從目標分配到路徑規劃,哈工大團隊提出智能倉庫的多智能體深度學習解決方案

隨著物流行業的快速發展,智能倉庫技術應運而生,旨在提高倉儲效率和靈活性。傳統倉庫依賴傳送帶等固定設備,雖然能夠完成基本的物料搬運任務,但其靈活性差,難以適應不斷變化的需求。智能倉庫通過引入多智能體系統,利用自主移動的機器人來完成貨物的搬運和分揀,大大提升了倉儲操作的效率和靈活性。然而智能倉庫面臨的一個關鍵挑戰是如何有效地進行目標分配和路徑規劃(TAPF),以確保多個機器人能夠高效協同工作,避免路徑沖突和資源浪費。

在智能倉庫中,TAPF問題涉及為每個機器人分配任務(如搬運貨物)并規劃其行進路徑,以確保任務能夠高效完成且路徑不發生沖突。TAPF問題的復雜性在于其通常是一個NP難問題,具有巨大的搜索空間。傳統方法通常將目標分配和路徑規劃分開處理,但這種方法忽略了兩者之間的相互影響,可能導致次優的解決方案。合理的目標分配不僅可以有效減少機器人的路徑長度,提高操作效率,還能幫助避免不同機器人之間的路徑沖突。因此,解決TAPF問題對于智能倉庫的高效運行至關重要。

8 月 27 日發表的論文《Multi-Agent Target Assignment and Path Finding for Intelligent Warehouse: A Cooperative Multi-Agent Deep Reinforcement Learning Perspective》提出了一種基于合作多智能體深度強化學習(RL)的方法,首次將TAPF問題建模為合作多智能體深度RL問題,并同時解決目標分配和路徑規劃。具體創新點包括:

- 首次建模:論文首次將TAPF問題建模為合作多智能體深度RL問題,填補了現有研究的空白。

- 物理動態特性:在路徑規劃階段,論文考慮了機器人的物理動態特性(如速度和加速度),這在以往研究中較為少見。

- 實驗驗證:通過實驗驗證,論文方法在各種任務設置中表現良好,目標分配合理,路徑接近最短,且比基線方法更高效。

這些創新點不僅為智能倉庫中的TAPF問題提供了新的解決思路,也展示了合作多智能體深度RL在實際應用中的潛力。

論文的研究團隊來自哈爾濱工業大學(深圳)控制科學與工程系,成員包括Qi Liu, Jianqi Gao, Dongjie Zhu, Xizheng Pang, Pengbin Chen, Jingxiang Guo, Yanjie Li。團隊在多智能體系統、深度強化學習和智能倉庫技術方面具有豐富的研究經驗和技術積累。通過本研究,團隊展示了其在智能倉庫領域的創新能力和技術實力,為未來的研究和應用奠定了堅實基礎。

背景與動機

傳統倉庫技術主要依賴于傳送帶、叉車和固定的貨架系統來完成物料搬運和存儲。這些系統雖然在一定程度上提高了倉儲效率,但其局限性也十分明顯。首先,傳統倉庫系統缺乏靈活性,難以適應不斷變化的訂單需求和倉儲布局調整。其次,傳送帶和固定貨架系統的擴展性差,增加新的存儲空間或搬運路徑往往需要大規模的硬件改造。此外,傳統倉庫系統的自動化程度有限,依賴大量人工操作,導致人力成本高且容易出現人為錯誤。

智能倉庫系統的優勢

智能倉庫系統通過引入多智能體系統(如自主移動機器人),克服了傳統倉庫技術的諸多局限性。智能倉庫的主要優勢包括:

- 高靈活性:智能倉庫中的自主移動機器人可以根據實時需求動態調整搬運路徑和任務分配,適應性強。

- 高擴展性:智能倉庫系統可以通過增加或減少機器人數量來靈活調整倉儲能力,無需大規模硬件改造。

- 高效率:多智能體系統能夠并行處理多個任務,顯著提高了倉儲操作效率。

- 低人力成本:智能倉庫系統的高度自動化減少了對人工操作的依賴,降低了人力成本和人為錯誤的風險。

現有TAPF問題解決方法的不足

在智能倉庫中,目標分配與路徑規劃(TAPF)問題是確保多個機器人高效協同工作的關鍵。然而現有的TAPF問題解決方法存在一些不足之處。

分離處理:傳統方法通常將目標分配和路徑規劃分開處理,忽略了兩者之間的相互影響。這種方法可能導致次優的解決方案,無法充分優化整體效率。

物理動態特性忽略:許多現有方法在路徑規劃中忽略了機器人的物理動態特性(如速度和加速度),導致規劃路徑不夠精確,影響實際執行效果。

時間效率低:傳統方法在處理復雜任務場景時,計算時間迅速增加,難以滿足實際應用中的實時性要求。

論文提出的基于合作多智能體深度強化學習的方法,旨在同時解決目標分配和路徑規劃問題,并考慮機器人的物理動態特性,從而克服現有方法的不足,提高智能倉庫系統的整體效率和實用性。

TAPF問題的建模

目標分配與路徑規劃(TAPF)問題是智能倉庫系統中的核心問題之一。TAPF問題包括兩個主要部分:多智能體任務分配(MATA)和多智能體路徑尋找(MAPF)。在MATA中,系統需要根據訂單需求為每個智能體分配特定任務,而在MAPF中,系統需要規劃每個智能體的路徑,確保其在執行任務時不會與其他智能體發生沖突。TAPF問題通常是NP難問題,具有巨大的搜索空間,直接求解非常困難。傳統方法通常將這兩個問題分開處理,但這種方法忽略了任務分配和路徑規劃之間的相互影響,可能導致次優的解決方案。

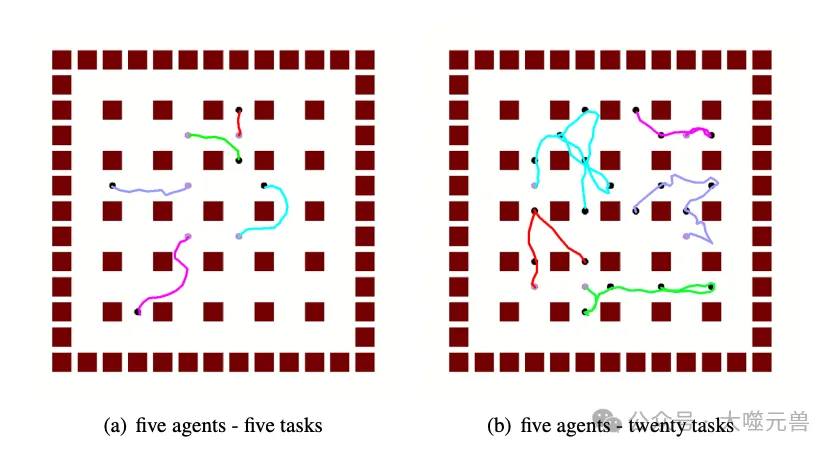

圖1:將TAPF建模為MARL問題

多智能體強化學習(MARL)是一種處理多個智能體在共同環境中交互的學習方法。MARL的目標是學習一個策略,使所有智能體能夠協同工作,完成共同目標。MARL可以通過以下幾個關鍵元素來建模。

- 狀態空間(S):表示系統的所有可能狀態。

- 動作空間(A):表示智能體可以執行的所有可能動作。

- 狀態轉移函數(P):描述系統從一個狀態轉移到另一個狀態的概率。

- 獎勵函數(r):定義智能體在執行某個動作后獲得的獎勵。

- 折扣因子(γ):用于平衡即時獎勵和未來獎勵的權重。

- 時間范圍(T):表示決策過程的時間跨度。

在MARL中,每個智能體根據其觀測到的環境狀態選擇動作,并通過與環境和其他智能體的交互來學習最優策略。合作多智能體深度強化學習(Cooperative MARL)特別適用于需要多個智能體協同工作的場景,如智能倉庫中的TAPF問題。

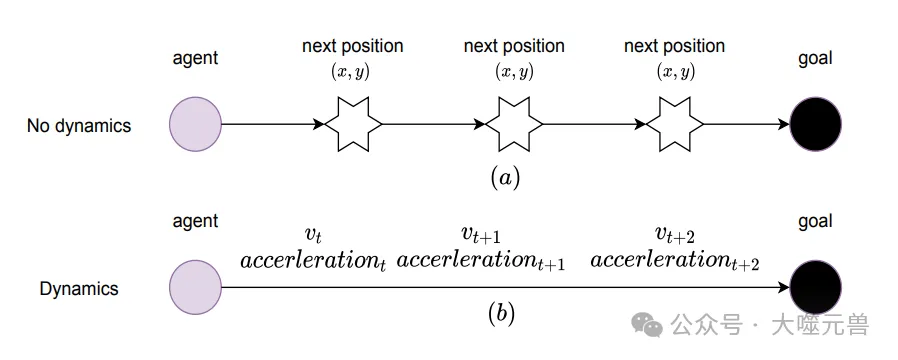

在智能倉庫的TAPF問題中,考慮智能體的物理動態特性(如速度和加速度)對于提高路徑規劃的精確性和實際執行效果至關重要。傳統方法通常只關注智能體的下一個位置,而忽略了其物理動態特性,這可能導致規劃路徑不夠精確,影響實際執行效果。

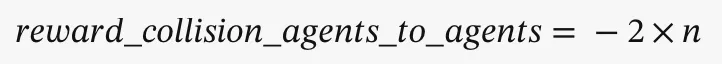

論文提出的方法首次在TAPF問題中考慮了智能體的物理動態特性。具體來說,智能體的動作空間是連續的,表示智能體在四個基本方向上的移動速度。通過計算智能體的速度和加速度,可以更準確地規劃其路徑,確保路徑規劃的實際可行性和高效性。

圖2:智能體的物理動力學

通過將TAPF問題建模為合作多智能體深度強化學習問題,并考慮智能體的物理動態特性,論文提出的方法能夠更有效地解決智能倉庫中的目標分配與路徑規劃問題,提高系統的整體效率和實用性。

具體方法

1. TAPF問題的MARL建模

狀態空間、動作空間與獎勵函數的定義

在論文中,目標分配與路徑規劃(TAPF)問題被建模為一個合作多智能體強化學習(MARL)問題。具體來說,系統的狀態空間(S)、動作空間(A)和獎勵函數(r)被定義如下:

狀態空間(S):每個智能體的觀測包含其自身的位置和速度、所有任務的相對位置、其他智能體的相對位置以及鄰近障礙物的相對位置。通過這些觀測,智能體能夠感知其周圍環境并做出決策。

動作空間(A):智能體的動作空間是連續的,表示智能體在四個基本方向上的移動速度(左、右、下、上)。最終動作是四個方向速度的向量和。

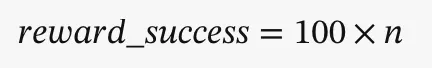

獎勵函數(r):獎勵函數被定義為多個部分的組合,包括任務成功獎勵、任務到智能體的距離獎勵、智能體與障礙物碰撞的懲罰以及智能體之間碰撞的懲罰。具體公式如下:

成功獎勵:

其中n表示滿足條件的元素數量。

距離獎勵:

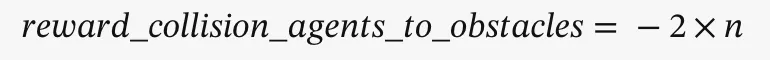

碰撞懲罰(障礙物):

其中n表示滿足條件的元素數量。

碰撞懲罰(智能體):

其中n表示滿足條件的元素數量。

智能體的物理動態特性

論文首次在TAPF問題中考慮了智能體的物理動態特性。具體來說,智能體的動作不僅僅是位置的變化,還包括速度和加速度的計算。通過計算智能體在四個基本方向上的力(F?x, F??x, F?y, F??y),根據牛頓第二定律可以得到加速度,然后通過加速度計算速度,最終得到智能體的動作。這種方法使得路徑規劃更加精確,能夠更好地反映實際執行中的物理特性。

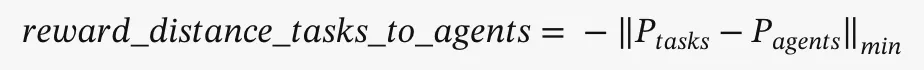

圖3:智能體的動作空間

2. 使用MADDPG算法解決TAPF問題

策略網絡與評論者網絡的更新

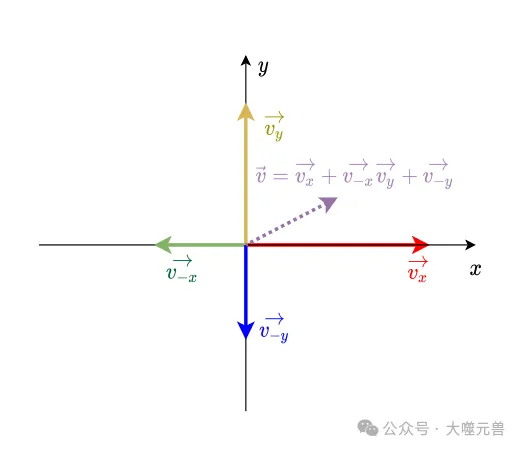

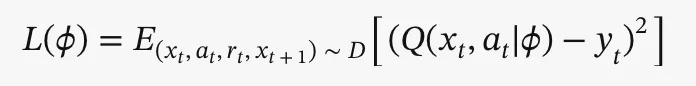

在論文中,使用多智能體深度確定性策略梯度(MADDPG)算法來解決TAPF問題。由于智能體是同質的,它們可以共享相同的策略網絡,從而提高學習效率。具體來說,策略參數通過集中評論者Q進行迭代更新,評論者參數通過最小化損失函數進行優化:

- 策略參數的更新公式為:

其中,xt和at分別表示所有智能體在時間步t的觀測和動作的拼接,D表示包含樣本的重放緩沖區。

- 評論者參數的優化公式為:

其中,yt為目標評論者網絡的值,定義為:

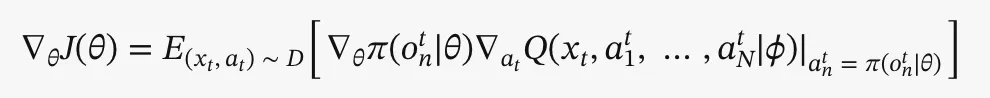

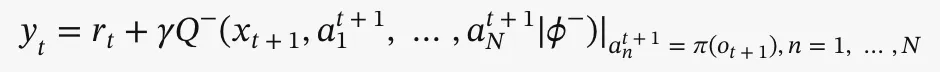

獎勵共享與執行階段的策略

在訓練過程中,智能體通過共享獎勵來學習合作策略。在執行階段,僅使用策略網絡π,其輸入為各智能體的觀測,輸出為施加在智能體上的力。根據智能體的物理動態特性,可以計算出智能體的動作。具體來說在執行階段,每個智能體僅依賴其局部觀測進行決策,從而實現分散執行。

圖4:任務和智能體的距離矩陣。

通過這種方法,論文提出的解決方案能夠同時解決目標分配和路徑規劃問題,提高智能倉庫系統的整體效率和實用性。

實驗結果

1. 目標分配與路徑規劃性能驗證

為了驗證論文方法在目標分配與路徑規劃(TAPF)問題上的性能,研究團隊在不同難度的智能倉庫場景中進行了實驗。實驗設置了五個不同難度的場景:兩個智能體-兩個任務、兩個智能體-四個任務、五個智能體-五個任務、五個智能體-十個任務和五個智能體-二十個任務。

實驗結果顯示,在所有不同難度的場景中,論文方法的平均回報值均呈現出單調增加的趨勢,驗證了方法的穩定性。具體表現如下:

簡單任務(如兩個智能體-兩個任務):目標分配和路徑規劃均表現良好,任務分配合理,路徑接近最短。

復雜任務(如五個智能體-二十個任務):盡管任務難度逐漸增加,論文方法依然能夠合理分配任務,并規劃出接近最短的路徑。

這些結果表明,論文方法在各種任務設置中均能有效解決TAPF問題,具有較高的適應性和穩定性。

2. 合作能力驗證

為了驗證智能體在沖突場景下的合作能力,研究團隊設計了一個特定的沖突場景。在該場景中,兩個智能體的任務路徑必然會發生沖突。實驗結果顯示,智能體能夠在沖突點互相避讓,然后繼續導航到各自的任務點,成功完成任務。

具體表現為:

智能體1和智能體2:在沖突點互相避讓,分別沿著紅色和青色軌跡完成導航任務。

這一結果驗證了論文方法在合作多智能體深度強化學習中的有效性,智能體能夠在復雜環境中學會合作,避免沖突,提高任務完成效率。

3. 時間效率驗證

時間效率是實際應用中一個重要的考量因素。研究團隊將論文方法與傳統方法在時間消耗上的表現進行了對比。傳統方法先解決目標分配問題(TA),然后進行路徑規劃(PF),而論文方法同時解決這兩個問題。

實驗結果顯示:

簡單任務(如兩個智能體-兩個任務):傳統方法的時間消耗可以接受。

復雜任務(如五個智能體-二十個任務):傳統方法的時間消耗迅速增加,難以滿足實時性要求。相比之下,論文方法在所有不同難度的任務中均能高效地提供策略,驗證了其時間效率。

這些結果表明,論文方法在時間效率上具有顯著優勢,能夠更好地滿足實際應用中的需求。

實驗結果展示了論文方法在智能倉庫中的潛在應用價值。通過同時解決目標分配和路徑規劃問題,并考慮智能體的物理動態特性,論文方法不僅提高了系統的整體效率和穩定性,還展示了其在實際應用中的高效性和實用性。這為智能倉庫系統的進一步發展和優化提供了新的思路和技術支持。

討論與未來工作

論文方法首次將目標分配與路徑規劃(TAPF)問題建模為合作多智能體深度強化學習(MARL)問題,能夠同時解決這兩個關鍵問題,避免了傳統方法中分離處理帶來的次優解。在路徑規劃中考慮了智能體的物理動態特性(如速度和加速度),使得規劃路徑更加精確,能夠更好地反映實際執行中的物理特性。實驗結果表明,論文方法在各種任務設置中均表現出較高的時間效率,能夠滿足實際應用中的實時性要求。智能體在沖突場景中能夠學會合作,避免路徑沖突,提高任務完成效率。

盡管論文方法在時間效率上表現優異,但在處理大規模智能體和任務時,計算復雜度仍然較高,可能需要進一步優化算法以提高可擴展性。論文方法在特定的智能倉庫環境中表現良好,但在不同類型的倉庫環境中,可能需要對算法進行調整和優化,以適應不同的應用場景。深度強化學習方法通常需要大量的訓練時間和計算資源,論文方法在實際應用中可能需要較長的訓練周期。

進一步優化算法以降低計算復雜度,提高可擴展性,使其能夠處理更大規模的智能體和任務。研究如何使算法在不同類型的智能倉庫環境中具有更好的適應性,提升其通用性。探索實時學習和在線更新的方法,使智能體能夠在實際操作中不斷學習和優化策略,提升系統的動態響應能力。結合視覺、語音等多模態信息,提升智能體的感知能力和決策精度。

論文方法在智能倉庫中的成功應用展示了其在智能物流領域的巨大潛力,未來可以推廣到更廣泛的物流場景中,如智能配送中心和無人倉庫。在智能制造領域,論文方法可以用于優化生產線上的物料搬運和任務分配,提高生產效率和靈活性。在服務機器人領域,論文方法可以用于多機器人協作任務,如清潔機器人和配送機器人,提升其協作能力和任務完成效率。

結論

論文提出了一種基于合作多智能體深度強化學習的方法,首次將智能倉庫中的目標分配與路徑規劃(TAPF)問題建模為合作多智能體深度強化學習問題,并同時解決這兩個關鍵問題。通過實驗驗證,論文方法在各種任務設置中均表現良好,目標分配合理,路徑接近最短,且比基線方法更高效。論文方法在時間效率和合作能力上表現出顯著優勢,展示了其在智能倉庫中的潛在應用價值。

論文方法通過同時解決目標分配和路徑規劃問題,并考慮智能體的物理動態特性,不僅提高了智能倉庫系統的整體效率和穩定性,還展示了其在實際應用中的高效性和實用性。未來,論文方法有望在智能物流、智能制造和服務機器人等領域得到廣泛應用,為這些領域的進一步發展和優化提供新的技術支持和解決方案。(END)

參考資料:https://arxiv.org/pdf/2408.13750