幾秒生成逼真3D場景,泛化媲美Stable Diffusion | 浙大&螞蟻等提出Prometheus

論文鏈接:https://arxiv.org/pdf/2412.21117

git鏈接:https://freemty.github.io/project-prometheus/

亮點直擊

- Prometheus,這是一種面向文本到3D生成的3D感知隱空間擴散模型,適用于對象和場景級別。

- 按照標準的隱空間擴散范式,將訓練分為兩個不同的階段。在第一階段,訓練一個3D高斯變分自編碼器(GS-VAE),它以多視角或單視角RGB-D圖像為輸入,預測每個像素對齊的3D高斯。在第二階段,訓練一個多視角LDM,聯合預測多視角RGB-D隱空間code,并以相機姿態和文本提示為條件。

- 此外,本文的完整模型在9個多視角和單視角數據集的組合上進行訓練,旨在實現與Stable Diffusion相當的泛化能力。

- 展示了該方法在前饋3D高斯重建和文本到3D生成中的有效性,表明本模型能夠在幾秒鐘內生成3D場景,同時很好地泛化到各種3D對象和場景。

總結速覽

解決的問題

- 實現從文本到3D場景的高效生成,適用于對象級別和場景級別。

- 提升生成3D內容的保真度和幾何質量,同時確保模型具備良好的泛化能力。

- 改善現有方法在3D生成中的效率問題,實現快速且高質量的3D生成。

提出的方案

- 多視圖、前饋、像素對齊的3D高斯生成:將3D場景生成表述為在隱空間變量擴散框架中的這一過程。

- 兩階段訓練框架:

- 第一階段:訓練3D高斯變分自編碼器(GS-VAE),以多視角或單視角的RGB-D圖像為輸入,預測每個像素對齊的3D高斯。

- 第二階段:訓練多視角隱空間變量擴散模型(LDM),聯合預測多視角RGB-D隱空間代碼,并以相機姿態和文本提示為條件進行生成。

- RGB-D隱空間變量空間的引入:通過解耦外觀和幾何信息,優化3D高斯生成的效率和質量。

- 基于預訓練模型的微調:以預訓練的文本到圖像生成模型為基礎,進行最小調整后,利用來自單視圖和多視圖數據集的大量圖像進行訓練。

應用的技術

- 隱空間變量擴散模型(LDM):作為生成框架,結合3D高斯生成和多視角條件。

- 3D高斯變分自編碼器(GS-VAE):用于從RGB-D圖像中提取隱空間變量并生成像素對齊的3D高斯。

- RGB-D隱變量空間:解耦外觀(RGB)和幾何信息(D),提升生成的保真度和幾何質量。

- 多視角訓練數據:結合9個多視角和單視角數據集,增強模型的泛化能力。

- 前饋生成策略:相比傳統方法,顯著加速生成過程。

達到的效果

- 高效生成:在幾秒內實現對象級別和場景級別的3D生成。

- 高質量輸出:生成的3D內容在保真度和幾何質量上表現優異。

- 良好的泛化能力:在不同類型的3D對象和場景中均表現出色,與Stable Diffusion相當的泛化能力。

- 實驗驗證:大量實驗結果證明了Prometheus在前饋3D高斯重建和文本到3D生成中的有效性。

方法

如下圖2所示,Prometheus遵循常見的隱空間變量擴散框架,該框架包括兩個訓練階段。在第一個階段,3D自動編碼器GS-VAE從多視圖圖像中學習壓縮和抽象的隱空間變量空間。隨后,它將該隱空間變量空間解碼為像素對齊的3D高斯(3DGS)表示,作為場景級別的表示。在第二個階段,一個隱空間變量多視圖擴散模型(MVLDM)在第一階段自動編碼器生成的隱空間變量表示上進行訓練,從而形成一個完全生成的模型。最后,詳細說明了采樣策略,該策略能夠在幾秒鐘內采樣出3D場景,同時保持一致性和視覺保真度。

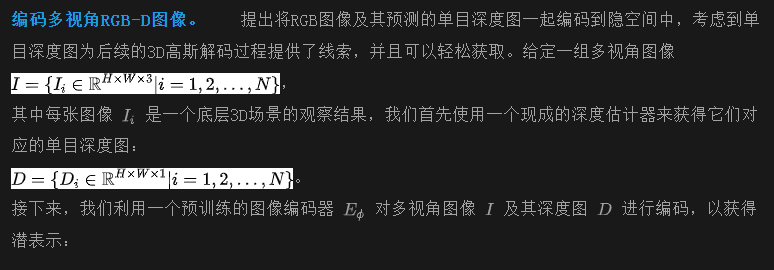

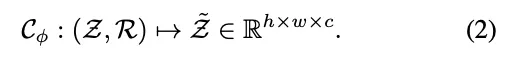

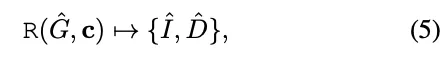

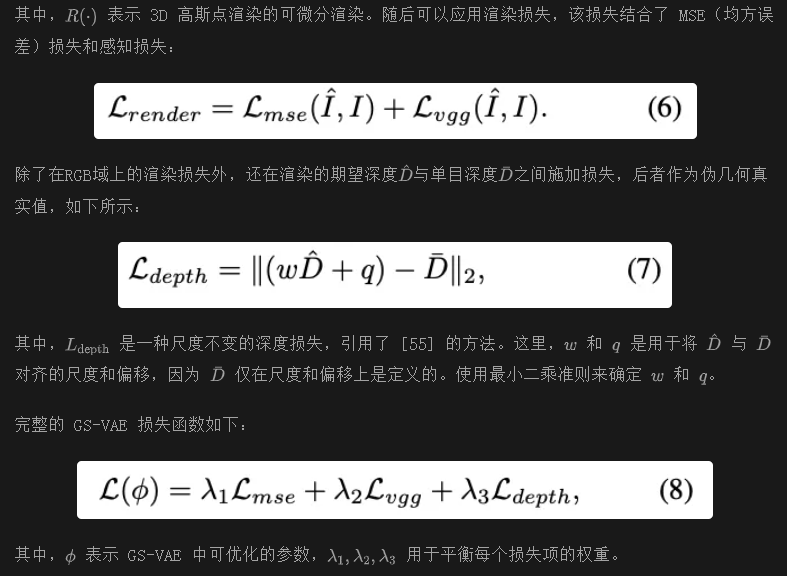

第一階段: GS-VAE

在階段 1 中,目標是訓練一個能夠將數據壓縮到隱空間并隨后將其重建為3D表示的3D自動編碼器。給定具有相機位姿的多視角輸入圖像,GS-VAE輸出多視角像素對齊的3D高斯表示(3DGS)。這些輸出隨后被合并為場景級別的3D表示。

其中h x w是下采樣后的分辨率。在實際操作中,使用預訓練的 Stable Diffusion (SD) 圖像編碼器,并在訓練過程中凍結它。最近的方法(如 Marigold)表明,SD 編碼器在處理深度圖時表現出強大的泛化能力。因此,我們選擇使用相同的 SD 編碼器分別對圖像和深度進行編碼,而無需進行微調。隨后,我們將這些編碼表示進行拼接,以獲得完整的多視圖隱空間變量Z,該隱空間變量可用于 3D 重建。此外,我們的擴散模型在聯合的 RGB-D 隱空間變量空間中進行訓練。

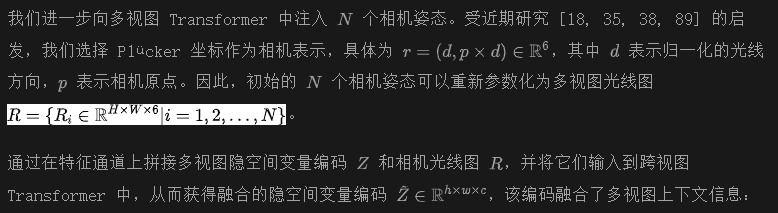

融合多視圖隱空間變量圖像 最近的研究進展 [26, 35, 77, 101, 102] 強調了基于 Transformer 的模型在整合多視圖信息方面的顯著潛力。由于每個視圖的隱空間變量編碼Z是獨立生成的,我們采用多視圖 Transformer 來促進跨視圖信息的交換。

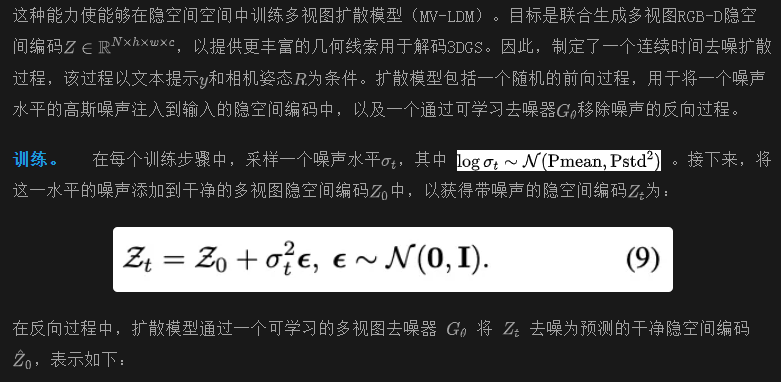

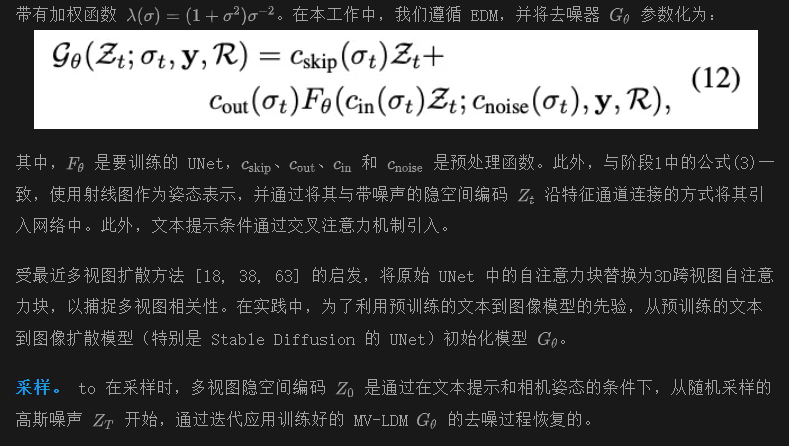

第二階段: 幾何感知多視圖降噪器

在第一階段的訓練之后,獲得了一個GS-VAE,其具備以下能力:

- 能夠高效地將圖像壓縮到一個緊湊的隱空間空間中;

- 通過3D高斯解碼器在2D和3D之間架起橋梁.

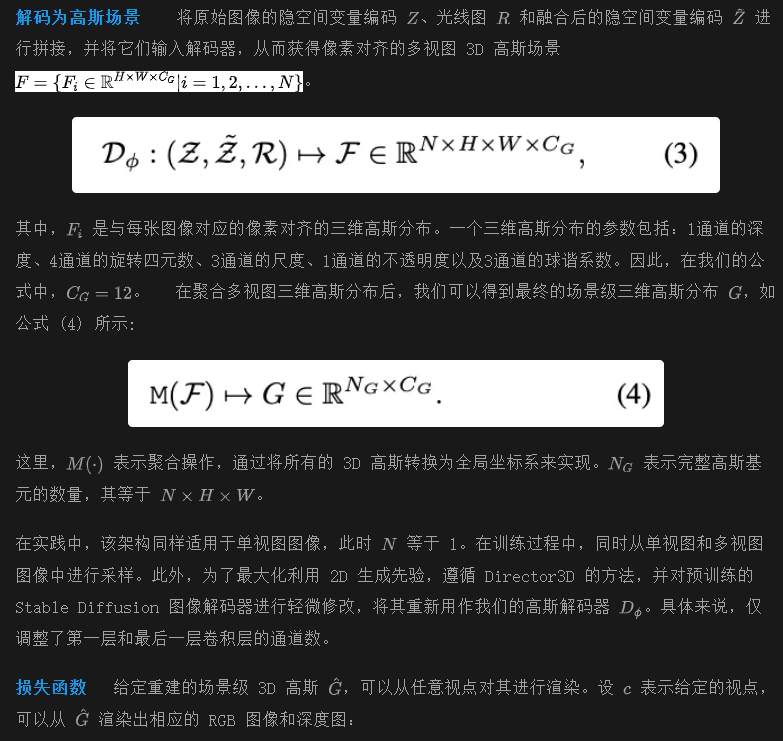

其中,y和R分別是文本和相機姿態的條件。MV-LDM 是通過在隱空間中使用去噪得分匹配 (DSM)進行訓練的。

幾秒鐘內生成文本到 3D 場景

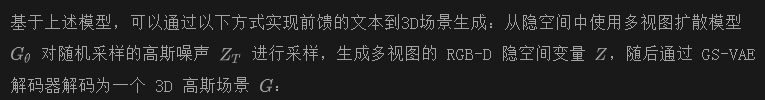

為了以高質量進行采樣并與條件對齊,使用無分類器引導(CFG)來引導多視圖生成朝向條件信號 。

實驗

訓練數據

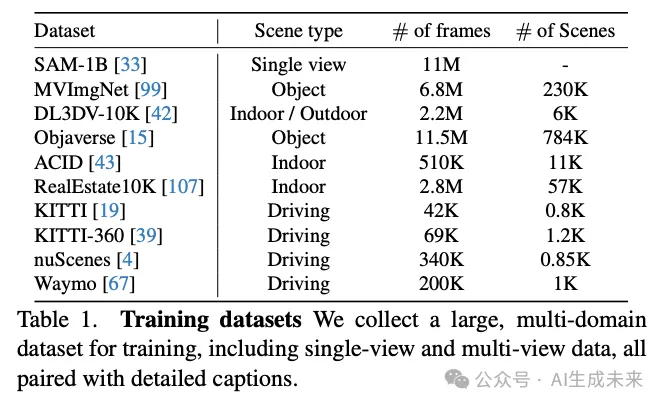

本文方法在大規模單視圖和多視圖數據集上進行訓練,詳見下表1。關于單視圖數據集,使用了高質量的 SAM-1B 數據集,該數據集包含詳細的描述,并出現在 PixArt-α 中。本文模型在9個多視圖數據集的組合上進行訓練,這些數據集包括以物體為中心、室內、室外和駕駛場景。每個場景的文本提示由多模態大語言模型 生成。

實施細節

在GS-VAE的訓練階段(階段1),為每個多視圖場景設置輸入視圖和新視圖的數量為N=4。為了提高模型的泛化能力,還在多視圖圖像旁采樣2個單視圖圖像,并僅對單視圖圖像的輸入視圖應用損失。GS-VAE在8個A800 GPU上以32的批量大小進行訓練。最終模型經過200,000次迭代,大約需要4天。使用gsplat作為我們的3D高斯渲染器。從預訓練的RayDiff模型初始化跨視圖Transformer的權重。

對于MV-LDM(階段2),采用Stable Diffusion 2.1作為基礎模型。在訓練過程中,為每個多視圖場景設置N=8。與階段1類似,在多視圖圖像旁采樣M=4個單視圖圖像。每次迭代時,在每個GPU上采樣批大小為8的圖像。最終的MV-LDM模型在32個A800 GPU上訓練,總批量大小為3072張圖像。模型經過350,000次迭代,大約需要7天。使用DepthAnything-V2-S模型動態估計深度圖。為了在采樣過程中實現無分類器引導,在訓練過程中,以10%的概率隨機丟棄文本條件t和姿態條件p。

評估協議

3D生成(階段2)。 為了評估本文模型的文本到3D生成能力,使用來自T3Bench 的兩個文本提示集——單對象和單對象帶環境。這些集合共同評估模型在對象級別和場景級別生成任務中的熟練程度。此外,收集了80個涵蓋室內和室外場景的多樣化場景級別文本提示。定量結果使用CLIPScore、NIQE 和BRISQUE 指標進行評估。CLIPScore評估生成圖像與文本提示之間的一致性,而NIQE和BRISQUE則表示圖像質量。

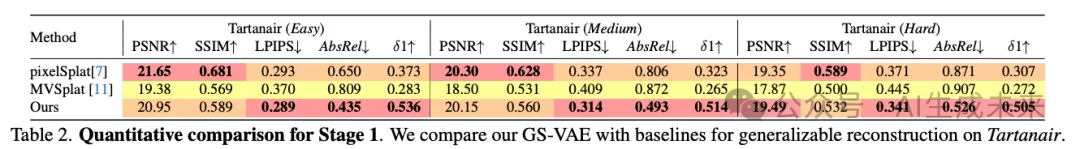

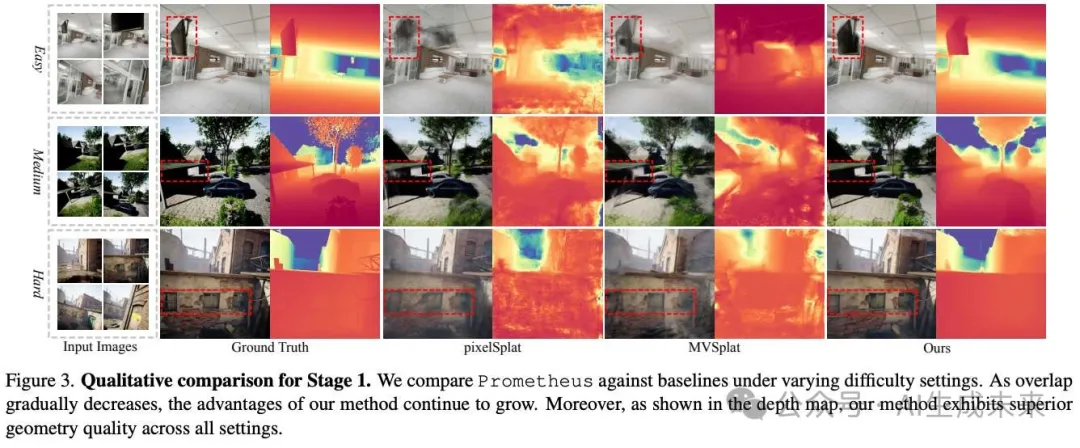

與基線比較

3D生成。 將Prometheus與三種文本到3D的基線方法進行比較,涵蓋了基于優化的方法和前饋方法。GaussianDreamer 是一種最先進的基于SDS的3DGS方法。還實現了一個基線,它將多視圖到3D的方法LGM 應用于由MVDream 生成的圖像。我們還與一種前饋方法Director3D(不帶精煉器)進行比較。下圖4和下圖5顯示,本文方法能夠生成對象和場景級別的內容,包含背景和豐富的細節,優于基于優化和前饋的基線。下表3顯示,整體指標在對象級別上不如Director3D,但在其他情況下領先。這歸因于對象中心設置中的失敗案例。請注意,我們方法僅需8秒即可生成,優于所有基線。

GS-VAE 消融 (Stage 1)

在下表4中,對Tartanair的困難模式進行了消融研究,分析了GS-VAE的以下因素。

深度先驗對GS-VAE的有效性: 研究了在第一階段訓練中RGB-D隱空間空間的影響。上表4中的結果顯示,僅使用RGB隱空間空間而不使用RGB-D隱空間空間進行訓練,會導致幾何結果比完整模型更差。此外,這種較差的幾何將導致重建圖像的質量不佳,詳見圖6中的定性結果。

大規模數據集在可泛化重建中的重要性: 接下來,對大規模數據集的有效性進行了消融研究,在上表4中標記為“w/o single-view”。排除單視圖數據集會導致重建圖像和幾何性能的下降。這強調了大規模數據集在實現穩健的可泛化重建中的重要作用。也在下圖6中展示了定性結果。

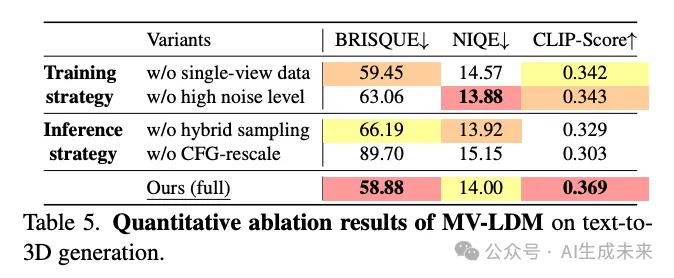

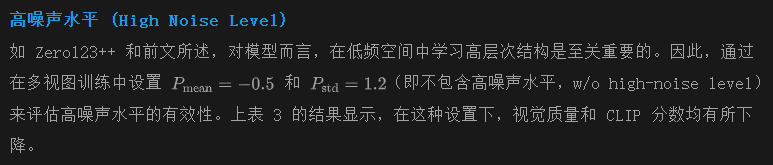

MV-LDM 消融(Stage 2)

在下表 5 中,對 T3Bench 的 SingleObject-with-Surroundings 子集進行了消融研究,分析了 MV-LDM 的訓練和推理策略。

單視圖數據集 (Single-View Dataset)

評估了單視圖數據的影響。當僅使用多視圖數據進行訓練(即不包含單視圖數據,w/o single-view data)時,模型性能出現了下降。這種性能下降可歸因于缺乏單視圖數據,導致模型的泛化能力降低,這與 MVDream 中的觀察結果一致。

混合采樣和 CFG 重標定 (Hybrid Sampling and CFG-Rescale)

最后,評估了前文中推理策略的設計,具體包括混合 CFG 采樣和 CFG 重標定。在實驗中,僅對文本提示應用 CFG(即不使用混合采樣,w/o hybrid sampling),并將 CFG 重標定因子設置為 0(w/o CFG-rescale)。上表 5 顯示,缺乏混合采樣和 CFG 重標定會導致指標在不同程度上下降。

結論

Prometheus,這是一種3D感知的隱空間擴散模型,專為在對象級別和場景級別上實現文本到3D生成而設計,并且能夠在數秒內完成。通過大量實驗,展示了該方法在前饋重建和3D生成任務中的有效性。相信,本工作為文本到3D場景生成提供了重要貢獻,提升了通用性、保真度和效率。

本文轉自AI生成未來 ,作者:AI生成未來