阿里巴巴達摩院、新加坡科技設計大學和南洋理工大學聯合團隊提升AI多步推理能力的新方法

大模型在處理更復雜的問題時,仍然容易在推理過程中出現錯誤,導致推理路徑偏離,最終影響模型的整體性能。現有的大語言模型在多步推理任務中,通常會由于推理路徑中某一步驟的錯誤而影響整個推理過程。這些錯誤不僅降低了模型的準確性,還增加了計算成本和執行延遲。傳統的方法如強化學習需要復雜的獎勵模型,而其他偏好優化方法往往忽視了多步推理任務中錯誤發生的具體步驟及其后續分支。

為了解決這些問題,阿里巴巴達摩院、新加坡科技設計大學和南洋理工大學聯合團隊提出了一種新的訓練框架——Reasoning Paths Optimization(RPO)。該框架通過探索和學習多樣化的推理路徑,優化大語言模型的推理能力。具體而言,RPO在每個推理步驟中鼓勵有利分支,懲罰不利分支,從而提高模型的整體問題解決能力。與需要大規模人工注釋的傳統方法不同,RPO利用模型自身生成的推理路徑,使其具備可擴展性和數據高效性。10 月 16 日,他們的技術論文《Reasoning Paths Optimization:Learning to Reason and Explore From Diverse Paths》發表于arXiv,引起廣泛關注。

研究團隊結合了來自學術界和工業界的資源與智慧,成員包括新加坡科技設計大學、阿里巴巴達摩院和南洋理工大學的專家。他們的跨機構合作為研究提供了強大的技術支持和創新能力,展示了推理路徑優化在前沿科技研究中的巨大潛力。主要成員包括新加坡科技設計大學與阿里巴巴達摩院聯合博士項目的Yew Ken Chia 和 Guizhen Chen;阿里巴巴達摩院的研究員Weiwen Xu;南洋理工大學的研究人員Luu Anh Tuan 和 Soujanya Poria;阿里巴巴達摩院和新加坡科技設計大學的Lidong Bing。通過此次合作,該團隊展示了Reasoning Paths Optimization框架的潛力,不僅在理論上提供了新的方法,也在實際應用中展現了良好的效果。

研究方法

大語言模型在解決復雜問題時,經常需要進行多步推理。為了提高模型的推理能力,研究團隊提出了一種新的框架,即Reasoning Paths Optimization(RPO)。該框架旨在生成并優化推理路徑,確保模型能在復雜問題中更準確地找到正確答案。推理路徑生成的核心在于鏈式思維提示。

鏈式思維提示是一種通過展示多個逐步推理示例,來引導模型逐步推理的方法。具體來說,鏈式思維提示通過給出問題及其對應的推理步驟,幫助模型學習如何進行多步推理。為了生成參考推理路徑,首先,他們需要準備一系列示例,每個示例包含一個問題及其對應的推理路徑。接著,利用這些示例通過溫度采樣技術從基礎模型中生成推理路徑。

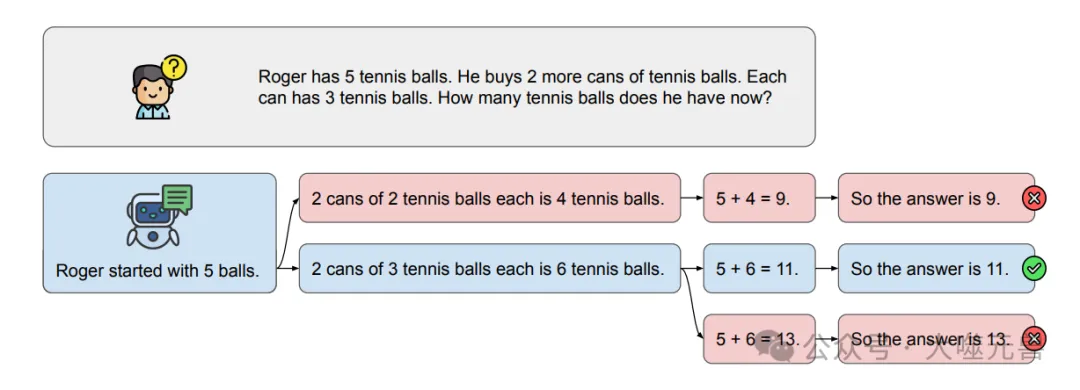

圖1:模型的推理路徑如何很容易地分叉到無法達到正確解的不利分支的示例。雖然我們在這里展示了一個簡化的例子,但對于需要更長推理路徑的更復雜的問題,挑戰被放大了。

在生成參考推理路徑的過程中,模型會生成多個可能的推理路徑,并最終選擇其中能夠達到正確答案的路徑作為參考路徑。如果生成的路徑在最后一步包含正確答案,他們將其視為正確路徑。如果未能生成正確路徑,則繼續采樣和驗證,最多嘗試十次。通過這種方式,他們可以確保生成的推理路徑盡可能準確,避免錯誤累積導致推理失敗。

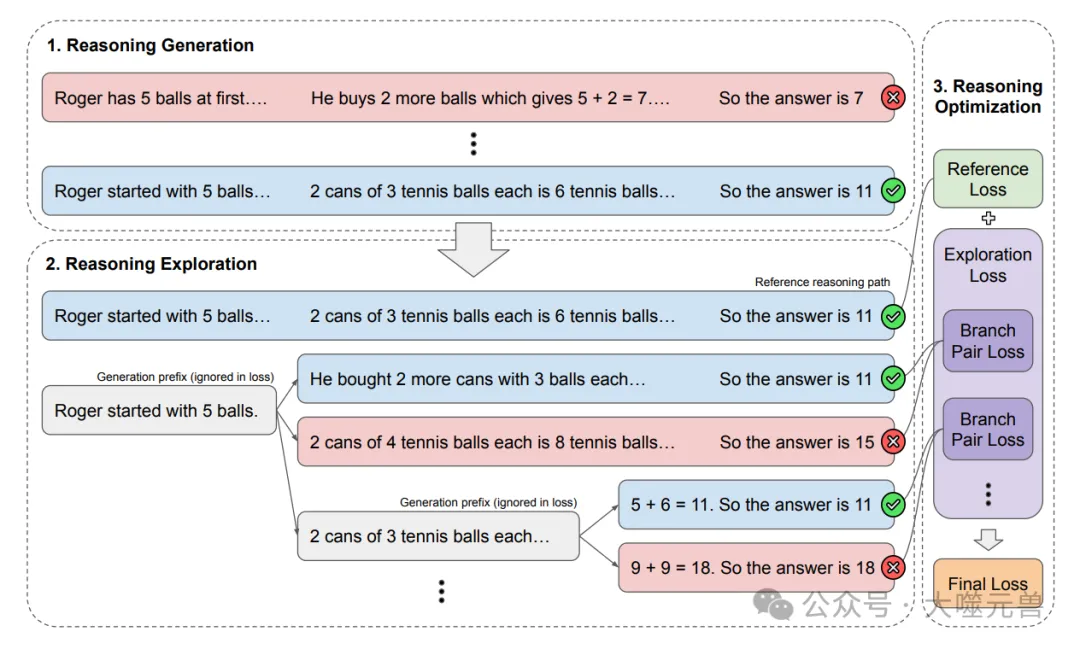

為了進一步提高模型的推理能力,他們需要考慮每個推理步驟中可能出現的錯誤。因此,在推理探索階段,他們通過多分支探索方法來生成多個可能的解決分支,從而找出有利與不利分支對。

具體來說,在生成參考路徑后,他們從每一步開始,生成多個可能的分支,并通過溫度采樣技術探索這些分支。在這個過程中,他們目標是找到一個有利分支和一個不利分支,其中有利分支能夠通向正確答案,而不利分支則不能。通過迭代采樣和驗證,每一步都會形成一個推理分支對,這些分支對將用于后續的對比反饋和優化過程。

圖2:我們用于探索和學習不同推理路徑的推理路徑優化框架概述。

在推理優化階段,他們結合參考路徑和探索得到的分支對,通過計算參考路徑損失和分支對損失,實現對基礎模型的優化。首先,參考路徑損失是通過標準的因果語言模型損失計算的,目的是提高模型生成參考路徑的概率。具體公式為:

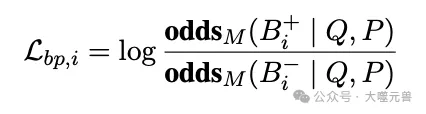

其次,對于分支對損失,通過對比有利和不利分支,提供對模型優化的指導。分支對損失的計算基于對數賠率差,具體公式為:

生成分支的賠率通過以下公式計算:

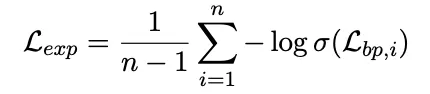

通過聚合每一步的分支對損失,他們可以得到總體的探索損失:

最終,他們綜合參考路徑損失和探索損失,通過以下公式實現總損失函數的優化:

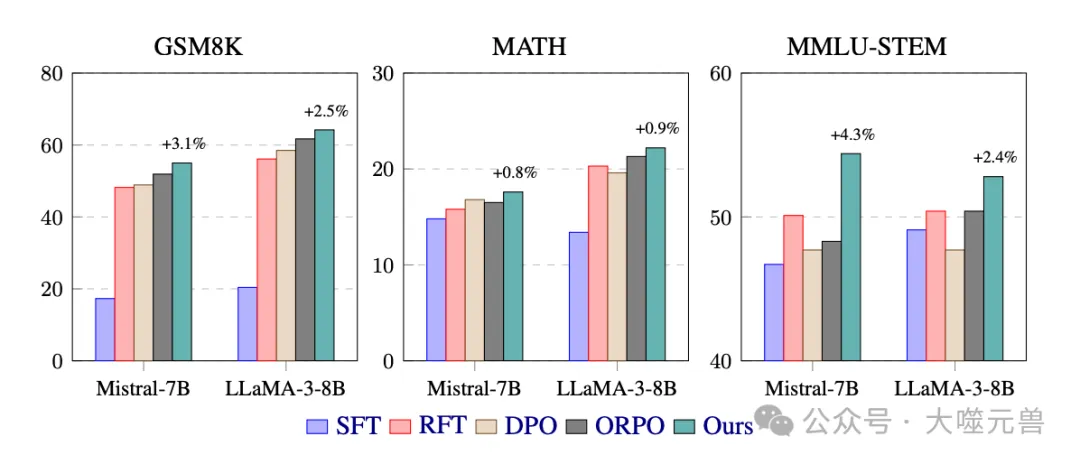

其中,λ是平衡參考路徑優化和探索分支優化的超參數。通過這種方式,RPO框架能夠有效提高模型在復雜問題求解中的推理能力,減少錯誤的發生,提升整體性能。

這部分內容詳細介紹了論文中提出的Reasoning Paths Optimization框架的研究方法,包括推理路徑生成、推理探索和推理優化的具體步驟和計算方法。接下來,將進一步討論實驗結果和對比分析,以驗證該方法的有效性和優勢。

實驗與結果

在實驗部分,他們詳細介紹了使用的數據集、實驗方法及其結果。這些實驗展示了Reasoning Paths Optimization(RPO)框架在提高模型推理能力方面的有效性。通過對比不同基線方法和調整實驗參數,他們進一步驗證了該方法的優勢。

數據集介紹

為了全面評估RPO框架的性能,他們選擇了多個具有代表性的數據集進行實驗。這些數據集包括GSM8K、MATH和MMLU-STEM。

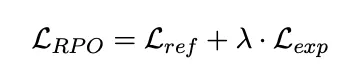

圖3:GSM8K和math中數學推理問題以及MMLU-STEM中基于科學的考試問題的不同訓練方法的評估準確率(%)的主要結果。我們還指出,與性能最高的基線相比,我們的方法有所改進。

GSM8K數據集主要用于數學文字問題的推理評估,該數據集包含了8000多個經過人工標注的數學題目,涵蓋了從簡單到復雜的各種難度等級。由于其多樣性和高質量標注,GSM8K成為了評估語言模型推理能力的重要基準。

MATH數據集則專注于競賽級數學題目,這些題目通常需要復雜的多步推理才能得出正確答案。MATH數據集的引入能夠幫助他們評估模型在高難度推理任務中的表現,檢測RPO在應對復雜問題時的有效性。

MMLU-STEM數據集是MMLU考試問題數據集的一個子集,專注于科學、技術、工程和數學(STEM)領域的問題。該數據集包含了多個需要多步推理才能解決的問題,能夠全面評估RPO在不同領域推理任務中的適用性和效果。

實驗方法

在實驗過程中,他們采用了多種基線方法進行比較,以驗證RPO框架的性能提升。主要的基線方法包括監督微調(SFT)、拒絕采樣微調(RFT)、直接偏好優化(DPO)和賠率比偏好優化(ORPO)。

監督微調方法不使用推理路徑,僅訓練模型生成最終答案。拒絕采樣微調方法利用模型自生成的推理路徑進行訓練,類似于RPO框架的推理生成階段。直接偏好優化和賠率比偏好優化則提供對比反饋,幫助模型在有利和不利分支之間進行選擇。

在模型訓練和評估過程中,他們首先通過鏈式思維提示生成參考推理路徑,并結合多分支探索方法生成多個可能的分支對。然后,通過計算參考路徑損失和分支對損失,優化模型的推理能力。為了確保結果的可靠性,他們在訓練和評估過程中保持一致的實驗設置,采用固定的采樣溫度和批量大小。

實驗結果

通過對比不同基線方法,他們發現RPO框架在多個數據集上均表現出了顯著的性能提升。特別是在GSM8K和MMLU-STEM數據集上,RPO分別取得了3.1%和4.3%的性能提升。這表明RPO框架能夠有效減少推理過程中錯誤的發生,提高整體推理能力。

此外,他們還研究了不同權重λ值對性能的影響。結果顯示,λ值過低會導致對推理探索重視不夠,結果不佳;而過高則會影響參考路徑的優化效果。因此,在優化參考路徑和探索分支之間找到平衡是至關重要的。

圖4:LLaMA-3-8B的勘探損失權重對MATH數據集性能的影響。

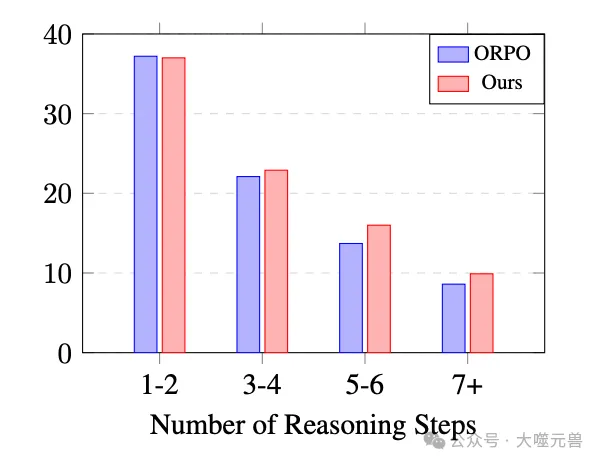

圖5:LLaMA-3-8B在MATH數據集上的推理路徑長度性能。

推理路徑長度對結果的影響也進行了分析。與最高性能基線ORPO相比,RPO在較長推理路徑上的表現更好,表明該方法能夠有效減少復雜問題中的錯誤發生。

案例研究

為了進一步驗證RPO框架的有效性,他們進行了案例研究。通過對具體問題的詳細分析,他們發現RPO不僅能夠得出正確答案,還能通過連貫的推理過程展示推理步驟。相比之下,其他基線方法在沒有詳細解釋的情況下,容易在第一步就出現錯誤。

常見錯誤及其修正也在案例研究中得到了詳細討論。通過逐步驗證推理路徑,RPO框架能夠有效減少錯誤,提升模型的推理能力和可靠性。

基于代碼的推理

除了自然語言推理,RPO框架還在代碼推理中展現了良好的適用性。他們通過代碼示例生成Python程序,得到輸出答案。實驗結果表明,RPO在文本和代碼推理中均表現出相似的優勢。這表明該框架不僅在自然語言處理任務中有效,還可以推廣到其他領域,如代碼生成和代碼增強推理。

對比目標和參考路徑的影響

在實驗中,他們研究了不同對比目標和參考路徑的影響。結果顯示,RPO框架在不同對比目標下表現出一致的穩健性和性能提升。此外,使用多個參考路徑能夠進一步增強模型的推理能力,證明了RPO在處理復雜推理任務時的有效性。

通過這些實驗結果,他們可以得出結論,Reasoning Paths Optimization框架通過優化推理路徑,有效提高了大語言模型在復雜問題求解中的可靠性和效率。這進一步展示了該方法在多步推理任務中的巨大潛力,并為未來研究提供了重要的啟示。

相關工作

一致性和基于偏好的優化

在人類反饋強化學習(RLHF)領域,很多研究致力于使大語言模型(LLMs)更好地與人類偏好對齊,并能夠遵循指示。RLHF方法通過訓練一個單獨的獎勵模型來提供標量反饋,然后使用該反饋對LLMs進行微調。然而,PPO算法雖然廣泛應用,但其復雜性和不穩定性讓訓練過程充滿挑戰。此外,RLHF需要分階段訓練獎勵模型和策略模型,這進一步增加了技術難度。為了解決這些問題,近來涌現了多種技術,包括直接偏好優化(DPO)、無偏好優化(IPO)、簡化偏好優化(SimPO)和賠率比偏好優化(ORPO),這些技術在一定程度上消除了對獎勵模型的需求,大大穩定并簡化了訓練過程。

這些優化方法通過成對比較模型生成的兩個響應,推動模型為更有利的響應分配更高的概率。然而,這些偏好優化方法通常在整體上比較兩個響應,忽視了多步推理任務中特定步驟及其后續分支中錯誤的影響。因此,他們提出了Reasoning Paths Optimization(RPO),該方法關注每個中間步驟,提供更精細的對比反饋,有效提高模型的推理能力。

大語言模型中的多步推理

大語言模型在多步推理任務中表現出色,能夠通過逐步生成推理步驟來解決復雜的問題。研究表明,通過引導模型生成推理步驟,可以顯著提升其多步推理能力。例如,鏈式思維提示通過向模型展示逐步推理的示例,幫助其學習如何逐步推理。盡管如此,LLMs在推理過程中仍然容易出現錯誤,特別是在面對復雜的多步推理任務時。為了解決這一問題,逐步驗證推理路徑成為一種有效的方法,能夠在每個推理步驟中捕捉并糾正錯誤。

此外,最新研究嘗試通過構建逐步標簽來驗證中間步驟,從而減少人工注釋的成本。這些方法主要集中在訓練驗證器(即獎勵模型),而他們的RPO框架則通過流程監督將驗證方法應用于偏好優化,無需單獨的獎勵模型。

人工智能中的路徑探索

在人工智能領域,路徑探索技術被廣泛應用于提高復雜任務的性能。比如,AlphaGo使用蒙特卡洛樹搜索(MCTS)來探索可能的移動空間。類似地,樹狀提示(Tree-of-Thought prompting)通過探索語言模型生成的可能解決方案空間,提高模型的決策能力。其他研究也設計了基于樹的解碼策略,以尋找最佳解決方案。在推理任務中,先前的研究通過自采樣解決方案進行訓練,并通過樹搜索生成路徑,進一步優化模型性能。

受這些工作的啟發,研究團隊提出的RPO框架通過探索多樣化的解決方案空間,并在訓練期間利用有利和不利分支的對比反饋來優化模型。通過這種方式,他們不僅能夠捕捉到推理過程中的錯誤,還能夠通過對比反饋進一步提升模型的整體推理能力。

總結起來,研究團隊提出的Reasoning Paths Optimization框架在推理路徑生成、推理探索和推理優化方面提供了一種全新的方法。通過對比現有的偏好優化方法和多步推理技術,RPO框架展示了其在提高大語言模型推理能力方面的潛力和優勢。

結論與未來工作

研究團隊提出了一種新穎的訓練框架,即推理路徑優化(Reasoning Paths Optimization,簡稱RPO),旨在提升大語言模型在多步推理任務中的性能。通過生成、探索和優化多樣化的推理路徑,RPO框架展示了其在復雜問題求解中的卓越能力。該方法通過鏈式思維提示生成參考推理路徑,并在推理過程中探索多個可能的解決分支,形成有利和不利的推理分支對。最終,通過對比反饋和優化,總損失函數結合參考路徑損失和探索損失,有效提高了模型的整體推理能力。

實驗結果表明,RPO在多個數據集上均表現出顯著的性能提升,尤其是在GSM8K和MMLU-STEM數據集上,分別提高了3.1%和4.3%。這些結果證明了RPO框架在減少推理過程中錯誤發生,提高復雜問題求解中的可靠性和效率方面的優勢。

盡管RPO框架展示了顯著的性能提升,但其方法仍存在一些局限性。首先,RPO依賴于模型在訓練階段生成正確推理路徑的能力,如果基礎模型表現不佳,可能難以生成必要的正確路徑,從而限制了方法的有效性。其次,生成和探索多個推理路徑的過程相對計算密集,盡管這是訓練中的一次性成本,但仍需大量計算資源支持,這在資源受限的環境中可能會成為瓶頸。

此外,RPO框架雖然無需大規模人工注釋,但在生成初始參考路徑和探索分支時,仍可能受到模型自身生成質量的影響。如果生成的參考路徑不夠準確,或者探索到的分支存在較多錯誤,可能會影響最終優化結果的質量。

未來的研究可以從以下幾個方面進一步改進和擴展RPO框架。

增強基礎模型的推理能力:可以考慮結合更多的訓練數據和更先進的預訓練模型,以提高基礎模型在生成正確推理路徑時的性能,從而增強RPO的整體效果。

優化計算資源的使用:針對生成和探索過程中的計算密集問題,研究可以嘗試引入更加高效的采樣和驗證方法,以減少計算資源的消耗,提升訓練效率。

擴展應用領域:RPO框架在自然語言處理中的推理任務表現優異,未來可以探索其在其他領域的應用,例如代碼生成、科學計算和復雜系統建模等,驗證其在更多任務中的適用性和有效性。

開發更健壯的驗證機制:引入更加智能和自動化的驗證機制,減少對模型生成質量的依賴,確保探索到的推理分支更加準確和有效。

人機協作優化:探索人類專家與RPO框架的協作,通過專家指導和反饋進一步優化推理路徑,提升模型的整體推理能力和準確性。

總之,Reasoning Paths Optimization框架通過創新的方法和嚴謹的實驗,展示了其在提升大語言模型多步推理能力方面的巨大潛力。盡管存在一些局限性,但隨著技術的發展和研究的深入,RPO有望在更多復雜任務中發揮重要作用,推動人工智能技術的持續進步和應用。(END)

參考資料:https://arxiv.org/pdf/2410.10858

本文轉載自 大噬元獸,作者: FlerkenS