多階段對比學習+多專家CLIP實現細粒度多模態表征學習

今天給大家介紹一篇港中文、上海AI Lab等機構聯合發表的CLIP優化工作,構建了基于多專家網絡的MoE模型,實現更細粒度的視覺表征器訓練,提升下游多模態大模型

論文標題:CLIP-MOE: TOWARDS BUILDING MIXTURE OF EXPERTS FOR CLIP WITH DIVERSIFIED MULTIPLET UPCYCLING

下載地址:??https://arxiv.org/pdf/2409.19291v2??

1.背景

基于CLIP的圖文對比學習預訓練是構建多模態大模型的一個核心基礎模塊。通過圖片和文本的對比學習過程,訓練圖片和文本的Encoder,能夠對齊圖片和文本這兩個模態的表征。

然而,很多工作都發現,CLIP訓練的Encoder,提取的更多是粗粒度的圖像信息,例如CLIP的表征會存在語義不同、內容相似的圖像被分到同一個類別中。這種比較弱的視覺Encoder會影響下游任務的效果。

為了解決上述問題,本文構建了一種基于多專家網絡的CLIP模型,不同專家從不同維度提取視覺表征,提升視覺編碼器能力。并且整個過程只需要基于已有的checkpoint進行finetune,不用從0訓練CLIP模型。

2.建模方法

CLIP-MoE的核心建模方法可以分成3個部分:多階段對比學習、多專家網絡、訓練方式。

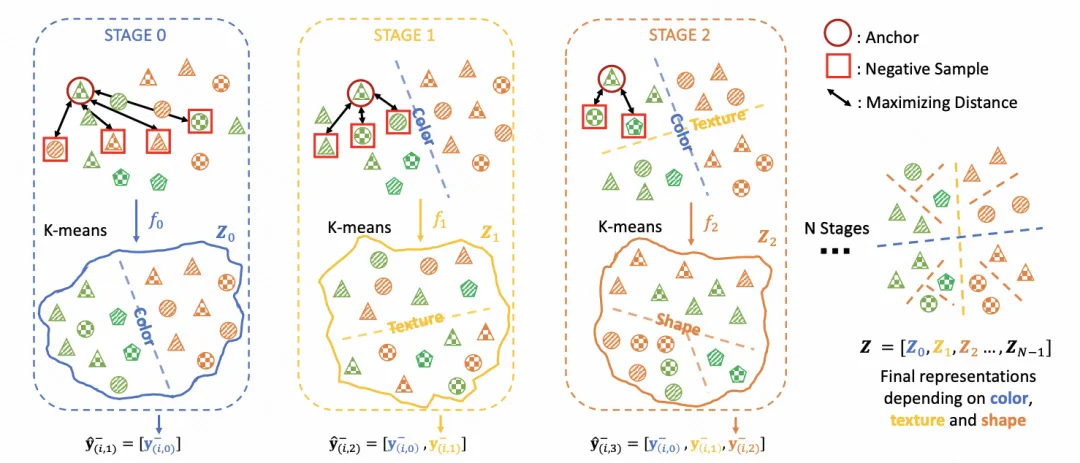

多階段對比學習是港中文在Avoiding feature suppression in contrastive learning: Learning what has not been learned before中提出的CLIP訓練方法。進行多輪的CLIP訓練,每輪訓練后,根據表征進行聚類,下一輪的對比學習在每個聚類類簇內進行訓練。通過多輪訓練,得到一系列的CLIP模型。這種建模方法可以理解為,比如最開始對比學習學到了根據顏色進行表征對齊,在聚類后,顏色相同的聚類到了一起,第二階段就可以學到顏色以外的其他信息進行表征區分。通過這種方式實現不同維度的表征學習。

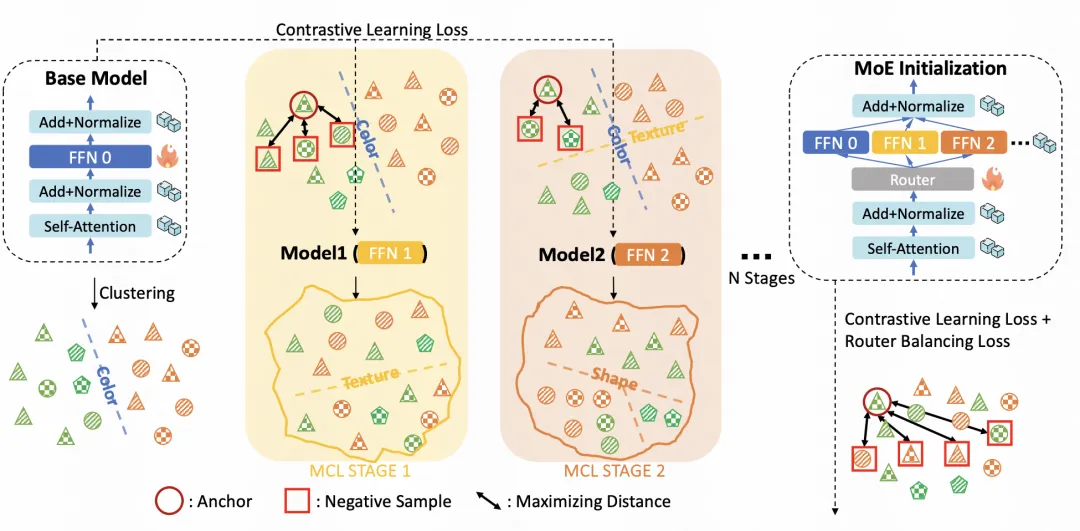

本文也利用多階段對比學習的思路,基于一個預訓練的CLIP模型,將參數固定,只對Transformer中的FFN層進行finetune。通過多階段對比學習,生成多組FFN參數。

基于上述不同階段的FFN參數,可以構建多專家網絡。通過門控網絡,設定樣本通過各個FFN的概率,各個FFN的輸出結果進行加權求和。并且在損失函數中引入復雜均衡loss,防止MoE被少數專家主導的情況。

在訓練方式上,包含2個階段。第一階段,在多階段對比學習過程中,基于預訓練CLIP,模型參數freeze,只對FFN層進行finetune。在第二階段,凍結所有參數,只對多專家網絡中的路由部分進行finetune。

3.實驗結果

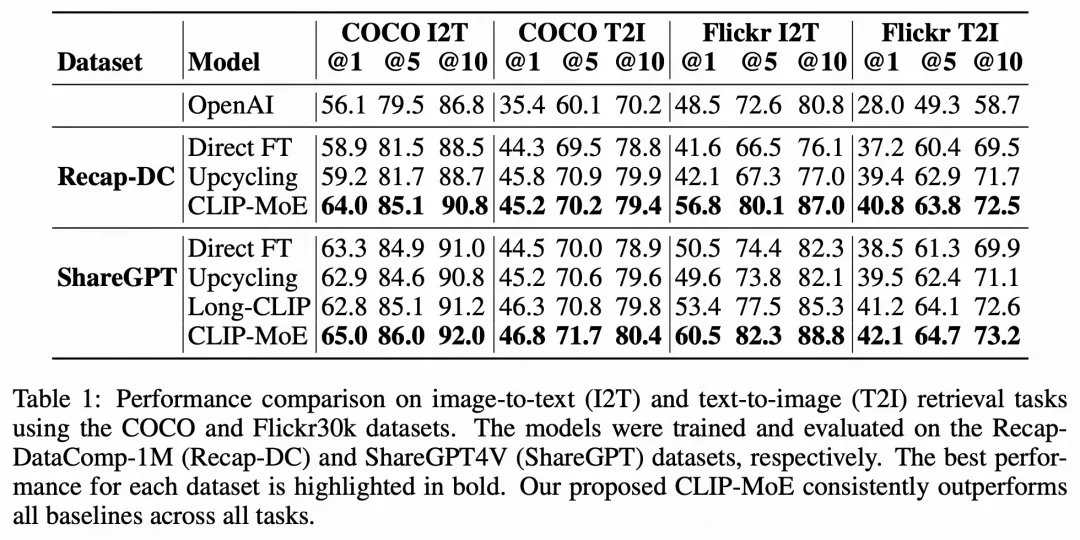

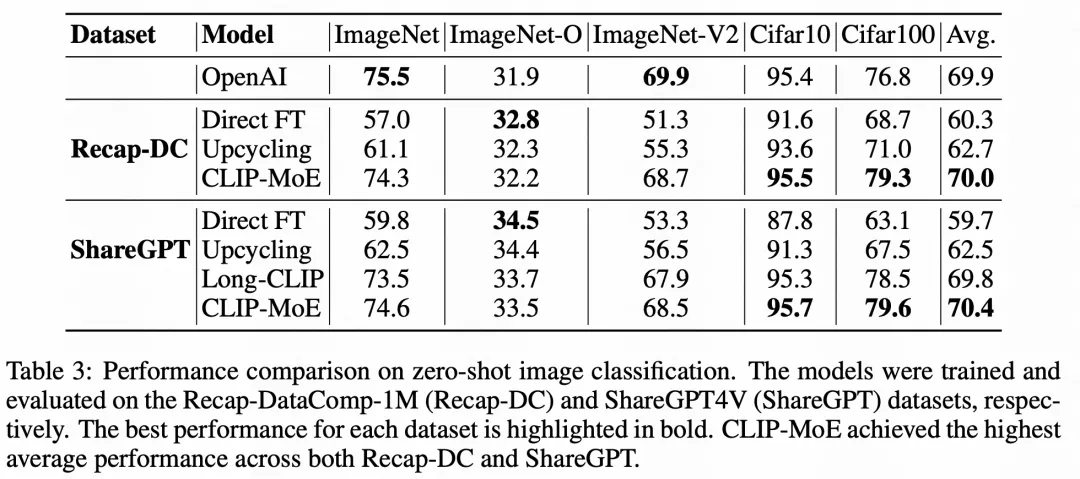

通過實驗結果來看,本文的CLIP預訓練方法在零樣本學習場景的圖文檢索、圖像分類等任務上取得了顯著的效果提升。

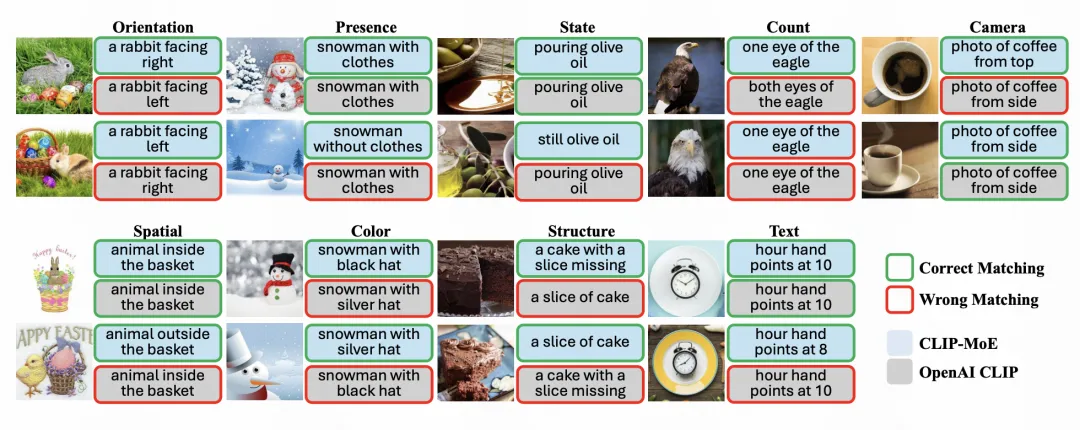

文中也通過case分析了這種CLIP-MoE結構對于細粒度圖文匹配的有效性。CLIP-MoE能夠更加關注圖像中的細節信息,做出和文本更準確的匹配。

本文轉載自 ??圓圓的算法筆記??,作者: Fareise