即插即用,無痛增強模型生成美感!字節跳動提出VMix:細粒度美學控制,光影、色彩全搞定

文章鏈接:https://arxiv.org/pdf/2412.20800

代碼地址:https://github.com/fenfenfenfan/VMix

項目地址:https://vmix-diffusion.github.io/VMix/

亮點直擊

- 分析并探索現有模型在光影、色彩等細粒度美學維度上生成圖像的差異,提出在文本提示中解耦這些屬性,并構建一個細粒度的美學標簽體系,提供清晰的模型優化方向;

- 提出VMix條件注入方法,它將輸入文本提示解耦為內容描述和美學描述,通過值混合交叉注意力的條件控制方法,從不同維度提升模型生成的美感;

- 提出的方法對于現有的擴散模型具有普適效果,作者基于此訓練了一個即插即用的美學適配器,與社區模塊高度兼容。

- 實驗表明,提出的方法能顯著提升現有模型生成美感,優于FreeU、DPO、Textual Inversion等方法。

總結速覽

解決的問題:

- 擴散模型在文本到圖像生成方面表現出色,現有方法在提升圖像質量以滿足人類偏好方面做出了努力,但未能充分滿足人類對視覺生成內容的細粒度審美偏好,如自然光線、豐富色彩和合理構圖等;

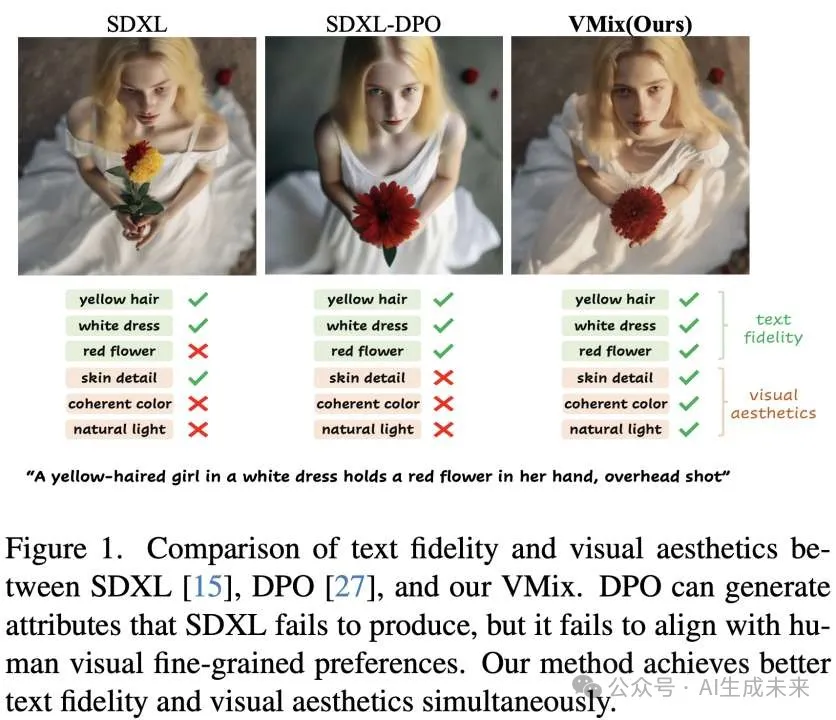

- 現有方法在提升圖像質量以滿足人類偏好方面做出了努力,如FreeU、DPO等,盡管整體生成結果可能在文本對齊方面表現更好,但可能在視覺構圖等方面表現較差,現有方法未能準確對齊生成圖像與人類偏好。

提出的方案:

- 通過對齊人類設計師偏好,構建包括光影、色彩、構圖等不同美學標簽,將文本條件解耦成內容描述和美學描述;

- 提出新的條件注入方法VMix,通過審美嵌入初始化模塊和跨注意力混合控制模塊,在保持原有模型圖文匹配能力同時,提升美學表現;

- VMix設計靈活,能夠與社區模塊(如LoRA、ControlNet和IPAdapter)兼容,為圖像生成提供更大的創造能力。

應用的技術:

- 擴散模型架構:Stable Diffusion、SDXL被作為基礎圖像生成模型進行實驗,通過凍結基模僅訓練額外小參數網絡提升模型美感;

- 美學向量初始化:通過初始化美學向量,將輸入文本提示分離為內容描述和多維度美學描述,并通過映射網絡將審美標簽作為額外條件整合到去噪模型中;

- 值混合交叉注意力:引入交叉注意力混合控制網絡,在不直接改變注意力圖的同時,最小化對圖像-文本對齊的不利影響,從而更好的注入美學條件。

達到的效果:

- VMix能夠在不損害模型原有圖文匹配能力的同時,提升模型在光影、色彩、構圖等不同美學維度的表現;在與其他方法,如FreeU、DPO、Textual Inversion的比較中表現更出色,證明了其在提升圖像美感方面的有效性。

- 在MJHQ-30K和LAION-HQ10K基準測試中,VMix在Aes分數上取得了最高分,表明其在提升美感的重要性。用戶研究也表明,應用VMix后,預訓練和開源模型更受用戶青睞。

方法

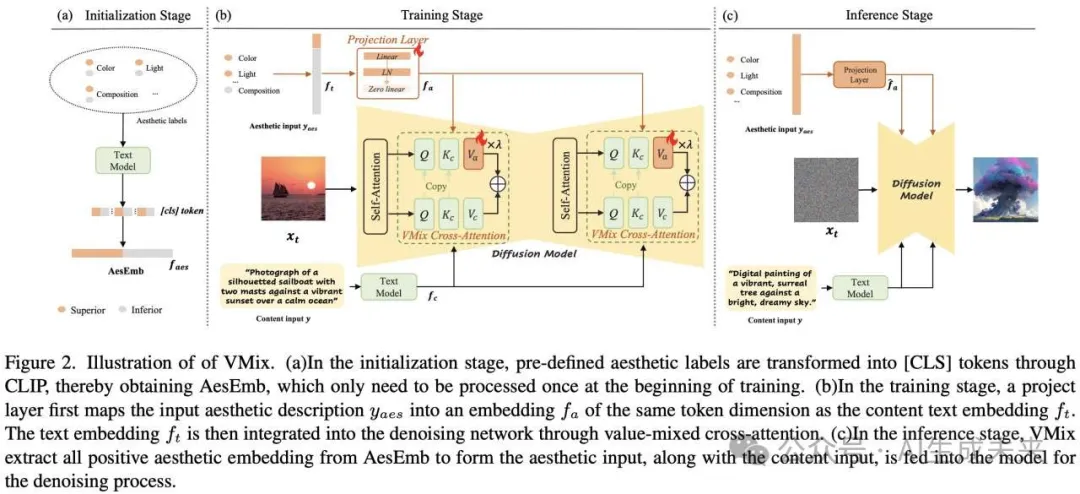

VMix框架的pipeline和實現細節,如下圖所示,分為三個階段:

(1)美學向量初始化階段;(2)訓練階段;(3)推理階段

美學向量初始化

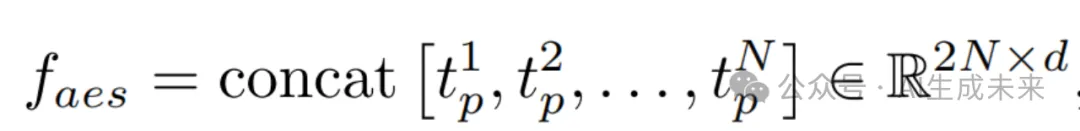

其中d是維度,N表示美學標簽對的數量。

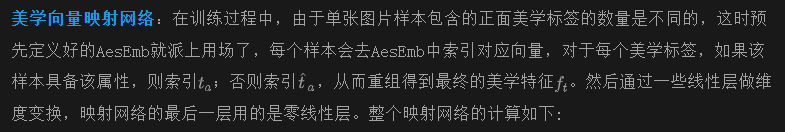

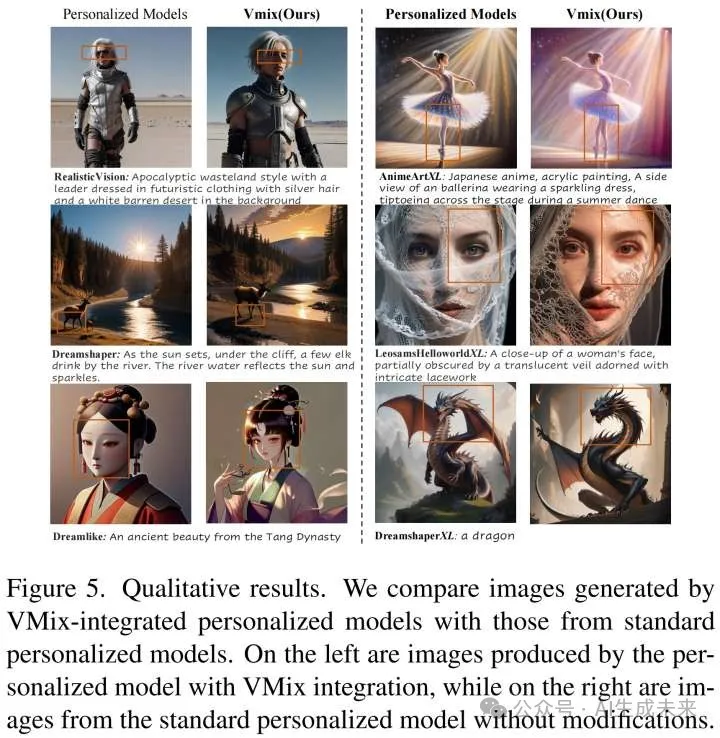

交叉注意力混合控制

fa是從美學向量映射網絡出的最終文本特征。在訓練開始時,作為連接層的零初始化線性層的權重和偏置被設置為零。這種初始化確保了微調模型不會引入有害噪聲,從而保留了原始預訓練模型的能力。

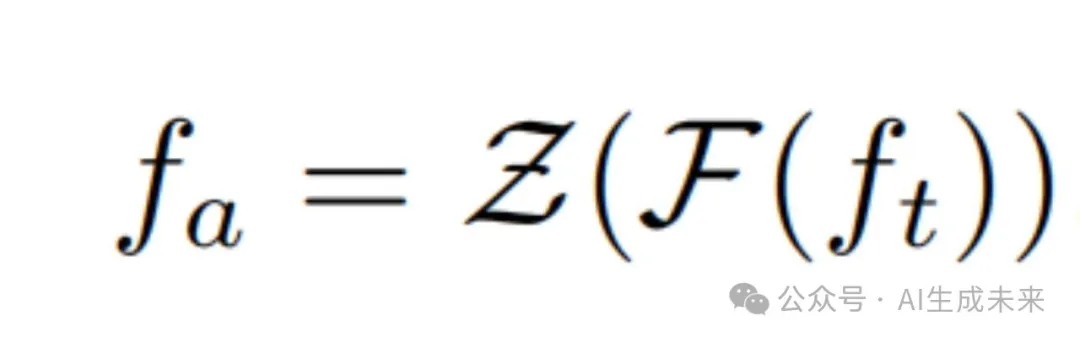

值混合交叉注意力:交叉注意力層中的注意力圖決定了文本標記在每個圖像塊的概率分布,為了盡可能保留預訓練模型中固有的圖文匹配能力,通過內容分支和美學分支雙分支的方式在擴散模型中引入值混合交叉注意力網絡,這兩個分支共享注意力圖,對于美學分支,僅讓網絡學習一個新的value,從而減少注入過程中對原始注意力圖的影響,這個過程可以表示為:

訓練及推理細節

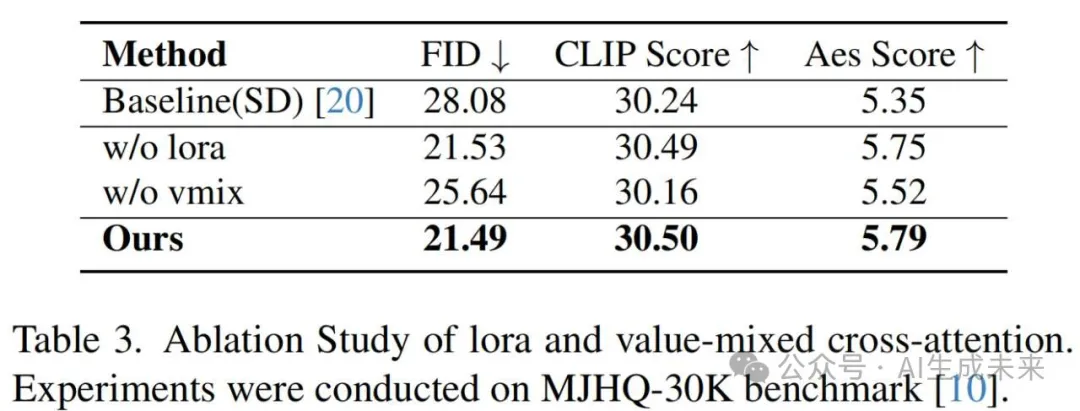

模型全參數訓練雖然會有更高的上限,但會產生高昂的成本,并且高度定制化;訓練過程中,基模參數被凍結,只訓練新增的映射網絡和值混合交叉注意力網絡,基模通過掛載一個小參數的LoRA,從而使模型訓練過程更加穩定,并增強了其適用性。訓練完成后,形成一個即插即用的模塊。在推理階段,默認使用所有正面的審美標簽,如上圖(c)所示,從而提升模型在所有審美維度上的生成質量。盡管在訓練階段使用了LoRA,在推理階段這不是必需的,后面有相關的消融實驗

實驗結果

實驗設置

訓練數據:從LAION等大型公開英文數據集中提取了20萬張圖片,采用自動和人工過濾組合方式進行清洗。這批圖除了內容描述文本外,還會標注不同美學維度(如色彩、光影、構圖、重心等)的分類標簽,用來作為訓練過程中的額外條件。

訓練設置:SD1.5和SDXL的學習率分別設置為1e?4和1e?5。Batch size設置為256,實驗中的總訓練步數為50,000。在推理階段,使用DDIM采樣器進行采樣25步,CFG為7.5,不使用反向提示詞。

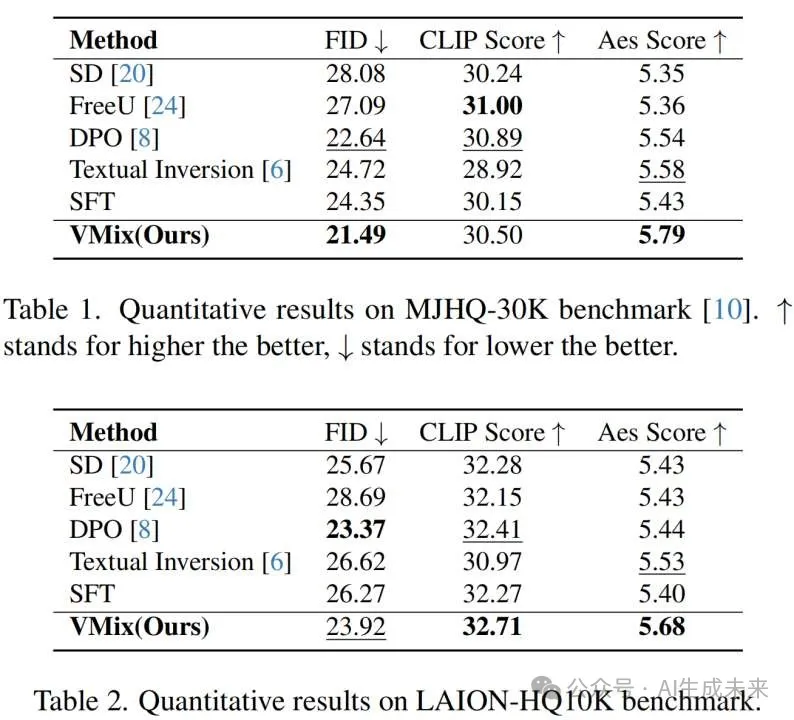

評估細節:除了使用MJHQ-30K數據集進行評估外,額外構建一個只包含高美學和高分辨率圖片的LAION-HQ10K數據集,使用FID、CLIP Score和Aes Score衡量生成圖像的整體質量。

結果

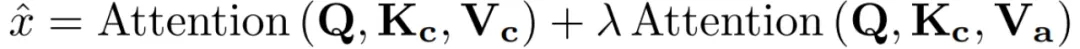

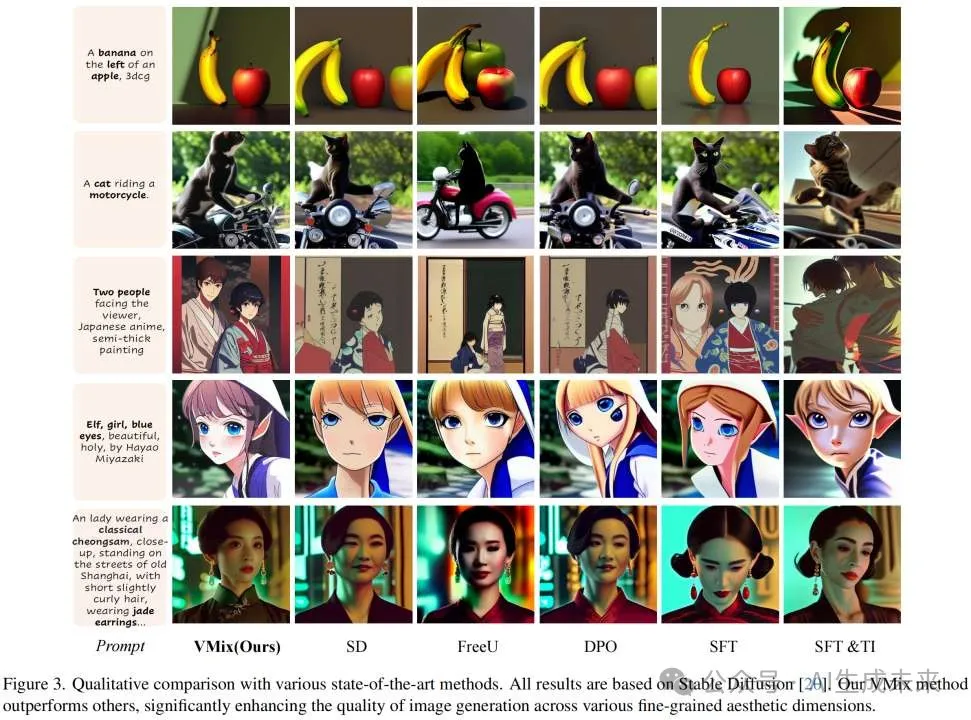

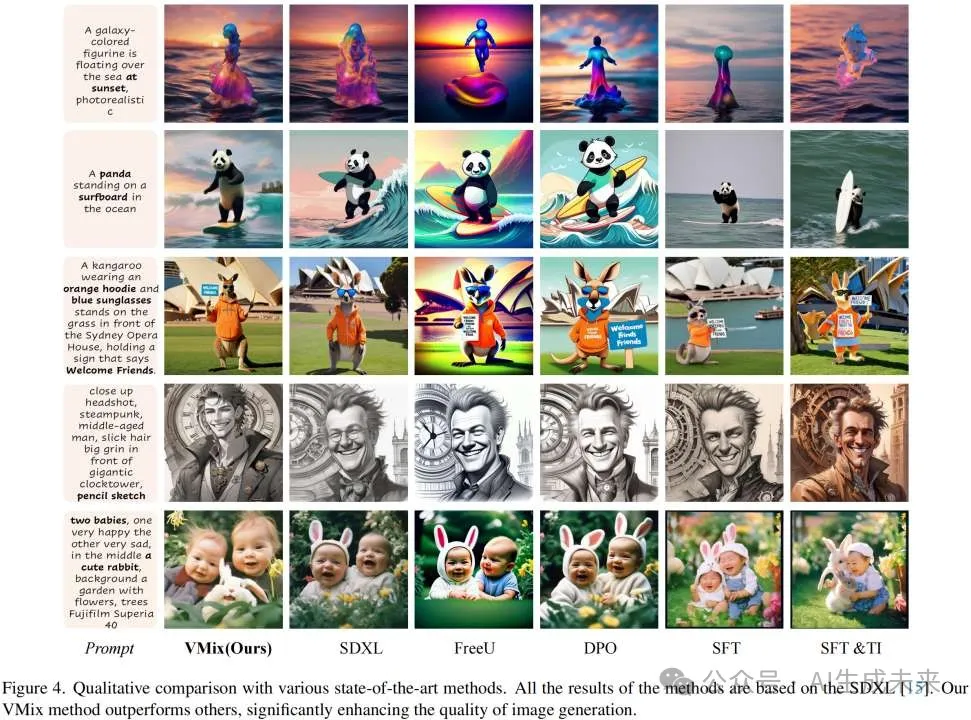

定性比較:在視覺效果上,VMix顯著優于其它方法,并且與使用同樣訓練集的SFT方法比,VMix的效果更好,從而驗證了條件注入的有效性,同時對高質量數據進行消融。此外,VMix作為插件可以直接應用于開源模型,提升它們的美學表現。

SD1.5上不同方法的比較

SDXL上不同方法的比較

應用于開源模型的效果

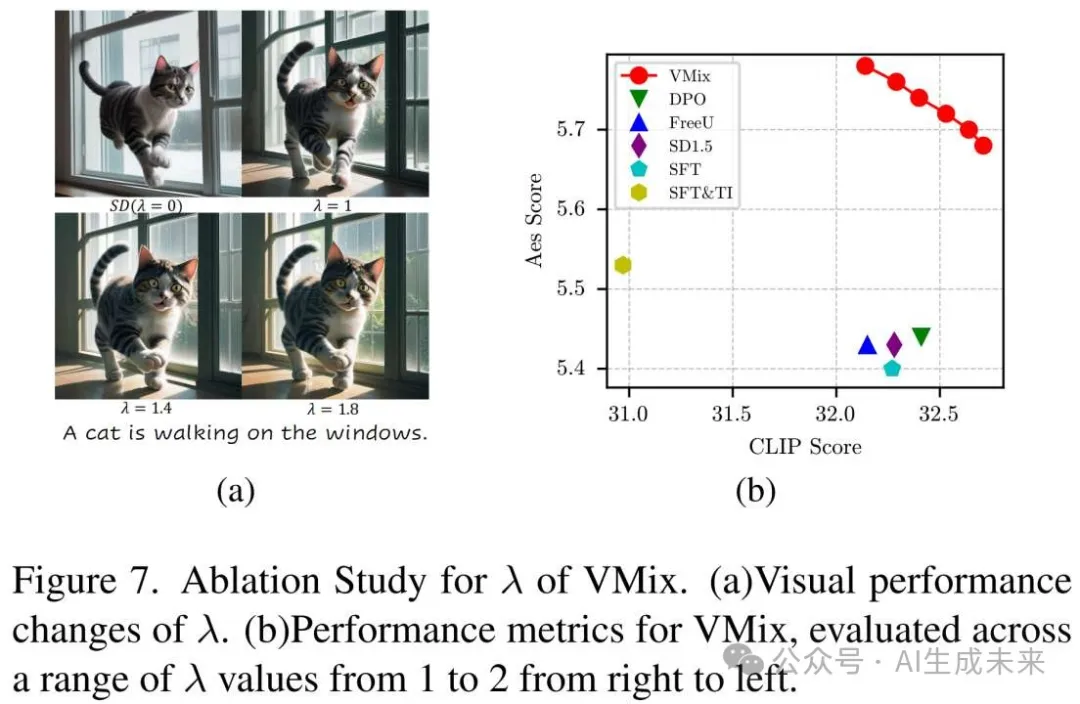

定量指標:VMix模型有著最高的Aes Score,并且可以看到基模的圖文匹配能力并沒有受到影響,甚至條件解耦后模型相較普通SFT方式更容易在高質量數據集上收斂。推理階段隨著增大,圖片美感也會隨之提升。

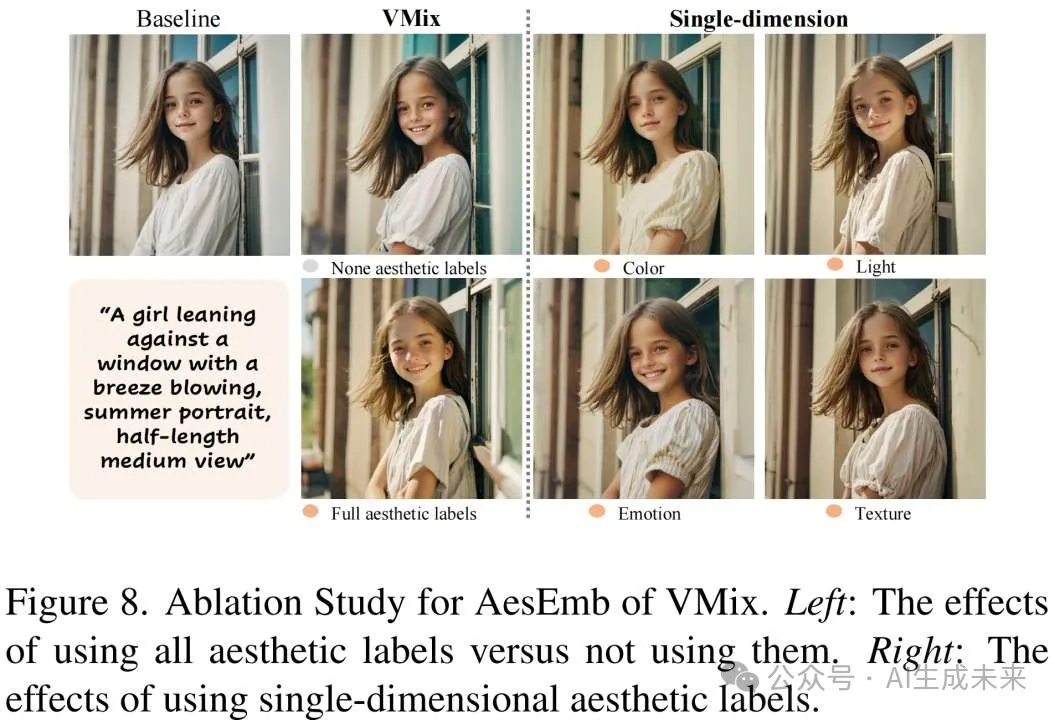

消融實驗:文中進一步分析了AesEmb不同維度對生成結果的影響,可以看到不同美學維度都能明顯改善圖片質量,當一起使用時效果最好;文中還對對LoRA的使用進行了消融,從而驗證模型性能的提升主要來自VMix本身。

結論

這項研究提出了VMix,它通過引入美學標簽(光影、色彩、構圖等)作為額外的條件,并采用交叉注意力混合控制方法來增強模型在各種美學維度上的表現。論文發現,讓模型對齊人類期望的最關鍵因素之一是使用適當的條件控制方法,在解耦的細粒度美學標簽下進行訓練。受此啟發,論文提出了一種有效的條件控制方法,顯著提高了模型的生成質量。廣泛的實驗驗證了VMix在文本忠實度和視覺美學方面超越了其他最先進的方法。作為一個即插即用的插件,VMix可以與開源模型無縫集成,提升審美表現,從而進一步推動社區的發展。

本文轉自AI生成未來 ,作者:AI生成未來