具身智能成敗之關鍵!干貨長文首次全面回顧具身智能領域中的視覺-語言-動作模型!

文章鏈接:https://arxiv.org/pdf/2405.14093

亮點直擊

本綜述是關于具身智能領域中新興的視覺-語言-動作模型的首次全面回顧。

- 全面回顧。對具身智能領域中涌現的VLA模型進行了全面回顧,涵蓋了架構、訓練目標和機器人任務等各個方面。

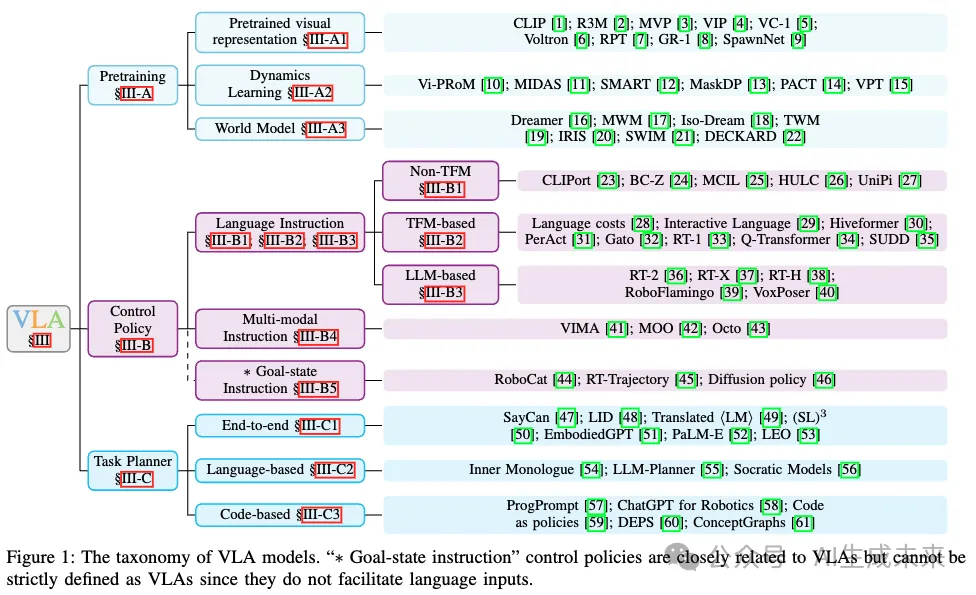

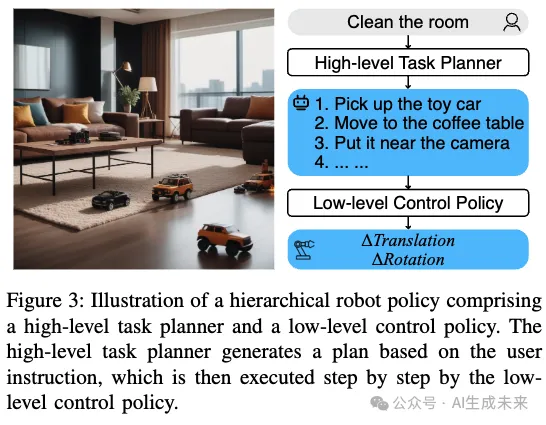

- 分類法。引入了當前機器人系統的分層結構分類法,包含三個主要組件:預訓練、控制策略和任務規劃器。預訓練技術旨在增強VLAs的特定方面,如視覺編碼器或動力學模型。低層次控制策略根據指定的語言命令和感知到的環境執行低層次動作。高層次任務規劃器將長遠任務分解為由控制策略執行的子任務。

- 豐富資源。概述了訓練和評估VLA模型所需的資源。通過比較它們的關鍵特性,調查了最近引入的數據集和模擬器。此外,還列出了廣泛采用的基準測試,涉及機器人控制和具身推理等任務。

- 未來方向。概述了該領域當前的挑戰和未來的潛在機遇,例如解決數據稀缺問題、增強機器人靈活性、實現跨任務、環境和實體的泛化能力,以及提高機器人安全性。

深度學習在許多領域中展現出了顯著的成功,包括計算機視覺、自然語言處理和強化學習。這些領域的代表性人工神經網絡涵蓋了卷積神經網絡、Transformer模型以及深度Q-networks。基于單一模態神經網絡,許多多模態模型被引入以解決一系列任務,如視覺問答、圖像字幕生成和語音識別。隨著指令跟隨機器人策略在具身智能中的興起,一種被稱為視覺-語言-動作模型(VLAs)的新型多模態模型類別應運而生。這些模型的多模態能力已成為機器人學習的基礎要素。為了增強模型的多功能性、靈活性和泛化能力,提出了各種方法。有些模型專注于通過預訓練來優化特定組件,另一些則旨在開發能夠預測低級別動作的控制策略。某些VLAs作為高層次任務規劃器,可以將長遠任務分解為可執行的子任務。在過去幾年中,眾多VLAs應運而生,反映了具身智能的快速發展。因此,有必要通過全面的綜述來把握這一不斷演變的領域。

I. 引言

視覺-語言-動作模型(VLAs)是一類旨在處理多模態輸入的模型,結合了來自視覺、語言和動作模態的信息。該術語最近由RT-2提出。VLAs的開發目的是為具身智能(embodied AI)處理指令跟隨任務。與其他人工智能形式如以ChatGPT為代表的對話式人工智能不同,具身智能需要控制物理實體并與環境交互。機器人技術是具身智能最突出的領域。在基于語言的機器人任務中,策略必須具備理解語言指令、視覺感知環境并生成適當動作的能力,這就需要VLAs的多模態能力。與早期的深度強化學習方法相比,基于VLA的策略在復雜環境中表現出更強的多功能性、靈活性和泛化能力。這使得VLAs不僅適用于工廠等受控環境,還適用于日常任務,如烹飪和房間清潔。

早期的深度學習發展主要由單一模態模型組成。在計算機視覺(CV)領域,像AlexNet這樣的模型展示了人工神經網絡(ANNs)的潛力。循環神經網絡(RNNs)為眾多自然語言處理(NLP)模型奠定了基礎,但近年來逐漸被Transformer模型所取代。深度Q-network(Deep Q-network)展示了人工神經網絡可以成功應對強化學習問題。借助單一模態模型在各個機器學習領域的進步,多模態模型演變得足夠強大,可以應對各種任務,如視覺問答、圖像字幕生成、語音識別等。

傳統基于強化學習的機器人策略大多專注于有限的一組任務,通常在工廠和實驗室等受控環境中進行。例如,文獻 [68] 訓練了一個專門用于抓取物體的策略。然而,對于更具多功能性的多任務策略的需求日益增加,類似于最近在大型語言模型(LLMs)和視覺-語言模型(VLMs)中的進展。開發多任務策略更具挑戰性,因為它需要學習更廣泛的技能并適應動態和不確定的環境。此外,任務規范也增加了另一層復雜性。一些方法使用單熱向量來選擇任務,但這些方法受限于訓練集中任務的數量。

基于預訓練視覺基礎模型、大型語言模型和視覺-語言模型的成功,視覺-語言-動作模型(VLAs)已展示出應對這些挑戰的能力。來自最先進的視覺編碼器的預訓練視覺表示幫助VLAs感知復雜環境,提供更精確的估計,例如對象類別、對象姿態和對象幾何形狀。隨著語言模型能力的增強,基于語言指令的任務規范成為一種可行的選擇。基礎VLMs探索了多種將視覺模型與語言模型結合的方式,包括BLIP-2、Flamingo等。來自不同領域的這些創新使VLAs能夠應對具身智能的挑戰。

不同的視覺-語言-動作模型(VLAs)各自側重不同的方面,如下圖1中的分類所示。部分VLAs通過采用專門為機器人任務設計的預訓練任務,力求增強其預訓練的視覺表示,重點在于獲取改進的視覺編碼器。同時,還有大量研究專注于機器人控制策略。在這一類別中,語言指令輸入控制策略,控制策略根據環境生成動作,然后將這些動作轉發給運動規劃器以執行。相比之下,另一類VLAs作為高層次任務規劃器運作,它們抽象了低層次的控制,專注于將長遠的機器人任務分解為子任務。這些子任務可以由控制策略逐一完成,最終完成整體任務。

相關工作。 盡管目前缺乏關于VLAs的綜述,但相關領域的現有綜述為VLA研究提供了有價值的見解。在計算機視覺領域,綜述涵蓋了從卷積神經網絡 到Transformer的廣泛視覺模型。自然語言處理模型在綜述 [75], [76] 中得到了全面總結。強化學習的深入評論可在綜述 [77]–[79] 中找到。圖神經網絡的綜述也可供參考 [80]。此外,現有的視覺-語言模型比較綜述為VLA提供了啟發 [67], [81]–[83]。另外,還有一篇關于早期具身智能的綜述 [84]。

論文結構。 § II-A 概述了單模態模型的代表性發展和里程碑。由于視覺-語言模型與視覺-語言-動作模型密切相關,§ II-B 對近期視覺-語言模型的進展進行了比較。§ III 探討了各種類型的視覺-語言-動作模型。§ IV 總結了最近的數據集、環境和具身智能的基準測試。挑戰和未來方向在§ V 中討論。

II. 背景

A. 單模態模型

視覺-語言-動作模型(VLAs)整合了三種模態,通常依賴于現有的單模態模型來處理不同模態的輸入。在計算機視覺領域,從卷積神經網絡向視覺Transformer的轉變推動了更通用視覺模型的發展。在自然語言處理領域,從循環神經網絡向Transformer的演變最初引領了“預訓練-微調”范式,隨后是由大型語言模型驅動的提示調優的成功。強化學習領域也出現了使用Transformer將馬爾可夫決策過程(MDP)建模為自回歸序列數據的趨勢。

近期單模態模型的進展在促進多模態模型(包括VLA模型)的成功方面發揮了關鍵作用。近期單模態模型成功的一個重要因素是其參數規模的不斷擴大。關于各模態中近期里程碑式發展的更全面概述,請參閱附錄中的詳細總結。

B. 視覺-語言模型

視覺-語言任務,包括圖像字幕生成、視覺問答、視覺定位,需要融合計算機視覺和自然語言處理技術。早期的嘗試,如Show and Tell,利用了早期卷積神經網絡(CNNs)和循環神經網絡(RNNs)的成功。隨著BERT 和GPT等高級語言模型的引入,基于Transformer的視覺-語言模型(VLMs)開啟了一個新時代。隨著Transformer模型的不斷擴展,大型語言模型成為了許多VLMs的新骨干。視覺Transformer的集成在增強VLMs的視覺能力方面起到了關鍵作用。VLMs與VLAs關系密切,因為VLMs的多模態架構可以很容易地被VLAs采用。例如,將動作解碼器附加到VLMs上可以將其轉化為用于低層次控制的VLAs。如果VLMs具備足夠的推理能力,它們也可以作為高層次任務規劃器。

VLMs的發展經歷了三個主要階段:自監督預訓練、對比預訓練和大型多模態模型。VLMs的一個開創性自監督預訓練方法是ViLBERT,它利用了多流Transformer架構來處理多模態輸入。受ViLBERT啟發,后續的工作探索了單流架構。在自監督預訓練之后,引入了多模態對比預訓練方法。CLIP率先利用對比學習對齊不同模態,引領了一系列相關研究。其他方法探索了其他路徑,包括擴展預訓練數據集或采用專門的多模態架構,如 [102]、BEiT-3 等工作中所見。隨著大型語言模型的興起,開發出了大型多模態模型(LMMs),其中預訓練的大規模視覺和語言模型相結合,在多模態指令跟隨任務中達到了最先進的性能。代表性的LMMs包括Flamingo、BLIP-2、LLaVA。關于VLMs近期發展的詳細介紹,請參閱附錄II-B。

C. 具身智能與機器人學習

具身智能是一種獨特的人工智能形式,能夠主動與物理環境進行交互。這使其與其他AI模型不同,如主要處理文本對話的對話AI(如ChatGPT),或專注于生成任務的生成式AI模型(如文本轉視頻生成的Sora)。具身智能涵蓋了廣泛的實體形式,包括智能家電、智能眼鏡、自動駕駛汽車等。其中,機器人是最突出的具身形式之一。

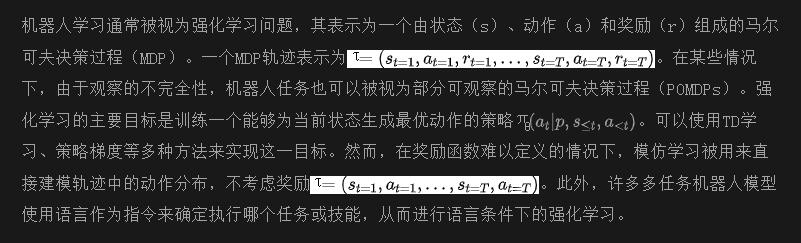

III. 視覺-語言-動作模型

視覺-語言-動作模型(VLAs)是處理視覺和語言多模態輸入并輸出機器人動作以完成具身任務的模型。它們是具身智能領域中指令跟隨機器人策略的基石。這些模型依賴于強大的視覺編碼器、語言編碼器和動作解碼器。為了提升在各種機器人任務中的表現,一些VLA模型側重于獲取優越的預訓練視覺表示(見第III-A節);另一些則集中于完善低層次控制策略,擅長接收短期任務指令并生成可通過機器人運動規劃執行的動作(見第III-B節);此外,某些VLA模型將低層次控制抽象化,專注于將長期任務分解為可由低層次控制策略執行的子任務(見第III-C節)。因此,低層次控制策略與高層次任務規劃器的結合可以被視為一種分層策略,如下圖3所示。本節內容圍繞這些主要方面展開。

A. 預訓練

VLA模型通常由處理多種模態的獨立組件組成。其中,視覺編碼器尤為重要,因為它需要編碼環境狀態并提供關于環境的充足信息。幾項研究致力于通過預訓練視覺編碼器來獲得高質量的預訓練視覺表示(PVRs)(見III-A1)。其他研究嘗試通過正向或逆向動力學預訓練模型,以學習環境的動態特性(見III-A2)。在動力學學習方面的進一步進展是學習一個世界模型(見III-A3),這允許模型從當前狀態進行狀態推演,并為策略提供更豐富的世界知識。

1)預訓練視覺表示

視覺編碼器的有效性直接影響策略的表現,因為它提供了關于對象類別、位置和環境功能的重要信息。因此,許多方法致力于通過預訓練視覺編碼器來提高PVRs的質量。其技術細節在表I中進行了比較。

盡管對比語言-圖像預訓練(CLIP)最初并不是為強化學習或機器人任務設計的,但它已廣泛應用于機器人模型中的視覺編碼器。CLIP的主要目標是在給定批次中從所有可能的組合中識別正確的文本-圖像對。通過訓練來增強視覺編碼器與語言編碼器之間的對齊,CLIP在提供文本指令作為輸入的任務中表現尤為出色。CLIP在WebImageText(WIT)數據集上進行訓練,該自定義數據集包含4億個圖文對。大規模的訓練使得CLIP能夠對視覺和文本信息之間的關系形成豐富的理解。值得注意的是,CLIP對各種視覺編碼器進行了全面的比較,探索了ResNet和ViT的不同配置。這種分析為準確性和效率之間的權衡提供了寶貴的見解。

用于機器人操作的可重用表示(R3M) 提出了兩個主要的預訓練目標:時間對比學習和視頻-語言對齊。時間對比學習的目標是最小化時間上接近的視頻幀之間的距離,同時增加時間上相距較遠的幀之間的分離度。該目標旨在創建能夠捕捉視頻序列中時間關系的PVRs。另一方面,視頻-語言對齊的目標是學習一個視頻是否與某個語言指令對應。該目標豐富了PVRs中嵌入的語義相關性。

Masked Visual Pre-training (MVP) 采用了計算機視覺領域的遮罩自編碼器(MAE)方法。MAE 的工作原理是對輸入到 ViT 模型的一部分圖像塊進行遮罩處理,然后訓練模型重建這些被破壞的圖像塊。這種方法與 BERT中使用的遮罩語言模型技術非常相似,屬于自監督訓練的范疇。MVP 將這種 MAE 目標擴展到各種機器人數據集上,證明預訓練的視覺編碼器在后續操控任務中的表現顯著提升。

Value-Implicit Pre-training (VIP)

Visual Cortex (VC-1) 對先前的預訓練視覺表示(PVRs)進行了深入研究,并通過在不同數據集中系統地探索最佳 ViT 配置,推出了一種改進的 PVR 模型。此外,他們還在多個操控和導航數據集上對其模型與之前的方法進行了全面的比較分析,揭示了提升 PVR 表現的關鍵因素。另一項研究 [113] 也比較了在監督學習或自監督學習下獲得的先前 PVRs。

Voltron 引入了一種新穎的預訓練目標,通過將語言調節和語言生成引入到遮罩自編碼(MAE)目標中。采用編碼器-解碼器結構的 Transformer ,預訓練在語言調節的遮罩圖像重建和從遮罩圖像生成語言之間交替進行。這增強了語言和視覺模態之間的對齊,從而在語言調節的模仿任務中顯著提高了成功率。

RPT RPT(Reinforcement Pretraining)在預訓練過程中,不僅專注于重建視覺輸入和機器人動作,還關注本體感受狀態。在評估三種不同的遮罩方案時,發現token masking特別能顯著提高模型的性能。

GR-1 GR-1 引入了一種新穎的視頻預測預訓練任務,專為 GPT 風格的模型設計。該視頻預測目標在微調階段也會被使用,特別是利用機器人數據。其理由在于,能夠預測未來幀有助于更準確的動作預測。實驗結果表明,在機器人操控領域,該方法的主張得到了實證支持。

SpawnNet SpawnNet 采用了一個雙流架構,通過適配器層融合了預訓練視覺編碼器的特征和從零開始學習的特征。這種創新方法不需要訓練預訓練的視覺編碼器,同時超越了參數高效微調(PEFT)方法的性能,實驗結果在機器人操控任務中驗證了這一點。

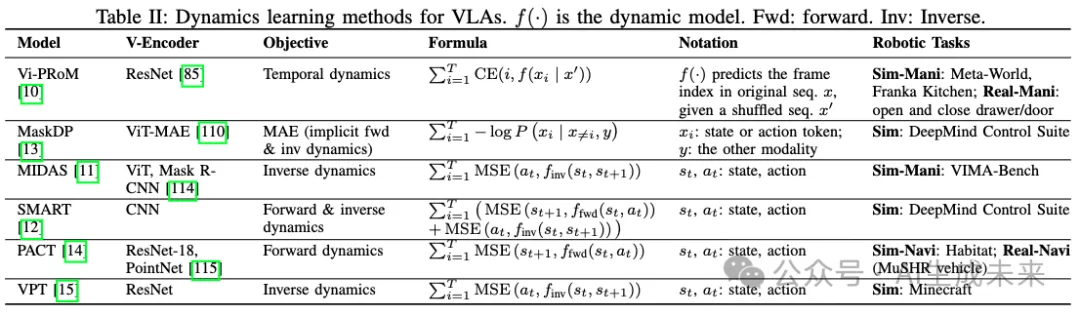

2) 動力學學習

動力學學習包含了使模型理解正向或逆向動力學的目標。正向動力學涉及預測給定動作后的下一個狀態,而逆向動力學則涉及確定從先前狀態過渡到已知后續狀態所需的動作。一些研究方法還將這些目標框定為打亂狀態序列的重新排序問題。雖然正向動力學模型與世界模型密切相關,本小節專注于利用動力學學習作為輔助任務來提升主要機器人任務性能的研究方法。在下表 II 中進行了比較。

Vi-PRoM Vi-PRoM 提出了三種不同的預訓練目標。首先是對比自監督學習目標,旨在區分不同的視頻。其余兩個目標集中在監督學習任務上:時間動態學習,旨在恢復打亂的視頻幀;以及使用偽標簽進行的圖像分類。通過與先前的預訓練方法進行全面比較,Vi-PRoM 在行為克隆和 PPO(Proximal Policy Optimization)任務中展示了其有效性。

MIDAS MIDAS 引入了逆向動力學預測任務作為其預訓練的一部分。其目標是訓練模型從觀察中預測動作,這被制定為一個跟隨運動的任務。這種方法增強了模型對環境過渡動態的理解。

SMART SMART 提出了一個包含三種不同目標的預訓練方案:前向動力學預測、逆向動力學預測和隨機遮罩的事后控制。前向動力學預測任務涉及預測下一個潛在狀態,而逆向動力學預測任務則涉及預測最后一個動作。在事后控制的情況下,整個控制序列作為輸入提供,其中一些動作被遮罩,模型則被訓練以恢復這些遮罩的動作。前兩種動力學預測任務有助于捕捉局部和短期動態,而第三個任務旨在捕捉全局和長期的時間依賴性。

MaskDP MaskDP 特點是遮罩決策預測任務,其中狀態和動作token都被遮罩以進行重建。這個遮罩建模任務專門設計來使模型理解前向和逆向動力學。與之前的遮罩建模方法(如 BERT 或 MAE)不同的是,MaskDP 直接應用于下游任務。

Perception-Action Causal Transformer (PACT) PACT 引入了一種預訓練目標,旨在建模狀態-動作過渡。PACT 接收狀態和動作序列作為輸入,并以自回歸的方式預測每個狀態和動作token。這個預訓練模型作為動力學模型,之后可以針對各種下游任務如定位、地圖制作和導航進行微調。

Video Pretraining (VPT) VPT 提出了一個利用未token的互聯網數據來預訓練 Minecraft 游戲基礎模型的方法。該方法首先使用有限量的token數據訓練逆向動力學模型,然后利用該模型token互聯網視頻。隨后,使用這些新自動token的數據通過行為克隆來訓練 VPT 基礎模型。這種方法遵循了半監督模仿學習。因此,該模型在多種任務上展示了人類水平的表現。

3) 世界模型

Dreamer使用三個主要模塊構建潛在動力學模型:表示模型(負責將圖像編碼為潛在狀態);過渡模型(捕捉潛在狀態之間的過渡);和獎勵模型(預測與給定狀態相關的獎勵)。在演員-評論家框架下,Dreamer 利用動作模型和價值模型通過傳播分析梯度來學習行為。基于這一基礎,DreamerV2引入了離散的潛在狀態空間,并改進了目標。DreamerV3擴展了其關注的領域范圍,并固定了超參數。

Masked World Model (MWM)

Iso-Dream Iso-Dream 對 Dreamer 框架進行了兩個關鍵改進:1)逆向動力學優化: 它將可控和不可控動力學分離,使處理不直接受控制的狀態過渡更加高效。2) 優化代理行為: 通過使用分離的潛在想象,Iso-Dream 改進了長遠任務的決策能力,因為不可控的動態可以與動作獨立展開。

基于Transformer的世界模型 (TWM)

IRIS IRIS 使用類似 GPT 的自回歸Transformer作為其世界模型的基礎,并采用 VQ-VAE 作為視覺編碼器。該策略通過從真實觀察中生成的潛在軌跡進行訓練,這些軌跡由世界模型生成,類似于 TWM 的方法。

SWIM

DECKARD

優缺點

預訓練的視覺表示突出了視覺編碼器的重要性,因為視覺觀察在感知環境當前狀態中起著關鍵作用。因此,它為整體模型的性能設定了上限。在 VLA 中,通用視覺模型通過使用機器人或人類數據進行預訓練,以增強在物體檢測、適應圖提取甚至視覺-語言對齊等任務中的能力,這些都是機器人任務的核心。而動力學學習則專注于理解狀態之間的過渡。這不僅涉及將視覺觀察映射到良好的狀態表示,還包括理解不同動作如何導致不同狀態,反之亦然。現有的動力學學習方法通常通過簡單的mask 建模或重新排序目標來捕捉狀態與動作之間的關系。相比之下,世界模型旨在完全建模世界的動態,使機器人模型能夠基于當前狀態預測多步未來的狀態,從而更好地預測最佳動作。因此,盡管世界模型更具吸引力,但實現起來也更具挑戰性。

B. 低級控制策略

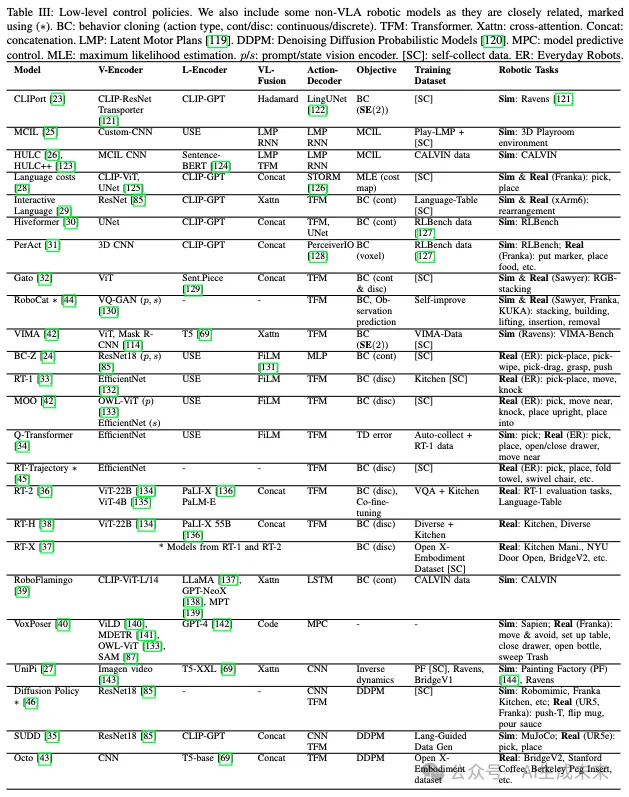

通過將動作解碼器與感知模塊(如視覺編碼器和語言編碼器)集成,形成了一個政策網絡,用于在模擬或現實環境中執行指令。控制策略網絡的多樣性體現在編碼器/解碼器類型的選擇以及這些模塊的集成策略。該子節探討了低級控制策略的不同方法。語言指令控制策略包括以下幾種類型:非Transformer型(III-B1)、基于Transformer型(III-B2)和基于大型語言模型型(III-B3)。還有其他一些控制策略處理多模態指令(III-B4)和目標狀態指令(III-B5)。在下表 III 中,比較了不同控制策略的各個方面。

1) 非Transformer語言指令控制策略

CLIPort

BC-Z

MCIL MCIL 代表了一種開創性的機器人策略,整合了自由形式自然語言條件,這與早期通常依賴于任務 ID 或目標圖像的條件方法形成對比。MCIL 引入了利用未token和無結構演示數據的能力。這通過訓練策略以遵循圖像或語言目標來實現,其中少量訓練數據集包含配對的圖像和語言目標。

HULC HULC 介紹了幾種旨在增強機器人學習架構的技術。這些技術包括機器學習的分層分解、多模態Transformer和離散潛在計劃。Transformer學習高層行為,分層劃分低層局部策略和全局計劃。此外,HULC 引入了一種基于對比學習的視覺-語言語義對齊損失,以對齊視覺-語言(VL)模態。HULC++進一步整合了自監督適應模型。該模型指導 HULC 到語言指令指定的可操作區域,使其能夠在該指定區域內完成任務。

Universal Policy (UniPi)

2) 基于Transformer的語言指令控制策略:

Language Costs

Interactive Language Interactive Language 提出了一個機器人系統,其中低級控制策略可以通過語言實時引導,從而完成長遠的重新排列任務。這種基于語言的引導的有效性主要歸功于使用了一個精心收集的數據集,該數據集包含了大量的語言指令,規模超出了以往數據集一個數量級。

Hiveformer Hiveformer 主要強調利用多視角場景觀察和保持完整觀察歷史來進行語言條件策略。這一方法相比于之前的系統(如 CLIPort 和 BC-Z)有所進步,后者僅使用當前觀察。值得注意的是,Hiveformer 是最早采用Transformer架構作為策略骨干的系統之一。

Perceiver-Actor (PerAct) PerAct 在觀察和動作空間上都實現了進步,通過利用 3D 體素表示。這種方法為動作學習提供了穩健的結構先驗,使得多視角觀察的自然處理和 6-DoF 數據增強成為可能。在這個框架中,模型的輸入是從 RGBD 圖像重建的體素圖,而輸出則是引導夾持器運動的最佳體素。通過這種方式,PerAct 即使在只有少量演示的情況下也能有效地進行任務學習。

Gato Gato 提出了一個可以同時玩 Atari 游戲、生成圖像說明和堆疊積木的模型,這些任務都使用同一組模型參數。這一成就得益于統一的token化方案,這種方案在不同任務和領域中協調了輸入和輸出。因此,Gato 使得不同任務的同時訓練成為可能。Gato 代表了一個重要的里程碑,體現了構建一個“多模態、多任務、多體現通用代理”的潛力。

RT-1 RT-1 由與 BC-Z 同一團隊開發,雖然與 BC-Z 類似,但引入了一些關鍵區別。特別是,RT-1 采用了基于更高效的 EfficientNet的視覺編碼器,區別于 BC-Z 使用的 ResNet18。語言指令也通過 USE 進行編碼,并通過 FiLM 層與圖像嵌入結合。然而,RT-1 不使用視頻作為任務指令,與 BC-Z 不同。此外,RT-1 將 BC-Z 中的 MLP 動作解碼器替換為Transformer解碼器,生成離散動作。這一修改使得 RT-1 能夠關注過去的圖像,從而提升了其性能。

Q-Transformer Q-Transformer 通過引入自回歸 Q 函數擴展了 RT-1。與通過模仿學習學習專家軌跡的 RT-1 不同,Q-Transformer 采用了 Q 學習方法。除了 Q 學習的 TD 誤差目標外,Q-Transformer 還引入了保守正則化器,以確保最大值動作保持在分布內。這種方法使 Q-Transformer 能夠利用成功的演示和失敗的軌跡進行學習。

Scaling Up and Distilling Down (SUDD) SUDD 提出了一個框架,其中大語言模型(LLM)指導數據生成,并隨后將過濾后的數據集蒸餾成視聽語言動作(visuo-linguo-motor)策略。該框架通過將 LLM 與一套基本的機器人工具(如抓取采樣器、運動規劃器)組合,實現在語言指導下的數據生成。接著,SUDD 擴展了 Diffusion Policy,通過結合基于語言的條件進行多任務學習。這種基于擴散的策略從成功的軌跡中學習,促進了過濾數據集的蒸餾。

3) 基于 LLM 的語言指令控制策略:

RT-2 RT-2 致力于利用大型多模態模型在機器人任務中的能力,受到 PaLI-X和 PaLM-E等模型的啟發。該方法引入了共同微調(co-fine-tuning),旨在使模型適應互聯網規模的視覺問答(VQA)數據和機器人數據。這種訓練方案增強了模型的泛化能力,并帶來了新興的能力。RT-2 代表了低級控制策略與高級任務規劃者的整合,追求更全面的機器人系統。

RT-X RT-X 在 RT-1 和 RT-2 模型的基礎上進行構建。這些模型使用新引入的開源大型數據集 Open X-Embodiment (OXE) 進行了再訓練,OXE 的規模比以前的數據集大幾個數量級。OXE 包含 160,266 個任務,涵蓋 527 種技能和 22 種體現。由于 OXE 數據集更廣泛且更大,最終生成的模型 RT-1-X 和 RT-2-X 的性能均優于其原始版本。

RT-H RT-H 引入了一種動作層級結構,其中包括一個語言動作的中間預測層,位于語言指令和低級動作(如平移和旋轉)之間。這一額外的層次促進了不同任務之間的數據共享。例如,語言指令“pick”(拾取)和“pour”(倒出)可能都涉及到語言動作“move the arm up”(抬起手臂)。此外,這種動作層級結構使得用戶能夠指定糾正措施以從失敗中恢復,模型可以從中學習。

RoboFlamingo RoboFlamingo 通過將現有的視覺語言模型(VLM)Flamingo 適配為機器人策略,展示了預訓練的 VLM 可以有效轉移到語言條件下的機器人操作任務。具體做法是將一個基于 LSTM 的策略頭附加到 VLM 上。

VoxPoser VoxPoser 使用大語言模型(LLM)和 VLM 創建兩個 3D 體素圖,這些圖表示了可用性和約束。它利用 LLM 的編程能力和 VLM 模型的感知能力(如 ViLD、MDETR、OWL-ViT、SAM)。LLM 將語言指令轉換為可執行代碼,調用 VLM 獲取物體坐標。基于組合的可用性和約束圖,VoxPoser 使用模型預測控制生成機器人手臂末端執行器的可行軌跡。值得注意的是,VoxPoser 不需要任何訓練,因為它直接連接 LLM 和 VLM 進行運動規劃,與之前基于 LLM 的高級任務規劃器(如 PaLM-E 和 ChatGPT for Robotics)不同。

4) 多模態指令控制策略:

VIMA

VIMA 重點關注多模態提示和模型的泛化能力。通過結合多模態提示,可以制定比傳統純文本提示更具體和復雜的任務。VIMA 引入了四種主要類型的任務:物體操作、視覺目標到達、新概念基礎、一-shot 視頻模仿、視覺約束滿足、視覺推理。這些任務通常難以僅用語言提示來表達。VIMA-Bench 已開發用于評估四個泛化水平:位置、組合、新物體、新任務。

MOO

MOO 擴展了 RT-1 以處理多模態提示。利用 RT-1 的基礎,MOO 融合了 OWL-ViT 來編碼提示中的圖像。通過用新物體和額外的提示圖像擴展 RT-1 數據集,MOO 提升了 RT-1 的泛化能力。這一擴展還促進了指定目標物體的新方法,例如用手指指向或點擊圖形用戶界面。

Octo

Octo 介紹了一種基于Transformer的擴散策略,其特點是開放框架設計,允許從不同的任務定義編碼器、觀測編碼器和動作解碼器靈活連接到 Octo Transformer。作為首批利用 Open X-Embodiment 數據集的模型之一,Octo 展示了在各種機器人和任務中的積極遷移和泛化能力。

5) 目標狀態指令控制策略

RoboCat

RoboCat 提出了一個自我改進過程,旨在使智能體能夠快速適應新任務,只需 100 個示例。這個自我改進過程通過對模型進行迭代微調,并使用微調后的模型自生成新數據。基于 Gato 模型,RoboCat 融合了 VQ-GAN 圖像編碼器。在訓練過程中,RoboCat 預測不僅是下一步動作,還有未來的觀測。通過在模擬和現實環境下的多任務、多體現設置中進行的全面實驗,證明了自我改進過程的有效性。

RT-Trajectory

RT-Trajectory 采用軌跡草圖作為策略條件,而不是依賴語言條件或目標條件。這些軌跡草圖由曲線組成,描述了機器人末端執行器應跟隨的預期軌跡。它們可以通過圖形用戶界面手動指定、從人類示范視頻中提取,或由基礎模型生成。RT-Trajectory 的策略基于 RT-1 并經過訓練,以控制機器人手臂準確跟隨軌跡草圖。這種方法促進了對新物體、任務和技能的泛化,因為來自各種任務的軌跡是可遷移的。

擴散策略

優缺點

a) 架構:

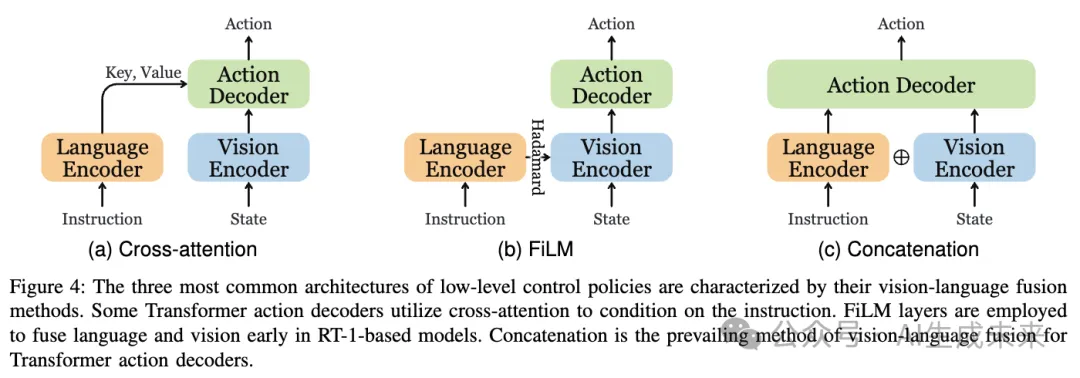

各種視覺語言架構探索了不同的視覺和語言輸入融合方法,包括交叉注意力(cross-attention)、FiLM 和拼接(concatenation),如下圖 4 所示。FiLM 被用于 RT-1,因此其后續工作繼承了這一機制。盡管交叉注意力可能在小型模型中提供更優的性能,但拼接實現較為簡單,并且在大型模型中可以達到類似的結果。

b) 動作類型及其訓練目標:

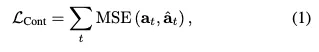

大多數低級控制策略預測末端執行器的動作,同時抽象掉了控制各個關節運動的運動規劃模塊,這些模塊使用逆向運動學進行控制。雖然這種抽象有助于更好的泛化到不同的體現(embodiments),但也對靈活性施加了限制。行為克隆(BC)目標用于模仿學習,對于不同的動作類型有不同的變體。連續動作的 BC 目標可以表示為:

其中,CE(·) 表示交叉熵損失。CLIPort和 VIMA使用 SE(2) 動作,其行為克隆目標可以表示為:

擴散控制策略中的 DDPM 目標表示為:

盡管離散動作在 RT-1 中表現出色,Octo認為這會導致早期抓取問題。SE(2) 動作僅要求模型預測兩個末端執行器姿勢,例如抓取姿勢和放置姿勢。雖然這種動作類型最多只能在兩次前向傳遞中進行預測,但它也限制了動作的靈活性和泛化能力。

c) 擴散基策略:

擴散基策略利用了擴散模型在計算機視覺領域的成功。其中,Diffusion Policy 是最早利用擴散生成動作的模型之一。SUDD為 Diffusion Policy 添加了語言條件支持。Octo采用模塊化設計以適應各種類型的提示和觀察。與常見的行為克隆策略相比,擴散策略在處理多模態動作分布和高維動作空間方面表現出優勢。

d)LLM 與非 LLM:雖然基于 LLM 的控制策略可以顯著增強遵循指令的能力,因為 LLM 更好地解析用戶意圖,但也存在訓練成本和部署速度的顧慮。特別是,較慢的推理速度可能會嚴重影響動態環境中的性能,因為環境的變化可能在 LLM 推理過程中發生。

e)RT 系列:

RT-1 啟發了一系列“機器人 Transformer”模型。在 RT-1 之前,BC-Z僅使用 MLP 層進行動作預測。在 RT-1 之后,出現了幾項工作,每項工作都引入了新功能。MOO使 RT-1 能夠處理多模態提示。RT-Trajectory使 RT-1 能夠處理軌跡草圖作為提示。Q-Transformer 利用 Q 學習來訓練 RT-1。RT-2 基于 ViT 和 LLM,介紹了與 RT-1 完全不同的架構。RT-X 用顯著更大的數據集重新訓練 RT-1 和 RT-2,導致性能提升。Transformer 膠囊超過了之前的 RNN 膠囊 ,利用 Transformer 的更高容量來吸收更大的機器人數據集。基于 RT-2,RT-H引入了動作層次結構,以更好地共享數據。

C. 高級任務規劃器

許多高級任務規劃器都是建立在大型語言模型(LLMs)之上的。雖然將多模態模塊以端到端的方式集成到 LLM 中 (III-C1) 是直觀的,但使用多模態數據進行訓練可能成本較高。因此,一些任務規劃器更傾向于使用語言 (III-C2) 或代碼 (III-C3) 作為交換多模態信息的媒介,因為它們可以被 LLM 原生處理。

1)端到端:

盡管控制策略在理解和執行簡單語言指令方面有效,但在涉及多個子任務的長期任務中,它們往往會遇到困難。大型語言模型被認為是解讀這些復雜長期任務的強大工具。因此,許多方法致力于將 LLM 集成作為高級任務規劃器。它們的目標是將長期任務分解成更簡單的子任務,從而使低級控制策略能夠按順序執行這些任務,促進層次化機器人系統的發展。表 IV 列出了這些高級任務規劃器的重要細節。

SayCan 是一個旨在將高級 LLM 規劃器與低級控制策略集成的框架。在此框架中,LLM 規劃器接受用戶的高級指令并“告訴”最可能的下一個低級技能,這一概念稱為任務定位。低級策略提供價值函數作為能力函數,確定該策略“可以”完成技能的可能性,稱為世界定位。通過考慮 LLM 的計劃和能力,框架為當前狀態選擇最佳技能。

LID 引入了一種新穎的數據收集過程,稱為主動數據收集(ADG)。ADG 的一個關鍵方面是事后重新token,它將標簽重新分配給不成功的軌跡,從而有效地最大化數據的利用,無論它們的成功與否。通過將所有環境輸入轉換為文本描述,其基于語言模型的策略展示了增強的組合泛化能力。

Translated ?LM? 采用兩步過程將高級指令轉化為可執行的動作。首先,利用預訓練的因果 LLM 進行計劃生成,將高級指令分解為用自由形式語言短語表達的下一個動作。然后,由于這些短語可能無法直接映射到 VirtualHome 動作,因此使用預訓練的mask LLM 進行動作翻譯。這一步涉及計算生成的動作短語與 VirtualHome 動作之間的相似度。翻譯后的動作被添加到計劃中,更新后的計劃由 LLM 讀取以生成下一個動作短語。兩步過程重復進行,直到形成完整的計劃。進一步提出了“重新提示”策略以生成糾正動作,當代理遇到前置條件錯誤時。

Semi-Supervised Skill Learning with Latent Language (SL)3

EmbodiedGPT 介紹了 embodied-former,它輸出任務相關的實例級特征。這是通過結合視覺編碼器嵌入的信息和 LLM 提供的具身規劃信息來實現的。實例特征用于通知低級策略有關需要采取的即時動作。

PaLM-E 集成了 ViT 和 PaLM,創建了一個大型具身多模態語言模型,能夠執行高級具身推理任務。基于感知圖像和高級語言指令,PaLM-E 生成一個文本計劃,作為低級機器人策略的指令。在移動操控環境中,它將生成的計劃映射到可執行的低級指令,并與 SayCan結合使用。隨著低級策略的執行,PaLM-E 還可以根據環境變化重新規劃。作為其核心的 PaLM 使得 PaLM-E 能夠處理正常的視覺問答(VQA)任務,以及額外的具身 VQA 任務。

LEO 發現傳統圖像輸入的使用是多模態通用智能體與 3D 世界交互的一個限制因素。這種新方法涉及通過兩個階段訓練基于 LLM 的架構。第一階段專注于 3D 視覺-語言對齊,第二階段則涉及 3D 視覺-語言-動作指令調整。LEO 不僅在 3D 標注和問答任務中表現出色,還在具身推理、具身導航和機器人操控等任務中表現優異。

2) 基于語言:

Inner Monologue 處于高級指令和低級策略之間,以實現閉環控制規劃。它利用 LLM 生成低級控制策略的語言指令,并根據控制策略收到的反饋動態更新這些指令。反饋包括多種來源:成功反饋、對象和場景反饋以及人類反饋。由于反饋以文本格式傳達給 LLM,因此無需對 LLM 進行額外訓練。類似的方法也在 ReAct 中提出,該方法交錯推理痕跡和任務特定動作。

LLM-Planner 介紹了一種新穎的方法來構建包括高級規劃器和低級規劃器的層次化策略。高級規劃器利用 LLM 的能力生成自然語言計劃,而低級規劃器將計劃中的每個子目標轉換為原始動作。盡管其整體架構與之前的方法相似,LLM-Planner 通過引入重新規劃機制來區分自己,幫助機器人“擺脫困境”。

Socratic Models (SMs) 提出了一個獨特的框架,其中不同的預訓練模型可以有效地組合在一起,無需微調。該框架基于關鍵組件——多模態信息提示,促進了具有不同多模態能力的模型之間的信息交換。這個思路是利用多模態模型將非語言輸入轉換為語言描述,從而在語言空間中統一不同的模態。除了在傳統的多模態任務中表現出色,SMs 在機器人感知和規劃中也展示了其多功能性。

3) 基于語言

ProgPrompt 介紹了一種新穎的任務規劃方法,通過類似程序的規格提示 LLM,詳細描述了可用的動作和對象。這使得 LLM 能夠以少量示例生成家庭任務的高級計劃。環境反饋可以通過程序中的斷言進行整合。這個提示方案利用了 LLM 的世界知識和編程技能。

ChatGPT for Robotics 利用 ChatGPT 的編程能力來促進“用戶在環”控制,區別于傳統的“工程師在環”方法。該過程包括幾個步驟:首先,定義一系列 API,如對象檢測 API、抓取 API、移動 API;其次,為 ChatGPT 構建一個提示,指定環境、API 功能、任務目標等;第三,迭代地提示 ChatGPT 編寫可以執行任務的代碼,提供對模擬和用戶反饋的訪問,以評估代碼質量和安全性;最后,執行 ChatGPT 生成的代碼。在這個過程中,ChatGPT 作為高級任務規劃器,類似于 PaLM-E,并通過調用相應低級 API 生成動作。

Code as Policies (CaP) 也利用了 LLM 的代碼編寫能力。它采用 GPT-3 或 Codex 生成策略代碼,然后調用感知模塊和控制 API。CaP 在空間幾何推理、新指令的泛化以及低級控制原語的參數化方面表現出色。

DEPS 代表“描述、解釋、規劃和選擇”。該方法利用 LLM 生成計劃并基于從環境中收集的反饋描述解釋失敗,這一過程被稱為“自我解釋”,有助于重新規劃。此外,DEPS 還引入了一個可訓練的目標選擇器,根據子目標的易達程度進行選擇,這一點是其他高級任務規劃器通常忽視的重要方面。

ConceptGraphs 介紹了一種將觀察序列轉換為開放詞匯 3D 場景圖的方法。對象通過 2D 分割模型從 RGB 圖像中提取,并利用 VLM 對對象進行標注并建立對象間關系,從而形成 3D 場景圖。該圖可以轉換為文本描述(JSON),為 LLM 提供實體間的豐富語義和空間關系,用于任務規劃。

優缺點

端到端任務規劃器 如 SayCan與低級控制策略共享類似架構,可以針對特定任務進行優化,但由于結合了 LLM 和視覺Transformer的大模型尺寸,其訓練成本可能會非常高。

基于語言的任務規劃器 提供了與現有語言條件控制策略無縫集成的優勢。然而,它們通常需要微調或對齊方法,以將生成的計劃映射到低級控制策略的可執行語言指令上。

基于代碼的任務規劃器 利用 LLM 的編程能力連接感知和動作模塊。這種方法不需要額外的訓練,但其性能可能受限于現有模型的能力。

VI. 數據集、模擬器與基準測試

收集真實世界的機器人數據面臨顯著的挑戰。首先,數據收集過程受到高昂的機器人設備采購成本、環境搭建費用以及大量人力資源的限制。其次,收集專家演示數據需要大量的時間投入。第三,各種機器人類型和配置的多樣性導致傳感器數據、控制模式、夾具類型等的不一致。最后,準確捕捉物體的 6D 姿態以及精確復制或重置設置依然具有挑戰。因此,公共的真實世界機器人數據集相對稀缺。此外,在真實世界條件下評估機器人系統的性能引入了另一層復雜性,因為精確重現設置非常困難,并且通常需要人工監督。我們在表 V 中總結了最近的 VLA 機器人數據集。

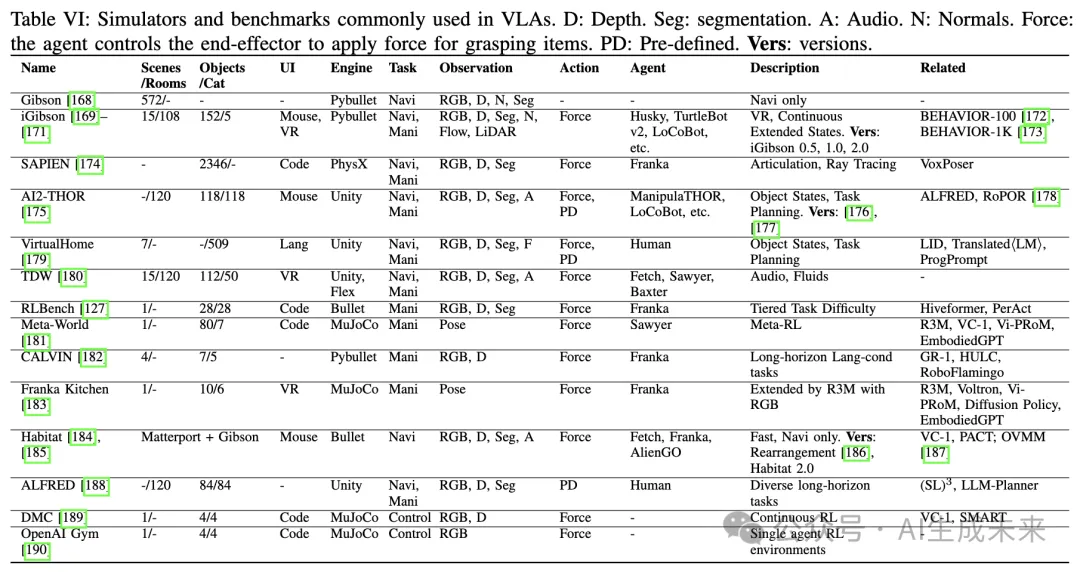

因此,許多研究人員轉而使用模擬環境來緩解這些障礙,并加速數據收集過程。然而,這種策略也存在其自身的挑戰,其中最主要的是模擬與真實之間的差距。這種差距出現于模型在模擬數據上訓練良好但在真實世界應用中表現不佳。造成這種差距的原因多種多樣,包括渲染質量的差異、物理模擬的不準確以及領域轉移,如不切實際的物體屬性和機器人運動規劃器。例如,模擬非剛性物體如液體或毛巾存在顯著困難。此外,將新物體引入模擬器需要大量的工作,通常涉及 3D 掃描和網格編輯等技術。盡管存在這些障礙,模擬環境提供了自動評估指標,幫助研究人員一致地評估機器人模型。大多數基準測試基于模擬器,因為只有模擬環境能夠準確重現實驗設置,而真實世界的評估則因不同模型而異,使得可靠比較變得不可行。HomeRobot OVMM 基準 提出了一個模擬到真實的基準,但其一致性尚待觀察。以往的研究 [171] [172] 已經總結了一些模擬器,在下表 VI 中比較了與 VLA 最相關的模擬器。

另一種解決真實世界數據稀缺問題的策略是利用人類數據。人類行為因其靈活性和多樣性,為機器人策略提供了豐富的指導。然而,這種策略也有其固有的缺點。捕捉和轉移人類手部/身體動作到機器人體型上本身具有挑戰性。此外,人類數據的不一致性也構成了障礙,因為一些數據可能是以自我視角捕獲的,而其他數據則是從第三方視角捕獲的。此外,過濾人類數據以提取有用信息可能是勞動密集型的。這些障礙突顯了將人類數據融入機器人學習過程中的復雜性。有關現有數據集的全面比較請參見 [191]。

此外,一些數據集和基準測試雖然并不直接針對機器人操作和導航,但卻專注于其他相關能力,這些能力對于具身人工智能至關重要,如空間推理、物理理解以及世界知識。這些能力對于任務規劃者而言具有極大的價值。其中最顯著的具身任務之一是具身問答(EQA)。EQA 類似于以前的視覺問答和視頻問答任務,但不同之處在于,智能體可以在回答之前主動探索環境。EmbodiedQA和 IQUAD是首次引入這一任務的工作之一。MT-EQA專注于涉及多個目標的問題,提高了理解和回答問題的復雜性。MP3D-EQA將之前的 RGB 輸入轉換為點云,測試了 3D 感知能力。然而,主動探索需要訪問模擬器,這限制了可使用的數據類型,如真實世界的視頻。因此,一些 EQA 基準測試不涉及主動探索。

EgoVQA將 VQA 的重點轉移到自我中心的視頻上。EgoTaskQA 強調空間、時間和因果關系的推理。EQA-MX關注于多模態表達(MX),包括常規的語言表達和非語言手勢,如眼神和指向。OpenEQA評估了七個主要類別,包括功能性推理和世界知識,這些在以前的基準中未曾涵蓋。EgoPlan-Bench和 EgoCOT衡量模型生成任務計劃的能力,使用如準確率和困惑度等指標。PlanBench全面評估了任務規劃能力的各個方面,如成本最優性、計劃驗證和重新規劃等。LoTa-Bench通過在模擬器中執行生成的計劃并計算成功率來直接評估任務規劃能力。

V 挑戰與未來方向

視覺-語言-行動(VLA)模型在機器人領域面臨若干持久的挑戰,需要集中關注和共同的研究努力:

機器人數據稀缺:獲取足夠的現實世界機器人數據仍然是一個重大障礙。收集這些數據既耗時又資源密集,而僅依賴于模擬數據會加劇模擬與現實之間的差距。多樣化的現實世界機器人數據集需要不同機構之間的密切合作。模擬數據則依賴于開發更現實和高效的模擬器。

運動規劃:目前的運動規劃模塊往往缺乏處理各種環境復雜性的必要靈活性。這一局限性妨礙了機器人有效地與工具互動、導航復雜環境和執行高精度操作。克服這些挑戰需要開發更強大的運動規劃算法。

實時響應:許多機器人應用需要實時決策和行動執行以滿足操作要求。VLA 模型應設計為響應迅速,延遲最小。此外,整個機器人系統的各個層次需要進行全局優化,從高層任務規劃器到運動規劃器。

多模態信息整合:VLA 必須處理和整合來自多種模態的信息,包括視覺、語言和行動。盡管在這方面已取得顯著進展,但實現這些模態的最佳整合仍然是一個持續的挑戰。解決這一挑戰需要在多模態表示學習、融合技術和任務特定適配方面取得進展。超越單純的視覺和語言能力,機器人還可以從融入音頻或語音等模態中獲得極大收益。接受更廣泛的感知和交流能力使機器人能夠與用戶進行更有效的合作。

對未知場景的泛化能力:一個真正通用的機器人系統應能夠理解和執行自然語言指令,適應各種多樣和未知的場景。實現這種級別的泛化能力,類似于 ChatGPT 在自然語言處理中的表現,需要對指令、環境、物體和機器人體態的變化具有魯棒性。這需要開發具有適應性和可擴展性的 VLA 架構。

長時間任務執行:單一指令往往可以轉化為機器人執行的長時間任務,例如指令“清理房間”,這包括物體重新排列、地面清掃、桌面擦拭等。成功執行這樣的任務需要機器人在較長時間內規劃和執行一系列低層次動作。盡管當前的高層任務規劃器取得了初步成功,但它們在許多場景中仍顯不足,因為大多數 LLM 并未針對具身任務進行調優。解決這一挑戰需要制定高效的規劃器,這些規劃器具備強大的感知能力和廣泛的常識。

基礎模型:在機器人任務中探索 VLA 的基礎模型仍然是未知領域,主要由于機器人領域中多樣化的體態、環境和任務。孤立的數據集和評估設置進一步加劇了這一挑戰。為了建立一個強大的基礎 VLA 模型,必須利用互聯網規模的具身數據集和最先進的多模態模型。

基準測試

盡管存在許多用于評估低層控制策略 VLA 的基準測試,但它們通常在評估技能的方面存在顯著差異。此外,這些基準測試中包含的對象和場景通常受到模擬器提供能力的限制。為了更全面地評估 VLA 模型,需要基于現實模擬器的基準測試,涵蓋一系列多樣化的技能。對于高層任務規劃器 VLA,許多基準測試聲稱可以衡量規劃能力,通常以問答任務的形式進行。然而,更理想的方式是將高層任務規劃器與低層控制策略一起評估,以執行長時間任務并測量成功率,而不是僅僅依賴于對規劃器的孤立衡量。這種方法提供了對 VLA 系統能力的更全面的評估。

安全考慮

在機器人技術中,安全性至關重要,因為機器人直接與現實世界互動。確保機器人系統的安全性需要在其開發和部署過程中整合現實世界的常識和復雜的推理。這涉及到強大的安全機制、風險評估框架和人機互動協議的結合。VLA 決策過程的可解釋性和可擴展性對于通過錯誤診斷和故障排除來提高機器人安全性也至關重要。

倫理和社會影響

機器人的部署總是引發各種倫理、法律和社會問題。這些問題包括隱私風險、安全性、職位流失、決策偏見以及對社會規范和人際關系的影響。有效的監管在促進機器人倫理使用方面發揮著關鍵作用。

結論

VLA 策略在使具身 AI 能夠有效地與周圍世界互動方面具有巨大的潛力。近期的進展展示了這些模型在不同條件下完成復雜任務的能力。然而,關于泛化、效率和安全性等方面仍然存在顯著挑戰。需要進一步研究以解決這些挑戰,并為 VLA 驅動的機器人在現實世界應用中的廣泛采用鋪平道路。

本文轉自?????AI生成未來,作者:Yueen Ma等