Arena-Hard:開源高質(zhì)量大模型評估基準(zhǔn)

開發(fā)一個(gè)安全、準(zhǔn)確的大模型評估基準(zhǔn)通常需要包含三個(gè)重要內(nèi)容:1)穩(wěn)定識別模型的能力;2)反映真實(shí)世界使用情況中的人類偏好;3)經(jīng)常更新以避免過擬合或測試集泄漏。

但傳統(tǒng)的基準(zhǔn)測試通常是靜態(tài)的或閉源的,同時(shí)大模型的技術(shù)發(fā)展和功能迭代比較,這凸顯了建立具有高可分離性評估基準(zhǔn)的必要性。

大模型研究組織Lmsys Org則開源了Arena-Hard。這是一個(gè)全新高質(zhì)量大模型評估基準(zhǔn)。

開源地址:https://github.com/lm-sys/arena-hard

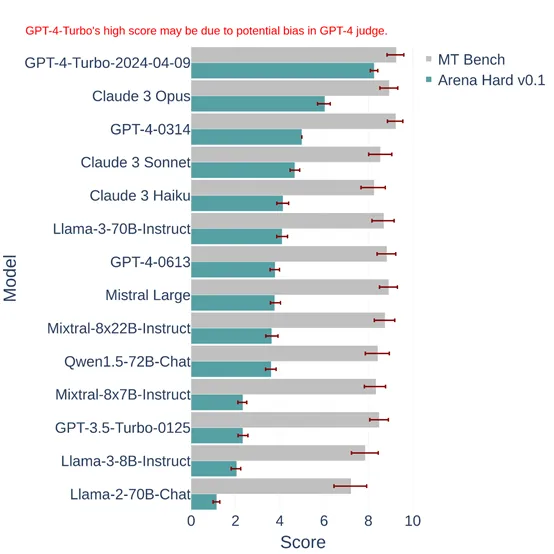

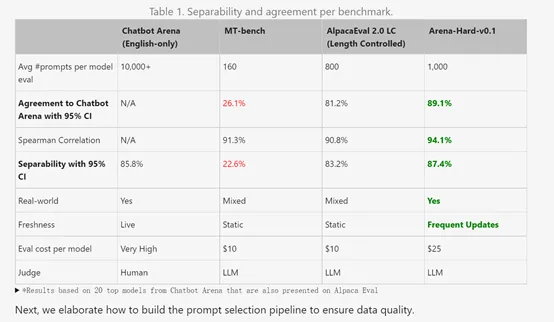

Lmsys將新的基準(zhǔn)測試平臺 Arena Hard v0.1 與當(dāng)前領(lǐng)先的聊天 大模型基準(zhǔn)測試 MT Bench 進(jìn)行比較。

結(jié)果顯示,Arena Hard v0.1 相對于 MT Bench 提供了明顯更強(qiáng)的可分離性,且置信區(qū)間更窄。它還與 Chatbot Arena(僅限英文)的人類偏好排名具有更高的一致性(89.1%)。

Arena-hard-v0.1與廣泛采用的大模型基準(zhǔn)相比顯示出最高的可分離性 (87.4%),并且也便宜且運(yùn)行速度快(25 美元)。

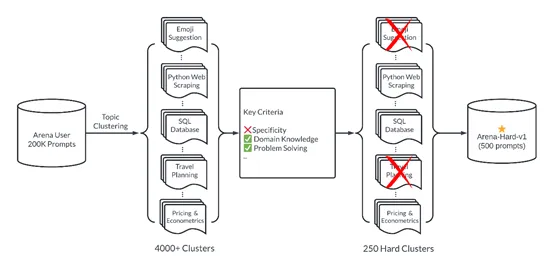

Arena-hard-v0.1構(gòu)建了一個(gè)管道,可以從通過 Chatbot Arena 收集的 200,000 個(gè)用戶查詢的數(shù)據(jù)集中自動(dòng)提取高質(zhì)量提示。這包括多樣性,提示集應(yīng)涵蓋廣泛的現(xiàn)實(shí)世界主題;提示質(zhì)量,每個(gè)提示都應(yīng)具有高質(zhì)量來衡量大模型的水平。

為了確保提示多樣性,Lmsys在BERTopic中采用主題建模管道,首先使用 OpenAI 的嵌入 (text-embedding-3-small) 轉(zhuǎn)換每個(gè)提示,使用 UMAP 降維,并使用基于層次的聚類算法 (HDBSCAN) 來識別聚類然后使用 GPT-4-turbo 進(jìn)行總結(jié)。這有助于Lmsys識別涵蓋廣泛領(lǐng)域的 4000 多個(gè)主題。

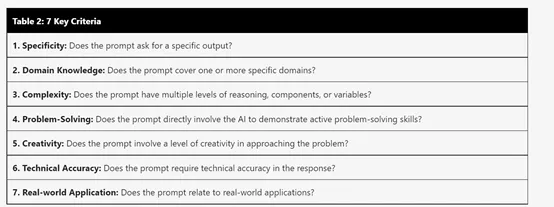

但主題集群在大模型基準(zhǔn)測試中具有不同的質(zhì)量和可分離性。Lmsys為大模型開發(fā)了一個(gè)經(jīng)過校準(zhǔn)的系統(tǒng)提示,幫助其根據(jù)七個(gè)關(guān)鍵標(biāo)準(zhǔn)例如,特異性、領(lǐng)域知識、問題解決能力等選擇高質(zhì)量的用戶查詢。

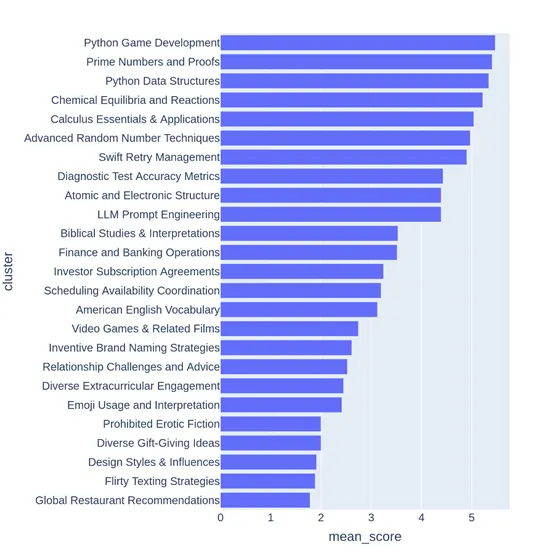

大模型Judge(GPT-3.5-Turbo、GPT-4-Turbo)對每個(gè)提示進(jìn)行注釋,從 0 到 7,以指示滿足多少個(gè)標(biāo)準(zhǔn)。然后,Lmsys根據(jù)提示的平均得分對每個(gè)簇進(jìn)行評分。

下面,Lmsys展示了從低到高平均分?jǐn)?shù)的主題集群示例。例如,游戲開發(fā)或數(shù)學(xué)證明。另一方面,得分較低的集群指向瑣碎或模糊的問題,例如“設(shè)計(jì)風(fēng)格和影響”。

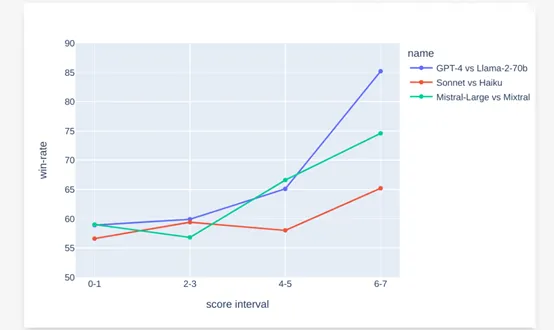

為了了解提示分?jǐn)?shù)是否與可分離性相關(guān),Lmsys對每個(gè)分?jǐn)?shù)采樣 50 個(gè)提示,并比較 GPT-4 和 Llama-70b 的響應(yīng),并以 GPT-4-Turbo 作為判斷。

Lmsys表示高潛在得分與 GPT-4 對 Llama-70b 的勝率之間存在很強(qiáng)的相關(guān)性。在其他模型對中也觀察到類似的趨勢,例如Claude Sonnet 與 Haiku 以及Mistral-large 與 Mixtral。

本文轉(zhuǎn)自 AIGC開放社區(qū) ,作者:AIGC開放社區(qū)