CVPR`25 | SOTA!首揭PCA解決長視頻低質問題!FreePCA讓長視頻絲滑如電影!(中科大)

文章鏈接:??https://arxiv.org/pdf/2505.01172??

Git鏈接:https://github.com/JosephTiTan/FreePCA

亮點直擊

- 首次揭示了PCA能夠有效將視頻特征解耦為一致的外觀和運動強度特征,從而解決長視頻生成中的不一致性和低質量問題。

- 提出了一種技術,從整個視頻序列的全局特征中提取主成分空間中的一致性特征,并逐步將其整合到通過滑動窗口獲得的局部特征中,從而在保證視頻質量的同時確保一致性。

- 大量實驗表明,本文的方法優于現有方法,達到了SOTA性能。此外,該方法無需額外訓練即可應用于多種基礎視頻擴散模型。

總結速覽

解決的問題

- 長視頻生成的分布偏移問題:

a.使用基于短視頻訓練的模型生成長視頻時,由于幀數變化導致數據分布偏移,出現質量下降、物體缺失和運動緩慢等問題。

- 全局與局部信息難以有效融合:

a.現有方法(如全局對齊或局部滑動窗口拼接)無法兼顧全局一致性和局部質量,導致視頻出現運動不一致或視覺質量下降。

- 外觀與運動耦合的挑戰:

a.視頻中的外觀和運動高度耦合,直接融合全局和局部特征會導致生成結果不協調。

提出的方案

FreePCA框架:一種基于主成分分析(PCA)的無訓練長視頻生成范式,通過解耦外觀一致性和運動強度特征,實現全局一致性與局部質量的互補融合。

應用的技術

- 主成分分析(PCA):

a.在時序維度對視頻特征進行解耦,分離外觀一致性和運動強度。

- 余弦相似度度量:

b.用于量化全局與局部特征的相似性,劃分主成分空間中的一致性特征。

- 漸進式特征融合:

c.動態調整全局與局部特征的融合權重,確保生成質量與平滑過渡。

達到的效果

- 高質量長視頻生成:

a.在無需額外訓練的情況下,顯著提升生成視頻的視覺質量和運動流暢性。

- 強一致性保持:

b.通過全局外觀特征的補充和噪聲均值復用,有效解決跨窗口不一致問題。

- 廣泛適用性:

c.可適配多種視頻擴散模型(如Stable Video Diffusion),支持多提示詞生成和連續視頻生成。

- 實驗驗證:

d.在多個基準模型上驗證了方法的有效性,生成結果在一致性和細節豐富性上優于現有方法(如局部拼接或純全局對齊)。

觀察與分析

本節首先介紹使用PCA的動機,并證明對視頻應用PCA后,主成分空間中的某些成分保留了一致的外觀。還通過統計發現,不同長視頻生成方法中一致性信息的占比存在差異。此外,展示了如何從擴散模型的視頻特征中提取一致性特征,并闡明與先前方法的區別。

使用PCA的動機

受PCA在視頻分割中信息整合能力的啟發,發現PCA可以衡量時序維度上幀間的線性相關性,并將視頻特征解耦為一致外觀和運動多樣性。對視頻時序維度應用PCA后,本文將主成分空間中各成分的信息分離,并單獨映射回原始空間。盡管每個成分存在顯著信息損失,但某些成分仍保留一致的外觀屬性。

為量化這種一致性,對每幀應用Canny邊緣檢測并疊加所有幀。若邊緣集中于特定區域且呈現清晰外觀,則一致性較好;反之,若邊緣分散則一致性較差。本文進一步使用PSNR衡量PCA后視頻外觀與原視頻的差異,設定35 dB為閾值。如下圖2所示,部分PCA成分呈現一致外觀,而其他成分則雜亂不一致。

統計分析與生成方法關聯

為從統計角度分析一致性成分的分布及其與生成方法的關系,本文對100組提示詞生成的視頻(全局方法使用長幀,局部方法使用短幀)應用PCA,并根據是否含一致性成分分為高一致性和低一致性兩組。結果表明,局部方法生成的低一致性視頻數量顯著多于全局方法。這一差異說明,主成分空間可量化全局與局部方法的一致性程度,從而激勵本文利用PCA解決局部方法的不一致性問題,同時保留原始質量。

時序注意力與特征解耦

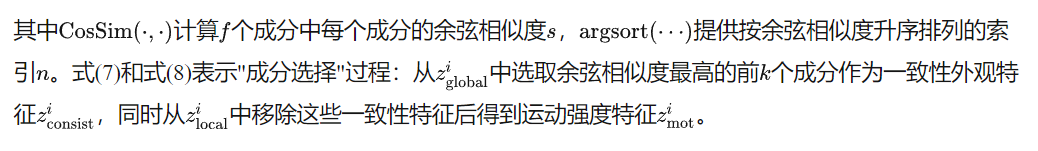

由于時序注意力在長視頻生成中的關鍵作用,同時在時序注意力中應用全局和局部方法,并在主成分空間提取其特征。通過比較各成分的余弦相似度發現:高相似度成分呈現一致外觀屬性,而低相似度成分反映運動強度屬性。如下圖3所示,逐幀差分結果顯示,局部特征(b)的變化強度大于全局特征(a),后者因更強的一致性而更穩定。但兩者均因外觀與運動耦合而難以清晰分離。

通過余弦相似度篩選后,高相似度成分(c/d)展現出明確的結構化外觀,且全局特征(c)更平滑穩定,可彌補局部特征(d)的混沌性;低相似度成分(e/f)雖無清晰外觀,但局部特征(f)保留了更豐富的運動信息。因此,將高一致性全局特征(c)與高運動強度局部特征(f)互補融合,可同時解決長視頻生成的質量與一致性問題。

與先前方法的區別

盡管表面類似[31][28],但本文的方法存在本質差異:

- 更強的解耦能力:利用PCA將視頻特征明確解耦為一致外觀和運動多樣性,并在特征層賦予清晰的物理意義。

- 全局-局部優勢融合:首次提出如何整合全局一致性與局部多樣性以優化生成結果,而此前方法未有效解決該問題。

方法

基于上述分析,本文提出FreePCA——一種基于PCA的免訓練長視頻生成方法,利用預訓練擴散模型提升一致性與質量。如下圖4所示,預訓練模型采用U-net結構,包含卷積層、空間transformer和時序transformer,并在短視頻數據上訓練。FreePCA聚焦于時序transformer,包含兩個核心步驟:一致性特征分解與漸進式融合。此外,本文復用初始噪聲的均值統計量以增強一致性。

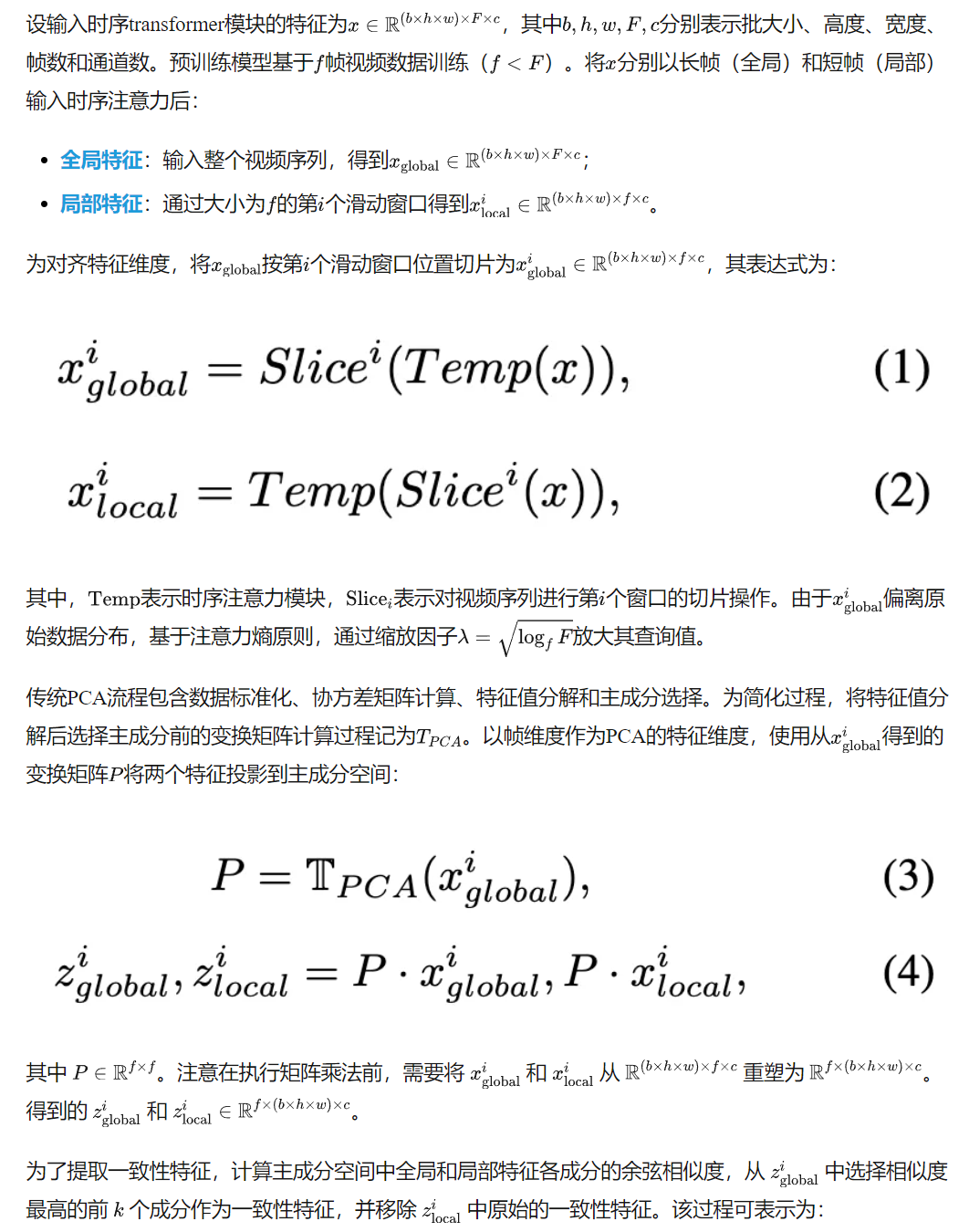

一致性特征分解

漸進式融合

最新研究表明擴散模型首先生成場景布局和物體形狀,后續步驟才細化細節。因此在DDIM的50步去噪過程中:

- 前25步使用完整FreePCA方法

- 后25步采用局部方法

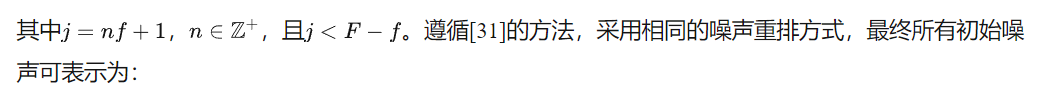

均值統計量復用

先前方法采用噪聲重調度技術來確保視頻一致性。然而,這種方法對輸入施加了嚴格限制,阻礙了生成更豐富場景的可能性。早期工作指出,從視頻序列的時間維度提取的均值能夠反映外觀信息。受此啟發,本文提取前f幀的噪聲均值,并用其替換后續F-f幀的噪聲均值。本文發現,這種方法不僅能保持視頻的外觀一致性,還能增強視頻生成的靈活性,其表達式為

其中sh(·)表示對幀序列順序進行重排。

實驗

實現細節

實驗設置。為驗證本方法的有效性和泛化能力,將FreePCA應用于公開的基于擴散模型的文本生成視頻系統VideoCrafter2和LaVie,這些模型均在16幀視頻數據上訓練。本文的目標是使這些模型能夠生成長視頻(即64幀),同時盡可能保持原始視頻生成質量。本方法無需訓練,可直接在推理階段使用。

測試提示詞。使用Vbench中的326條提示詞來測試本方法效果。

評估指標。采用Vbench提供的指標進行評估,主要測試兩個維度:視頻一致性和視頻質量。視頻一致性包含三項指標:1)主體一致性:通過計算幀間DINO特征的相似度評估物體是否保持穩定;2)背景一致性:通過計算幀間CLIP特征相似度衡量背景場景的穩定性;3)整體一致性:使用ViCLIP特征計算幀間相似度評估語義和風格一致性。視頻質量從運動和外觀兩個角度測試:1)運動平滑度:使用AMT視頻插值模型評估運動流暢性;2)動態程度:通過RAFT計算連續幀間光流強度判斷視頻是否靜態;3)成像質量:使用基于SPAQ數據集訓練的MUSIQ圖像質量評估器。

基線方法。將FreePCA與以下無需訓練的長視頻生成方法對比:1)直接采樣:直接使用短視頻模型生成64幀視頻;2)FreeNoise:通過噪聲重調度保持幀間一致性;3)FreeLong:將低頻全局特征與高頻局部注意力圖融合以提升視頻質量。

基線對比

下表1展示了定量實驗結果。直接生成長視頻存在領域泛化問題,導致外觀和運動質量下降(盡管一致性尚可),其語義準確性也導致整體一致性最差。FreeNoise因滑動窗口機制未出現質量指標顯著下降,但一致性表現惡化。FreeLong受限于簡單的頻域融合方式難以進一步提升質量。相比之下,FreePCA不僅獲得最優視頻質量,還通過PCA和漸進式融合保持了最佳一致性。在NVIDIA RTX 4090上的測試顯示,本方法以可接受的推理時間增長實現了更優生成效果(DiT框架結果見補充材料)。

下圖6-7的定性對比表明:直接生成長視頻會出現物體缺失、運動遲緩和細節丟失;FreeNoise存在明顯外觀不一致;FreeLong雖略微改善一致性但仍存在語義丟失。而FreePCA在保持卓越一致性的同時,確保了外觀與運動的高質量。

消融實驗

本文針對以下變量進行消融研究:

其他應用中的一致性增強

本文的方法還可應用于:

- 多提示詞視頻生成(下圖8):為不同視頻段落提供差異提示詞時,FreePCA能保持外觀連貫性

- 視頻延續生成(下圖9):通過DDIM反演初始視頻后應用FreePCA,可在保留原內容基礎上擴展更豐富的長視頻

這些實驗充分證明了本方法在多場景下的泛化能力和實用價值,成為維護視頻一致性的有效范式。

結論

FreePCA,一種無需訓練的創新方法,用于從短視頻擴散模型生成高質量且保持連貫性的長視頻。該方法利用主成分分析(PCA)強大的特征解耦能力,從視頻特征中提取一致性特征,并提出"一致性特征分解"技術——在PCA處理后應用余弦相似度來識別一致性特征。本文還設計了"漸進融合"策略,通過滑動窗口逐步增加一致性特征的占比,在保證視頻質量的同時確保連貫性。此外,引入"均值統計復用"機制進一步強化一致性。實驗表明,FreePCA顯著優于現有模型,實現了高保真度與連貫性,并為其他應用領域的連貫性增強建立了一種無需訓練的范式。

本文轉自AI生成未來 ,作者:AI生成未來