神經網絡調試手冊:從數據集與神經網絡說起

近日,hackernoon 上出現了一篇題為《How to debug neural networks. Manual.》的文章,從數據集與神經網絡兩個方面分享了作者 Andrey Nikishaev 在調試神經網絡方面的實踐心得。

調試神經網絡是一項艱難的工作,專家也不例外。面對數百萬的參數,任何一個小變動都可能使你前功盡棄。沒有調試和可視化,所有你的行動就像拋硬幣,而且更糟糕的是還浪費時間。下面是我搜集的實踐匯總,希望有助于你提早發現問題。

一、數據集問題

1. 嘗試使用小數據集過擬合你的模型

一般來說神經網絡應該在數百次迭代中過擬合你的數據。如果你的損失值不下降,那問題存在于更深層次。

2. 使用迭代邏輯解決問題

嘗試構建最簡單的網絡解決你的主要問題,接著一步一步擴展到全局問題。比如,你正在創建風格遷移網絡,首先在一張圖像上訓練你的腳本遷移風格。如果奏效,再接著創建用于任何圖像的風格遷移模型。

3. 使用具有扭曲的平衡數據集

比如訓練分類數據的網絡,你的訓練數據應該對每一分類具有相同數量的輸入。其他情況下則存在分類過擬合的可能性。神經網絡對于所有的扭曲并非恒定不變,因此需要你對它們進行專門訓練。制造輸入扭曲將會提升網絡準確度。

4. 網絡容量 vs 數據集大小

你的數據集應足夠大,以便網絡用來學習。如果你的數據集小,而網絡很大,那么它會停止學習(某些情況下也會為大量的不同輸入輸出相同結果)。如果你有大數據,而網絡很小,那么你將會看到損失值的跳躍,因為網絡容量無法存儲如此多的信息。

5. 使用均值中心化(mean centering)

這將會從你的網絡中移除噪音數據,提升訓練性能,同時某些情況下有助于解決 NaN 問題。但是記住,如果你有時序數據,那么你應該使用批而不是全局中心化。

二、神經網絡問題

1. 首先嘗試較簡單的模型

我在很多案例中看到人們首先嘗試一些標準的大型網絡,比如 ResNet-50、VGG19 等,但是接著發現他們的問題通過僅有若干層的網絡也能解決。因此如果你沒有標準問題,首先從小網絡開始吧。你添加的數據越多,模型就越難訓練,因此從小網絡開始會更省時。你也應該記住,大網絡需要更大的內存與更多的操作。

2. 可視化是必須的

如果你正使用 TensorFlow,一定要從 TensorBoard 開始。如果沒有,嘗試為你的框架尋找一些可視化工具,或者自己動手編寫。這將對于你發現訓練早期階段的問題非常有幫助。你必須可視化的事情有:損失值、權重直方圖、變量和梯度。如果你正在做計算機視覺,那要一直可視化過濾器從而理解網絡實際上看到了什么。

3. 權重初始化

如果你錯誤設置權重,由于零梯度,或者所有神經元的類似更新等,你的網絡將變得無法訓練。同樣你也應該記住權重與學習率是成對的,因此高學習率和大權重可以導致 NaN 問題。

對于一些網絡使用 1e-2–1e-3 左右的高斯分布初始化軟件已經足夠。

對于深度網絡這毫無用處,因為你的權重彼此相乘了很多次,將會產生幾乎消除反向傳播上的梯度的非常小的數值。多虧了 Ioffe 和 Szegedy,現在我們有了批歸一化,緩解了令人頭疼的大量問題。

4. 使用標準網絡解決標準問題

存在大量的預訓練模型,你可以正確使用它們。在一些情況中是這樣,或者你可以使用調整技術節約訓練時間。主要的想法是絕大多數網絡容量對于不同問題是相同的。比如,如果我們討論計算機視覺,它將會包含對于所有圖像一樣的線、點、角,并且你不需要再訓練它們。

5. 把衰減用于學習率

這幾乎每次都會給你一個提升。TensorFlow 中有大量的不同衰減調度器

(https://www.tensorflow.org/versions/r0.12/api_docs/python/train/decaying_the_learning_rate)。

6. 使用網格搜索、隨機搜索或配置文件調整超參數

不要試圖手動調整所有參數,這很耗時,效率低下。我經常使用全局配置調整所有參數,并在運行完檢查結果后看看在哪個方向上應該進一步調查。如果這個方法沒有幫助,你可以試一下隨機搜索或網格搜索。

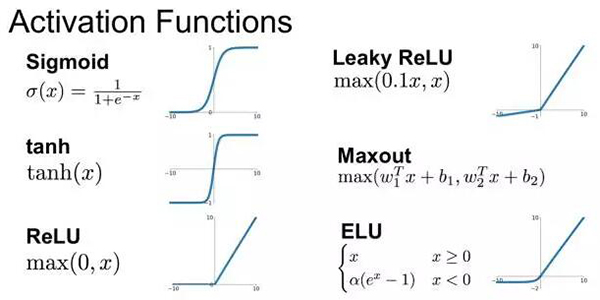

7. 激活函數

(1) 梯度消失問題

一些激活函數,比如 Sigmoid 和 Tanh 正在遭受飽和問題。在其極限時,它們的導數接近于零,這將會消除梯度和學習過程。因此檢查不同的函數比較好。現在標準的激活函數是 ReLU。同樣這一問題也出現在一個非常深度或者循環的網絡中,比如你有 150 層,所有的激活值是 0.9,那么 0.9¹⁵⁰ = 0,000000137。但是正如上文所說,批歸一化將有助于解決這一問題,殘差層也是。

(2) 不是零均值的激活值

比如 Sigmoid、ReLU 函數就不是零均值的。這意味著訓練期間所有你的梯度將全部是正或負,并會引發學習問題。這就是為什么我們使用零均值的輸入數據。

(3) Dead ReLUs

標準的 ReLU 函數也不完美。對于負數 ReLU 給出零的問題意味著它們將不會被激活,因此你的神經元的某些部分將會死掉并永不再用。這之所以能發生是因為高學習率和錯誤的權重初始化。如果參數調整沒有幫助,那么你可以試一下 Leaky ReLU、PReLU、ELU 或 Maxout,它們沒有這一問題。

(4) 梯度爆炸

這一問題與梯度消失相同,除卻每一步梯度變的越來越大。一個主要的解決辦法是使用梯度剪裁,為梯度設置基本的硬限制。

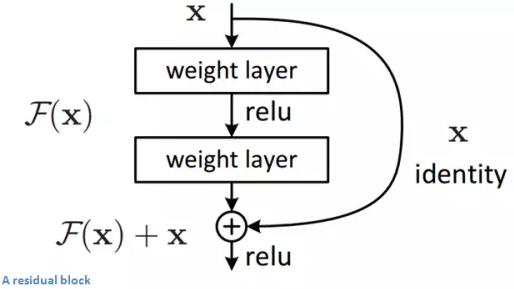

8. 深度網絡的精確度降級

從一些點上真正深化網絡的問題開始表現為一個壞手機,因此增加更多層降低了網絡精確度。解決辦法是使用殘差層把輸入的一些部分傳遞到所有層。

原文:https://hackernoon.com/how-to-debug-neural-networks-manual-dc2a200f10f2

【本文是51CTO專欄機構“機器之心”的原創譯文,微信公眾號“機器之心( id: almosthuman2014)”】