CV技術加強車輛監管助力疫情防控

然而,傳統的人工監管方式存在如下問題:

- 人工監管無法實時記錄出入車輛的綜合信息,并將信息格式化輸出,例如車牌、出入狀態、車輛顏色、車輛類別等;

- 人工監管無法實時抓拍車輛圖片,作為備份存儲,更加客觀地呈現車輛外觀;

- 人工監管可能存在由于門衛疲勞導致疏漏或者記錄錯誤;

- 人工監管無法24小時全天監控車輛,不方便門衛進行其他工作。

傳統的人工監管方式弊端日益突出,需要采用新方式對車輛進行監管。智慧家庭運營中心自研場景化AI智能分析能力,建設面向社區和鄉村的“車輛車牌多能力攝像頭”。主要針對社區門口和道路場景,對經過的車輛進行結構化信息提取,并將車輛圖片抓拍上報給平臺,提示工作人員做出相應處理回應。實現“預防為主、防微杜漸、全程監管、社會共治”的創新性監管模式。

Part 01、 車輛車牌檢測

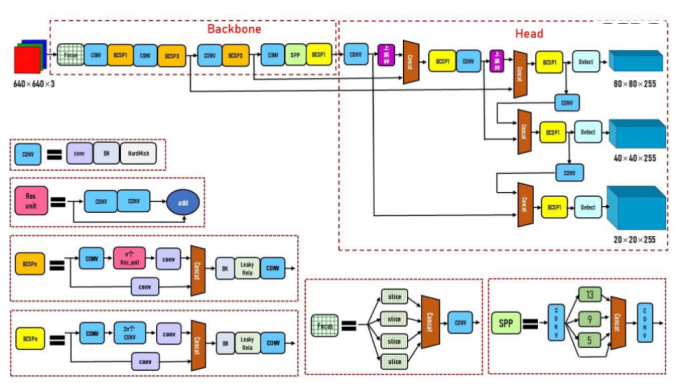

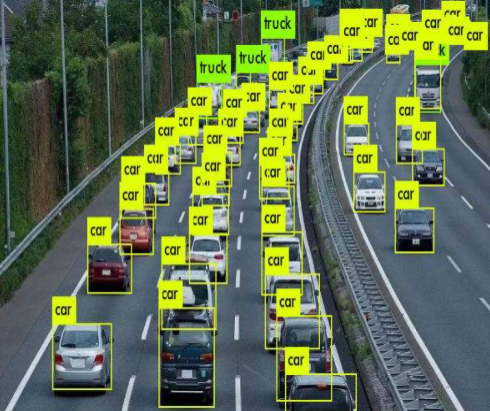

目標檢測是比圖像分類更進一步的AI技術,目標檢測除了需要識別分類圖片中的目標類別,還需要將目標用邊界框標出。于是目標檢測任務流程可以分為兩個類別,包括One-stage和Two-stage方法。最初的目標檢測任務都是Two-stage算法,該算法主要分為兩個步驟,包括檢測框的確定和目標分類。首先通過特定的網絡結構生成目標的檢測框,確定目標邊界,然后對邊界框中的內容進行圖像分類,確定其屬于何種類別。Two-stage算法中最著名的算法是Faster R-CNN,它的檢測精度高,然而算法運行速度慢,不適用于攝像頭端側處理。相比之下,One-stage算法直接通過網絡同時確定目標的邊界框和類別。其中,YOLO系列是應用最廣泛也是端側最成熟的One-stage目標檢測算法,經過5個版本的迭代,YOLOv5同時保證了運行速度和算法精度,于是在端側我們使用YOLOv5作為車輛車牌檢測算法,圖1(a)是YOLOv5主要算法框架[1]。為了進一步提高檢測速度,我們使用模型剪枝和量化方法輕量化算法框架。圖1(b)是道路場景檢測示意圖。

圖1(a) YOLOv5主要算法框架

圖1(b) 道路場景檢測示意圖

Part 02、 車牌字符識別

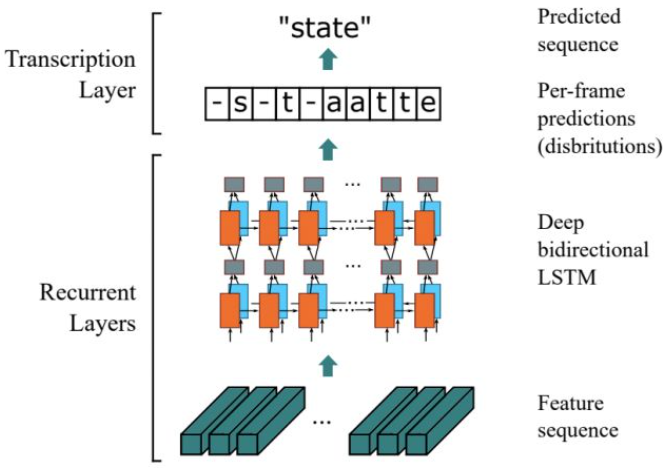

在車牌字符識別步驟中使用了文字識別技術。我們基于車牌檢測的結果,識別車牌區域上的文字內容。在文字識別算法中,通常使用基于CTC的字符識別算法,其中典型的算法模型是CRNN[2],圖2是CRNN算法結構圖,CRNN網絡主要分為CNN和RNN網絡。首先使用CNN網絡如VGG、ResNet、MobileNet等主干網絡提取文字區域的深度特征,然后使用雙向LSTM結構處理深度特征獲得輸入圖片的上下文信息的序列特征,最終將序列特征輸入到CTC損失函數,解碼序列結果。

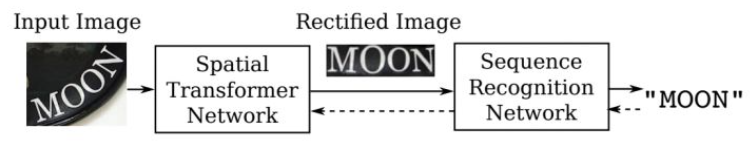

在實際應用中,由于攝像頭抓拍角度問題,車牌圖片往往存在一定的形變,不規則的文本不利于識別。為了提高該場景下的識別精度,我們在車牌檢測之后,文本識別之前加入文本矯正模塊,將不規則文本矯正為規則文本。利用空間變換網絡STN[3],通過空間變換矯正不規則的文字圖片,使其成為水平方向的規整圖片,再將其送入到CRNN算法獲得車牌字符識別的結果。

(a)

(b)

圖2 CRNN算法結構以及矯正網絡結構

Part 03、 車輛屬性識別

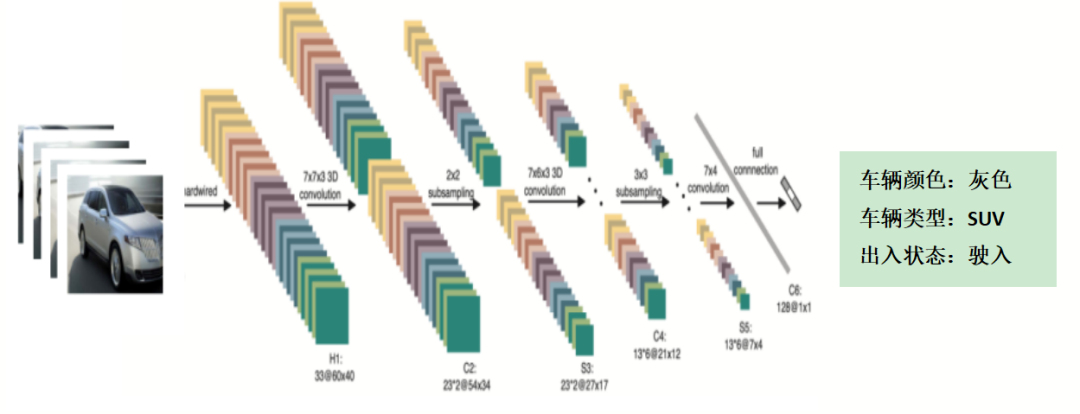

車輛屬性主要包括車輛類型和顏色信息。在實際的抓拍過程中,抓拍到的往往是車輛局部信息,如圖3所示,視角的局限性和環境的影響,會降低車輛屬性識別的準確率。為了盡量多且連續地抓拍車輛的綜合信息,我們采用3D卷積分類,提取整個時間序列上的車輛信息,對于某段時間在不同視角的車輛進行屬性識別。

圖3 抓拍的單幀圖片視角局限?

二維卷積是對單幀圖片進行卷積操作,二維卷積的輸入是H*W的二維矩陣。而三維卷積[4]是對多幀圖片進行卷積操作,三維卷積的輸入是H*W*C的三維矩陣,相比之下多了深度C。三維卷積在圖片的三個方向分別滑動,每個位置都會通過卷積運算輸出一個數值。相比于二維卷積,三維卷積可以將時序上的多幀圖片同時卷積,獲得圖片的時序特征。圖4是三維卷積分析車輛屬性示意圖。

圖4 采用3D卷積獲得車輛屬性識別結果

Part 04、 結束語

智慧家庭運營中心的“車輛車牌多能力攝像頭”利用CV技術解決出入口傳統車輛監控方式存在的諸多問題,圍繞社區、鄉村車輛的監管需求,實現“預防為主、防微杜漸、全程監管、社會共治”的創新監管模式。

目前已經落地甘肅31個小區,并以此為錨點,拓展場景化業務,助力安防業務升級轉型,落實智能防疫和數字鄉村建設。

??參考文獻

[1] https://zhuanlan.zhihu.com/p/172121380

[2] Baoguang Shi, Xiang Bai, and Cong Yao. An end-to-end trainable neural network for image-based sequence recognition and its application to scene text recognition. In TPAMI, volume 39, pages 2298–2304.

[3] Max Jaderberg, Karen Simonyan, Andrew Zisserman, et al. Spatial transformer networks. In NIPS, pages 2017–2025.

[4] Ji S, Xu W, Yang M, et al. 3D convolutional neural networks for human action recognition[J]. IEEE transactions on pattern analysis and machine intelligence, 2013, 35(1): 221-231.