首個GPT-4驅動的人形機器人!無需編程+零樣本學習,還可根據口頭反饋調整行為

讓GPT-4操縱人形機器人,事先不做任何編程or訓練,能搞成啥樣兒?

答案是:太 獵 奇 了!

這不,要求機器人表演“在昏暗電影院里狂炫爆米花,卻突然發現吃的是隔壁陌生人的??”。

在GPT-4的操縱下,機器人笑容凝固,“尷尬”得搖頭扶額后仰:

但在尷尬之余,竟然還不忘再抓一把塞嘴里???

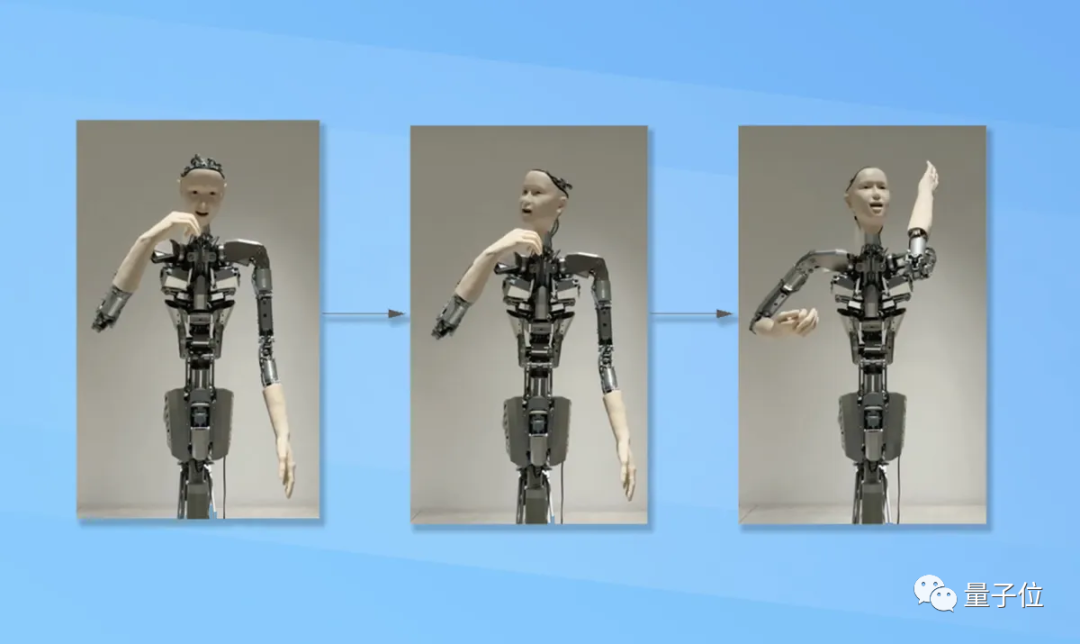

又像是要求機器人“彈吉他”。

GPT-4略思考一番,開始操控機器人活動一番手指、隨后瘋狂甩頭,好像是有點搖滾內味兒。

但仔細一看,甩頭的時候,手指就完全不動了……

你要說這是神叨叨的地攤先生在掐指一算,好像也沒什么不對(手動狗頭)。

總結一系列動作來看——

相比波士頓動力人形機器人,一舉一動均由人為程序精細操縱,這個GPT-4直接操控的機器人,表情猙獰,動作詭異,但一切行為又符合prompt的要求。

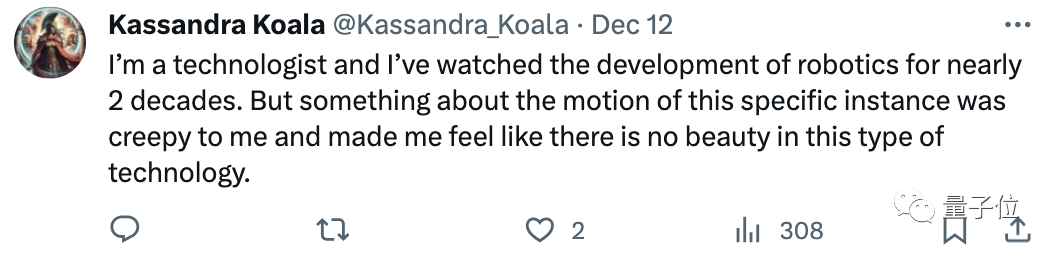

這一連串GPT-4操控機器人的視頻po到網上后,不少網友直呼“恐怖谷效應犯了”:

甚至嚇到了20年工齡的機器人技術專家:

這些動作讓我毛骨悚然。你自己看看這有美感嗎?

還有網友調侃:“看起來就像舞臺上的我一樣。”

但也有網友認為,人形機器人能通過GPT-4來操縱,已經是很不可思議的事情了。

原來,這是首個由GPT-4驅動人形機器人的研究,來自東京大學和日本Alternative Machine公司。

依靠這項研究,用戶無需事先給機器人編程,只需語言輸入、也就是動動嘴皮和GPT-4聊上一會兒,就能讓機器人根據指令完成行動。

一起來看看這項研究的更多細節和背后原理。

大模型+機器人的新嘗試

不編程,也不訓練,拿GPT-4當腦子,這個人形機器人Alter3,還能做出哪些令人皺眉卻又合理的動作?

不如給個指令,讓Alter3假裝自己是個??吧!

它倒是也懂一秒入戲,張大嘴巴、雙手前伸。

但不知道為什么,微張的雙唇和空洞的眼神,讓人感覺它更像林正英都要直呼內行的僵尸:

如果要求它自拍,Alter3倒也當場能來個懟臉大頭照。

就是不知道是被原相機里的自己丑到,他的表情并不享受,反而痛苦似的將自己眼睛閉了起來:

再來聽個搖滾,music走起。

你說它頻頻點頭是在追隨節拍,一定沒錯;但你要說它是畢恭畢敬站在面前,說“啊對對對對對”,似乎也貼切極了(手動狗頭):

在所有放出的視頻demo中,“喝茶”這個行為最不奇葩怪異,甚至像是在演我:

上班上到生無可戀的時候,喝茶就是這么要死不活的。要咱說,送到嘴邊了才張口,這茶不喝也罷。

作為人形機器人,Alter3做出人類行為有點子搞笑,那……不如試試別的?

比如,演繹一條受到音樂感召后搖擺身姿的蛇:

看到了嗎,沒那么柔韌,但確實在盡它所能扭動軀干了,可以說是一條蛇的發癲版本.gif。

這么看下來,直接把人形機器人和GPT-4集成這件事,可以干,但美觀性屬實不太夠啊……

其實回顧一下,讓大模型和機器人結合這事兒,科學家研究者們今年已經忙活了一整年。

不過,通常做法是做更多的訓練,然后嘗試將圖像語言大模型的能力和知識遷移到機器人領域。

包括微軟的ChatGPT for Robotics,谷歌的PaLm-E、RT-1、RT-2,還有VoxPoser、BoboCat等眾多工作,都走的是這個路線。

其中,轟動一時的谷歌RT(Robot Transformer)系列效果賊棒,但谷歌訓練它就花了17個月,并收集13臺機器人的13萬條機器人專屬數據——一般團隊很難有這個資金和精力。

年中,李飛飛團隊的具身智能成果,則百尺竿頭更進一步,通過將LLM(大語言模型)+VLM(視覺語言模型)結合在一起,機器人與環境進行交互的能力進一步提升。

這種思路下,機器人完成任務無需額外數據和訓練。

但是李飛飛團隊給出demo里的硬件,本體還只是一個機械臂,今天我們介紹的研究中,實驗對象則是大模型界最強的GPT-4,以及作為“身體”的Alter3。

無論是OpenAI開發的GPT-4,還是東京大學和日本“機器人之父”黑石浩聯合開發的人形機器人Alter3,都是已有的研究成果。

這項研究的真正目的,是探索如何在不編程的情況下,用像GPT-4這樣的大模型控制人形機器人完成各種動作,以驗證GPT-4生成動作的能力、降低人機交互的復雜度。

依靠這一系列成果,Alter3才能完成上面看到的各種各樣復雜動作(咱們先拋開完成度和觀賞性不提)。

還有一件事,那就是研究人員在集成Alter3和GPT-4時發現,即使給Alter3下同一個指令,Alter3反饋的動作也不會每次都一樣。

經過一番分析后,他們認為,這與大語言模型本身的特點有關,即相同輸入可能對應不同的輸出,但并不代表GPT-4無法很好地控制人形機器人。

例如,要求機器人“吃飯”,它可能前后兩次就會分別做出拿筷子吃飯和拿刀叉吃飯的不同動作。

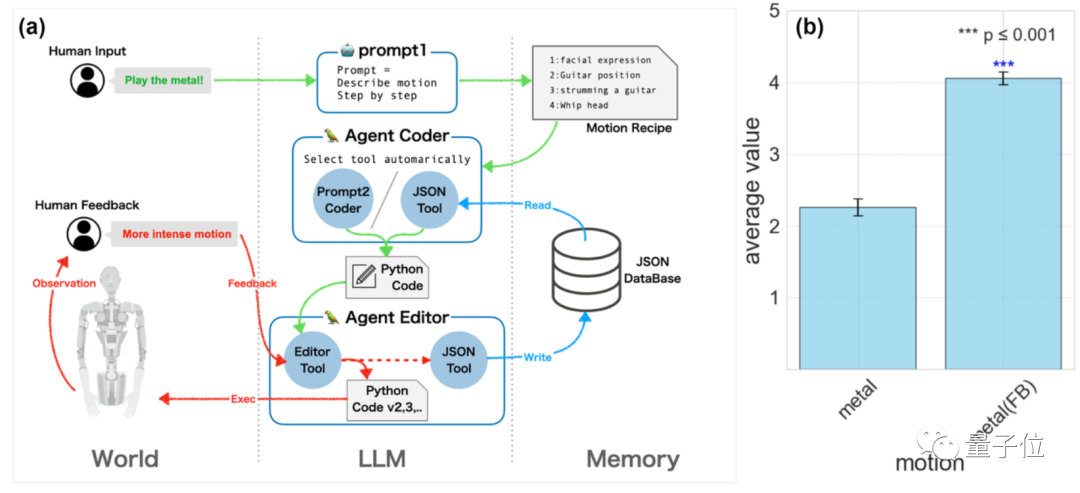

那么,話又說回來,GPT-4究竟是如何一接收到語句輸入,就知道要如何控制Alter3的呢?

關鍵靠2步提示詞

其實在接入GPT-4之前,Alter3就是帶腦子(AI神經網絡)的,身上還帶著各種傳感器。

此前,Alter3的行為主要靠其內置的一顆CPG(CentralPattern Generator,中樞模式發生器)來對傳感器傳來的數據做出分析,然后按一定順序驅動體內的43個氣動裝置,完成相應動作。

整個過程中往往需要人為介入,打點補丁,從而進行一些改進。

But!現在一切都不一樣了,研究團隊稱GPT-4的集成讓他們“解脫了”。

現在能實現用口頭指令來指揮Alter3,背后技術主要是這倆:

CoT (思維鏈),以及zero-shot (零樣本學習)。

依托這兩項技術,對Alter3的控制不再完全依賴硬件本身,而是能夠用GPT-4直接將自然語言轉換成機器人可理解并執行的動作。

最最重要的是,整個流程無需對任何一個身體部位進行明確編程。

好了,現在來具體講講把GPT-4和Alter3集成到一起,是如何實現的。

大體可以分為兩個步驟:

首先,先用prompt描述一下,想要Alter3能夠完成什么行為或者動作,比如“咱來張自拍吧”“自拍的時候胳膊再舉高一點”。

接收到輸入的GPT-4會生成一系列的思考步驟,這些步驟詳細地闡述了要完成這個動作,需要先后完成些啥。

這個過程被研究團隊稱為CoT的一部分,即將一個復雜任務分解為一串更簡單的思考步驟。

然后,研究者們再祭出另一個prompt,把分解后的詳細步驟轉化為Alter3可以聽懂的動作指令。

簡單理解就是把人們的指令描述轉化為Python代碼,這些代碼可以直接用來控制Alter3的各個身體部位的具體運動參數。

有了轉化后的代碼,Alter3想擠眉弄眼就擠眉弄眼,想撇嘴就能撇嘴。

研究團隊把這第二步也看成CoT的一部分,因為它完成的是“把一個抽象描述轉化為具體操作”。

團隊表示,CoT讓GPT-4能夠有效控制Alter3,命令它做各種復雜動作,且不用額外的訓練或者微調。

多說兩句,除了上述的兩個Prompt搞定機器人控制外,研究團隊還順手完成了一些其它研究。

比如掰開了看Alter3在對話中的行為,主要針對其對話軌跡和語義時間演化。

針對對話軌跡,研究團隊使用了一種叫UMAP(Uniform Manifold Approximation and Projection)的方法。團隊把對話內容嵌入二維空間,從而方便觀察這個簡化版的對話發展過程。

他們發現,當對話順序固定時,對話軌跡會呈現循環模式,也就是老在重復同樣的話題。

而當對話順序隨機時,對話內容更有發散性or創造性。

賊有趣的一點,研究發現GPT-4聊久了過后,會傾向于反復說“再見”。如果你不來點兒人為干預,它就會沉迷于想辦法跟你說再見。

而做語義時間演化分析的過程中,團隊觀察了隨著時間變化,聊天內容的變化。

他們發現,對話初期的一些關鍵詞,比如“藝術”或者“學習”啥的,會聊著聊著就被GPT-4忘了,取而代之的是諸如“文化”“人類”“抑制”之類的詞。

這表明對話內容是在逐漸發展變化的。

當然,如果你開始跟GPT-4說“再見”,它就幾乎一心一意只想跟你說byebye~(doge)

來自東京大學

這項火爆全網的研究,來自東京大學和日本Alternative Machine公司。

一作Takahide Yoshida,來自東京大學通用系統科學系。

另外兩位作者升森敦士(Atsushi Masumori)和池上高志(Takashi Ikegami),都是既在東京大學,又屬于Alternative Machine公司。

最后,不得不提到本次研究內容的主人公Alter3,它的幕后研究者也來自東京大學,由東京大學AI研究學者池上高志和日本“機器人之父”黑石浩聯袂打造。

Alter3出生于2020年,是同系列機器人第三代產品。

據了解,Alter系列的兩次迭代都是在歌劇演唱中完成的。第3代的初亮相就是在東京新國立劇場指揮管弦樂隊并參加其他現場表演。

那個時候它的特色是增強了傳感器,并改善了唱歌的表達能力和發聲系統。

以及身體里那粒能夠最終驅動43個氣動裝置的CPG。

CPG對數據的分析靈敏到什么程度呢?就是如果Alter3呆的房間里如果溫度驟降,Alter3會因此打個冷顫,表示自己有被冷到。

這或許也為現在接入GPT-4當腦子后的它,能夠活靈活現做表情、完成動作提供了一些基礎吧。

One More Thing

說起人形機器人的最新消息,一定要提老馬家特斯拉擎天柱Optimus的最新動態:

就在剛剛,馬斯克突然在推特發布了Optimus的視頻,表示Optimus第二代機器人(Gen 2)將在本月發布。

一點點“微小”的進步是二代Optimus步行速度提升了30%。

平衡感和身體控制能力也有所改善。

一把子期待住了!

參考鏈接:

[1]https://tnoinkwms.github.io/ALTER-LLM/。

[2]https://arxiv.org/abs/2312.06571。

[3]https://twitter.com/elonmusk/status/1734763060244386074。