給AI Agent完整的一生!港大NYU謝賽寧等最新智能體研究:虛擬即現實

怎樣能構建更強大的AI Agent?

答案是給他們一個完整而真實的世界。

最近,來自香港大學的Jihan Yang和紐約大學的謝賽寧等人,聯合發表了一項新研究:在虛擬環境中模擬現實世界。

論文地址:https://arxiv.org/abs/2402.03310

代碼地址:https://github.com/VIRL-Platform/VIRL

項目名稱V-IRL,能夠彌合數字環境與人類居住的世界之間存在的巨大差距,讓Agent在模擬的真實世界環境中執行各種復雜的任務。

V-IRL中的環境數據完全來源于真實世界:地圖、地理信息、街景......可以說,V-IRL給了Agent真實而完整的一生。

V-IRL是一個可擴展的平臺,利用地圖、地理空間和街景圖像等API將AI智能體嵌入到地球上的真實城市中。

V-IRL可以作為一個巨大的測試平臺,用于衡量開放世界計算機視覺和具身人工智能的進展,具有前所未有的規模和多樣性,提供對全球數千億張圖像的結構化訪問。

截至2022年5月,僅Google街景就擁有超過2200億張圖像,并且還有許多其他圖像和數據來源可以合并以豐富環境。

V-IRL Agent

研究人員使用V-IRL實例化了一系列智能體,他們以其豐富的感知和描述數據為基礎,解決了各種實際任務。

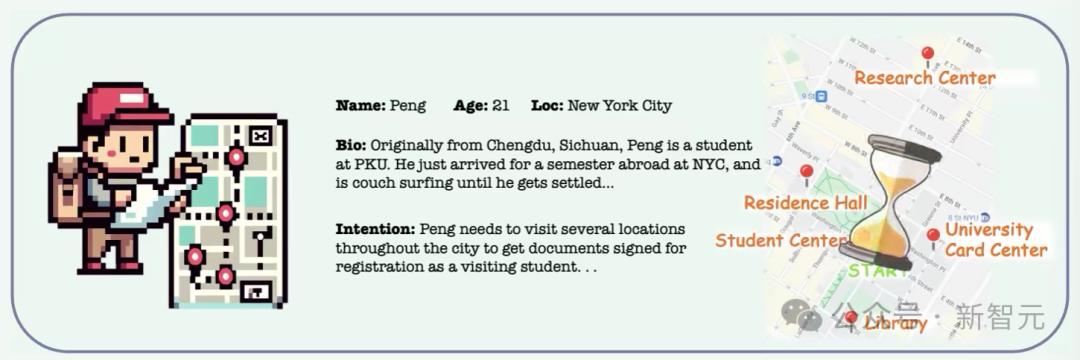

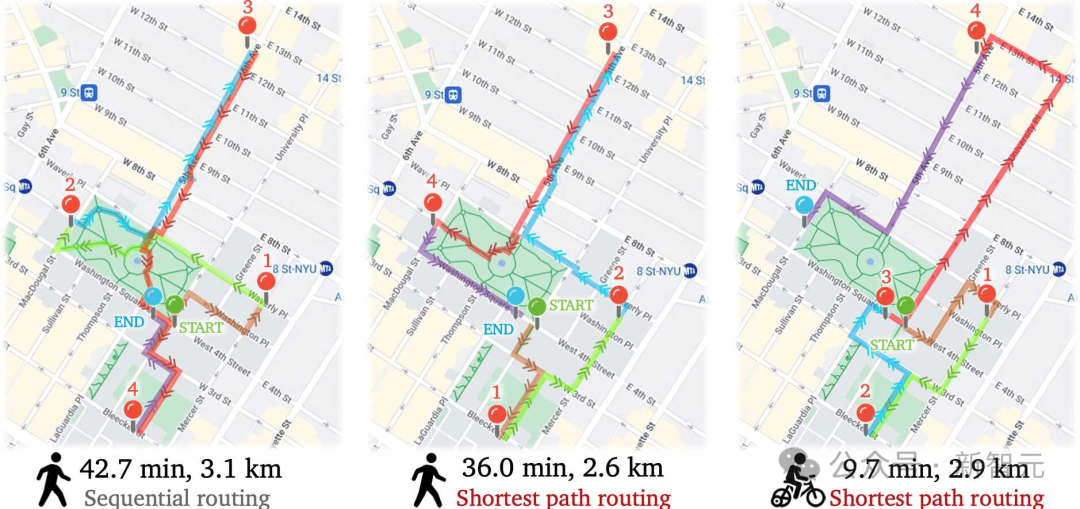

比如這個Peng,為了注冊為訪問學生,需要訪問紐約市的幾個地方來獲得一些文件。

利用地理定位和地圖功能,Peng可以沿著最短的路徑行走來節約時間:

語言驅動

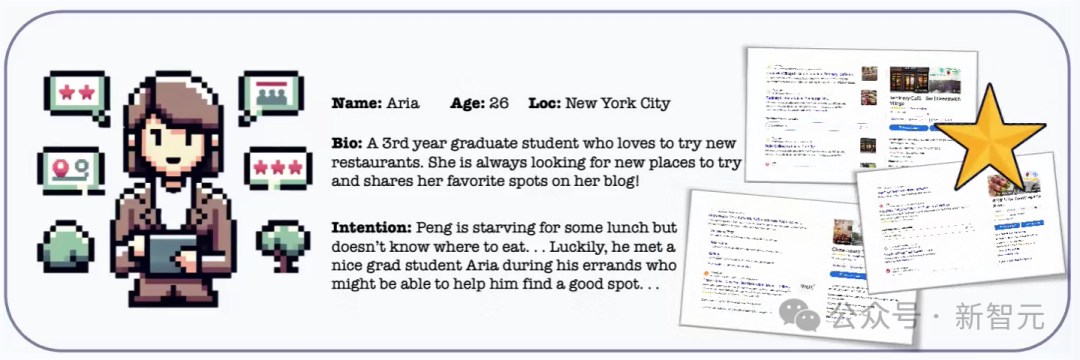

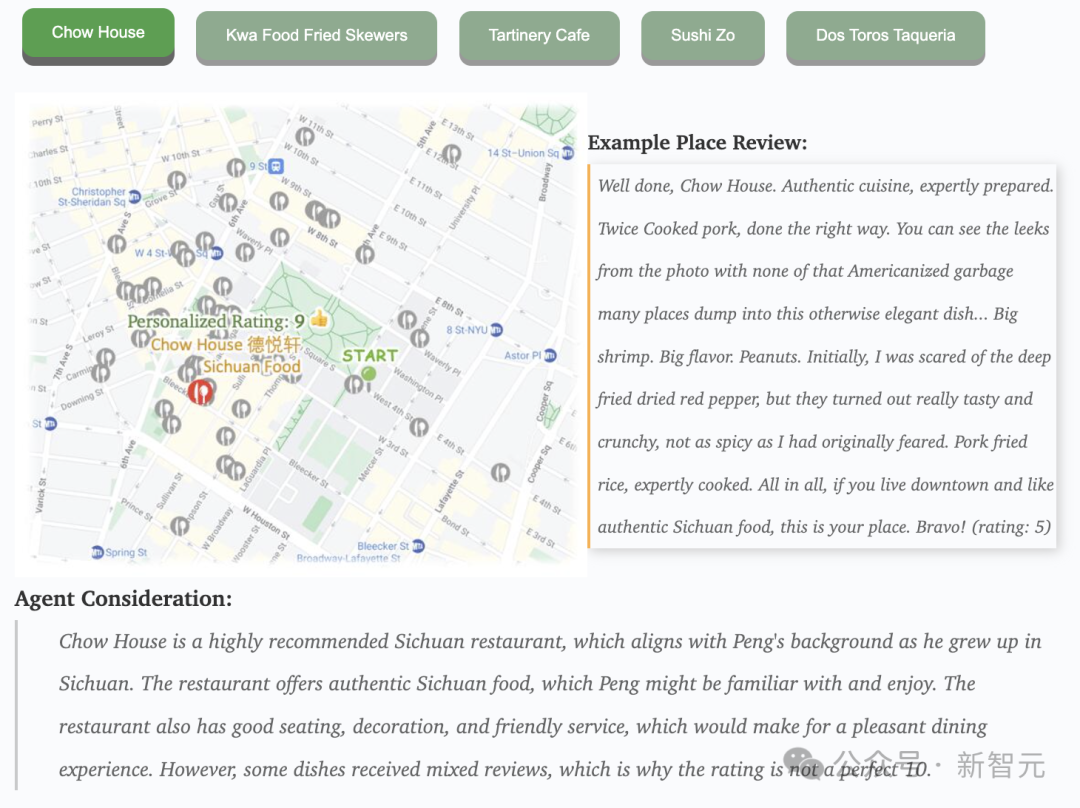

下面這位Aria,可以搜索附近的餐館。然后,她綜合公眾評論,通過GPT-4提出最終建議。

對于上面來自四川的Peng同學,Aria推薦了辛辣的中式聯合餐廳Chow House,讓他嘗到了家的味道。

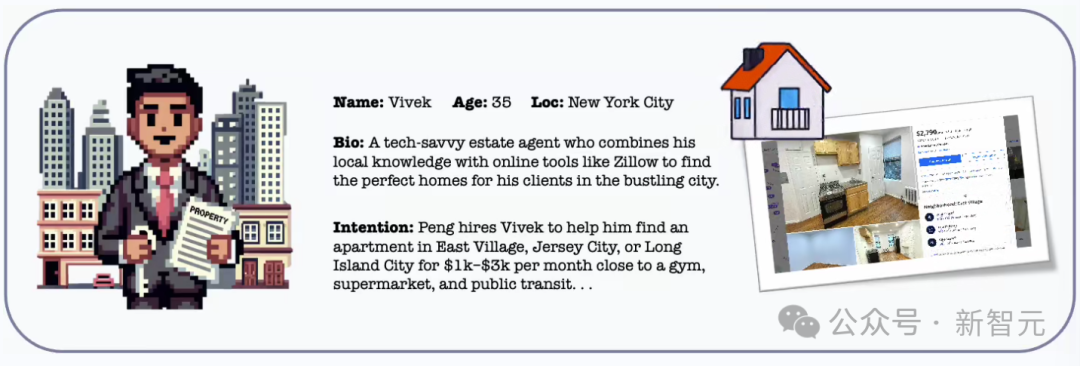

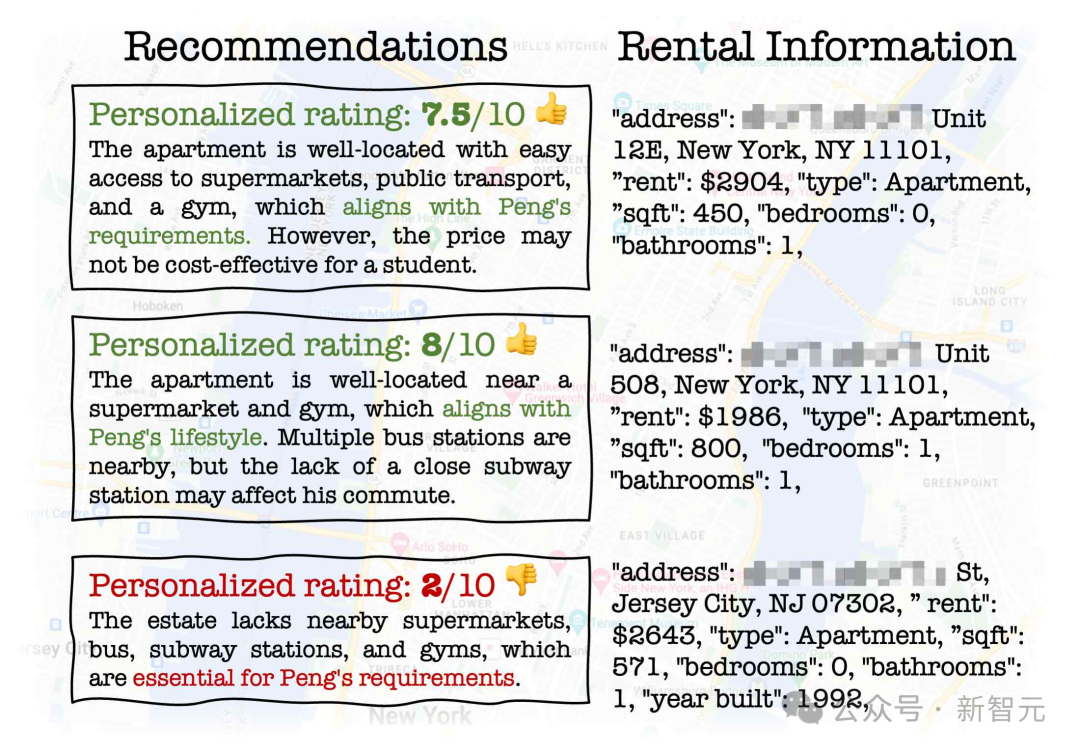

Vivek是一位房地產經紀人,他使用房地產API在Peng所需的地區和價格范圍內尋找潛在的公寓。

Vivek使用GPT-4提供整體評級和伴隨推理。他最推薦的是一套性價比高的1居室公寓,每月1986美元,靠近超市、2個公交車站和健身房。

視覺驅動

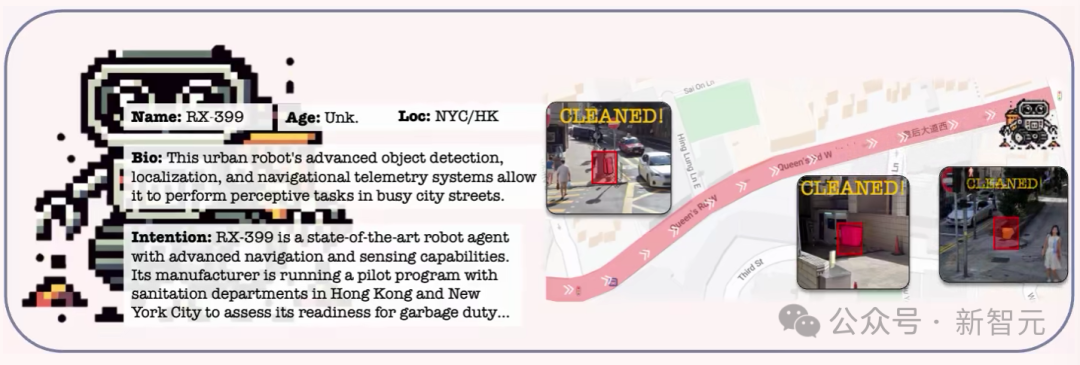

RX-399,是一個城市輔助機器人。

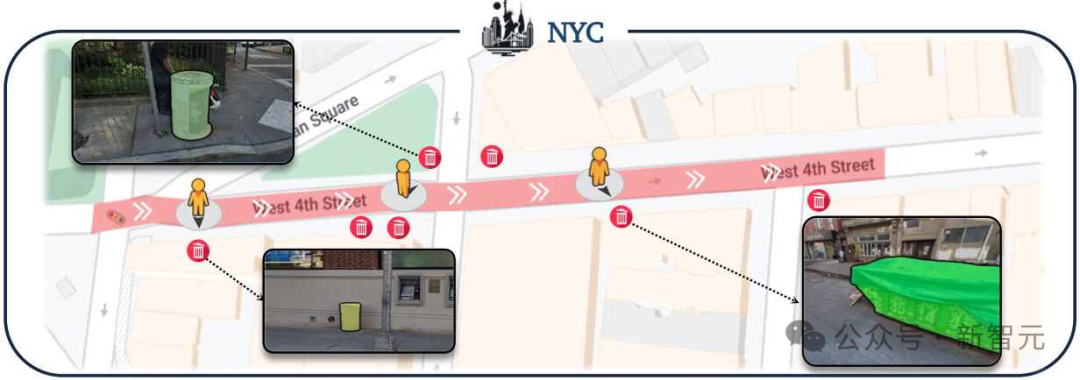

在下面的演示中,他沿著預定義的城市路線導航,使用開放世界探測器和地理定位模塊標記所有垃圾箱。

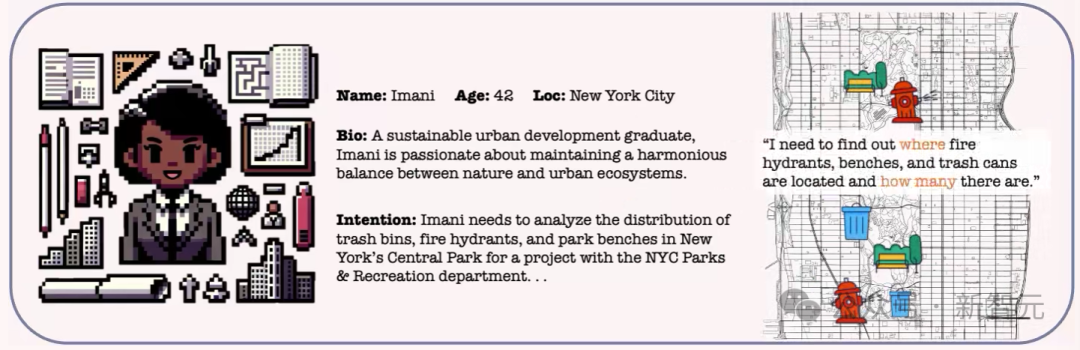

Imani是一位城市規劃師,

她為RX-399設置了穿越中央公園和感興趣物體的路線,RX-399遍歷了這些路線并記錄了所有檢測到的實例。

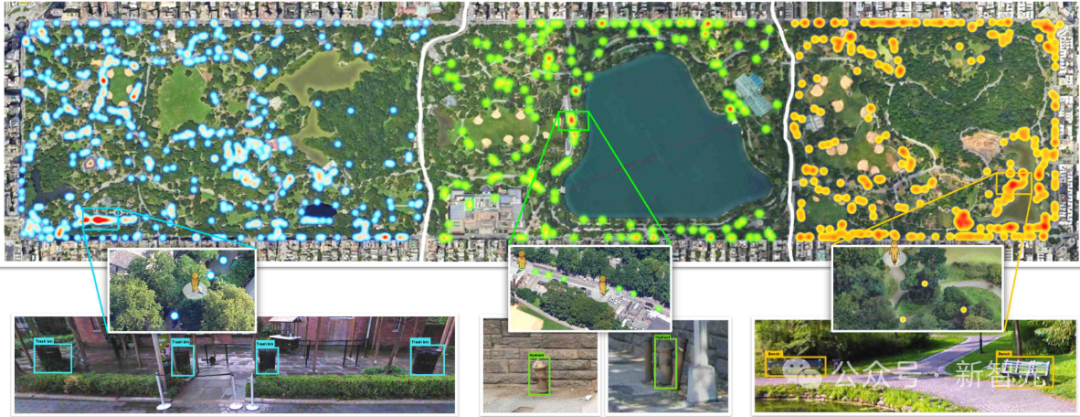

在RX-399完成其路線后,Imani會以不同的細節水平分析RX-399收集的數據。

Imani使用RX-399收集的數據對紐約市中央公園的垃圾箱、消防栓、公園長椅進行可視化。上圖顯示了公園內垃圾箱、消防栓和長凳的一般分布,Imani還可以放大到特定區域。

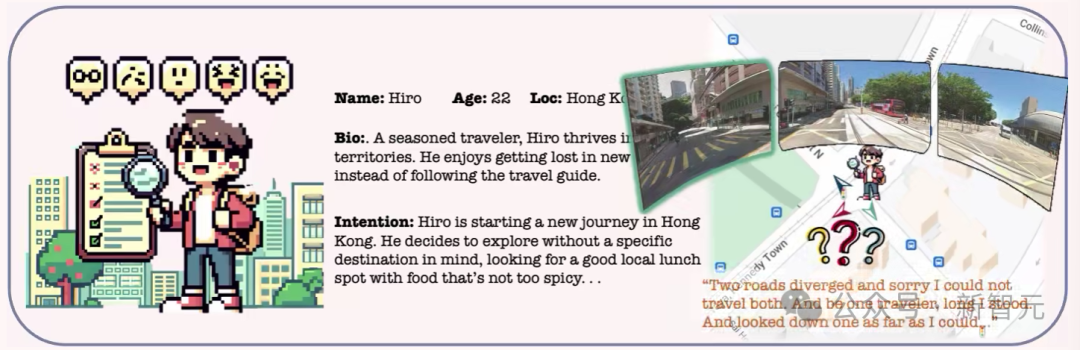

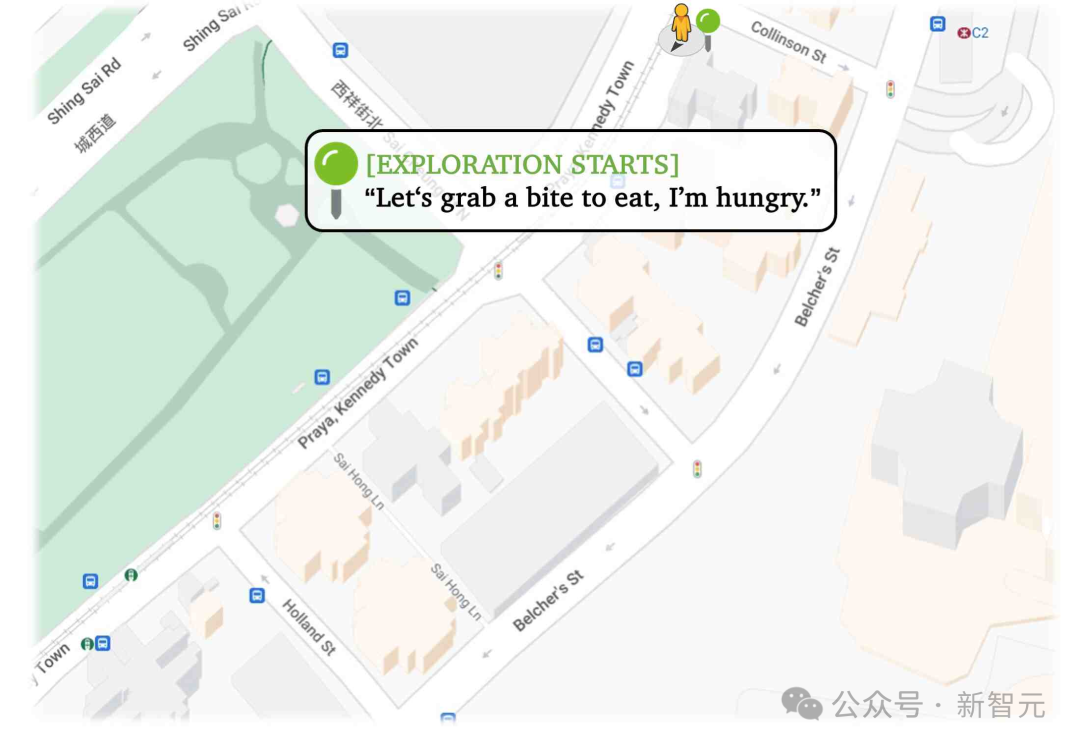

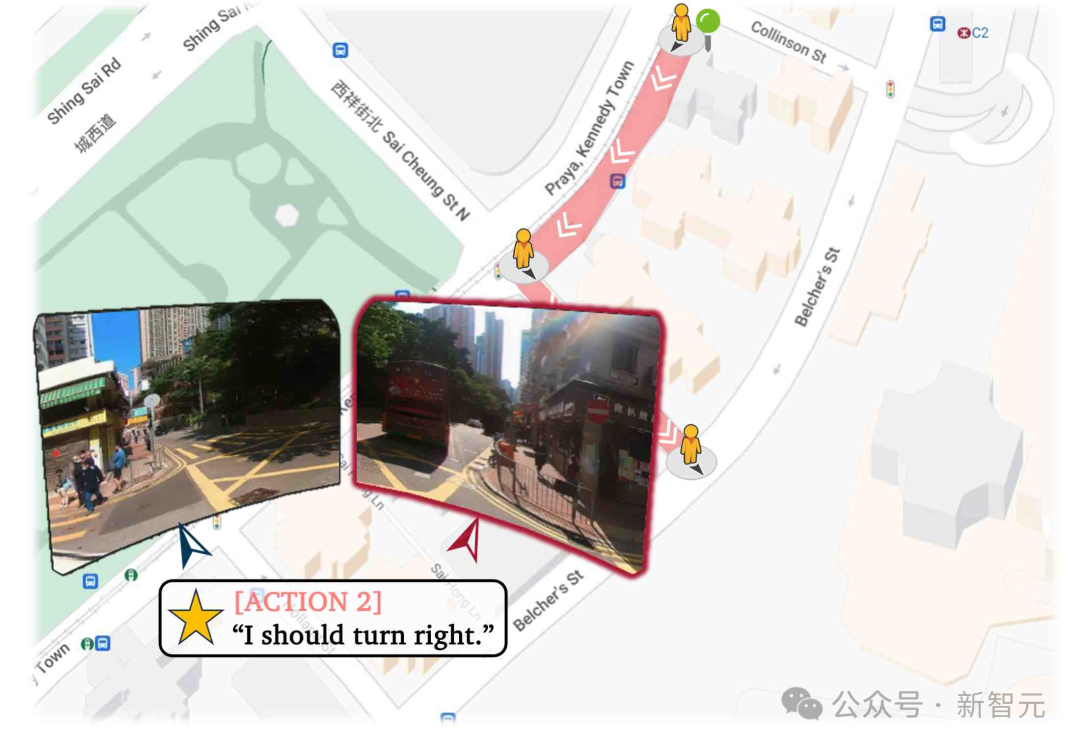

Hiro是一位經驗豐富的旅行者,他使用開放世界檢測來尋找餐廳;使用VQA來選擇合適的道路;使用地點評論和LLM來決定一個地點是否適合自己。

下面是Hiro在香港的午餐探索:

協作

人類經常通過協作來解決復雜的現實世界任務。將復雜任務拆解為簡單的子任務,交給不同領域的專業人士。

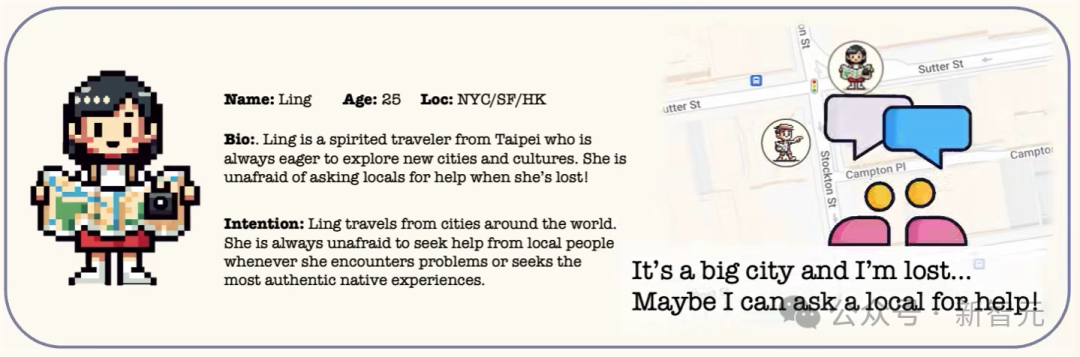

所以當Agent自己沒辦法完成任務的時候,就應該求助。

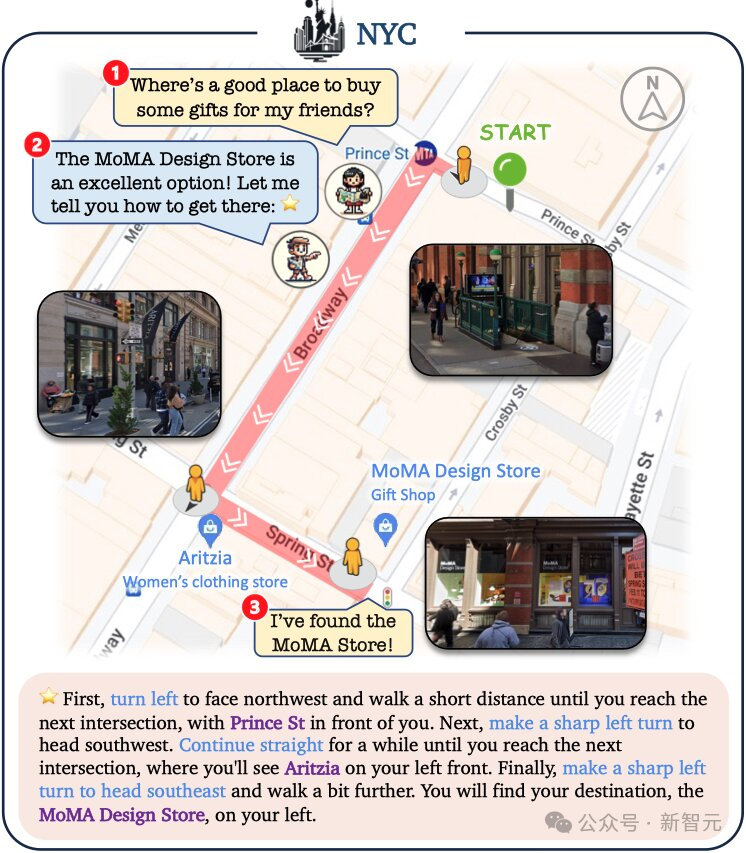

Ling是個游客,她首先從當地人那里獲得路線描述,然后在V-IRL中,Ling可以使用開放世界識別和地圖來調整自己的行進路線。

同時,識別街道上的視覺地標有助于GPT-4就轉向方向、前進和停止的位置給出正確的決定:

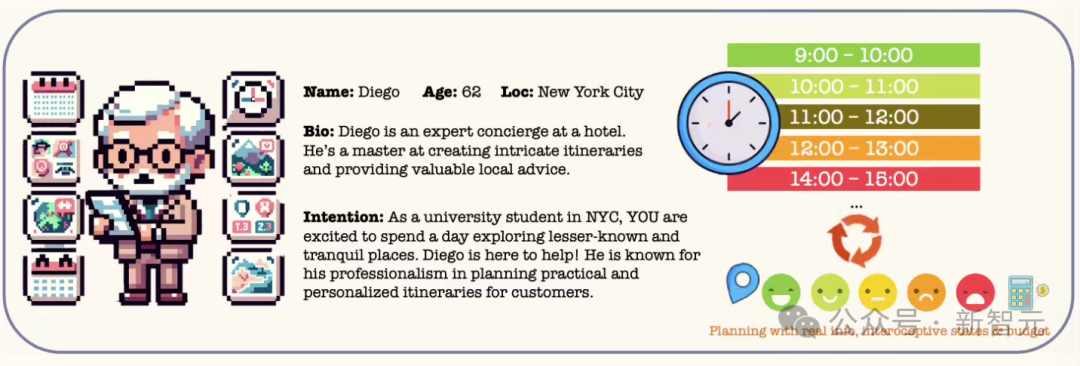

最后一位Diego是禮賓專家:

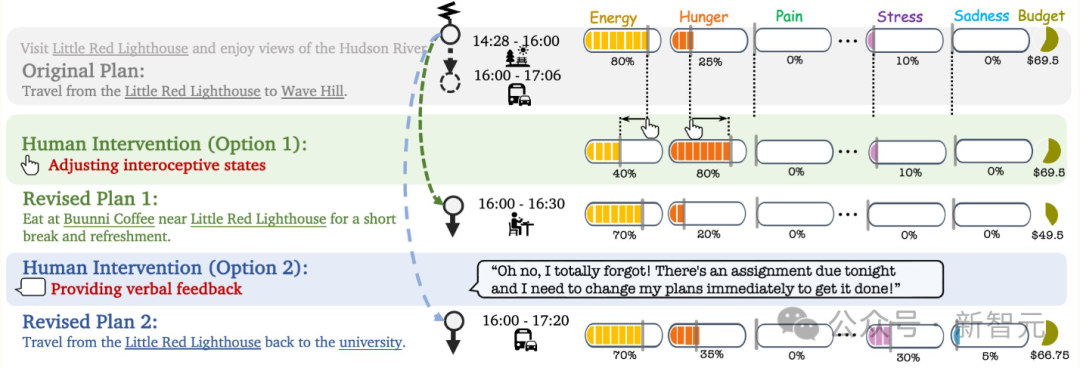

他不僅會考慮你的身體和精神狀態、每項活動的預算,還會預測你在參加每項活動時的狀態變化和費用。

他會考慮到V-IRL平臺提供的真實旅行時間,并與另一個餐廳推薦Agent合作選擇合適的餐飲方案。

當你調整了自己的狀態并通知Diego之后,他會立即修改計劃以滿足要求。

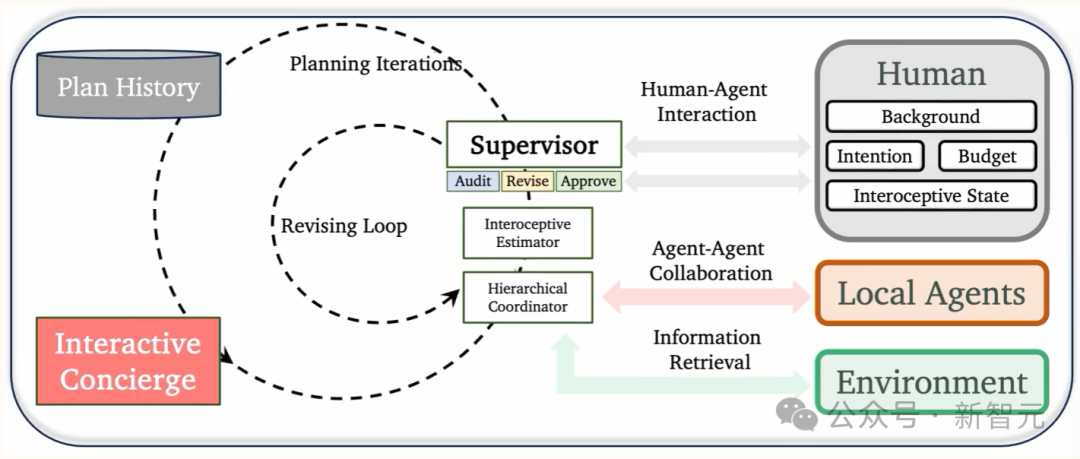

如上圖所示,Diego使用迭代計劃流程。首先,Diego使用GPT-4為第一項活動創建一個初步計劃草案,并將用戶的簡歷、要求和以前的活動納入工作記憶。

然后,通過分層協調(真實的地理空間/地點信息)、感知估算(活動成本和對人類狀態的影響)和監督(預算和潛在干預)對草案進行細致完善。

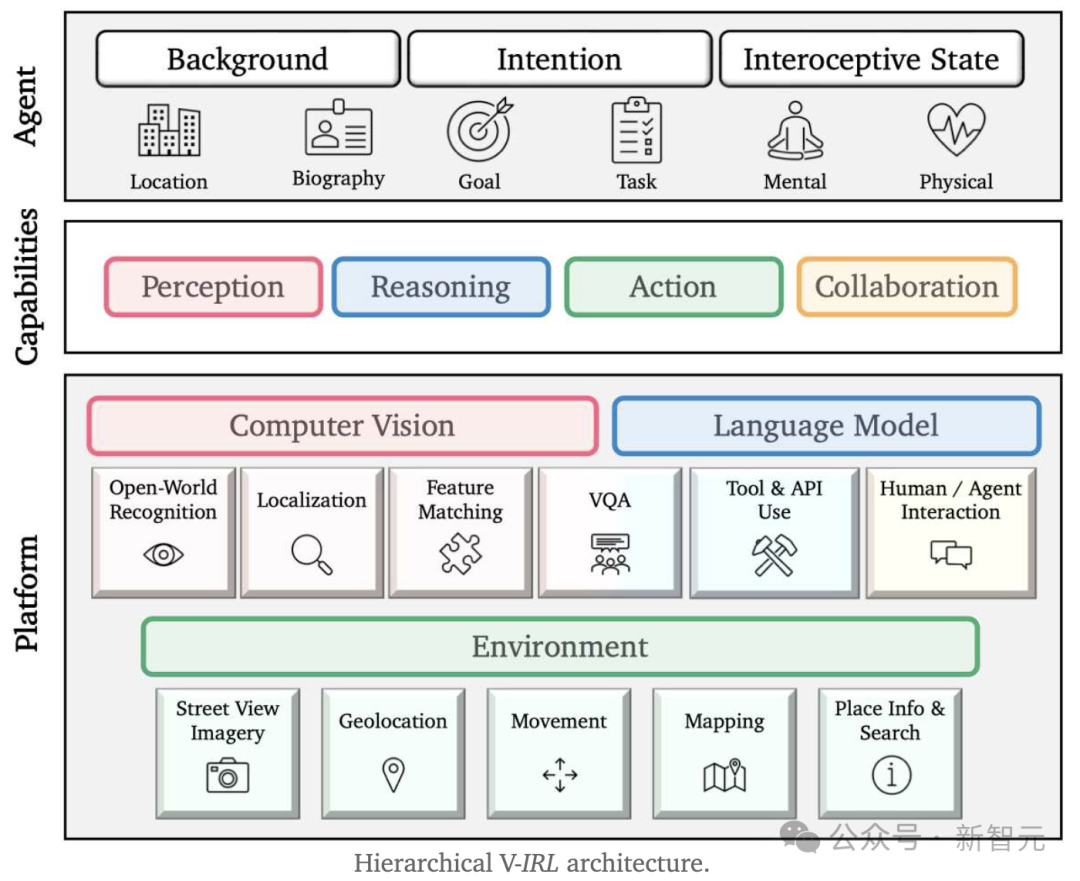

系統基本原理

V-IRL的分層設計把全球各個真實的城市變成了一個龐大的虛擬空間。在這里,智能體可以被構建出來解決實際任務。

其中,平臺是整個系統的基礎,為智能體提供了必要的組件和基礎架構。

在這之上,智能體能夠展現出感知、思考、行動和合作等更高級的能力。

最后,智能體通過這些能力和用戶自定義的信息,在針對特定任務設計的運行程序中找到解決問題的方法。

V-IRL基準測試

V-IRL基準測試的核心在于它能夠處理來自真實世界感覺輸入的地理上多樣化的數據,并且提供了一個便捷的API與谷歌地圖平臺(GMP)進行交互。

基于此,研究人員構建了三個V-IRL基準測試,目的是檢驗現有視覺模型處理這類開放世界數據的能力。

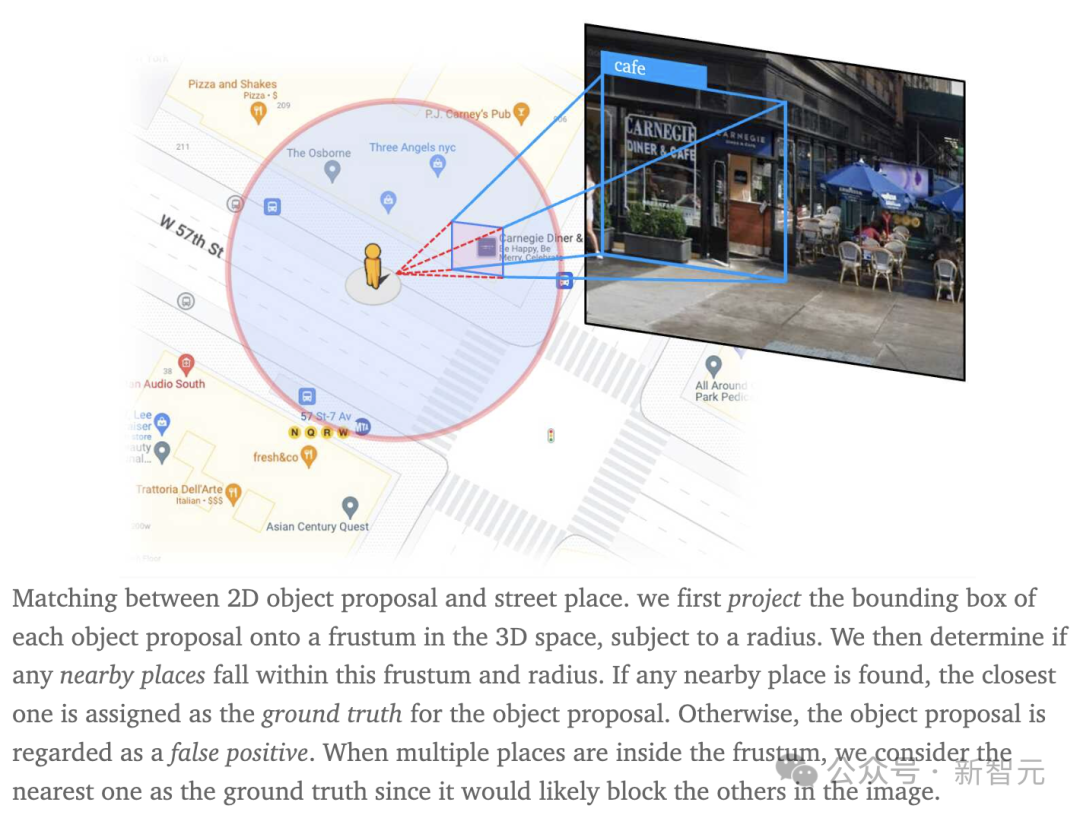

V-IRL地點:定位

- 動機

人們每天在城市中穿梭,為了各種目的前往不同地點。

因此,可以利用街景圖像及其相關的地點數據,來測試視覺模型在日常地點定位任務上的表現。

- 設置

研究人員對RX-399智能體進行了微調,使其能夠在定位和識別20種地點類型的同時,穿越多邊形區域。

測試共包含三種知名的開放世界檢測模型:GroundingDINO、GLIP和Owl-ViT。

此外,研究人員還設置了一個簡單的基準模型——CLIP(結合GLIP提案),即使用CLIP對GLIP提出的分類進行重新分類。

模型的評估依據是定位召回率,即正確定位的地點數與總定位嘗試中的地點數之比。

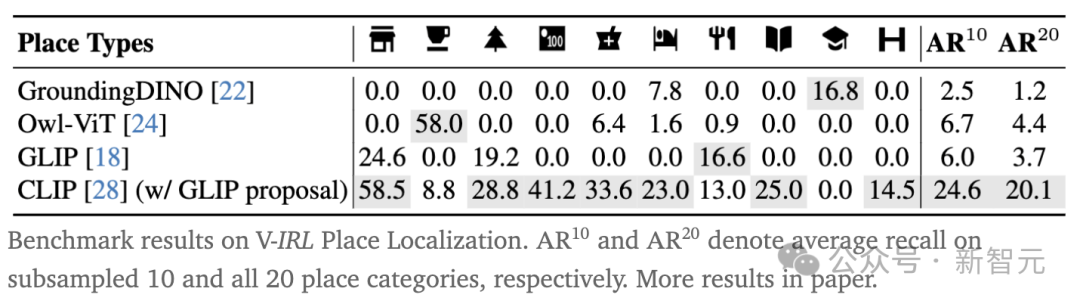

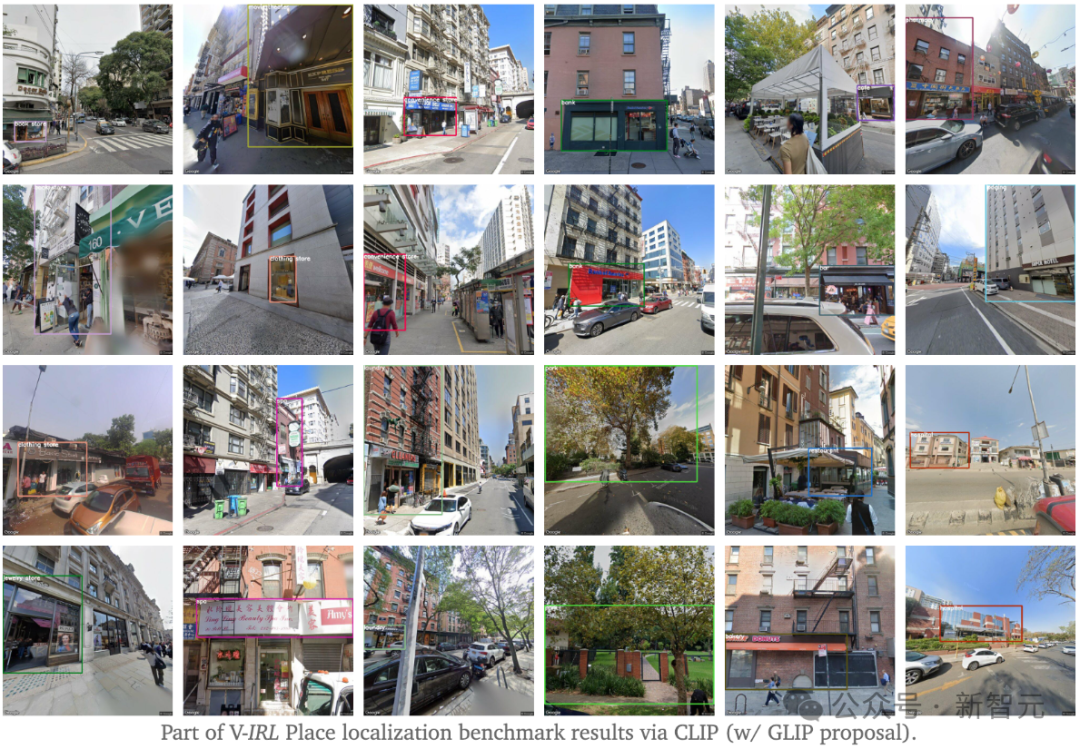

- 結果

由下表所示,開放世界檢測器如GroundingDINO、Owl-ViT和GLIP對某些特定地點類型(例如學校、咖啡館和便利店)是有明顯偏好的。

與之相比,CLIP(結合 GLIP 提案)能識別更多種類的地點。這主要是因為對象檢測數據集中存在的類別偏差,這些數據集通常只包含有限的詞匯。

因此,即便是使用了CLIP進行初始化的檢測器,如Owl-ViT,其能識別的詞匯范圍也會在微調之后縮小。

這些發現表明,對于那些在對象檢測數據集中不太常見的類別,使用不依賴于特定類別的對象提案,進而利用零樣本識別技術進行開放世界定位,是一種很有潛力的方法。

V-IRL地點:識別與視覺問答

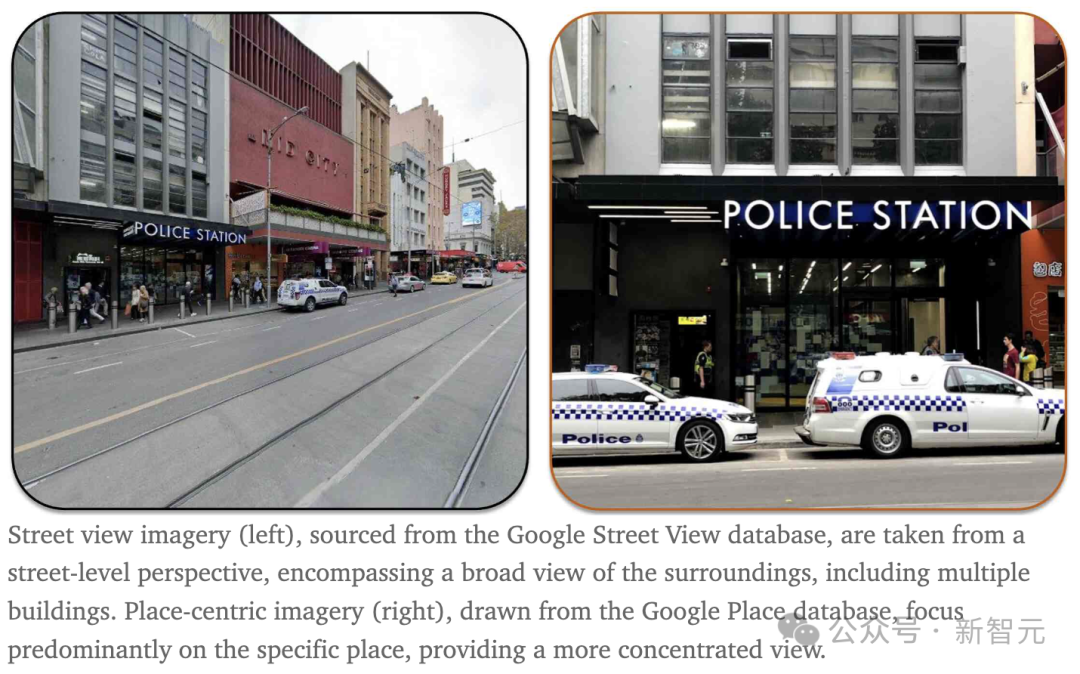

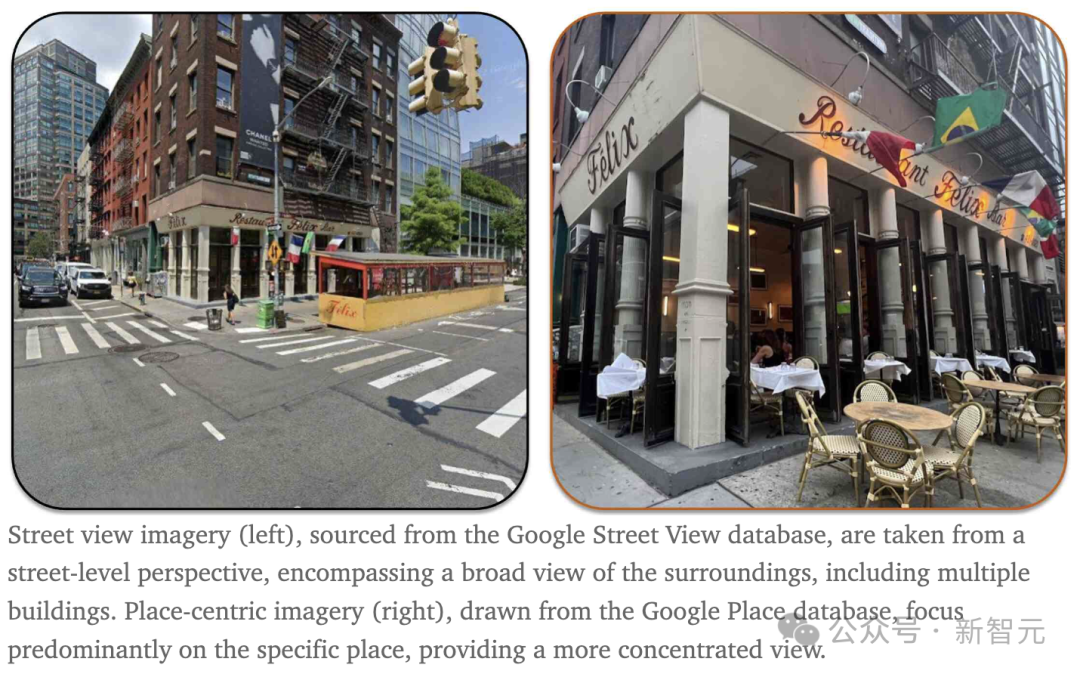

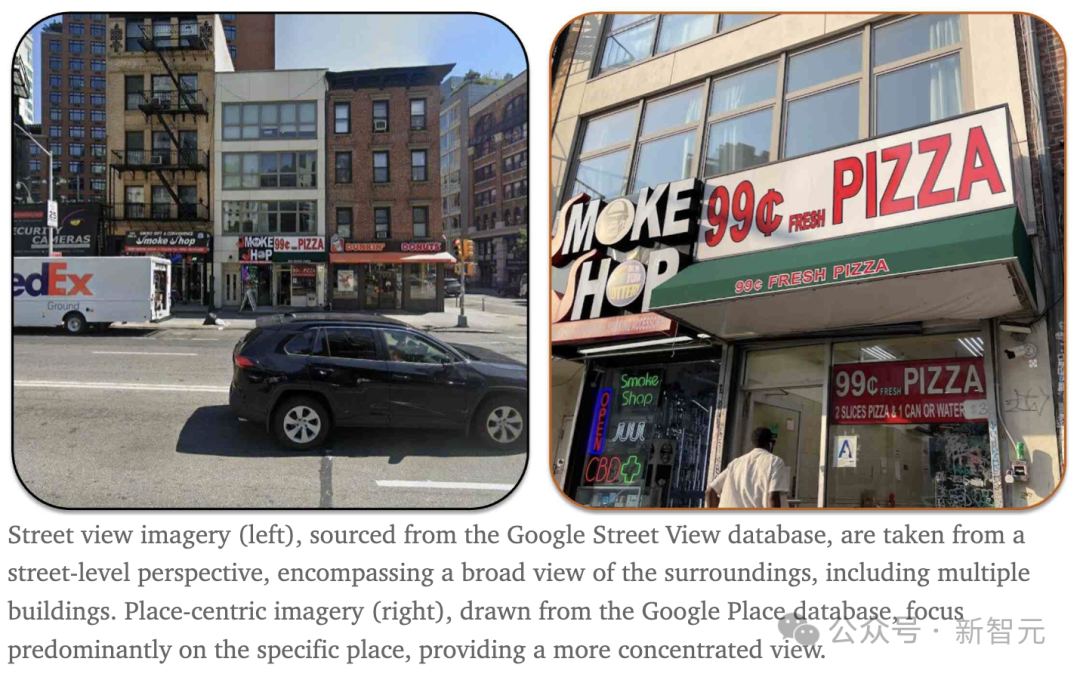

- 動機

相較于在街景圖像上進行的復雜的V-IRL地點定位任務,人們在現實生活中可以通過近距離觀察來輕松識別各種商業場所。

鑒于此,研究人員對現有的視覺模型在兩種以地點為主的圖像感知任務上進行了評估:

(1)識別具體的地點類型;

(2)通過視覺問答來識別人類的意圖,也就是意圖VQA。

- 設置

在識別方面,研究人員評估了10種開放世界識別模型。測試使用的是以地點為中心的圖像,而模型需要從96個選項中識別出地點類型。

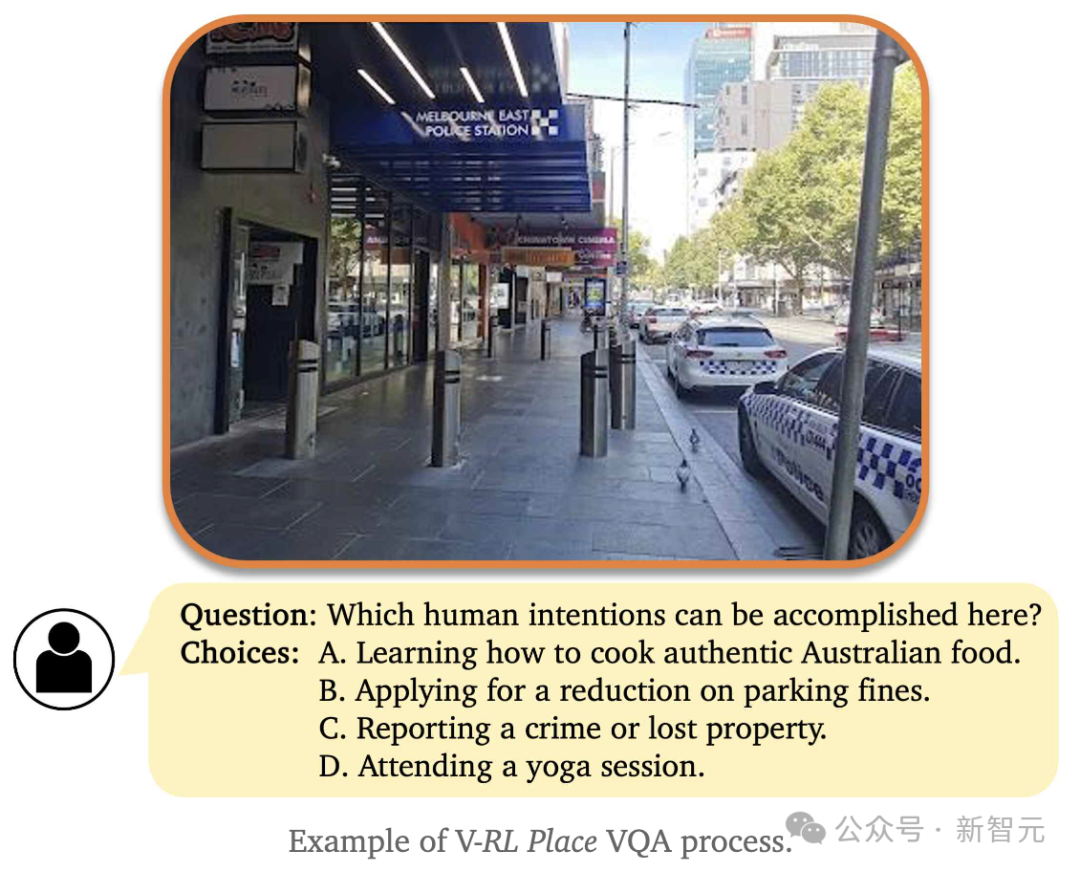

在意圖VQA方面,研究人員還評估了8種多模態大語言模型(MM-LLM),方法是通過包含有4個選項的多選題來判斷人類的可能意圖。

V-IRL地點VQA的過程如下圖所示,其中每個問題的可能答案和正確答案都是由GPT-4自動生成的。

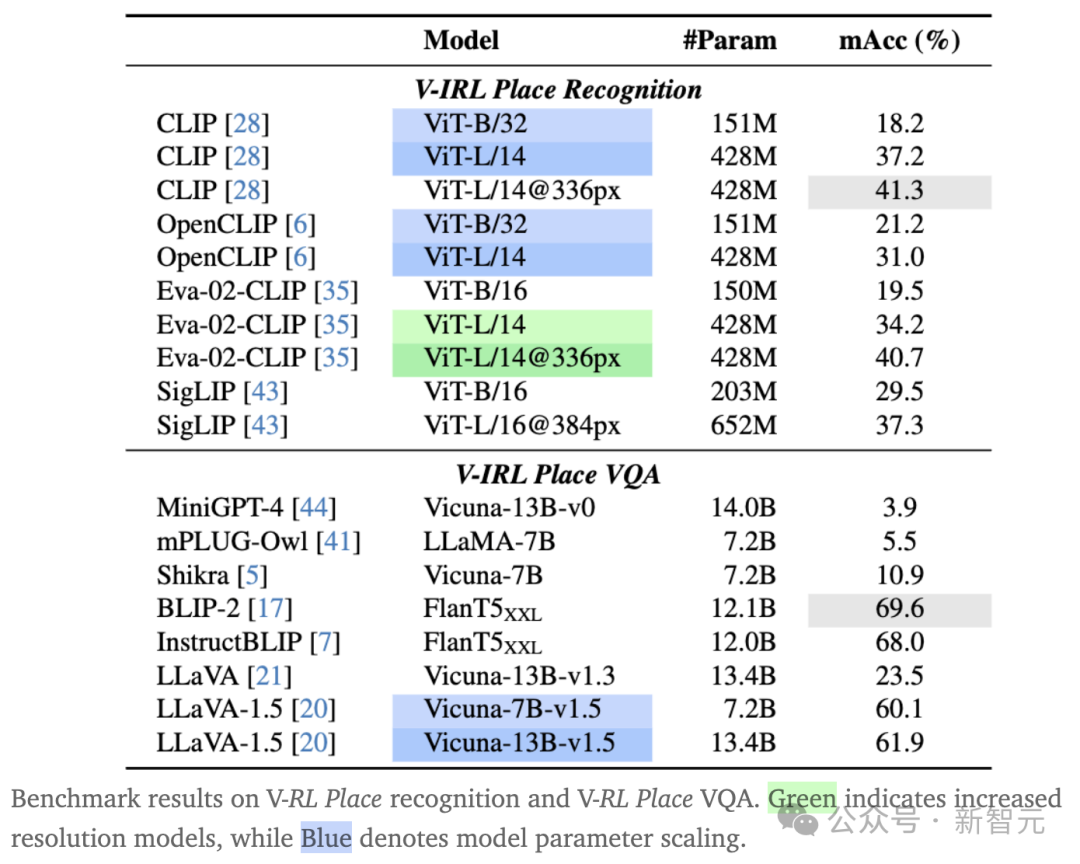

- 結果

如下表所示,在V-RL地點識別任務中,CLIP(L/14@336px)的表現超過了Eva-02-CLIP和SigLIP的最大版本,凸顯了CLIP數據的質量之高。

表格的底部顯示,在意圖VQA方面,BLIP2、InstructBLIP和LLaVA-1.5表現優異,而其他模型則表現不佳。

可以看到,這三個表現最好的MM-LLM在評估過程中給出了一致的答案,而其他模型因為選擇不一致而常常失敗。

V-IRL視覺語言導航

- 動機

Intentional Explorer和Tourist智能體想完成復雜的任務,就必須要同時利用視覺和語言模型。

因此,研究人員通過引入結合了真實街景的新任務,創建出了V-IRL視覺語言導航(VLN)基準測試。

- 設置

研究人員微調了Tourist智能體的實現方式,將其識別組件替換為了不同的基準測試模型,負責在導航過程中識別視覺地標。接著,GPT-4會根據識別的結果預測下一步動作。其中,導航指令由Local智能體生成。

這里,研究人員共評估了四種方法在導航時識別地標的能力:

(1)通過搜索附近地標的近似方法;

(2)零樣本識別器CLIP和EVA-02-CLIP;

(3)多模態大語言模型LLaVA-1.5;

(4)使用OCR模型識別街景中的文本,然后通過GPT解析答案。

- 結果

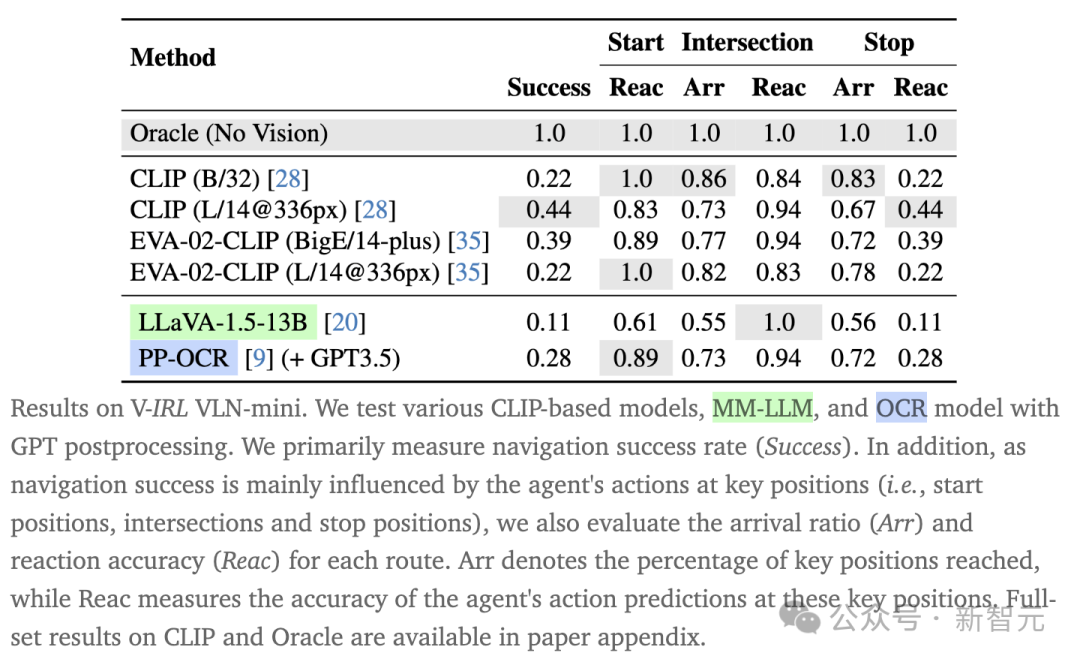

如下表所示,當使用oracle地標信息時,強大的LLM能夠精準地理解導航指令并做出正確的決策,表現令人印象深刻。

但是,當依賴視覺模型從街景獲取地標信息時,成功率大幅下降,這說明視覺模型的感知存在誤導,影響了LLM的決策。

在這些識別器中,CLIP和EVA-02-CLIP的大規模版本表現更為出色,凸顯了模型scaling的優勢。

LLaVA-1.5作為視覺編碼器使用CLIP(L/14@336px)時表現不佳,可能是因為在指令微調過程中存在對齊問題。

另外,PP-OCR(+ GPT-3.5)的成功率為28%,體現出OCR對于視覺地標識別至關重要。

地理多樣性及挑戰

V-IRL基準測試涵蓋了全球12個不同的城市,進而提供了一個獨特的視角,來觀察視覺模型在不同地區可能存在的偏差。

正如下方圖表所展示的,視覺模型在尼日利亞拉各斯、日本東京、中國香港和阿根廷布宜諾斯艾利斯的表現都不盡如人意。

其中,東京、香港和布宜諾斯艾利斯等城市普遍使用了非英語文字。而拉各斯的街景更是與發達城市相比大相徑庭,直接難倒了幾乎所有的視覺模型。

這一現象揭示了一個重要的問題:目前的視覺模型在處理包含多種語言的圖像數據時面臨挑戰。

結論

開源平臺V-IRL的設計初衷是為了縮小數字世界與真實世界之間的感知差異,讓AI Agent能夠在一個既虛擬又真實的環境中與現實世界進行交互。

借助V-IRL,智能體可以基于真實的地理信息和街景圖片,培養出豐富的感知能力和對環境的理解。

研究人員通過構建不同的示例智能體和開展性能評估,展示了這個平臺在全球視覺數據處理方面語言和視覺模型的廣泛應用潛力,為提高AI在理解環境、做出決策和處理現實世界信息方面的能力開啟了新的可能。

隨著空間計算技術和機器人系統的日益普及,AI Agent的需求和應用場景將不斷擴大。

從個人助手到城市規劃,再到為視力受限者打造的生活輔助工具,我們期待著一個能夠深刻理解周圍世界的智能體時代的到來。

作者介紹

Jihan Yang

論文一作Jihan Yang目前在香港大學電子與電氣工程學院攻讀博士學位,導師是Xiaojuan Qi博士。

在此之前,他在中山大學獲得了學士學位,導師是Liang Lin教授和Guanbin Li教授。

此外,他還與Ruijia Xu、Shaoshuai Shi博士、unyu Ding和Zhe Wang博士有著密切的合作。