1.3ms耗時!清華最新開源移動端神經網絡架構 RepViT

論文地址:https://arxiv.org/abs/2307.09283

代碼地址:https://github.com/THU-MIG/RepViT

可以看出,RepViT 相比于其它主流的移動端 ViT 架構確實時很優異。接下來讓我們來看下本工作做了哪些貢獻:

- 文中提到,輕量級 ViTs 通常比輕量級 CNNs 在視覺任務上表現得更好,這主要歸功于它們的多頭自注意力模塊(

MSHA)可以讓模型學習全局表示。然而,輕量級 ViTs 和輕量級 CNNs 之間的架構差異尚未得到充分研究。 - 在這項研究中,作者們通過整合輕量級 ViTs 的有效架構選擇,逐步提升了標準輕量級 CNN(特別是

MobileNetV3的移動友好性。這便衍生出一個新的純輕量級 CNN 家族的誕生,即RepViT。值得注意的是,盡管 RepViT 具有 MetaFormer 結構,但它完全由卷積組成。 - 實驗結果表明,

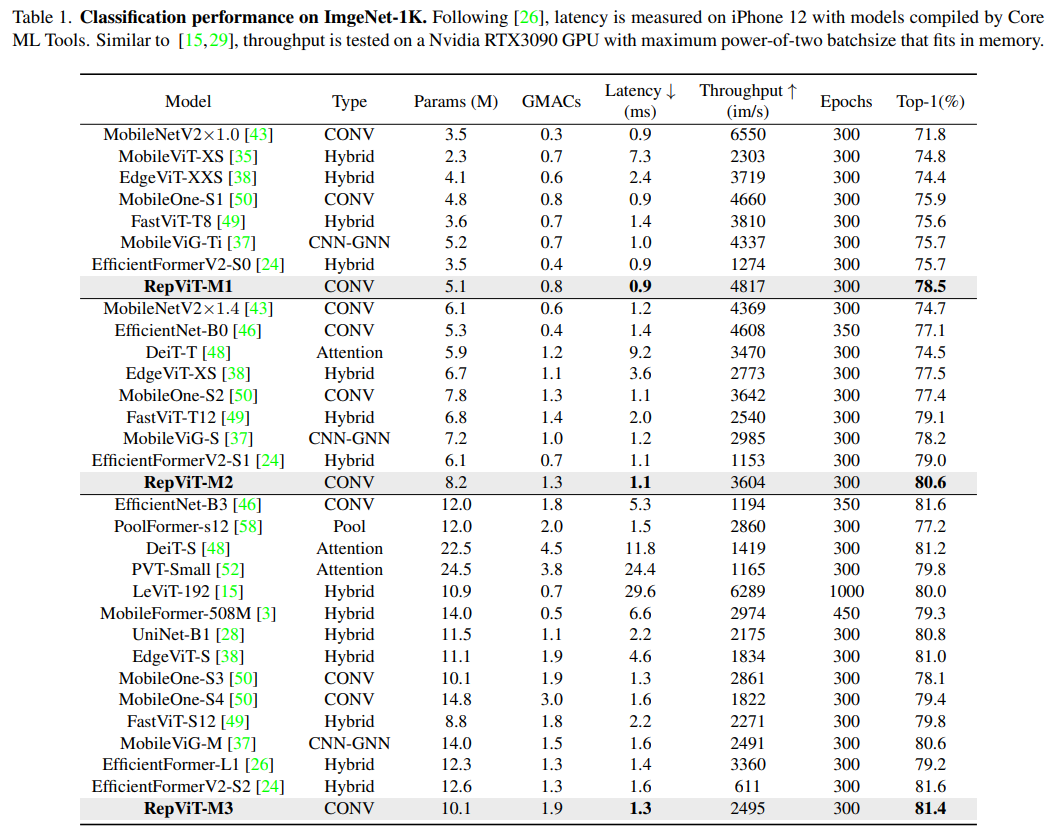

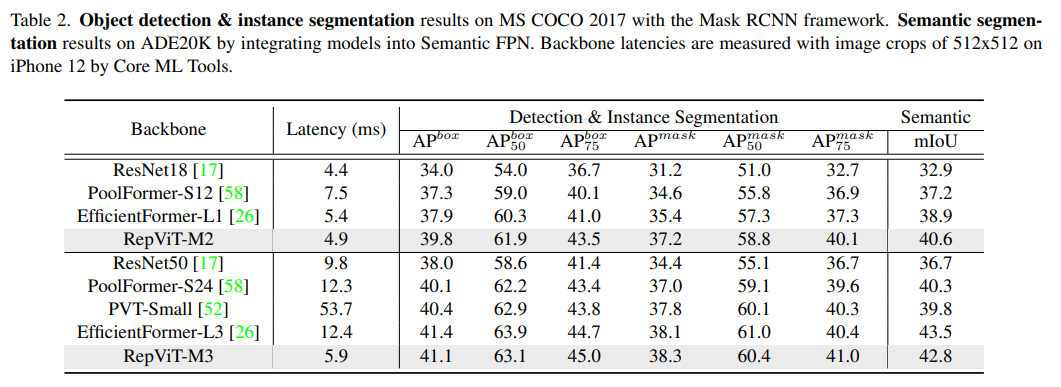

RepViT超越了現有的最先進的輕量級 ViTs,并在各種視覺任務上顯示出優于現有最先進輕量級ViTs的性能和效率,包括 ImageNet 分類、COCO-2017 上的目標檢測和實例分割,以及 ADE20k 上的語義分割。特別地,在ImageNet上,RepViT在iPhone 12上達到了近乎 1ms 的延遲和超過 80% 的Top-1 準確率,這是輕量級模型的首次突破。

好了,接下來大家應該關心的應該時“如何設計到如此低延遲但精度還很6的模型”出來呢?

方法

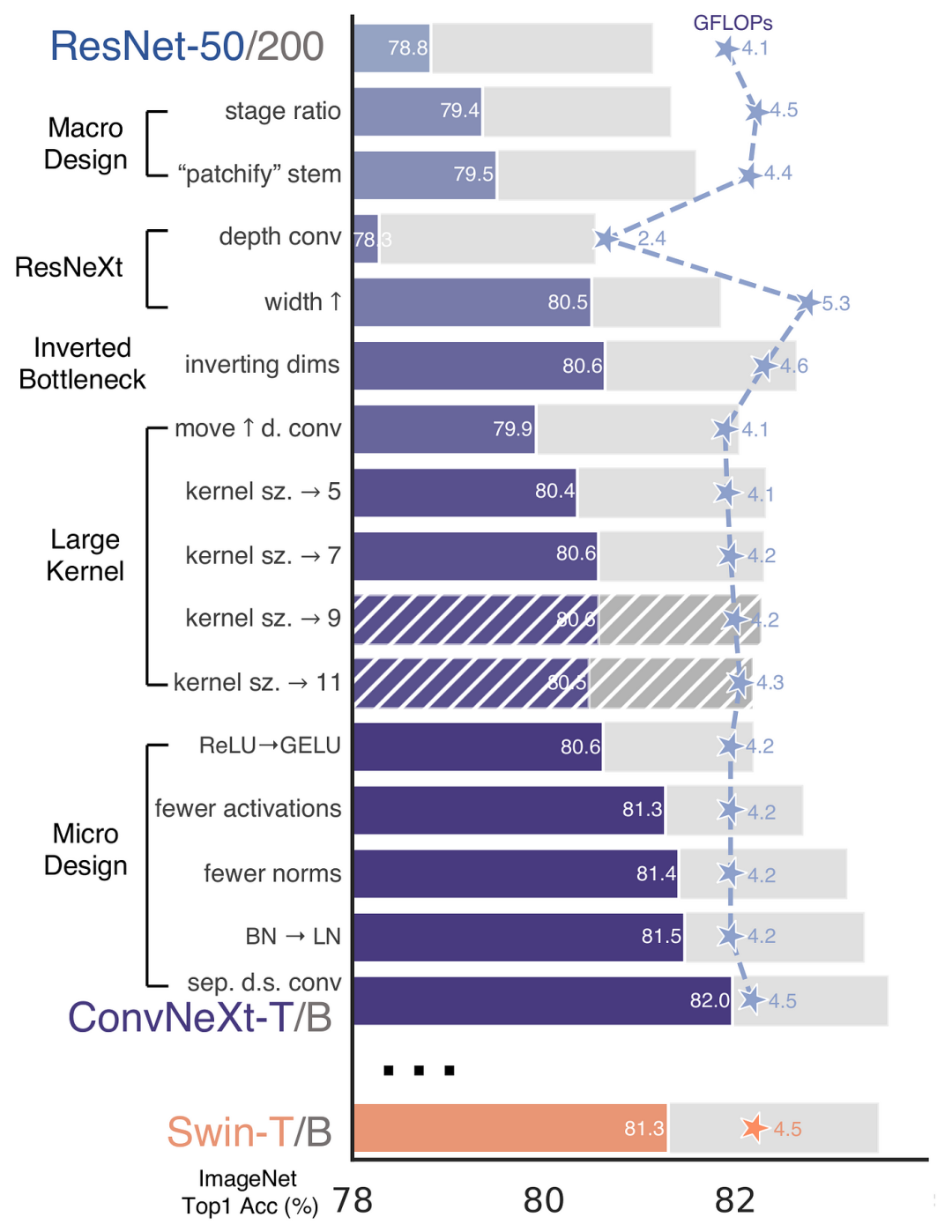

再 ConvNeXt 中,作者們是基于 ResNet50 架構的基礎上通過嚴謹的理論和實驗分析,最終設計出一個非常優異的足以媲美 Swin-Transformer 的純卷積神經網絡架構。同樣地,RepViT也是主要通過將輕量級 ViTs 的架構設計逐步整合到標準輕量級 CNN,即MobileNetV3-L,來對其進行針對性地改造(魔改)。在這個過程中,作者們考慮了不同粒度級別的設計元素,并通過一系列步驟達到優化的目標。

訓練配方的對齊

首先,論文中引入了一種衡量移動設備上延遲的指標,并將訓練策略與現有的輕量級 ViTs 對齊。這一步驟主要是為了確保模型訓練的一致性,其涉及兩個概念,即延遲度量和訓練策略的調整。

延遲度量指標

為了更準確地衡量模型在真實移動設備上的性能,作者選擇了直接測量模型在設備上的實際延遲,以此作為基準度量。這個度量方法不同于之前的研究,它們主要通過FLOPs或模型大小等指標優化模型的推理速度,這些指標并不總能很好地反映在移動應用中的實際延遲。

訓練策略的對齊

這里,將 MobileNetV3-L 的訓練策略調整以與其他輕量級 ViTs 模型對齊。這包括使用 AdamW 優化器【ViTs 模型必備的優化器】,進行 5 個 epoch 的預熱訓練,以及使用余弦退火學習率調度進行 300 個 epoch 的訓練。盡管這種調整導致了模型準確率的略微下降,但可以保證公平性。

塊設計的優化

接下來,基于一致的訓練設置,作者們探索了最優的塊設計。塊設計是 CNN 架構中的一個重要組成部分,優化塊設計有助于提高網絡的性能。

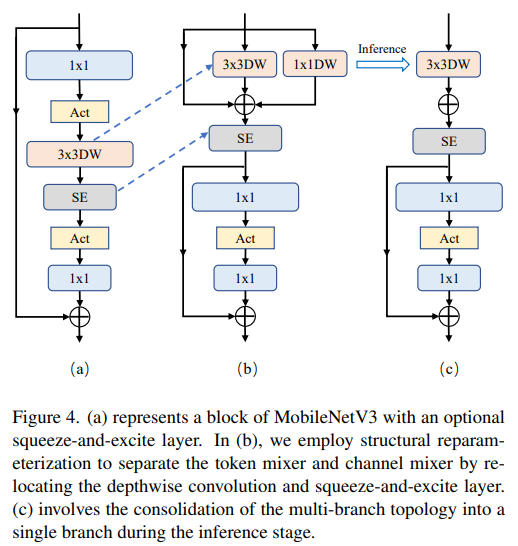

分離 Token 混合器和通道混合器

這塊主要是對 MobileNetV3-L 的塊結構進行了改進,分離了令牌混合器和通道混合器。原來的 MobileNetV3 塊結構包含一個 1x1 擴張卷積,然后是一個深度卷積和一個 1x1 的投影層,然后通過殘差連接連接輸入和輸出。在此基礎上,RepViT 將深度卷積提前,使得通道混合器和令牌混合器能夠被分開。為了提高性能,還引入了結構重參數化來在訓練時為深度濾波器引入多分支拓撲。最終,作者們成功地在 MobileNetV3 塊中分離了令牌混合器和通道混合器,并將這種塊命名為 RepViT 塊。

降低擴張比例并增加寬度

在通道混合器中,原本的擴張比例是 4,這意味著 MLP 塊的隱藏維度是輸入維度的四倍,消耗了大量的計算資源,對推理時間有很大的影響。為了緩解這個問題,我們可以將擴張比例降低到 2,從而減少了參數冗余和延遲,使得 MobileNetV3-L 的延遲降低到 0.65ms。隨后,通過增加網絡的寬度,即增加各階段的通道數量,Top-1 準確率提高到 73.5%,而延遲只增加到 0.89ms!

宏觀架構元素的優化

在這一步,本文進一步優化了MobileNetV3-L在移動設備上的性能,主要是從宏觀架構元素出發,包括 stem,降采樣層,分類器以及整體階段比例。通過優化這些宏觀架構元素,模型的性能可以得到顯著提高。

淺層網絡使用卷積提取器

圖片

圖片

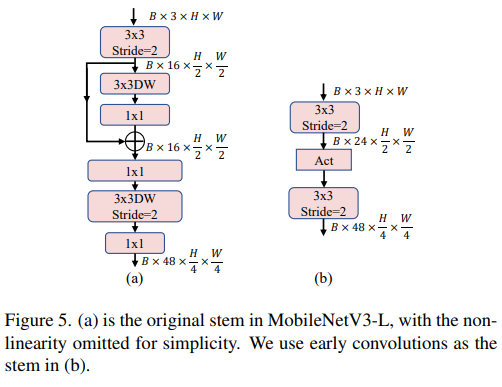

ViTs 通常使用一個將輸入圖像分割成非重疊補丁的 "patchify" 操作作為 stem。然而,這種方法在訓練優化性和對訓練配方的敏感性上存在問題。因此,作者們采用了早期卷積來代替,這種方法已經被許多輕量級 ViTs 所采納。對比之下,MobileNetV3-L 使用了一個更復雜的 stem 進行 4x 下采樣。這樣一來,雖然濾波器的初始數量增加到24,但總的延遲降低到0.86ms,同時 top-1 準確率提高到 73.9%。

更深的下采樣層

在 ViTs 中,空間下采樣通常通過一個單獨的補丁合并層來實現。因此這里我們可以采用一個單獨和更深的下采樣層,以增加網絡深度并減少由于分辨率降低帶來的信息損失。具體地,作者們首先使用一個 1x1 卷積來調整通道維度,然后將兩個 1x1 卷積的輸入和輸出通過殘差連接,形成一個前饋網絡。此外,他們還在前面增加了一個 RepViT 塊以進一步加深下采樣層,這一步提高了 top-1 準確率到 75.4%,同時延遲為 0.96ms。

更簡單的分類器

在輕量級 ViTs 中,分類器通常由一個全局平均池化層后跟一個線性層組成。相比之下,MobileNetV3-L 使用了一個更復雜的分類器。因為現在最后的階段有更多的通道,所以作者們將它替換為一個簡單的分類器,即一個全局平均池化層和一個線性層,這一步將延遲降低到 0.77ms,同時 top-1 準確率為 74.8%。

整體階段比例

階段比例代表了不同階段中塊數量的比例,從而表示了計算在各階段中的分布。論文選擇了一個更優的階段比例 1:1:7:1,然后增加網絡深度到 2:2:14:2,從而實現了一個更深的布局。這一步將 top-1 準確率提高到 76.9%,同時延遲為 1.02 ms。

微觀設計的調整

接下來,RepViT 通過逐層微觀設計來調整輕量級 CNN,這包括選擇合適的卷積核大小和優化擠壓-激勵(Squeeze-and-excitation,簡稱SE)層的位置。這兩種方法都能顯著改善模型性能。

卷積核大小的選擇

眾所周知,CNNs 的性能和延遲通常受到卷積核大小的影響。例如,為了建模像 MHSA 這樣的遠距離上下文依賴,ConvNeXt 使用了大卷積核,從而實現了顯著的性能提升。然而,大卷積核對于移動設備并不友好,因為它的計算復雜性和內存訪問成本。MobileNetV3-L 主要使用 3x3 的卷積,有一部分塊中使用 5x5 的卷積。作者們將它們替換為3x3的卷積,這導致延遲降低到 1.00ms,同時保持了76.9%的top-1準確率。

SE 層的位置

自注意力模塊相對于卷積的一個優點是根據輸入調整權重的能力,這被稱為數據驅動屬性。作為一個通道注意力模塊,SE層可以彌補卷積在缺乏數據驅動屬性上的限制,從而帶來更好的性能。MobileNetV3-L 在某些塊中加入了SE層,主要集中在后兩個階段。然而,與分辨率較高的階段相比,分辨率較低的階段從SE提供的全局平均池化操作中獲得的準確率提升較小。作者們設計了一種策略,在所有階段以交叉塊的方式使用SE層,從而在最小的延遲增量下最大化準確率的提升,這一步將top-1準確率提升到77.4%,同時延遲降低到0.87ms。【這一點其實百度在很早前就已經做過實驗比對得到過這個結論了,SE 層放置在靠近深層的地方效果好】

網絡架構

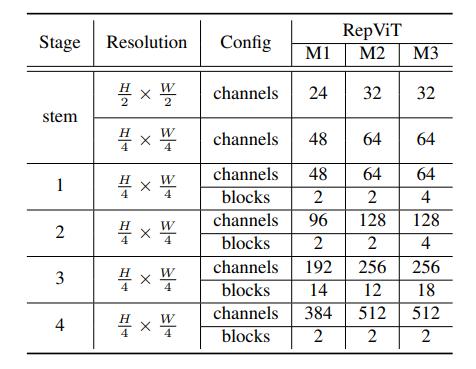

最終,通過整合上述改進策略,我們便得到了模型RepViT的整體架構,該模型有多個變種,例如RepViT-M1/M2/M3。同樣地,不同的變種主要通過每個階段的通道數和塊數來區分。

實驗

圖像分類

檢測與分割

總結

本文通過引入輕量級 ViT 的架構選擇,重新審視了輕量級 CNNs 的高效設計。這導致了 RepViT 的出現,這是一種新的輕量級 CNNs 家族,專為資源受限的移動設備設計。在各種視覺任務上,RepViT 超越了現有的最先進的輕量級 ViTs 和 CNNs,顯示出優越的性能和延遲。這突顯了純粹的輕量級 CNNs 對移動設備的潛力。