撰稿丨諾亞

出品 | 51CTO技術棧(微信號:blog51cto)

總被用戶吐槽“有點智障”的Siri有救了!

Siri自誕生以來就是智能語音助手領域的代表之一,但很長一段時間里,其表現并不盡如人意。然而,蘋果的人工智能團隊最新發布的研究成果有望極大地改變現狀。

在相關的研究論文中,蘋果的AI專家們描述了一個系統,其中Siri不僅可以識別圖像中的內容,還能做更多的事情,變得更智能、更實用。尤為令人興奮的是,他們認為自己研發的用于實現這一功能的模型ReALM,其基準性能優于GPT 4.0。

一、動機:解決不同實體的指代解析

蘋果的研究團隊指出:“讓對話助手能夠理解上下文,包括相關的內容指向,非常關鍵。能讓用戶根據他們所看到的屏幕內容進行提問,是確保真正實現語音操作體驗的重要一步。”

打個比方,在人機交互過程中,用戶常常會在對話中提及屏幕上的某個元素或內容,例如指示語音助手撥打電話號碼、導航至地圖上的特定地點、打開特定應用程序或網頁等。如果對話助手無法理解用戶指令背后的實體指代,就無法準確地執行這些命令。

而且人類對話中普遍存在模糊指代的現象,為了實現自然的人機交互,以及在用戶與語音助手進行關于屏幕內容查詢時準確理解語境,指代解析能力至關重要。

蘋果在論文中提到的名為ReALM(Reference Resolution As Language Modeling)的模型,其優勢就在于,它能夠同時考慮用戶屏幕上的內容和正在進行的任務,利用大語言模型解決不同類型實體(包括對話實體和非對話實體)的指代解析問題。

盡管傳統的文本模態不便于處理屏幕上顯示的實體,但ReALM系統通過將指代解析轉化為語言建模問題,并成功運用LLMs來處理屏幕上非對話實體的指代,極大地推動了這一目標的達成。如此一來,便有望達成高度智能、更加沉浸的用戶體驗。

二、重構:突破傳統文本模態的限制

傳統的文本模態不便于處理屏幕上顯示的實體,是因為屏幕上的實體通常包含豐富的視覺信息和布局結構,例如圖像、圖標、按鈕及它們之間的相對位置關系等,這些信息在純粹的文本描述中難以完全表達。

ReALM系統針對這一挑戰,創造性地提出了通過解析屏幕上的實體及其位置信息來重建屏幕,并生成一種純文本表示,這種文本能可視化地反映屏幕內容。

實體部分會被特別標記,以便語言模型了解實體出現在何處及其周圍的文本是什么,這樣就能模擬“看到”屏幕上的信息,并在理解和解析屏幕上的指代時提供必要的上下文信息。這種方法是首次嘗試使用大型語言模型從屏幕內容中編碼上下文,克服了傳統文本模態難以處理的屏幕實體的問題。

具體來說,ReALM系統為了讓大型語言模型能夠“理解”并處理屏幕上顯示的實體,采用了以下步驟:

首先,借助上層數據檢測器提取屏幕文本中的實體,這些實體會帶有類型、邊界框以及實體周圍非實體文本元素的列表。這意味著,對于屏幕上每一個可視化的實體,系統都會捕捉其基本信息和它所處的上下文環境。

然后,ReALM創新地提出了一種算法,通過將實體及其周圍對象的邊界框中心點按照垂直(從上至下)和水平(從左至右)的順序排序,并穩定排列。若實體間距離較近,則認為它們在同一行內,并用制表符隔開;若距離超出設定的邊距,則將它們置于下一行。這樣,通過連續應用上述方法,就可以將屏幕內容按從左到右、從上到下的方式編碼成純文本格式,有效地保留了實體間的相對空間位置關系。

這樣一來,原本難以直接被LLM處理的屏幕視覺信息轉化成了適合語言模型輸入的文本形式,使LLM能夠在處理序列到序列的任務時,充分考慮到了屏幕實體的具體位置和上下文,從而實現對屏幕實體的正確識別和指代解析。

這使得ReALM系統不僅在解決對話實體的指代問題上表現出色,而且在處理非對話類實體——即屏幕上的實體時同樣表現出了顯著的性能提升。

三、細節:任務定義和數據集

簡單來,ReALM系統面臨的任務是,根據用戶想要執行的任務,在給定的實體集合中,找出與當前用戶查詢相關的實體。

這個任務被構造成一個針對大型語言模型的選擇題,期望從用戶屏幕展示的實體中選擇一個或多個選項作為答案。當然,在某些情況下,答案可能是“都不是”。

事實上,研究論文將任務涉及的實體分為三類:

1. 屏幕實體:是指當前在用戶界面上可見的實體。

2. 對話實體:與對話內容相關的實體,可能來自用戶的上一輪發言(如用戶提到“呼叫媽媽”,則聯系人列表中“媽媽”的條目就是相關實體),也可能由虛擬助手在對話中提供(如供用戶選擇的地點列表)。

3. 背景實體:源于后臺進程,不一定直接體現在用戶屏幕顯示或與虛擬助手互動中的相關實體,例如預設會響起的鬧鐘或正在后臺播放的音樂。

至于用于訓練和測試ReALM的數據集,由合成數據和人工標注的數據組成,同樣可劃分為三類:

其一,對話數據集:包含了與用戶與代理交互相關的實體的數據點。這些數據通過讓評分員查看含有合成實體列表的截圖,并要求他們提供明確指向列表中任意選定實體的查詢來收集。

其二,合成數據集:采用模板生成法得到數據,特別是當用戶查詢和實體類型足以確定指代,無需依賴詳細描述時,這種方法特別有用。合成數據集中也可以包含多個實體對應同一查詢的情況。

其三,屏幕數據集:主要涵蓋了用戶屏幕上當前顯示的實體的數據,每一條數據都包含用戶查詢、實體列表以及與該查詢對應的正確實體(或實體集合)。每個實體的信息包括實體類型和其他屬性,如名稱以及其他與實體相關的文本細節(例如,鬧鐘的標簽和時間)。

對于含有屏幕相關上下文的數據點,上下文信息以實體的邊界框以及圍繞該實體的其他對象列表的形式提供,同時附帶這些周邊對象的類型、文本內容和位置等屬性信息。整個數據集的大小根據類別分為訓練集和測試集,并且各具一定規模。

四、結果:最小的模型也取得了5%的性能提升

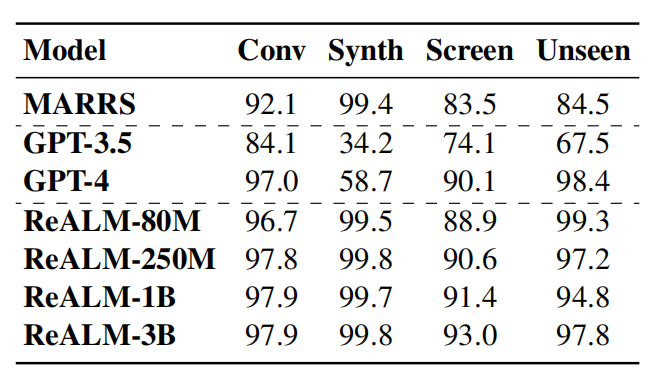

在基準測試中,蘋果公司將自家系統與GPT 3.5和GPT 4.0進行了比較。ReALM模型在解決不同類型的指代解析任務方面表現出卓越的競爭力。

圖片

圖片

根據論文所述,即便是ReALM中參數最少的版本,相較于基線系統也實現了超過5%的性能提升。而在更大的模型版本上,ReALM則明顯勝過GPT-4。特別是在處理屏幕上顯示的實體時,隨著模型規模的增加,ReALM在屏幕數據集上的性能提升更為顯著。

另外,ReALM模型在全新領域的零樣本學習場景上,其性能與GPT-4相當接近。而在處理特定領域的查詢時,由于經過用戶請求的微調,ReALM模型比GPT-4表現得更加精準。

比如,對于要求調整亮度這樣的用戶請求,GPT-4僅將該請求關聯到設置,而忽略了背景中存在的智能家居設備也是相關實體,而ReALM因為接受了領域特有數據的訓練,能夠更好地理解并正確解析此類特定領域內的指代問題。

“我們證明了ReaLM超越了以往的方法,并且盡管參數數量遠少于當前最先進的LLM——GPT-4,即使在純粹基于文本領域處理屏幕內引用時,ReaLM也能達到與其相當的表現水平。此外,對于特定領域的用戶話語,ReaLM的表現還優于GPT-4,因此,ReaLM可以說是在保證性能不打折扣的同時,適用于開發面向實際應用環境、可在設備本地高效運行的指代解析系統的首選方案。”

此外,研究人員還表示,在資源有限、需要低延遲響應或者涉及多階段集成如API調用等實際應用場景中,單一的大型端到端模型往往并不適用。

在這種背景下,模塊化設計的ReALM系統更具有優勢,允許在不影響整體架構的情況下,輕松替換和升級原有的指代解析模塊,同時提供更好的優化潛力和可解釋性。

面向未來,研究方向則指向了更為復雜的方法,比如將屏幕區域劃分為網格并以文本形式編碼空間相對位置,雖然頗具挑戰性,但這是一種有前景的探索途徑。

五、寫在最后

在人工智能領域,蘋果雖然一直比較謹慎,但也在默默投入。無論是多模態大模型MM1,還是AI驅動的動畫生成工具Keyframer,再到如今的ReALM,蘋果的研究團隊一直在持續實現著技術突破。

圍觀谷歌、微軟、亞馬遜等競爭對手,紛紛在搜索、云服務、辦公軟件上加碼AI,秀了一波又一波肌肉。蘋果顯然正努力不落人后。隨著生成式AI落地成果不斷涌現,蘋果更是加快了追趕的步伐。早有知情人士透露,在6月舉辦的全球開發者大會上,蘋果將聚焦于人工智能領域,新的人工智能戰略極有可能成為iOS 18升級的核心內容。屆時,說不定會給諸君帶來驚喜。

參考鏈接:

https://apple.slashdot.org/story/24/04/01/1959205/apple-ai-researchers-boast-useful-on-device-model-that-substantially-outperforms-gpt-4

https://arxiv.org/pdf/2403.20329.pdf