CVPR2024:VIVO提出泛化性更強的SAM(附源碼下載)

本文經計算機視覺研究院公眾號授權轉載,轉載請聯系出處。

- 論文地址:https://arxiv.org/pdf/2405.00256

- 代碼:https://asam2024.github.io/

PART/1

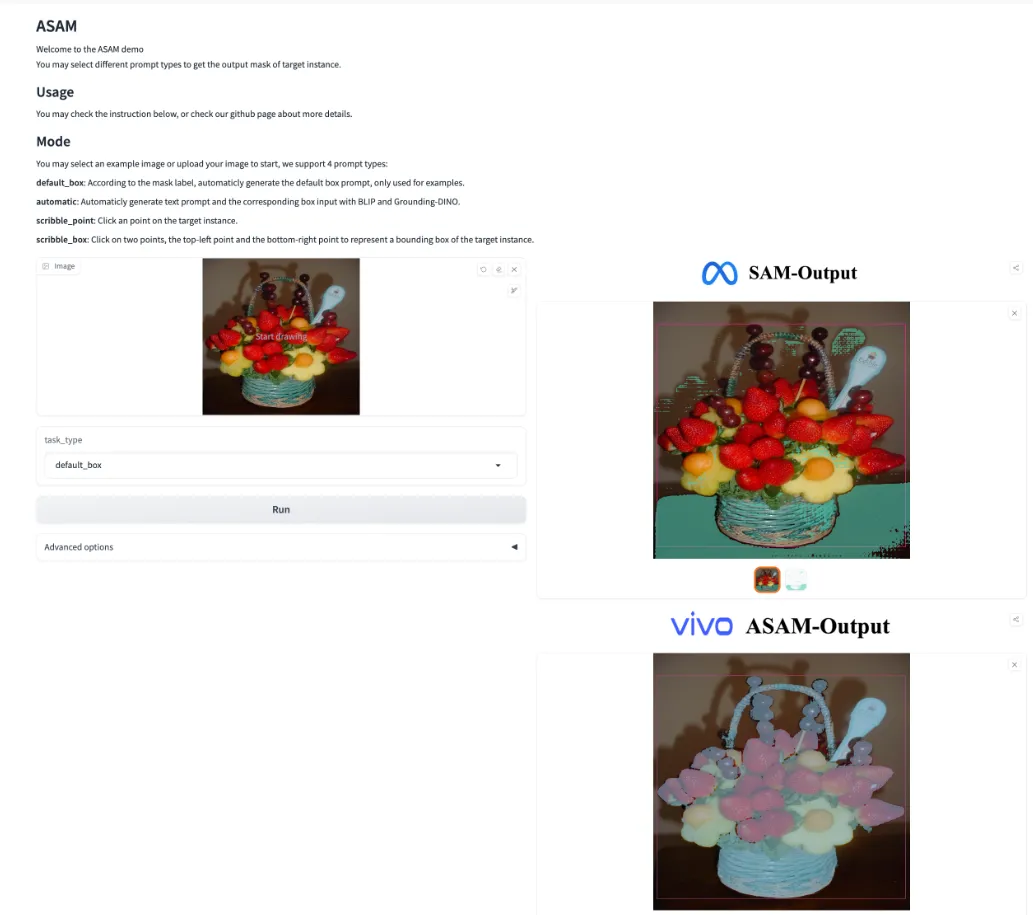

今天分析的是一種名為ASAM的新方法,它通過對抗微調來增強SAM的性能。研究者受到了自然語言處理領域成功應用自然對抗樣本的啟發,成功將地在計算機視覺里激發了這一方法的潛力。作者使用一個魯棒的擴散模型對SAM-1B數據集的一個子集(1%)進行了增強處理,生成了更能體現自然變化的、而非傳統的不易感知的干擾對抗樣本。ASAM保留了對抗樣本的視覺逼真性,并確保與原始的Mask標注對齊,從而維護了分割任務的完整性。微調后的ASAM在多種圖像分割任務上展現出了顯著的改進,而且不需要額外的數據或改動架構。作者的廣泛評估結果證明,ASAM在圖像分割任務中設立了新的性能基準,推動了計算機視覺領域基礎模型的進步。

PART/2 背景

基礎模型的概念在自然語言處理(NLP)領域以及近期計算機視覺領域的發展中起到了關鍵作用。這一概念源于NLP領域,具有里程碑意義的模型如BERT、GPT系列、LLaMA和PaLM,在未曾見過的任務對于零樣本泛化能力方面表現突出。這一成功促進了計算機視覺領域類似的范式轉換模型的發展。比如DINOv2、CLIP、BLIP、SAM以及Stable Diffusion等視覺基礎模型在多種任務上都展示了卓越的零樣本能力和廣泛的泛化能力。在這些模型中,專注于圖像分割的Segment Anything Model(SAM)因其獨特性脫穎而出。SAM在超過10億個Mask的龐大視覺語料庫上進行訓練,能夠分割各種場景中的多樣化目標和結構,為該領域帶來了革命性的變化。盡管表現印象深刻,但作為一個基礎模型,SAM在某些方面尚有改進空間。

這些挑戰引出了本項工作的核心動機:在不依賴額外數據、不更改基礎架構且不犧牲零樣本能力的條件下,如何進一步提升SAM作為基礎視覺模型的泛化性?于是,研究者便能在保持廣泛適用性的同時,釋放SAM的潛力。雖然現有解決方案在特定場景中有效,但并未根本上解決增強SAM內在性能的挑戰。

為了應對這一挑戰,研究者從NLP領域獲取靈感,尤其是基礎模型的研究。NLP中對抗訓練(AT)的獨特成功案例提供了新的視角。與視覺領域的常規對抗訓練通常需要在模型魯棒性和性能之間做出權衡不同,NLP中的對抗訓練不單強化了模型的魯棒性,也增強了其泛化能力和準確性。這一差異可能是因為NLP中的對抗樣本與現實世界中文本場景的相似性更高,例如常見的拼寫錯誤。研究者推斷,NLP中對抗訓練的成功得益于其生成樣本的“真實性”和“自然性”。這一見解引導研究者探索將NLP中成功的對抗訓練策略適用于視覺基礎模型像SAM這樣的模型的可能性。這種方法試圖創新性地利用跨領域的見解來改進計算機視覺中的特定任務。

將這一理念應用于SAM,ASAM以增強視覺基礎模型為目標,致力于利用類似于在NLP中發現的“自然”的對抗樣本。受到NLP中成功的優化方法的啟發,研究者提出使用這些更加“自然”的對抗樣本來微調SAM,從而避免了傳統對抗訓練通常伴隨的高成本問題。生成視覺對抗樣本的傳統方法通常依賴于范數約束,這導致產生的干擾并不自然,并且與真實世界的噪聲有著顯著不同。這種區別導致了這些對抗樣本與現實世界中的真實挑戰性情景之間的偏差。

為了生成既自然又逼真的對抗性樣本以微調SAM,研究者受到最新對抗性攻擊技術ACA, NeurIPS2023[1]的啟發,假設自然圖像能夠通過生成模型被投射到一個低維的流形上。這個通過自然圖像訓練而得到的流形確保了圖像的逼真性和內容的豐富性。通過將圖像映射到該流形,并在流形內沿對抗方向移動,研究者可以生成既自然又逼真的對抗性樣本。

PART/3 新框架

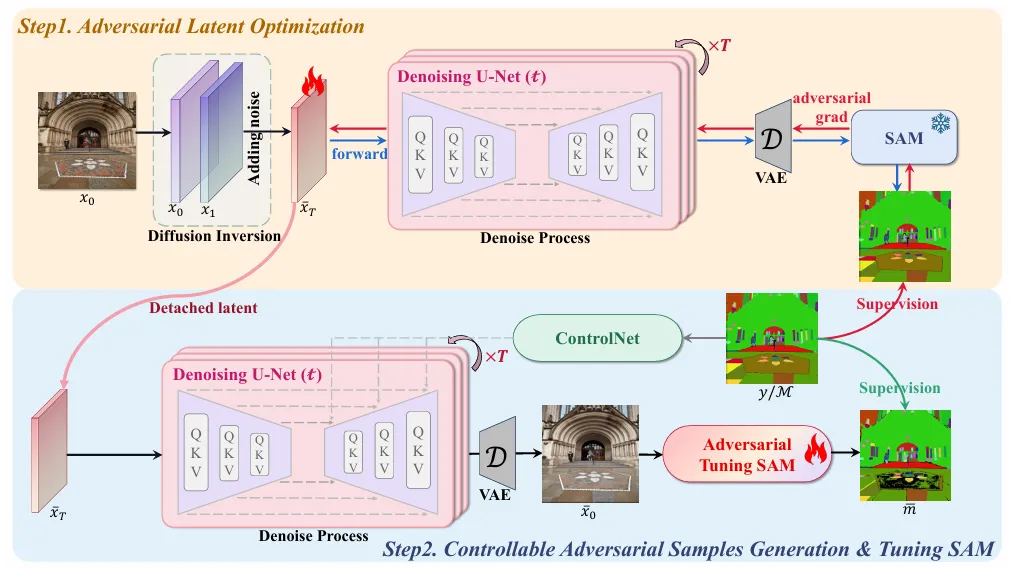

作者旨在從SA-1B 數據集中生成“自然”的對抗圖像,隨后使用這些生成的圖像及相應的SA-1B Mask 來微調SAM。注意,在微調SAM時,作者不改變SAM的結構,也不加入任何額外的標注數據。因此,作者提出的ASAM框架僅依靠其固有的數據和結構特性,實現了提高SAM泛化能力的目標。作者提出的ASAM框架主要包括兩個步驟,以下將詳細描述。

對抗隱變量優化。 現有的生成對抗圖像的方法通常遵循范數約束,導致產生的擾動并不完全自然,并且與真實世界的噪聲存在域偏移。在本文中,為了生成既自然又逼真的對抗樣本以調整SAM,作者假設自然圖像可以通過生成模型(如Stable Diffusion)首先投射到低維流形上。隨后,通過優化低維流形,作者能夠搜索到合適的對抗隱變量表示,從而有效地重新投射到自然圖像域。

可控對抗樣本生成。 上述優化過程對隱變量添加了輕微的擾動。因此,簡單的重新投射可能導致生成的對抗圖像與相應的SA-1B Mask 對齊不當。為了解決這個問題,在優化完成后,作者進一步設計了控制分支,它利用ControlNet來指導重新投射過程。

Projecting Image to Diffusion Latent

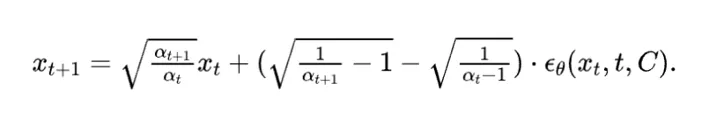

擴散反演通常用于將圖像投影到低維潛在空間。在擴散模型的情況下,作者采用了DDIM反轉技術,該技術利用來自提示P的條件嵌入,使用CLIP文本編碼器。

給定一個圖像 , 作者使用一個計劃 ,其中 。這種方法有效地在去噪過程的相反方向上操作(即 ,而不是 , 將圖像 投影到潛在空間的 。每張圖像的文本描述是通過 BLIPv2 生成的。

Adversarial Optimization of Latent

作者對潛在表示進行優化,以增強自然對抗圖像的生成。建立的潛在空間中,空文本嵌入確保了重建圖像的質量,而文本嵌入保留了圖像的語義內容。因此,同時優化這兩個嵌入可能不會導致最佳結果。考慮到噪聲在潛在空間中顯著包含了圖像的細節,作者選擇將優化工作集中在它上面。

Fine-tuning SAM with Adversarial Samples

與之前改變SAM結構的方法不同,作者的目標是增強SAM的整體能力,而無需進行任何結構修改。為微調選擇合適的參數需要仔細考慮,包括效率以及過擬合的風險等因素。在這方面,作者特別選擇對SAM的輸出標記和 Mask 標記進行微調,這部分參數僅占SAM總參數的大約。

此外,為了確保在保持泛化的同時,對對抗性樣本快速收斂,作者采用了在[24]工作中描述的學習率調度策略“慢啟動快衰減”。此外,作者提出的ASAM表明,僅使用SA-1B數據集的樣本就已經顯著提高了性能。

PART/4 實驗及可視化結果

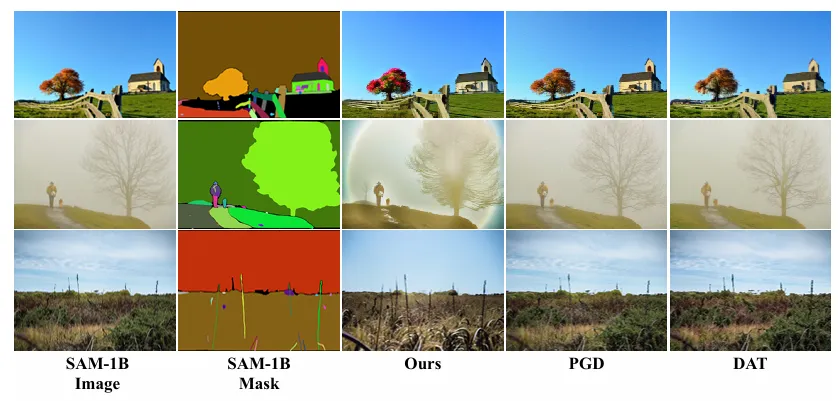

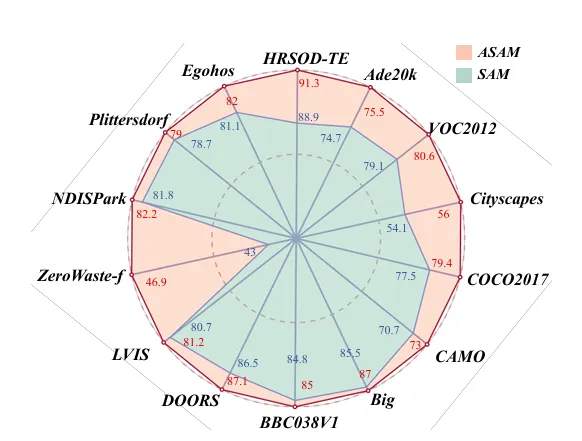

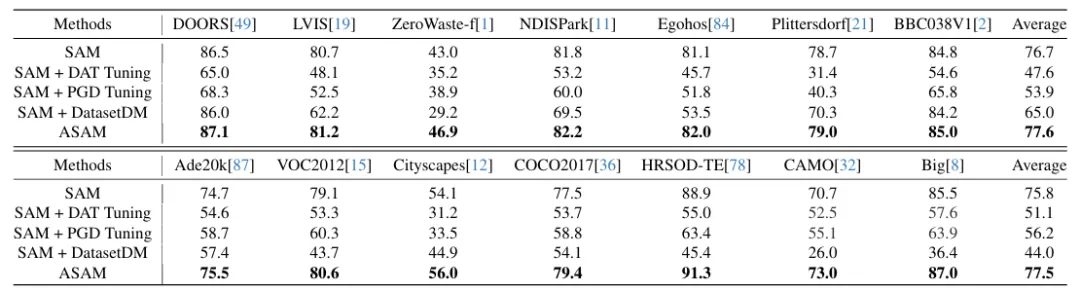

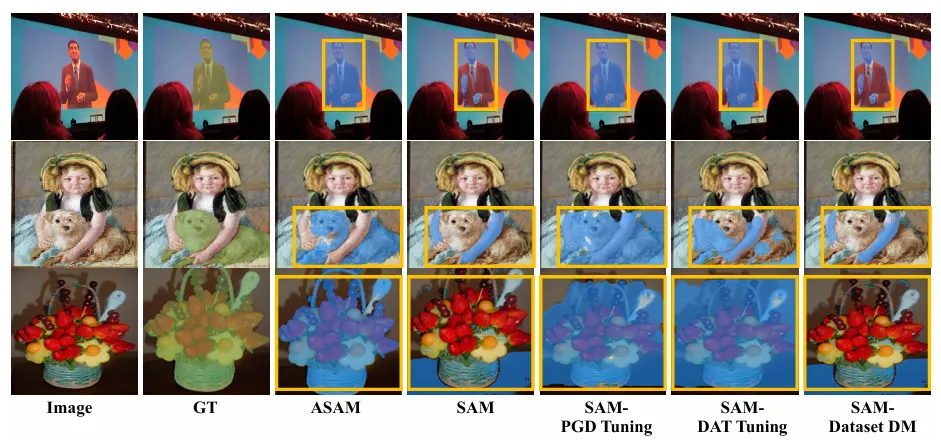

按照SAM,作者在訓練期間未見過的數據集和任務上評估ASAM。評估數據集可能包括新的圖像分布,例如水下或以自我為中心的圖像,據作者所知,這些圖像在SA-1B中并未出現。作者在mIoU評估下使用了一個包含14個數據集的新編系列,這些數據集具有多樣的圖像分布,如上表所示。

與PGD和DAT等現有方法不同,作者的對抗樣本是由一個經過優化、由SAM梯度引導的低維流形重建的。這種方法使作者能更有效地解決SAM原始訓練中的不足。它提供了一個更符合SAM學習范式的精細化輸入,使其能夠更有效地泛化到新或具有挑戰性的場景。從上圖的視覺比較中可以看出,作者提出的ASAM在原始SAM表現不佳的樣本上提升了性能。