小紅書去中心化內容分發技術

小紅書作為在國內因種草而聲名大噪的社區,伴隨用戶規模的擴大,已逐漸發展成為多元化的線上社區。眾多用戶通過筆記來記錄和分享自己的生活方式,當前每日可分發的內容多達數十億,每日新增發布的內容有數百萬之多,涵蓋圖文與視頻等形式,這些我們稱之為筆記。目前小紅書每日可產生數百億次的曝光量,每日超過一半的用戶在小紅書內產生互動行為,每日搜索查詢量達到億級。就產品形態而言,小紅書現分為雙列信息流和視頻沉浸流兩種。

一、業務背景介紹

1. UGC 社區

小紅書 UGC 社區與其他社區類似,主要由三個重要組成部分構成,分別是內容、消費用戶和創作者。這三者緊密相連,其中內容是作者與用戶之間的橋梁,若具備足夠豐富多樣的內容,我們就擁有廣闊的精細化分發空間。

中心化分發問題的本質在于曝光越多、活躍度越高的內容,往往能獲得更多的分發,致使普通創作者的內容分發效果相對較差。此外,用戶可能也會頻繁看到熱門興趣,導致自身中長尾興趣的內容所見相對較少。若要構建生態良好的社區,去中心化分發問題是需要解決的核心問題。

結合上述兩點,去中心化分發應從內容側與用戶側分別解決。對于內容側而言,應設法通過多種方式識別和引入筆記本身的更多信號,而非僅依賴用戶對筆記的行為進行分發。對于用戶側來說,應設法對用戶的興趣進行更優的挖掘,并在挖掘后予以一定的保護,鼓勵用戶中長尾和小眾興趣的內容分發,使用戶的興趣得到更全面的滿足。

2. 核心問題

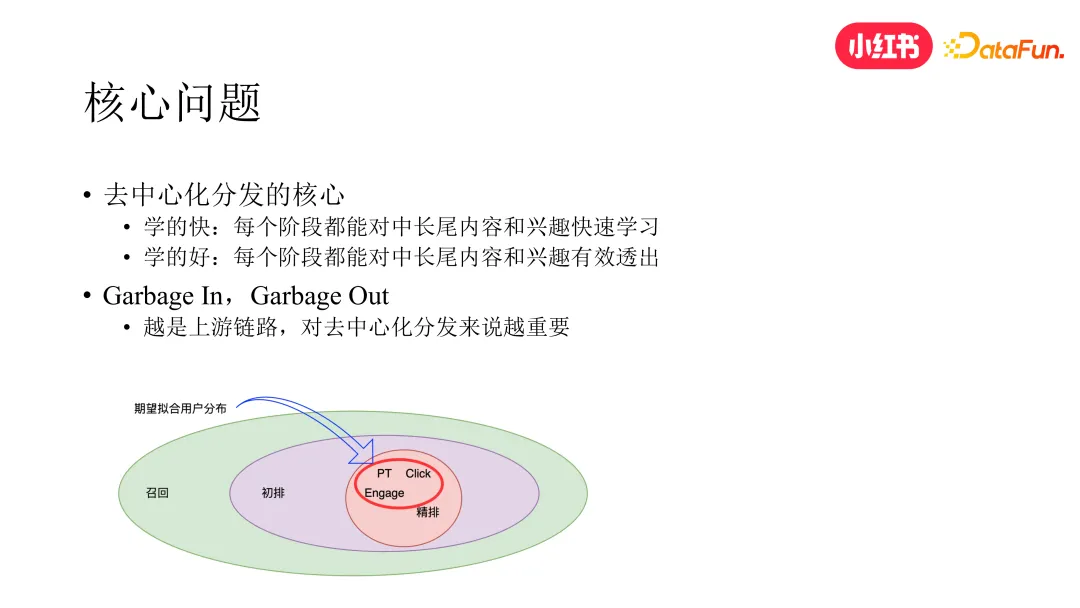

去中心化分發本質上就是要解決兩個問題,一方面是讓我們的系統學的更快,一方面是讓我們的系統學的更好。

- 學得快:整個系統鏈路學得更快,才能更快地捕捉到中長尾內容的信號和用戶中長尾的興趣。這對于內容冷啟動和用戶冷啟動也非常重要,如果一個新筆記在冷啟動階段就沒有得到很好的分發,那它就很難走到下一個階段。同樣的,如果一個用戶剛剛表現出一個新的興趣或者小眾的興趣,沒有被立刻捕捉到,這個用戶可能就會因為沒有看到自己想看的東西而流失。中長尾內容同理,也會導致作者的發布欲望下降。

- 學得好:光是學的快其實還不夠,因為中長尾興趣和內容的分發最終能不能滿足用戶和作者的要求,還要取決于系統學的好不好。想要做到這一點,必須要保證系統鏈路的每個環節對這些興趣和內容都能做有效的透出。如下圖所示,整個推薦系統包括召回、初排、精排、后排這幾個階段,推薦系統的目標是希望擬合用戶真實的興趣分布。在這方面,去中心化其實是個特殊的問題。過去推薦系統的核心動作是通過排序模型優化來將用戶的消費指標不斷做高,但用戶消費指標提高不一定意味著整個系統的去中心化分發變得更好了。下游的供給是來自上游的,如果上游給的內容就不好的話那下游怎么排也是排不好的,所以對去中心化分發這個問題,反而越是上游鏈路越重要。

舉例來說,曾經我在搞圍棋 AI 的時候遇到過一個問題,當時我們學習了一個 RL Policy,但這個模型經常到了 200 步之后就下的非常差。我們對這個模型本身做了很多的調整,但最后都沒有什么用處。后來我們發現問題出在 SL Policy 模型上,這個模型是通過人類棋手的監督數據學習而來的,但是對于人類的九段棋手來說,有很多高手在中盤就知道自己輸了,所以經常不會下到 200 步以后,導致這樣的數據很少,且噪音比較大,那基座就學不好這個信息,基于這個基座學習的下游模型效果也不會好,所以這是一個蠻重要的問題。

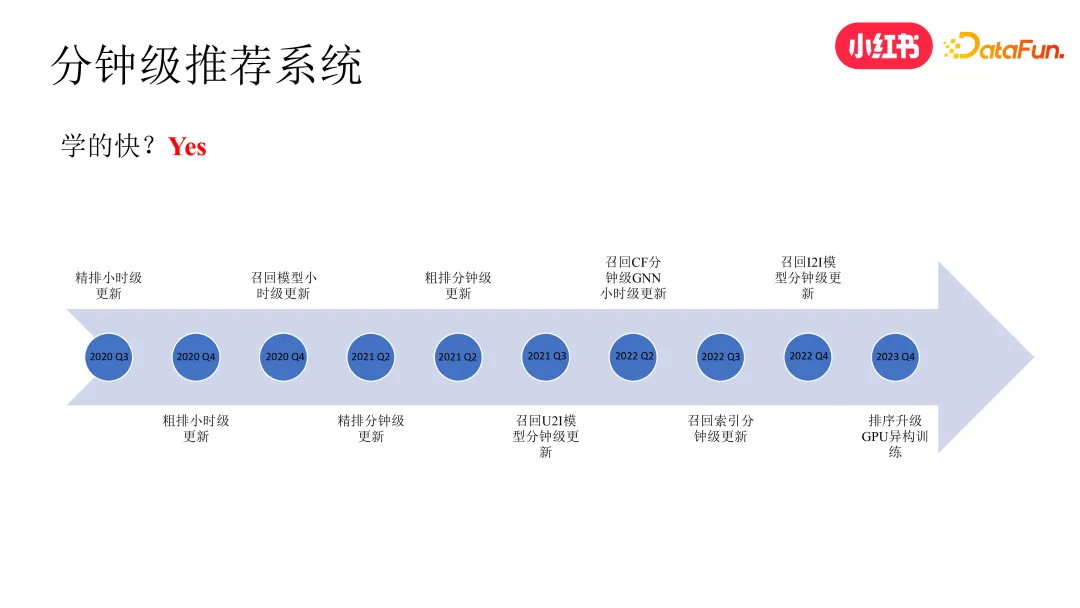

3. 高時效推薦系統 for“學的快”

小紅書在 2020 年 Q2 之前,推薦系統的主要模塊都保持在天級更新的狀態。為此我們經過兩年的持續迭代,通過數據流、訓練框架、索引框架的改造以及實時計算技術,先后把精排、粗排、召回模塊都做到了分鐘級更新的狀態。后來我們還進一步將初精排模型的訓練也升級到了 gpu 異構訓練的狀態,就是 cpu worker 和 gpu worker 也是分開的,這個可以進一步提高模型的更新速度。

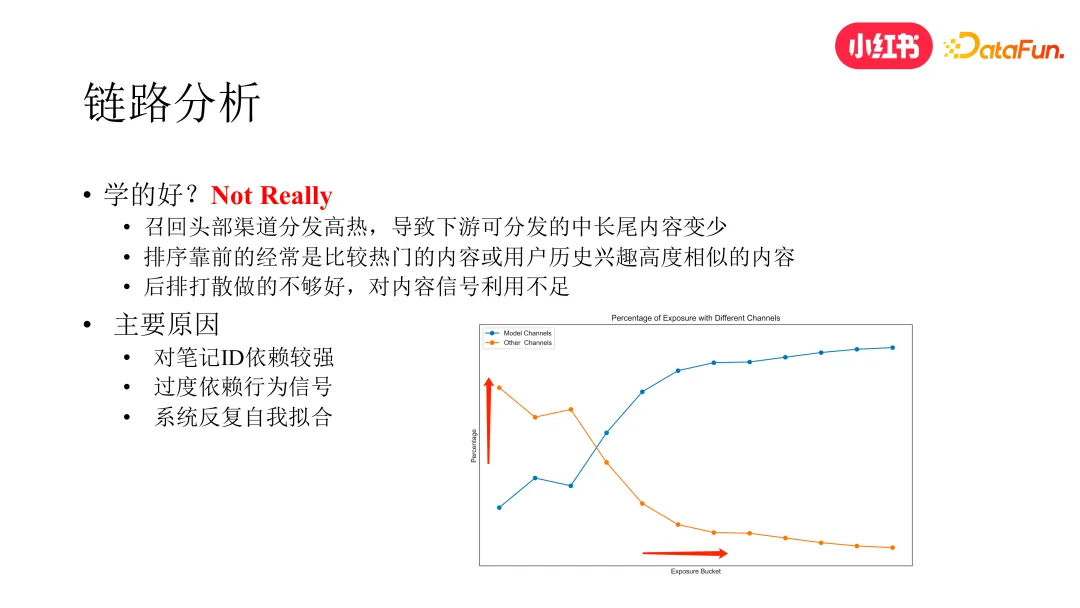

4. 鏈路分析 for“學的好”

經過對整個系統鏈路的分析,我們發現在“學的好”這個方面,很多模塊都是有優化空間的。

- 召回方面:我們對核心召回渠道做了一個曝光維度的分析,如下圖。橫軸是筆記按照曝光數的分桶,縱軸是不同召回渠道在不同曝光分桶上的分發占比。我們在召回方面上線了多目標、一致性、高精度等多路召回,時效性也都到了分鐘級,雖然整個大盤的消費指標是變好的,但數據分析顯示主要是在曝光比較高的區段變好的更多,在曝光比較低的區段表現仍是不好的,反而是其他的非頭部渠道在曝光比較低的分段區間表現的更好,而這些渠道多為純 CB 的召回渠道。

- 排序方面:我們發現如果我們不做任何干預,自然排名靠前的大多是比較熱門的或者是與用戶歷史興趣高度相似的內容,且新筆記排名并不高。

- 后排方面:高活用戶的歷史興趣存在扎堆的現象,即使通過筆記類目進行打散,也未獲得理想的效果,還會折損消費指標。

(1)原因分析

- 在當前模型的特征體系中,對筆記 id 本身的依賴過強

- 過度依賴用戶行為信號,雖然也用了一些內容信號,但對內容信號的學習和利用并不充分,未能有效發揮內容信號的作用

- 系統反復自我擬合,導致信息繭房問題

(2)解決思路:從內容側和用戶側分別來解決,雙向奔赴

- 特征側,除對筆記 id 特征的學習外,強化對 sideinfo 的利用

- 內容側,嘗試進行全鏈路的多模內容信號的引入

- 用戶側,系統性地加強用戶的興趣探索與保護

二、強化 Sideinfo 使用

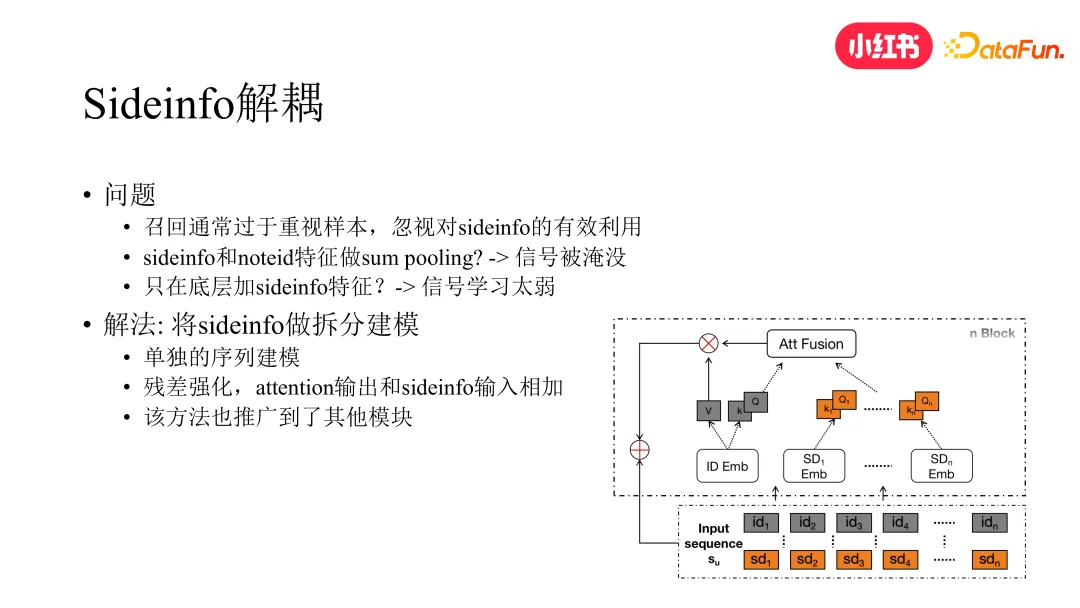

1. Sideinfo 解耦

考慮到召回是最上游的鏈路,對去中心化問題比較重要,我們首先從召回的角度嘗試優化了 sideinfo 的建模方式。在召回模型中,對 sideinfo 的使用通常比較簡單,一方面是直接作為模型最底層的特征輸入,但這樣會導致信號學習比較弱,另一方面是 sideinfo 的 embedding 通常會和筆記 id 的 embedding 做 pooling 融合,這樣會導致 sideinfo 信號被淹沒,不同的 sideinfo 之間區分不清晰。

為解決這個問題,最直接的方式就是將 sideinfo 進行單獨的拆分建模。拆分之后,除原本對用戶 lastn 的序列建模外,還會對 sideinfo 做單獨的序列建模。具體如下圖所示,我們先基于 Q 和 K 分別算出 id 和 sideinfo 維度的 attention score 后再與 V 相乘。此外,為進一步強化 sideinfo 信號的學習,我們引入殘差的做法,將 sideinfo 與 attention 的輸出結果相加,進一步提升 sideinfo 在整個模型中的影響力。此方法也推廣到了排序模塊。

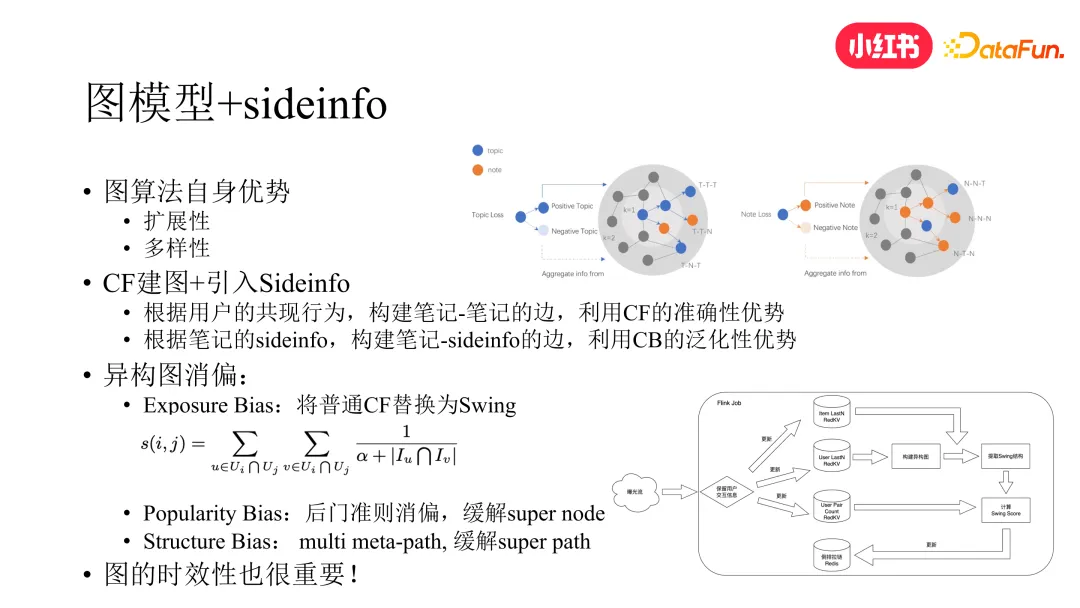

2. 圖模型融合 sideinfo

提到用戶興趣泛化與長尾內容泛化,就不得不提到圖模型,圖模型相較傳統算法主要優勢就在于其泛化能力和可擴展性,故引入圖模型來強化 sideinfo 的使用是一個很自然的做法。不過如果直接將 sideinfo 作為圖中的節點加入學習,難以直接取得理想效果。首先,若為純 content-based 的做法,在推薦系統被行為信號主導的情況下,下游的透出率無法保證。雖然我們可采取一些手段進行干預,例如通過中間鏈路進行保量強制其透出,但做法較為生硬,效果也比較有限。其次,若對圖上的數據不做任何干預直接進行學習,圖中會存在諸多的 bias,致使圖模型學習產生偏差。為此,我們從以下兩個方面進行優化。

首先,我們還是要想辦法將用戶的行為數據與純 CB 的數據進行融合。比較直接的做法就是從圖中的邊入手,我們可以采取 CF 的方法來構建圖中筆記到筆記的邊,同時根據筆記的 sideinfo 構建筆記到 sideinfo 的邊,這樣圖中就同時兼具了 CB 與 CF 兩種信號。

然后,在引入了基于 CF 的邊之后,需要面對的一個問題是 CF 本身存在 exposure bias 的問題,即標準 CF 通常比較偏向于出高熱的內容,這對中長尾內容其實是不友好的。因此我們將標準 CF 算法升級為 swing 算法。在 swing 算法中,如果一個中長尾內容被兩個用戶同時看過,而兩個用戶看過的筆記又比較少,即其興趣本身也較為長尾,那么根據 swing 公式的計算原理,不需要經過太多次的曝光,這兩個筆記的相似分數就會比較高,從而以更高的概率被召回。

此外,由于不同的 topic 關聯的筆記數量各異,就會導致少部分的 topic 連接著大部分的筆記,這又會引入 Popularity Bias。為此我們引入因果推斷中的后門準則做法,將 topic 視為 treatment,通過后門準則的消偏概率公式,對 topic 到筆記的邊權進行調整,緩解了所謂的 super node 的問題。而圖中除了 super node,還存在 super path,即在圖游走的過程中部分 path 會更頻繁的出現,這些 path 都放在一起學習也會導致頻率出現較低 path 的信號被湮滅。為此我們又引入了 multiple meta path 的做法,針對不同的 meta path(如t-> t->t、t->n->t、t->n->n、t->t->n等)通過不同的 mlp 網絡進行學習而非共享 mlp。不同的 meta path 對應的 mlp 的輸出 concat 之后再作為后續網絡的輸入,從而緩解了這個問題。

最后,我們發現圖的時效性也很重要,對算法效果能否有效地發揮也有很大的影響。而圖想要做到快速的更新是有挑戰的,業界很多公司也在做這方面的工作。就我們這個圖來說,圖中包括 CB 和 CF 兩種邊,CB 邊可迅速更新,但 CF 邊是通過 swing 計算得到的,而在小紅書的數據體量下,swing 全量計算是需要天級才能完成的。為解決這個問題,我們將 swing 算法從 batch 計算升級為 flink 流式計算,從而解決了這個問題。

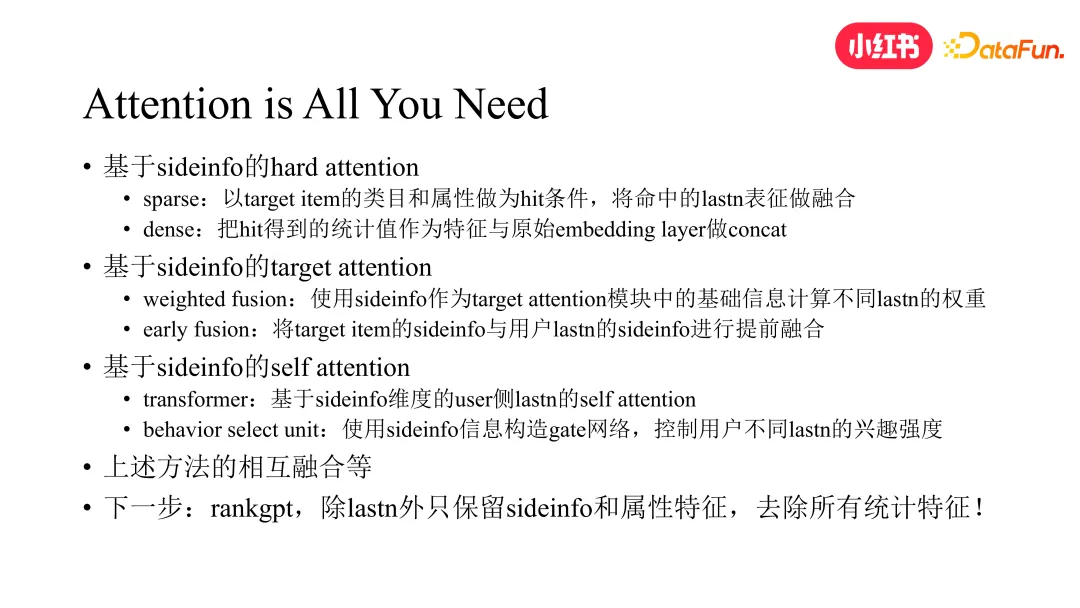

3. sideinfo 在排序中的應用

在排序中,sideinfo 主要是在各種 attention 中發揮作用,attention 分為 hard attention、target attention 和 self attention 幾種。

- hard attention 方面:通過 target item 的類目或屬性等 sideinfo 作為 hit 條件,將命中的 lastn 的表征進行融合,同時將 hit 作為統計值特征,與原始的 embedding layer 進行 concat 作為模型特征輸入的一部分。

- target attention 方面:將 sideinfo 作為 target attention 模塊中的基礎信息來計算不同 lastn 的權重,然后根據該權重對 lastn 的表征進行加權融合,同時對 sideinfo 做 early Fusion,即將 target item 的 sideinfo 在 attention 之前就與用戶 lastn 的 sideinfo 進行融合,使其學習更加充分。

- self attention 方面:基于 sideinfo 在用戶側內部做 self attention,同時以 sideinfo 構建 gate 網絡,來學習各自 lastn 的興趣強度。

- 最后,以上方法相互之間做融合,可取得更好的效果。而對 sideinfo 最極致的使用莫過于最近 meta 發表的 rankGPT 排序模型。在 rankGPT 中,user 側除 userid、基礎屬性特征以及 lastn 外,僅保留 sideinfo,其余的統計特征一概不用。在大數據 + 大模型的方案下,模型的效果最終超越了 meta 的基線模型,并驗證了 scaling law。其實關于這一點我本人也是比較看好的,在當年圍棋AI 的調研過程中我們就發現 20+ 特征的版本效果甚至優于 50+ 特征的版本。在那之后 AlphaZero 橫空出世,其特征僅寥寥數個,純靠自身進行 selfplay 學習,不知rankgpt是否受此啟發。所以在 sideinfo 這個維度上,我相信類 rankGPT 的方案最終是可以走通的。業界常說排序模型是特征的藝術,這個說法在未來的某一天可能會被徹底顛覆。

三、多模信號全鏈路融合

前面討論了 sideinfo 如何建模的問題,接下來我們從 sideinfo 本身的質量出發來強化中長尾內容和興趣的分發。相比類目、keyword、topic 等 sideinfo,多模表征也是 sideinfo 很重要的一種,且蘊含的內容信號更為豐富。在這個章節中我們介紹如何通過多模信號來強化 sideinfo 的表達能力,以及如何通過多種方式將其應用于我們的推薦系統。

首先提到一點,小紅書的多模態技術已經經過數輪迭代,從基于 CB2CF 的對比學習方案逐漸演變為基于大模型的方案,在 post-pretrain 階段,會引入下游的監督信號進行訓練,使多模態表征融合了行為信號,而非純內容信號本身。目前小紅書筆記的多模態表征已廣泛應用于小紅書的多個場景。

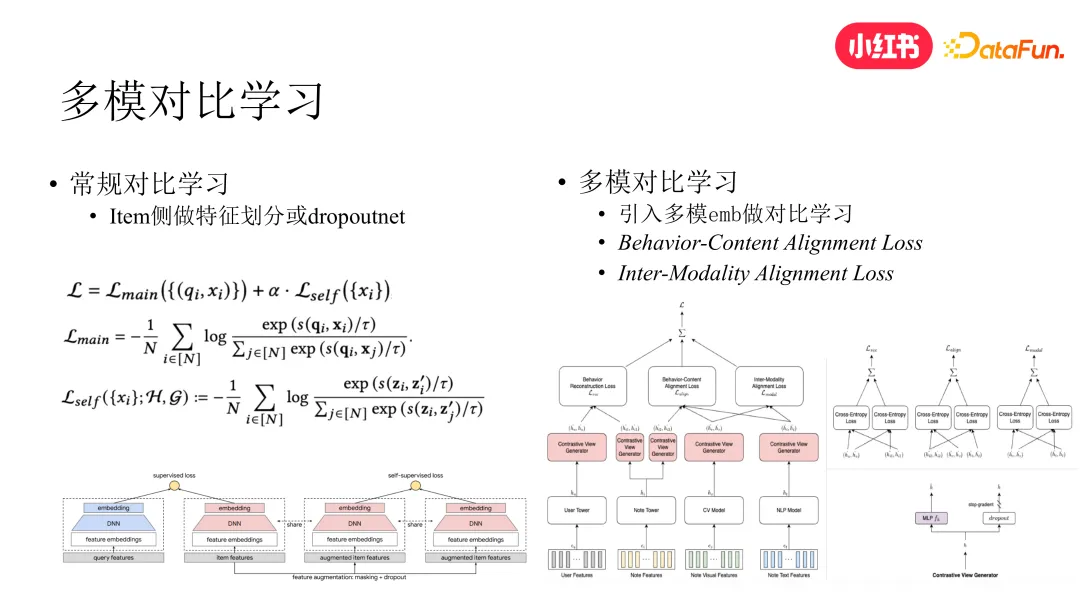

1. 多模對比學習

首先,使用多模信號不一定非要通過加特征的方式,我們試過直接在模型底層加特征,發現效果比較一般,這個和上面 sideinfo 解耦部分提到的問題類似,因此我們嘗試了對比學習的方案來進行多模信號融合。

常規的對比學習,通常是對 item 的特征進行劃分或 dropout,對同一個 item 的兩個表征進行對比學習,以強化中長尾筆記的分發,但該方案并未引入額外的內容信號,因此主要還是在依賴行為信號進行學習。我們在此基礎上引入多模信號,并將對比學習的方案進行升級。我們直接將多模 embedding 與常規雙塔召回中的 item embedding 進行 alignment。整個方案分為域內 alignment 和跨域 alignment 兩部分,域內是指筆記的 text 和 image 的 embedding 進行內部 alignment,跨域是指將筆記 text 和 image 的 embedding 與 item 塔輸出的 item embedding 進行 alignment。加上原本 u2i 模型中 user embedding 與 item embedding 的 alignment,三個 loss 進行聯合訓練,取得了比單純在模型底層添加多模表征更好的效果。此方案參考了 NIPS 2020 deepmind 的一篇工作。

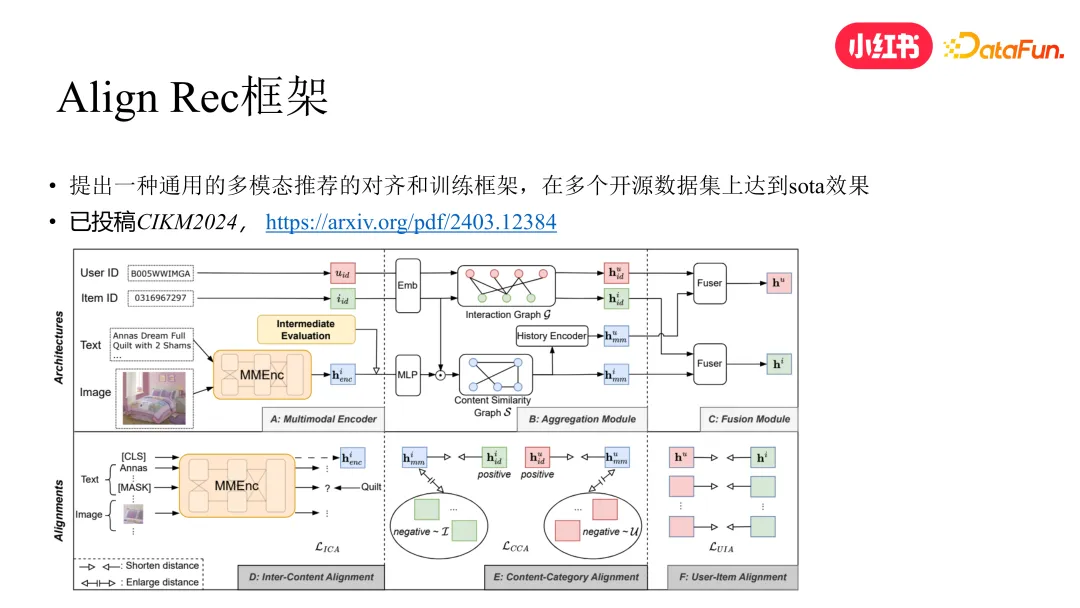

2. AlignRec 框架

受此上面工作的啟發,我們進一步提出 AlignRec 框架,此框架在上述方案基礎上更進一步,提出一個更通用的多模態推薦框架。該方案在多個開源數據集上達到了 SOTA 效果,目前已被 CIKM 2024 Full Research Paper Track 接收。整個框架分為以下幾個階段,具體見下圖:

(1)通過 MMEnc 模塊將 text 和 image 的 embedding 內部進行對齊與融合,得到 item 在內容側的表征。

(2)對 user 和 item 的行為側原始表征基于 user 與 item 的行為圖做融合。

(3)內容側的 item 表征會先和行為側的 item 表征做 Fusion,然后基于內容側 item 表征的相似度構建圖來對 fusion 后的 item embedding 做 aggregation 得到 item 的內容聚合表征,然后 user 側會根據 user 和 item 的行為圖做聚合,得到 user 在內容維度的聚合表征。

(4)user 和 item 的行為聚合表征分別和內容融合表征做 alignment 作為輔助 loss。

(5)user 和 item 的行為表征和內容表征各自相加,得到 user 和 item 的跨域融合表征并做最終的 alignment。

3. 多模特征交叉

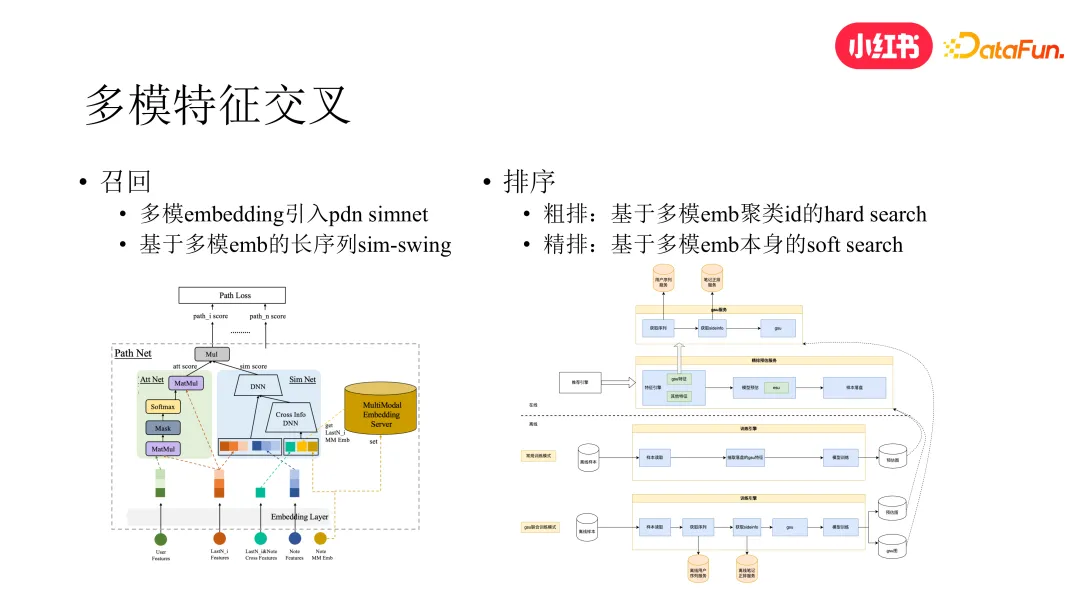

由于多模表征作為特征直接加在模型底層效果微弱,因此我們對多模在底層的使用方式進行了探索,包括召回和排序模塊。

(1)召回方面

- 在過去我們上線了 pdn 召回,該路召回的亮點是做了 u2i 和 i2i 的聯合建模,但分析發現它的內容分發仍然偏向于頭部內容。因此,我們對 pdn 召回做了升級。我們將 trigger net 部分改成了 attention 結構,同時在 simnet 部分引入了筆記的多模信息,即通過查表的方式得到用戶 lastn 和 target item 的多模表征,作為 simnet cross dnn 的輸入,通過特征交叉的方式在 simnet 的學習過程中引入多模信息。升級后的 pdn 對于中長尾內容和興趣的分發效果提升顯著,并帶動了大盤的消費指標。

- 此外,我們還做了基于多模表征的長序列 swing 算法。前面提到,我們把 swing 升級到流式計算后,由于不能全量計算,只能保留用戶近期的 lastn,導致算法對用戶長期信號的捕捉變弱。為緩解這個問題,同時考慮到性能,我們做了類似排序 sim 的做法,首先基于多模 embedding 從用戶長期行為序列中檢索出跟 target item 比較相似的 lastn,然后將得到的結果和原始的 online swing 放在一起同時做訓練,對用戶中長尾興趣和長期興趣的捕捉取得了不錯的補充效果。

(2)排序方面

- 初排方面,考慮到初排的線上性能壓力,直接通過多模表征做相似檢索的性能是難以接受的,所以在初排我們是通過多模 embedding 聚類得到的聚類 id 對 user lastn 做 hard search 來進行多模特征交叉

- 精排方面,直接用多模 embedding 來做 soft search。我們設計了 GSU+ESU 的架構,在離線訓練時用戶 lastn 通過本地靜態表的方式接入筆記的多模 embedding 進行訓練,模型導出時會導出成 GSU 和 ESU 兩張子圖在線上分別做部署。GSU 子圖放到線上后,特征引擎通過 RPC 的方式調用 GSU 服務,GSU 在圖內基于 target item 的多模 embedding 對用戶 lastn 的多模 embeddings 做檢索,得到最相似的 topk lastn,然后再將 topk lastn 及其相關特征送入通過 ESU 子圖做 attention 建模。

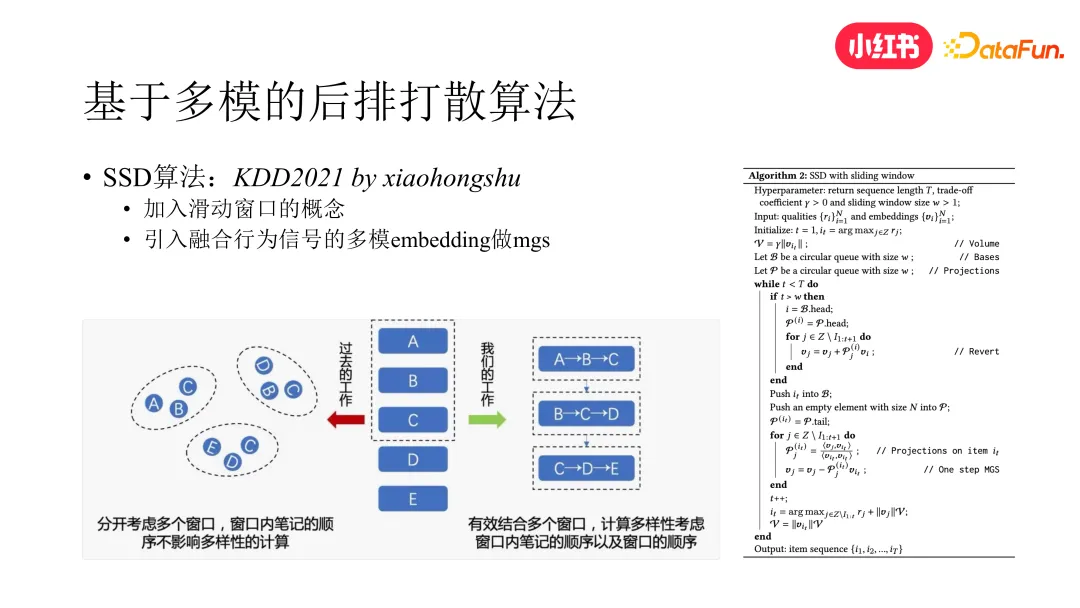

4. 基于多模的后排打散

在業界通常會有個認知,后排打散通常會帶來消費指標的損失,但我們驗證下來之后發現,多樣性的提高和消費指標的提升其實是不沖突的,如果出現蹺蹺板效應,那還是因為打散沒有做到個性化的多樣性。

我們在 KDD 2021 上提出了一種解法。該做法包括兩方面,一是加入滑動窗口的概念,二是引入融合行為信號的多模 embedding。滑動窗口有效地結合了多個窗口,我們把窗口之外的筆記先通過逆 MGS 的方式做向量還原,然后對窗口內部筆記的 embedding 重新做 MGS 分解,得到當前位置的候選筆記的 embedding,再根據該 embedding 計算與前面內容的相似度,并結合當前內容的相關性分數最終確定當前位置選擇哪個筆記。可以看出,筆記 embedding 的質量對這個算法是非常重要的。如果我們基于純 CB 的 embedding,由于 embedding 中沒有行為的信號,直接做打散就會對消費指標帶來負向的影響。因此我們通過對比學習的方式,提前得到了融合行為信號的多模 embedding。后來我們對該算法使用的多模 embedding 再次做了升級,又帶來了多樣性和消費指標的雙提升。

四、興趣探索及鏈路保護

上面介紹了從內容側來解決去中心化分發問題的一些工作,接下來我們介紹下在用戶側解決該問題的一些思路。從用戶角度來說,看不到中長尾興趣的內容,有很大的原因是因為系統總是在擬合用戶的歷史興趣。想要打破這一點,就需要引入興趣探索和興趣保護的能力。

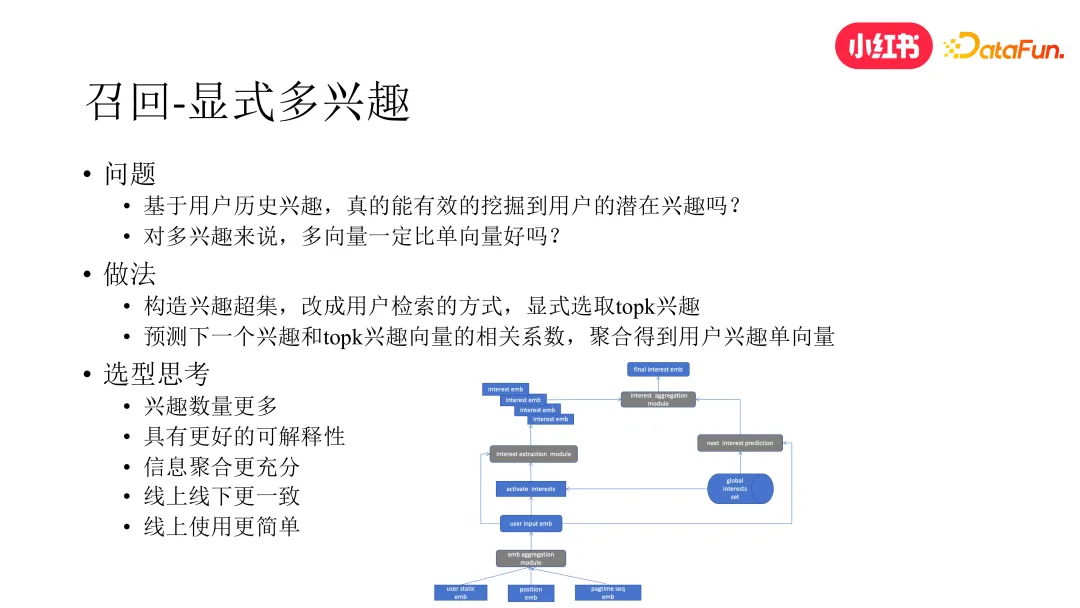

1. 顯式多興趣

首先還是從召回模塊入手,多興趣模型是召回階段做用戶興趣探索的常用手段之一。我們曾嘗試了一些基于多向量的多興趣做法,包括 mind、comirec 等,但在多樣性和中長尾內容分發方面沒有得到理想的效果。經過分析我們發現:其一,若直接基于用戶的 lastn 做聚類,本質上還是在完全依賴用戶的歷史興趣做建模,而用戶的潛在興趣在用戶的歷史行為中還比較弱勢,不進行顯式的挖掘很難直接獲取。其二,多興趣不等于多向量,多向量的效果也未必優于單向量,還會引發一些其他問題,例如會導致線上性能壓力升高,限制探索興趣的數量。其三,多向量的做法還是很難做到精準的個性化,同一用戶的不同向量所代表的興趣難以顯式區分和解釋,不同用戶的多向量所代表的興趣也難以做到全局概念上的對齊。

為此,我們反其道行之,相較于隱式挖掘多興趣,我們改為顯式挖掘的方式。具體來說,我們先構建一個客觀存在的全局興趣集合,這樣興趣集合中的每一個向量都代表著一個相對明確的興趣。然后我們通過檢索的方式,基于用戶 lastn 從這個興趣超集中顯式選取 topk 的興趣。接下來我們預測用戶的下一個興趣與當前所選擇的 topk 興趣向量的相關系數,然后聚合得到用戶的興趣向量,最終只將該單向量應用于線上。這種做法從性能和效果來說都取得了比較理想的效果,且具有更好的可解釋性。

2. EE 興趣探索

說到興趣探索,就不得不提及 EE。目前工業界 EE 方面的工作大多都在更靠近用戶的后鏈路展開,因 EE 如果做在前鏈路,受到下游鏈路的影響,最終對用戶的實際影響會受到較大的削弱。然而,對去中心化分發問題來說只在后鏈路做 EE 是不夠的,如果只是做在后鏈路,那一個很大的問題是若前鏈路下發的用戶中長尾興趣的內容本身就很少,那么探索的天花板就比較低,因此我們需要在前鏈路就設法通過 EE 將用戶中長尾興趣的內容挖掘出來。但僅在上游鏈路完成探索,下游鏈路若沒有有效承接,還是會導致整個 EE 的效率比較低。

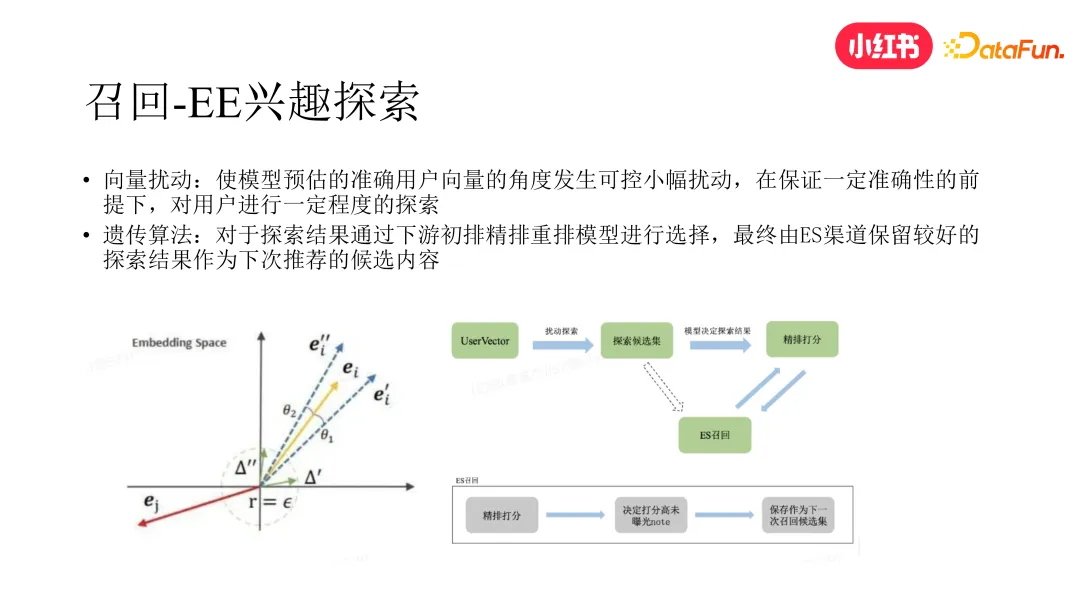

為兼顧以上兩個問題,我們提出了一種新的 EE 做法。

- 首先,我們在召回階段對用戶的召回向量表征加一些高斯噪音擾動,獲取一個新的召回向量,得到相應的召回結果。

- 然后,我們采用了基于 Evolution Strategy 的策略,將下發未曝光但在下發排名較高的當次探索內容進行保存,參與后續的召回。在這個過程中,我們將召回模塊作為交叉再生算子,將初排和精排漏斗當作遺傳選擇算子。在下一次召回時,會從前n 代最后下發的頭部筆記中選取未得到曝光的那些探索筆記,作為結果重新參與召回的再生。

我們發現這種系統性的 EE 做法,相較于單純在召回階段對向量擾動做 EE,對整個系統在中長尾興趣的內容分發方面產生了更顯著的影響。

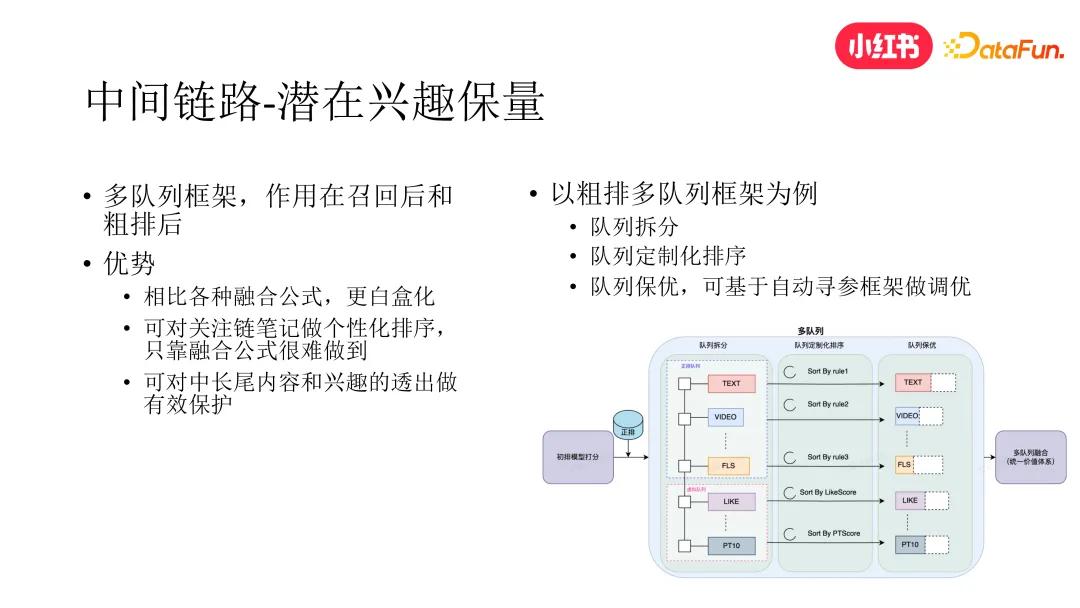

3. 中間鏈路興趣保量

受到 EE 做法的啟發,我們發現除了興趣探索之外,中間鏈路的興趣保量也很重要,只探索不保護會導致興趣探索最終無疾而終。從召回階段的興趣挖掘,再到最終曝光給用戶,推薦系統中間會經歷召回進初排、初排進精排等多個階段。在興趣保護方面,已有的做法大多是通過調整初精排的融合公式來對那些希望最終能展現給用戶的內容做一些提權,但這種做法有兩個比較大的短板。首先這種做法比較黑盒,對系統全局的影響不得而知。其次,某些特殊需求無法通過融合公式的調整直接做到,比如關注渠道是對中長尾內容和興趣有效分發的渠道之一,如果我們想要單獨調整某次下發中關注鏈筆記集合的內部序,通過全局的融合公式很難做到。

為此,我們構建了白盒化的多隊列保量框架,來和黑盒化的融合公式做互補。以初排進精排階段的多隊列為例(召回進初排我們也加入了多隊列框架),我們從多個維度對初排進精排的筆記進行了隊列拆分,每個隊列內部可以進行定制化排序,這樣就能解決前面所說的關注鏈筆記個性化排序無法實現的問題。再者,每個隊列可進行獨立的截斷,目前我們已經實現了一套基于 Evolution Strategy 的自動尋參工具,可通過該工具對每個隊列的截斷值進行超參自動尋優。

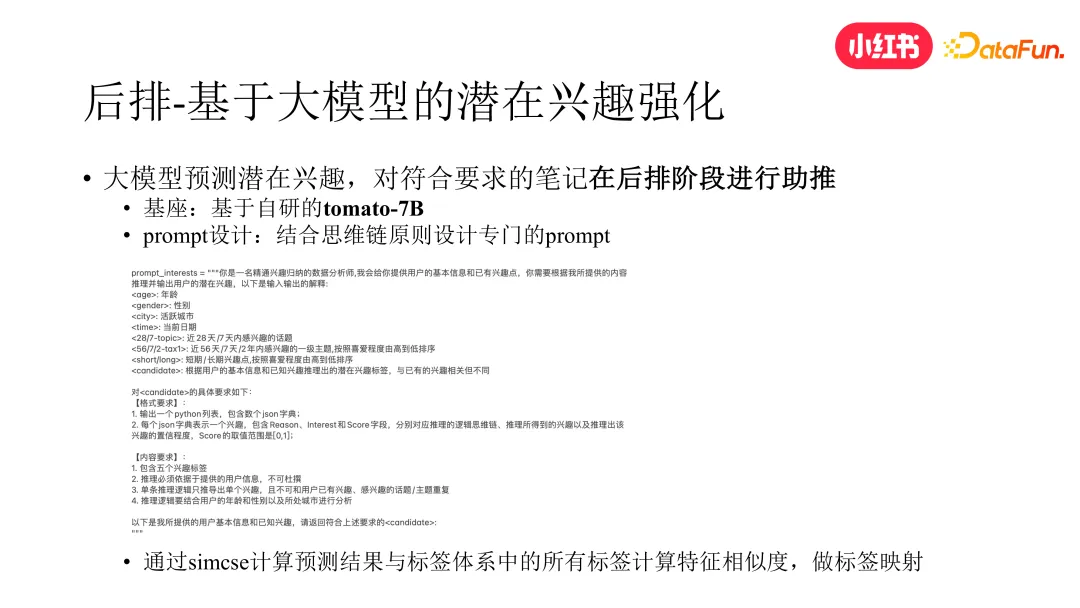

4. 基于大模型的潛在興趣挖掘與強化

最近一年大模型技術正在引領一場新的技術革命,大模型對于大多數問題的理解能力遠遠超過許多傳統的模型,因此展現出在興趣挖掘方面強大的潛力。鑒于大模型的性能要求很高,直接將其作為在線模塊用于用戶的興趣探索目前并不現實。為此小紅書采取了一種折中的辦法,首先基于 COT 原則設計了專門的 prompt 構造用戶畫像,然后通過小紅書自研的大模型基座 tomato-7B 離線預估用戶的潛在興趣,將得到的結果通過 SIMCSE 模型與已有的標簽體系做映射,最終對命中標簽的筆記在后排階段給予助推,從而和前鏈路的興趣探索和興趣保量一起,形成用戶興趣挖掘的閉環。

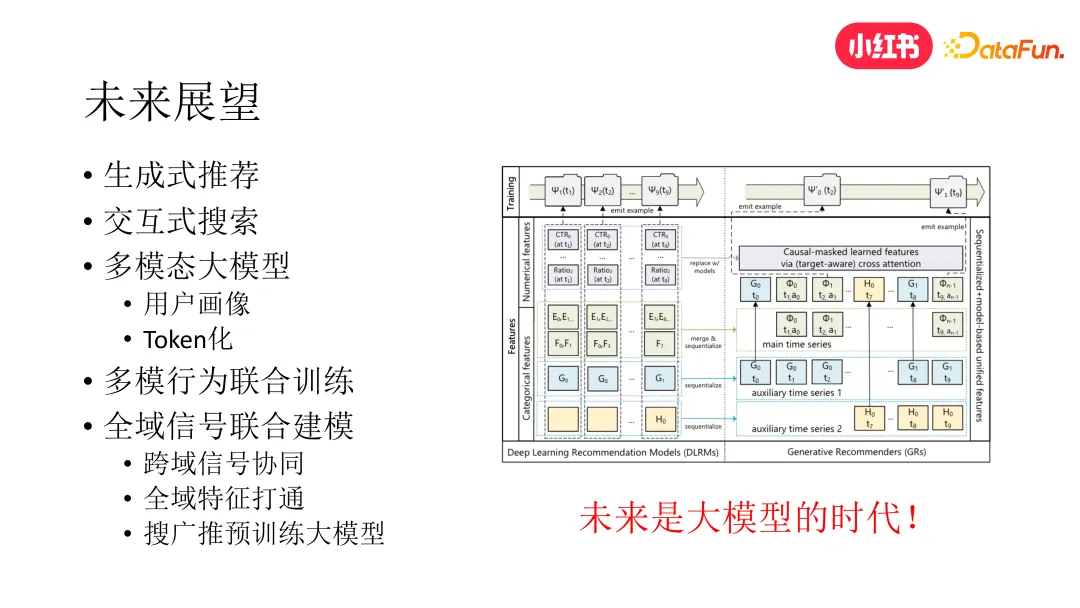

五、未來展望

未來在去中心化問題上仍然存在許多工作可以開展,主要分為以下幾個方面:

- 生成式推薦:相較于傳統的判別式推薦,生成式推薦具有更強的多樣性和泛化能力,目前生成式召回和排序的工作我們已在探索中,并取得了階段性的結果。

- 交互式搜索:基于大模型技術,以多輪對話的方式更全面細致地捕捉用戶意圖和挖掘用戶興趣,返回令用戶有驚喜感的內容。

- 多模態畫像:將用戶的個人信息和歷史行為輸入預訓練的多模態大模型得到用戶畫像,通過 token 化技術提取圖片中的筆記畫像,將用戶畫像和筆記畫像作為推薦各模塊模型的輸入。

- 多模態聯合訓練:傳統多模態推薦通常采取預訓練+finetune 兩階段的做法,可嘗試直接做 end2end 的多模態和行為聯合訓練,這也是個值得探索的方向。

- 全域信號聯合建模:通過搜廣推全域預訓練大模型或全域圖模型,打通全域信號,捕捉用戶在整個 app 上的行動軌跡,更全面地挖掘和學習用戶全域興趣。

今天主要是圍繞去中心化分發這個話題分享了小紅書在這方面的部分工作,除此以外小紅書還有很多在推廣搜和大模型方面的工作,時間原因不做進一步展開。