NeurIPS 2024 | 消除多對多問題,清華提出大規(guī)模細粒度視頻片段標注新范式VERIFIED

陳厚倫,清華大學計算機系媒體所的二年級博士生,主要研究方向是多模態(tài)大模型與視頻理解 ,在 NeurIPS 、ACM Multimedia 等頂級會議發(fā)表多篇論文,曾獲國家獎學金、北京市優(yōu)秀本科畢業(yè)生等。

視頻內(nèi)容的快速增長給視頻檢索技術(shù),特別是細粒度視頻片段檢索(VCMR),帶來了巨大挑戰(zhàn)。VCMR 要求系統(tǒng)根據(jù)文本查詢從視頻庫中精準定位視頻中的匹配片段,需具備跨模態(tài)理解和細粒度視頻理解能力。

然而,現(xiàn)有研究多局限于粗粒度理解,難以應(yīng)對細粒度查詢。為此,來自清華大學的研究者提出自動化視頻 - 文本細粒度標注系統(tǒng) VERIFIED,并基于此系統(tǒng)構(gòu)建新的細粒度 VCMR 基準數(shù)據(jù)集(Charades-FIG、DiDeMo-FIG 和 ActivityNet-FIG),以推動細粒度視頻理解的發(fā)展。

- 論文題目:VERIFIED: A Video Corpus Moment Retrieval Benchmark for Fine-Grained Video Understanding (NeurIPS 2024 Track on Datasets and Benchmarks)

- 論文鏈接:https://arxiv.org/pdf/2410.08593

- 主頁鏈接:https://verified-neurips.github.io/

一、介紹

視頻語料庫時刻檢索(VCMR)旨在根據(jù)文本查詢從大量視頻中精確定位特定片段。傳統(tǒng) VCMR 基準的視頻標注多為粗粒度標注,視頻與文本間存在多對多問題,無法支持細粒度視頻檢索的訓練與評估(圖 1 (a)),因此有必要為細粒度 VCMR 建立一個合適的 benchmark。為解決此問題,該研究提出了細粒度 VCMR 場景,使用更精細的文本查詢消除數(shù)據(jù)集中的多對多現(xiàn)象(圖 1 (b))。然而建立此類細粒度的 benchmark 有如下的挑戰(zhàn):

(1)人工標注細粒度信息成本高昂,是否可以利用大模型技術(shù)實現(xiàn)這一過程?

(2)研究證明大模型存在幻覺問題,如果利用大模型進行標注,如何設(shè)計一種方法保證標注數(shù)據(jù)的質(zhì)量?

為此,該研究設(shè)計了自動細粒度視頻標注系統(tǒng) VERIFIED(圖 1 (c)),通過大模型生成富含靜態(tài)和動態(tài)信息的標注,并且基于微調(diào) video foundation model 設(shè)計了一個高效的標注質(zhì)量評估模塊,基于此構(gòu)建了 Charades-FIG、DiDeMo-FIG 和 ActivityNet-FIG 高質(zhì)量細粒度 VCMR 基準,以推動細粒度 VCMR 研究發(fā)展。

圖 1:a) 粗粒度 VCMR 中,因查詢文本簡單,存在許多潛在正匹配(綠色),但這些時刻未被標注,導致真實標注不合理。b) 該研究提出的具有挑戰(zhàn)性的細粒度 VCMR 中,查詢更細粒度,方法需要從部分匹配的候選項(粉色)中檢索出最匹配的一個(綠色)。c) 該研究的 VERIFIED 生成了可靠細粒度標注,包括豐富靜態(tài)(綠色)和動態(tài)細節(jié)(藍色)。

二、VERIFIED 視頻細粒度標注系統(tǒng)

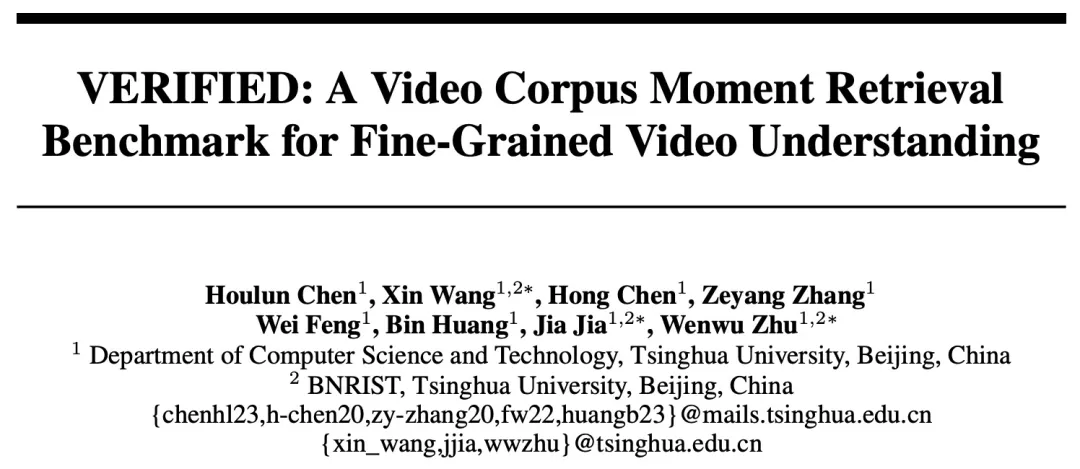

圖 2:VERIFIED 流程圖。Statics Enhanced Captioning(A)和 Dynamics Enhanced Captioning(B),它們生成帶有靜態(tài)和動態(tài)細節(jié)的多個細粒度描述候選。此外,該研究設(shè)計了一個 Fine-Granularity Aware Noise Evaluator(C),該模塊生成并選擇被擾動的正負樣本,通過難負樣本增強的對比損失和匹配損失來微調(diào) UMT。這個評估器對描述進行評分,以識別不準確描述。

圖 2 展示了該研究的 VERIFIED 標注流程圖。為了讓大模型像人類那樣對視頻中的細粒度信息進行標注,該研究設(shè)計了 Statics Enhanced Captioning 和 Dynamics Enhanced Captioning 模塊,分別對靜態(tài)與動態(tài)細節(jié)進行描述。靜態(tài)信息增強模塊通過提取視頻關(guān)鍵幀,分析前景和背景屬性,生成多個靜態(tài)細粒度描述,豐富視頻的靜態(tài)視覺信息。動態(tài)信息增強模塊則根據(jù)視頻的一個粗粒度標注,首先由 LLM 生成與視頻動態(tài)內(nèi)容相關(guān)的問題,使用視頻問答系統(tǒng)(VQA)獲取動態(tài)細節(jié),進而生成多個動態(tài)細粒度標注,幫助模型更好地理解視頻中的動作和變化。

為了保證數(shù)據(jù)標注的質(zhì)量,該研究設(shè)計了一個細粒度感知的噪聲評估模塊,其目的在于從前面模塊標注的數(shù)據(jù)中,篩選出可靠的細粒度標注,主要通過以下步驟進行:

(1)擾動文本生成:評估器首先從原始粗粒度標注中生成正向和負向的擾動文本。這些文本通過引入難例(挑戰(zhàn)樣本)與原始標注進行對比,以提高模型對細粒度差異的敏感度。

(2)篩選最優(yōu)擾動:通過使用預訓練模型(如 SentenceBERT),評估器從生成的擾動文本中挑選最合適的正向改寫和最具挑戰(zhàn)性的負向改寫,保證生成的文本與原始標注的語義距離合理。

(3)損失函數(shù):引入上述正向和負向的擾動文本,計算文本和視頻間的對比損失和匹配損失。引入正向擾動文本是為了防止 LLM 生成文本的潛在的 bias,引入負向擾動文本作為困難負樣本增強模型對細粒度信息的感知能力。

最后該研究用這個模塊對標注數(shù)據(jù)進行打分,用來作為數(shù)據(jù)篩選的標準。該研究將 VERIFIED 系統(tǒng)應(yīng)用于 Charades-STA、DiDeMo、ActivityNet Captions 數(shù)據(jù)集,對每個視頻片段篩選分數(shù)最高的標注,得到新的 Charades-FIG、DiDeMo-FIG、ActivityNet-FIG 數(shù)據(jù)集,作為細粒度 VCMR 的 benchmark。

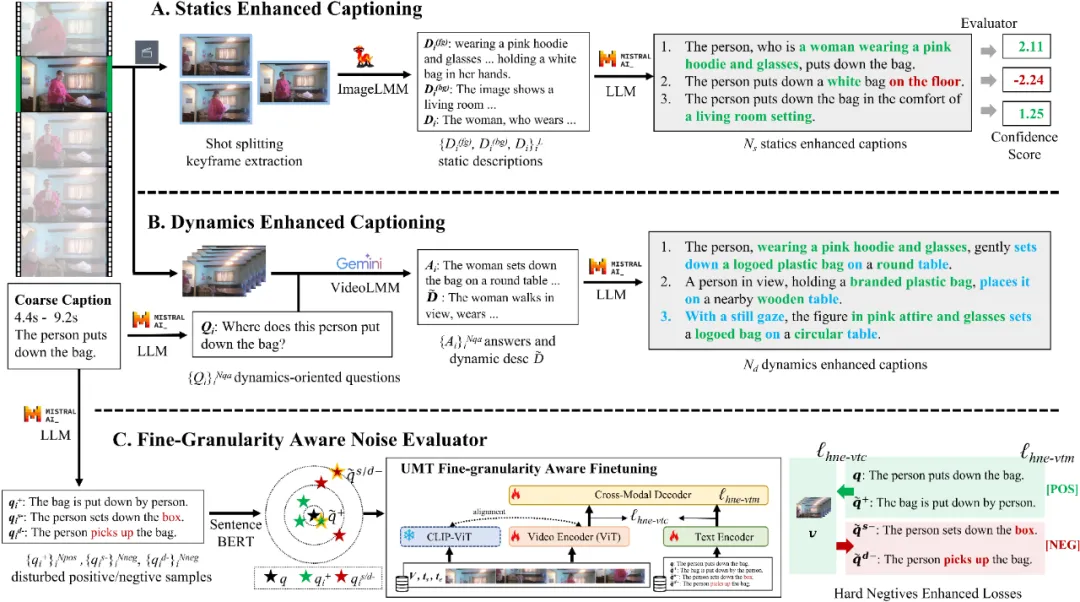

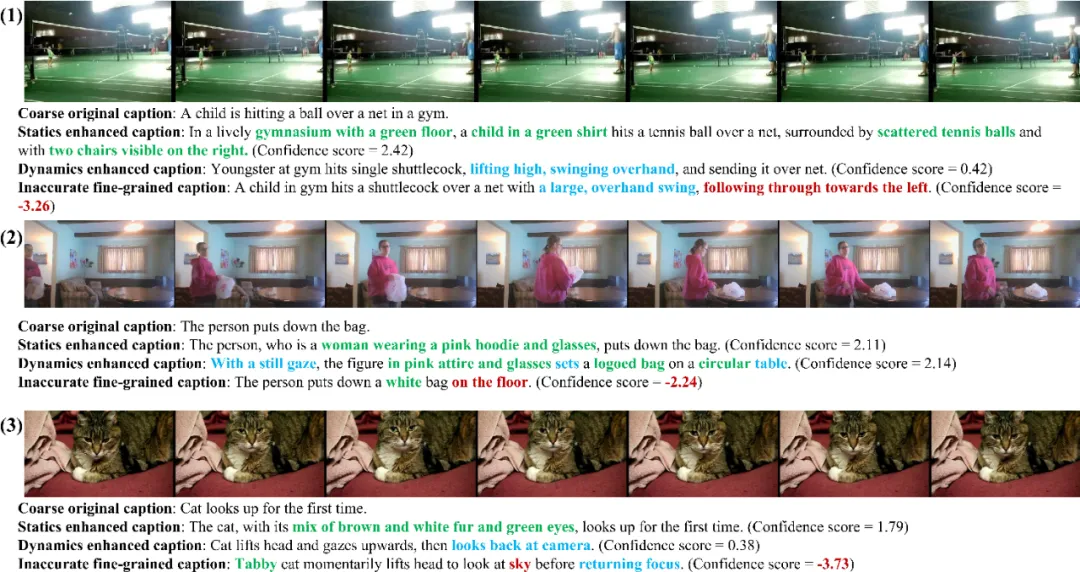

圖 3 圖 4 展示了該研究的標注中具有代表性的可視化樣本。

圖 3:(1-3)分別節(jié)選自 ActivityNet-FIG、Charades-FIG、DiDeMo-FIG 數(shù)據(jù)集,靜態(tài)和動態(tài)的細粒度內(nèi)容分別用綠色和藍色標出,不準確的內(nèi)容用紅色標出。

圖 4:(1) 本文構(gòu)建的標注捕捉到了狗與訓犬師之間的互動以及狗的運動軌跡。(2) 捕捉到了人物拋擲物體的細節(jié),并傳達了這個人多次拋擲的信息。(3) 讀取了視覺內(nèi)容中的文字信息,并正確表達了使用原料的順序。

統(tǒng)計數(shù)據(jù)和用戶實驗還表明視頻片段與標注文本之間的多對多現(xiàn)象得到了顯著減少,標注細粒度和質(zhì)量得到了用戶的認可。

三、VCMR 實驗

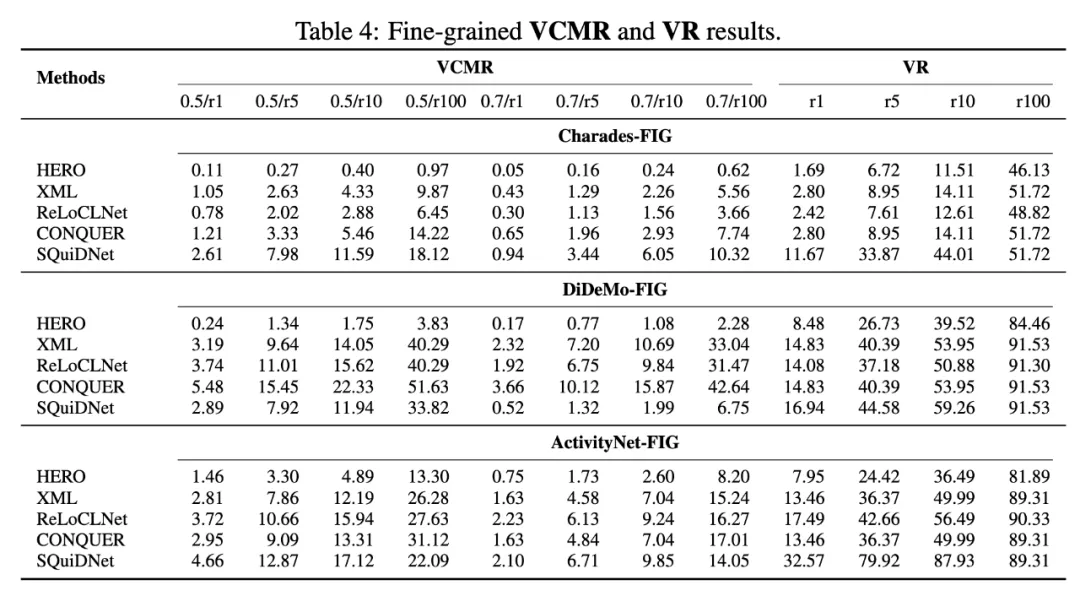

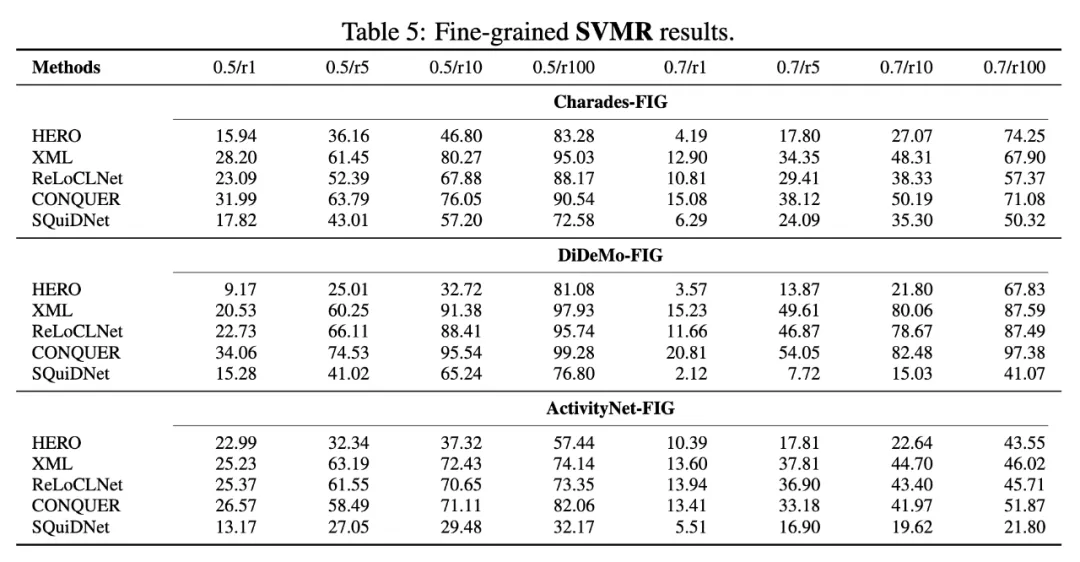

本文評估了 HERO、XML、ReLoCLNet、CONQUER、SQuiDNet 方法,分別在 Charades-FIG、DiDeMo-FIG、ActivityNet-FIG 上,對 VCMR(視頻庫片段檢索)、VR(視頻檢索)、SVMR(單視頻片段檢索)任務(wù)進行了測評,對于片段檢索指標,以 0.5/r10 為例,0.5/r10 表示召回的 top-10 個片段中與 ground truth 的 IoU 大于 0.5 的比例,結(jié)果如圖 5、6 所示。不同模型在視頻檢索任務(wù)中的表現(xiàn)各異,兩階段方法(如 CONQUER、SQuiDNet)通常優(yōu)于單階段的方法,所以訓練過程中應(yīng)當避免將視頻級別和片段級別的學習糾纏在一起,因為這可能會干擾模型對精確時刻定位的能力,進而影響整體性能,未來研究應(yīng)該關(guān)注如何有效分離視頻級別和片段級別的學習,并合理引入細粒度信息。

圖 5:細粒度 VCMR、VR 實驗結(jié)果

圖 6:細粒度 SVMR 實驗結(jié)果

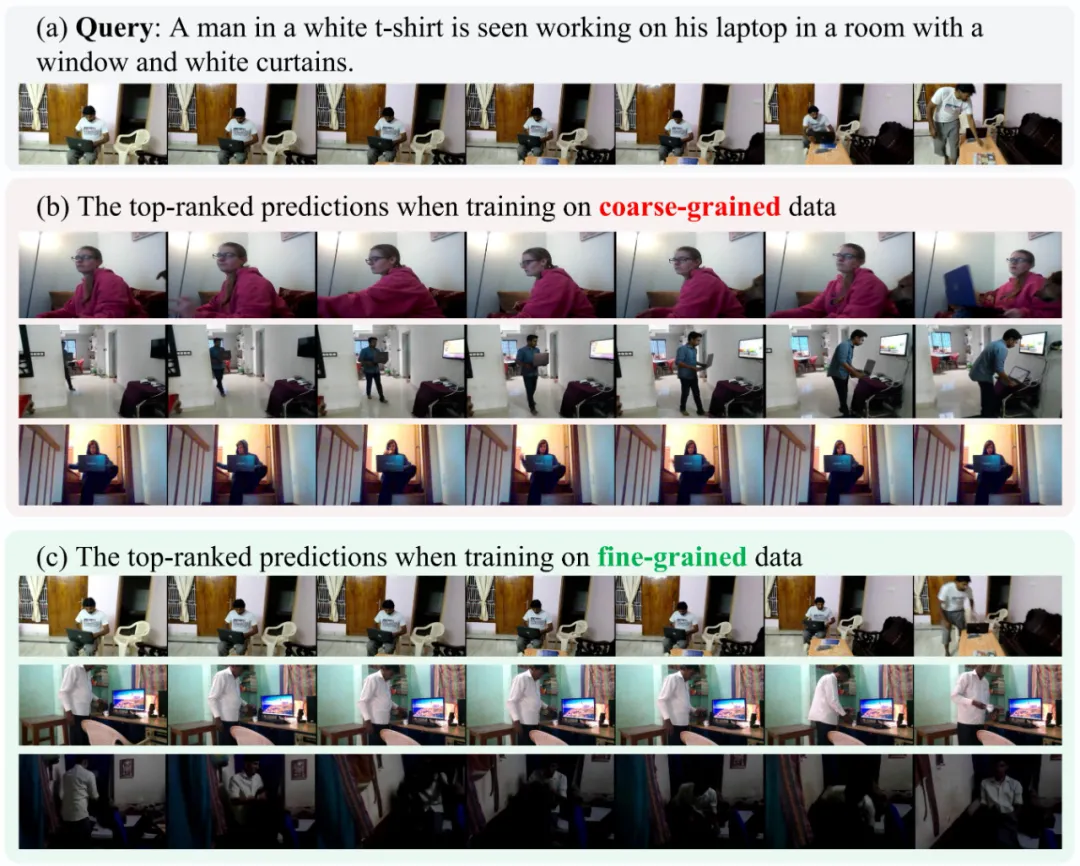

為了說明該研究的細粒度訓練數(shù)據(jù)對于提升模型的細粒度視頻檢索能力的意義,圖 7 展示了 XML 在 Charades-FIG 上訓練時,使用不同細粒度訓練數(shù)據(jù)的預測結(jié)果可視化。當使用粗粒度數(shù)據(jù)進行訓練時,真實值視頻不在時刻排名列表的前 100 名內(nèi)。排名靠前的預測主要集中在筆記本電腦上,而忽略了其他細節(jié)。使用該研究細粒度數(shù)據(jù)時,性能大大提升。它在排名第 5 位找到了目標時刻,后面的其他候選也與查詢高度相關(guān)。這展示了細粒度 VCMR 場景中的挑戰(zhàn)以及該研究的 VERIFIED 系統(tǒng)生成的標注數(shù)據(jù)在訓練中的有效性。

圖 7:XML 在 Charades-FIG 上使用不同細粒度訓練數(shù)據(jù)的部分預測結(jié)果

四、結(jié)論

現(xiàn)有 VCMR 基準數(shù)據(jù)集以粗粒度為主,限制了模型對細粒度視頻特征的學習。為此,該研究提出了 VERIFIED 自動標注系統(tǒng),結(jié)合大語言模型和多模態(tài)大模型生成細粒度的靜態(tài)和動態(tài)標注,并通過微調(diào) UMT 作為數(shù)據(jù)評估模塊提高標注可靠性。基于 VERIFIED 系統(tǒng),該研究構(gòu)建了新的細粒度 VCMR 數(shù)據(jù)集(Charades-FIG、DiDeMo-FIG、ActivityNet-FIG),評估了現(xiàn)有 VCMR 模型在細粒度場景上的表現(xiàn),實驗發(fā)現(xiàn)現(xiàn)有檢索模型在處理細粒度信息時仍與現(xiàn)實需求存在較大差距。