率先突破大規模多類數據損壞問題!中科大離線強化學習新方式入選NeurIPS 2024

機器人控制和自動駕駛的離線數據損壞問題有解了!

中科大王杰教授團隊 (MIRA Lab) 提出了一種變分貝葉斯推斷方法,有效地提升了智能決策模型的魯棒性。

論文發表在CCF-A類人工智能頂級會議NeurIPS 2024。

現實世界的離線數據集(如機器人控制、自動駕駛等)常常因傳感器故障或惡意攻擊而受到數據損壞(如數據帶有噪聲或對抗性攻擊)的影響。

盡管現有離線強化學習(offline RL)方法在魯棒性方面已取得了進展,但它們仍難以處理因離線數據的各類元素(即狀態、動作、獎勵和轉移動態)均部分損壞所引入的高不確定性。

作者針對離線數據的各類元素均有受損這一復雜的實際問題,提出了一種魯棒的變分貝葉斯推斷方法TRACER。

在面臨各類數據損壞時,該方法于所有實驗中均實現了最優,相對于現有的SOTA方法提升了高達+21.1%的決策性能,并在24組僅有單類數據損壞的實驗中仍實現了16組的最優性能。

TRACER主要具有以下三點優勢:

- TRACER首次將貝葉斯推斷引入到抗損壞的離線強化學習(corruption-robust offline RL)中。通過將所有離線數據作為觀測值,TRACER捕捉了由各類損壞數據所導致的動作價值函數中的不確定性。

- 通過引入基于熵的不確定性度量,TRACER能夠區分損壞數據和干凈數據,從而調控并減弱損壞數據對智能體模型訓練的影響,以增強魯棒性。

- 作者在機器人控制(MuJoCo)和自動駕駛(CARLA)仿真環境中進行了系統性地測試,驗證了TRACER在各類離線數據損壞、單類離線數據損壞的場景中均顯著提升了智能體的魯棒性,超出了多個現有的SOTA方法。

注:下文中公式若顯示不完整,請嘗試左右滑動查看

背景與問題

貝葉斯強化學習

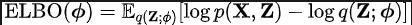

即最大化證據下界(ELBO):

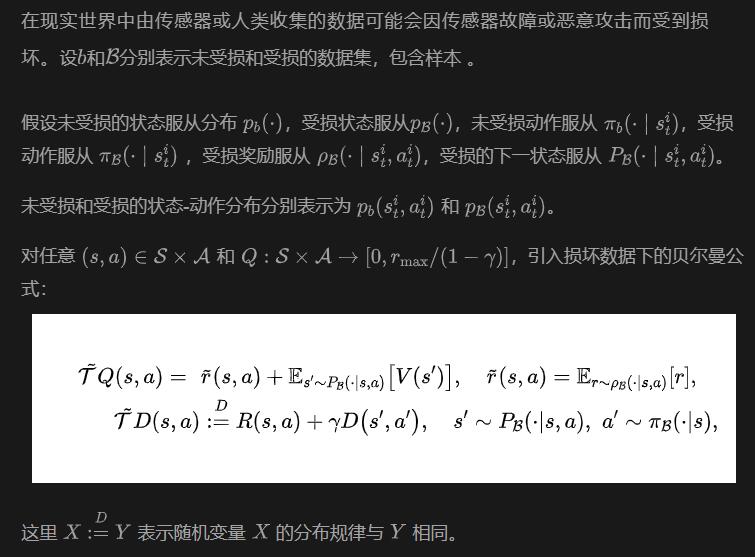

數據損壞下的離線強化學習

基于上述公式,作者的目的是基于損壞數據學習魯棒的策略。

方法介紹

總的來說,該方法將所有類別的數據損壞視為行動價值函數(action-value function)中的不確定性,并使用所有類別的離線數據作為觀測值,以估計行動價值函數的后驗分布。

這顯著增強了智能體對所有類別數據損壞的魯棒性。

此外,考慮到受損數據通常會引起更高的不確定性和熵,該方法引入了基于熵的不確定性度量,進而能有效區分損壞數據和干凈數據。

基于這類度量,該方法能調節并減弱損壞數據對智能體模型訓練的負面影響,進而顯著提高模型在干凈測試環境中的魯棒性和性能。

動機

使用多種受損數據估計累積獎勵函數(即動作值函數)會引入很高的不確定性,原因主要有兩個方面:

- 一是多種類型的損毀會向數據集的所有元素引入較高的不確定性;

- 二是每個元素與累積獎勵(即動作值、Q值)之間存在明確的相關性關系。

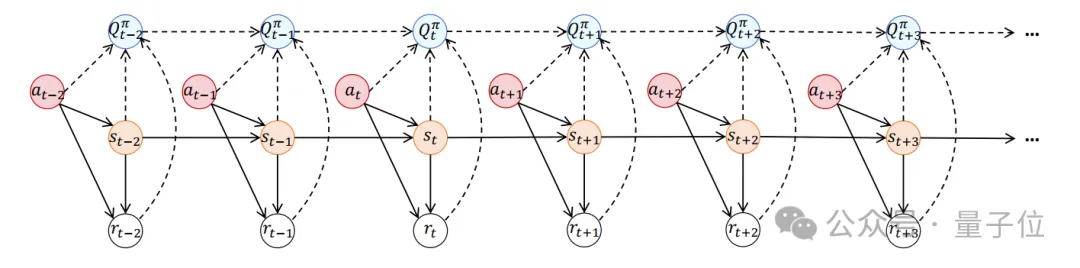

下圖為決策過程的概率圖模型。實線連接的節點表示數據集中的數據,而虛線連接的Q值(即動作值、累積回報)不屬于數據集。這些Q值通常是算法旨在估計的任務目標。

為了處理這類由多種數據損毀(即狀態、動作、獎勵、狀態轉移數據受損)導致的高不確定性問題,基于上圖所示的概率圖模型,作者提出利用數據集中的所有元素作為觀測數據。

這樣做的目的,是利用這些觀測數據與累積獎勵之間的高度相關性,來準確地識別動作值函數的不確定性。

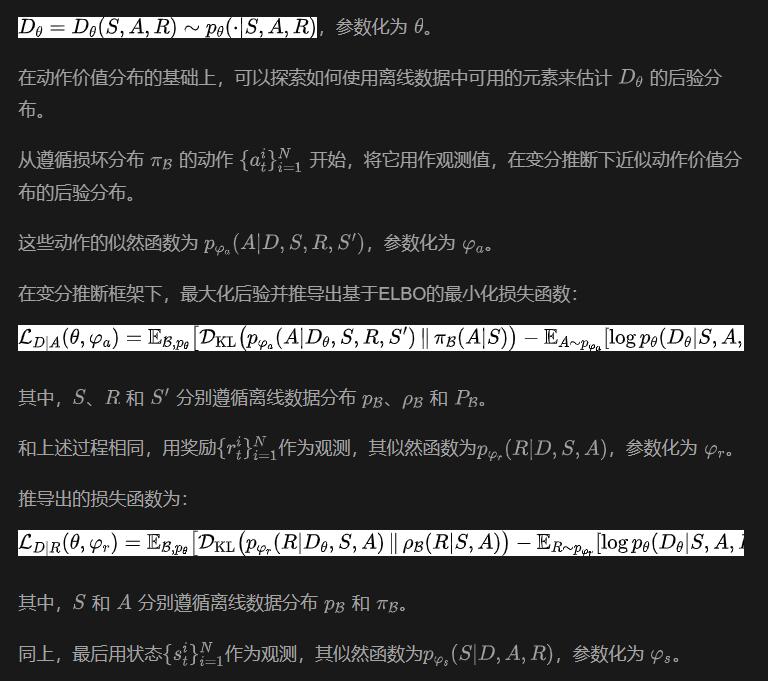

基于受損數據的貝葉斯推斷

作者提出使用離線數據集的所有元素作為觀測值,利用數據之間的相關性同時解決不確定性問題。

通過引入貝葉斯推理框架,該步的目標是逼近動作價值函數的后驗分布。

基于熵的不確定性度量

為了進一步應對各類數據損壞帶來的挑戰,作者思考如何利用不確定性進一步增強魯棒性。

鑒于目標是提高在干凈環境中的智能體性能,作者提出減少損壞數據的影響,重點是使用干凈數據來訓練智能體。

因此,作者設計了一個兩步計劃——先區分損壞數據和干凈數據;再調控與損壞數據相關的損失,減少其影響,從而提升在干凈環境中的表現。

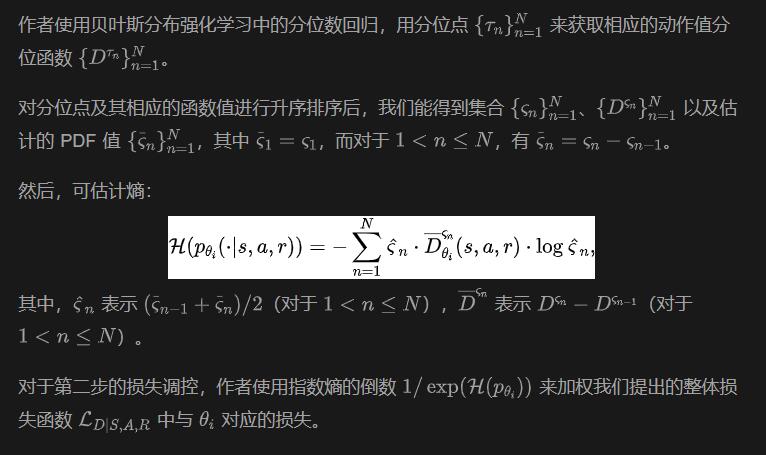

對于第一步數據的區分,由于損壞數據通常會造成比干凈數據更高的不確定性和動作價值分布熵,因此作者提出使用熵來量化損壞數據和干凈數據的不確定性。

因此,在學習過程中,TRACER 能夠調控與損壞數據相關的損失,并專注于最小化與干凈數據相關的損失,從而增強在干凈環境中的魯棒性和性能。

算法架構

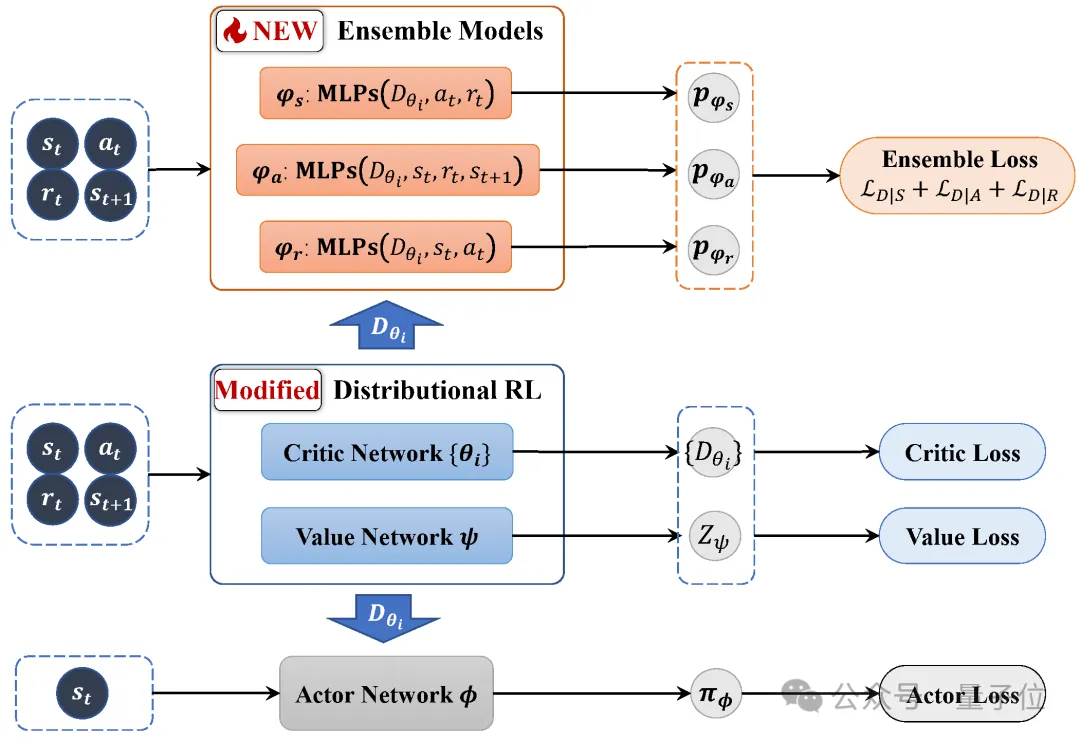

TRACER的框架圖如下所示。

可見相對于傳統的離線強化學習算法,作者的提出方法修改了批評家(critic)模型,將其改為用于分布強化學習(distributional RL)的動作值分位數回歸的架構。

此外,作者還添加了一個新的集成模型(ensemble model)。

數據受損,依然保持魯棒性

為了模擬數據受損的情形,作者對數據集的部分數據加入隨機噪聲或對抗攻擊來構建損壞數據。

在實驗中,作者對30%的單類數據進行損壞。

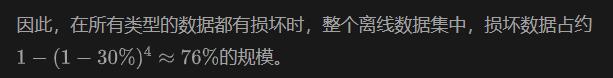

在機器人控制(MuJoCo)仿真環境測試中,作者選擇了常用的3個機器人控制環境(Halfcheetah,Walker2d,Hopper)。

這些環境的狀態為仿真機器人各個部位(如腿部、關節等)的不同物理量(如位置、角度、速度等),控制動作為機器人特定部位(如腿部、頭部)的力。

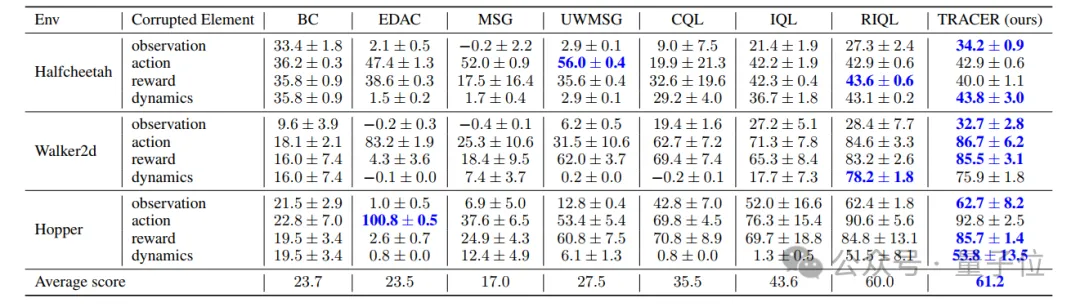

所有類型數據元素均存在隨機損壞(random)或對抗損壞(advers)時的實驗結果見下表。

可以看到,TRACER在所有控制環境中均獲得了較為明顯的性能提升,提升幅度達+21.1%,在所有環境中都獲得了最高的平均得分。

這一結果展現了TRACER對大規模、各類數據損壞的強魯棒性。

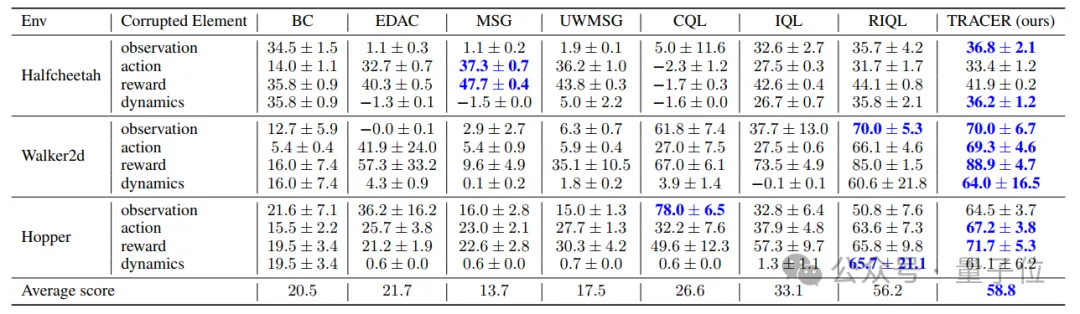

單種類型數據元素存在損壞的部分實驗結果見表2和表3。

而在單類數據損壞中,TRACER于24個實驗設置里實現16組最優性能,可見TRACER面向小規模、單類數據損壞的問題也能有效地增強魯棒性。

存在隨機損壞時,TRACER在8個實驗設置中獲得了最高的平均得分。

同樣地,單類元素存在對抗損壞時,TRACER在8個實驗設置中也獲得了最高的平均得分。

作者簡介

本論文作者楊睿是中國科學技術大學2019級碩博連讀生,師從王杰教授、李斌教授,主要研究方向為強化學習、自動駕駛等。

他曾以第一作者在 NeurIPS、KDD 等頂級期刊與會議上發表論文兩篇,曾獲滴滴精英實習生(16/1000+)。

論文地址:https://openreview.net/pdf?id=rTxCIWsfsDGitHub:

https://github.com/MIRALab-USTC/RL-TRACER