不要小看線性回歸!

在數據領域初學時,大家常聽到的一個建議是:不要試圖把整個機器學習都學透——因為它實在太龐大且變化太快,根本不現實;

而更應該聚焦在少數幾個與數據工作日常緊密相關的模型,比如決策樹、支持向量機,當然,還有線性回歸。

線性回歸本身就是一個非常實用的模型,更有意思的是,許多其他機器學習模型其實都是在它的基礎上稍作改動而來。

本文的目的,就是想讓大家看到這一點。接下來,我們會先簡要回顧一下線性回歸的基本原理,然后再介紹它的幾種常見變體。

1.線性回歸再認識

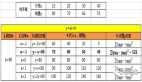

線性回歸屬于監督學習,也就是說我們有一個明確的輸出變量(即目標變量),我們假定它是輸入特征的線性函數。通常我們會用下面這樣的公式來表示:

這里,y 是目標變量,x 是包含所有輸入特征的向量,ε 代表“噪聲”,也就是那些讓我們的數據點無法完全落在直線上的誤差。

我們進一步假設這些噪聲服從均值為0、方差恒定的正態分布,也就是說,無論特征值大小如何,數據點距離直線的遠近都是類似的。

換句話說,理想中的線性回歸散點圖大致是這樣的:

圖片

圖片

而不是這樣的:

圖片

圖片

(方差不恒定時的圖像,線性回歸失效)

2.多項式回歸

在線性回歸中,我們假設目標變量是特征的線性函數。

但在實際問題中,目標往往和特征之間關系更為復雜。剛意識到這一點時,很多人可能會覺得棘手,仿佛我們需要去找到某個函數 f,使得 y = f(x) + 噪聲。

不過,如果仔細想想線性回歸的原理,就會發現現實世界很多規律其實都是連續的,這類函數往往可以用多項式很好地逼近(感興趣的同學可以去查查 Weierstrass 逼近定理或 Stone-Weierstrass 定理)。

線性函數其實只是一次多項式而已,所以多項式回歸可以看作是一種自然的推廣。模型形式大致如下:

圖片

圖片

如果你在初步分析數據時,發現目標與輸入的關系是彎曲的、非線性的,那么多項式回歸或許值得一試。比如下圖:

圖片

圖片

(x3-x 曲線的數據擬合示意圖)

3.廣義線性回歸

多項式回歸改變的是等式右側的函數形式,那左側呢?如果不是目標變量本身,而是它的某個函數和輸入的線性組合有關呢?也就是說,模型變成了:

這就是廣義線性回歸(Generalized Linear Regression,GLM)。

當 f(y) = y 時,就是我們前面討論的普通線性回歸,所以廣義線性回歸是它的直接擴展。

那 f 可以取什么形式呢?這取決于具體建模任務,但有幾個常見的特例:

- 如果懷疑目標變量服從泊松分布,自然可以取 f(y) = ln(y),這就是泊松回歸。

- 還有更常見的分類問題。雖然線性回歸及其變體主要用于回歸任務(顧名思義),但數據人第一次接觸分類任務時,往往學到的第一個模型就是邏輯回歸。其實,邏輯回歸正是廣義線性回歸在 logit 函數(f(y) = ln(y/(1-y))) 下的特例。

4.貝葉斯線性回歸

這里不打算展開貝葉斯統計的基礎知識,相關資料很多,有興趣的同學可以自行查閱。

簡單來說,就是當我們的數據很少、信息有限時,可以借助專家意見(先驗知識)來輔助建模,獲得對問題更全面的認識。在線性回歸的情境下,如果數據點很少,直接擬合參數往往不靠譜,因為信息量不足。

但如果我們不追求唯一的“最佳擬合直線”,而是希望得到一條“高度可能包含真實直線”的區域,那么貝葉斯線性回歸正好可以滿足這樣的需求。

數學細節可能會比較復雜,但核心思想就是:與其給出一條確定的直線,不如給出一個可能包含直線的區域。數據點越多,這個區域就越窄,我們對直線的位置也越有信心。如下圖所示:

圖片

圖片

(貝葉斯回歸的置信區間示意圖)

5.神經網絡

回到開頭給初學者的建議,雖然深度學習和神經網絡現在非常火爆,相關研究也是機器學習領域的前沿,但其實本質上,神經網絡也就是大量“重型并行版的線性回歸”再加上“激活函數”而已。

簡單來說,神經網絡由許多“神經元”(也叫感知機)組成,分布在不同的層中。每個神經元本質上就是一個線性回歸,加上一個激活函數,用來判斷輸入是否足夠讓神經元“激活”。神經網絡的訓練過程,其實就是在不斷調整這些線性回歸的系數。

歸根結底,神經網絡就是大量的線性回歸!不同的網絡結構,核心區別無非是神經元(線性回歸單元)數量和層數的不同。最復雜的深度網絡,神經元可以多達上百萬,層數也很多。

激活函數的選擇也有多種(Heaviside、ReLU、Sigmoid 等都很常見),有的網絡還會在不同層用不同的激活函數。

但本質區別也就這些。無論是 CNN、自動編碼器、Transformer 等等,歸根結底,都是由大量小小的線性回歸單元組成的。

6.總結

所以,線性回歸或許看起來有些平淡無奇,但它其實是許多機器學習模型的基礎。上面這些討論遠遠不是全部內容,但希望能讓你意識到線性回歸的重要性。千萬不要小看線性回歸!

原文鏈接:https://medium.com/data-and-beyond/do-not-underestimate-linear-regression-4680a19f5838