復(fù)雜多文本圖像生成;多角色對話視頻生成,唇形同步,身體動作,情感表達

TextCrafter: Accurately Rendering Multiple Texts in Complex Visual Scenes

2025-03-30|NJU, China Mobile, HKUST|??61

???http://arxiv.org/abs/2503.23461v2????

????https://huggingface.co/papers/2503.23461????

????https://github.com/NJU-PCALab/TextCrafter.git???

研究背景與意義

復(fù)雜視覺文本生成(CVTG)任務(wù)近年來受到廣泛關(guān)注,其核心挑戰(zhàn)在于如何在圖像的不同區(qū)域生成精確、清晰且上下文一致的文本內(nèi)容。現(xiàn)有模型如FLUX和SD3.5雖然在簡單場景中表現(xiàn)良好,但在多文本復(fù)雜場景下常出現(xiàn)文本混淆、遺漏或模糊等問題。TextCrafter正是為解決這些問題而提出的一種創(chuàng)新方法。

- 研究背景:隨著擴散模型的發(fā)展,視覺圖像生成技術(shù)取得了顯著進步,但復(fù)雜視覺文本生成仍面臨諸多挑戰(zhàn)。例如,多文本之間的干擾、小尺寸文本的模糊以及位置錯位等問題嚴(yán)重影響了生成效果。

- 研究意義:TextCrafter通過引入實例融合、區(qū)域隔離和文本聚焦三大機制,有效解決了上述問題。它不僅提升了復(fù)雜場景中文本生成的準(zhǔn)確性,還為評估此類任務(wù)提供了新的基準(zhǔn)數(shù)據(jù)集CVTG-2K。

研究方法與創(chuàng)新

TextCrafter的核心創(chuàng)新點在于其獨特的三階段策略,具體如下:

- 實例融合(Instance Fusion)實例融合通過加強文本與其載體之間的關(guān)聯(lián),確保文本不會漂浮在圖像中,而是準(zhǔn)確地定位到指定位置。該方法利用前引號的嵌入信息來捕捉文本的空間關(guān)系,并通過加權(quán)融合的方式將文本嵌入整合到載體嵌入中。這種方法避免了直接使用文本自身嵌入可能帶來的偏差。

- 區(qū)域隔離(Region Insulation)區(qū)域隔離旨在減少多文本之間的相互干擾。通過為每個文本分配矩形邊界框并初始化布局信息,模型能夠有效地分離不同文本區(qū)域。這一過程利用了預(yù)訓(xùn)練DiT模型的位置先驗知識,從而避免了手動指定布局或依賴大型語言模型的局限性。

- 文本聚焦(Text Focus)文本聚焦機制通過增強注意力機制,提升對小尺寸文本的關(guān)注度。具體而言,該方法通過調(diào)整注意力權(quán)重,使模型更加專注于文本及其前引號部分,從而提高渲染精度。此外,tanh函數(shù)被用于控制增強幅度,防止過度放大導(dǎo)致失真。

方法優(yōu)勢:

- 全局到局部的逐步細(xì)化:從整體任務(wù)分解到子任務(wù),再到具體文本的精確渲染,實現(xiàn)了由粗到精的過程。

- 無需額外訓(xùn)練:TextCrafter基于預(yù)訓(xùn)練模型構(gòu)建,無需額外訓(xùn)練或微調(diào),降低了實現(xiàn)成本。

- 廣泛的適用性:適用于多種復(fù)雜場景,包括長文本、小尺寸文本、數(shù)字和符號等。

實驗設(shè)計與結(jié)果分析

為了驗證TextCrafter的有效性,研究團隊設(shè)計了一系列實驗,并將其與其他基線方法進行了對比。

- 實驗設(shè)計

- 數(shù)據(jù)集:提出了全新的CVTG-2K數(shù)據(jù)集,包含多樣化的視覺文本提示,涵蓋位置、數(shù)量、長度和屬性等多個維度。

- 指標(biāo):采用OCR準(zhǔn)確率(Word Accuracy)、歸一化編輯距離(NED)和CLIPScore三種指標(biāo)進行評估。

- 基線方法:包括Stable Diffusion 3.5 Large、FLUX.1 dev、AnyText、TextDiffuser-2、RAG-Diffusion和3DIS等。

- 結(jié)果分析

- 在CVTG-2K數(shù)據(jù)集上,TextCrafter顯著優(yōu)于其他方法。特別是在多區(qū)域文本生成任務(wù)中,其OCR準(zhǔn)確率比FLUX高出45%以上。

- 對于小尺寸文本,TextCrafter的表現(xiàn)尤為突出,其清晰度和準(zhǔn)確性遠超其他模型。

- 定性結(jié)果表明,TextCrafter生成的圖像不僅美觀和諧,還能準(zhǔn)確渲染多個視覺文本,同時保持穩(wěn)定性。

- 對比基準(zhǔn)

- SD3.5和FLUX在簡單場景中表現(xiàn)良好,但隨著文本區(qū)域數(shù)量增加,性能急劇下降。

- AnyText和TextDiffuser-2專注于單區(qū)域生成,在復(fù)雜場景中的泛化能力不足。

- RAG-Diffusion和3DIS雖能處理復(fù)雜場景,但在視覺文本生成的具體要求上表現(xiàn)欠佳。

結(jié)論與展望

- 總結(jié)貢獻

- 提出了TextCrafter,一種無需訓(xùn)練的復(fù)雜視覺文本生成框架,包含實例融合、區(qū)域隔離和文本聚焦三大機制。

- 構(gòu)建了CVTG-2K數(shù)據(jù)集,為評估復(fù)雜視覺文本生成任務(wù)提供了全面的基準(zhǔn)。

- 實驗結(jié)果證明,TextCrafter在OCR準(zhǔn)確率、NED和CLIPScore等多個指標(biāo)上均表現(xiàn)出色。

- 分析局限

- 當(dāng)前方法主要針對靜態(tài)圖像中的文本生成,對于動態(tài)場景或視頻中的文本生成尚未涉及。

- CVTG-2K數(shù)據(jù)集雖然多樣化,但仍需進一步擴展以覆蓋更多極端情況。

- 方法展望

- 將TextCrafter擴展至動態(tài)場景,探索其在視頻生成中的應(yīng)用潛力。

- 引入更多樣化的屬性(如字體風(fēng)格、顏色漸變等),進一步豐富視覺文本的表現(xiàn)力。

- 開發(fā)更高效的優(yōu)化算法,降低計算成本,提升實時性。

MoCha: Towards Movie-Grade Talking Character Synthesis

2025-03-30|U Waterloo, Meta GenAI, Meta |??49

???http://arxiv.org/abs/2503.23307v1????

????https://huggingface.co/papers/2503.23307????

????https://congwei1230.github.io/MoCha/???

研究背景與意義

MoCha的提出旨在解決現(xiàn)有視頻生成模型在自動化電影制作中的局限性。當(dāng)前模型盡管在視覺效果和動態(tài)環(huán)境方面取得了顯著進展,但在生成具有完整身體動作、情感表達和多角色互動的對話場景時仍顯不足。MoCha通過結(jié)合語音和文本輸入生成高質(zhì)量的電影級角色動畫,不僅實現(xiàn)了精確的唇形同步,還能夠自然地表達情感和全身動作,從而推動了自動化敘事技術(shù)的發(fā)展。

- 研究背景:自動化電影制作潛力巨大,可實現(xiàn)大眾化的電影級敘事。然而,現(xiàn)有模型在生成具有豐富敘事內(nèi)容的角色動畫時存在明顯限制。

- 研究意義:MoCha首次實現(xiàn)了從語音和文本直接生成包含多角色對話的動畫視頻,突破了傳統(tǒng)單一角色或僅限面部區(qū)域的生成方法,為電影制作和虛擬助手等領(lǐng)域提供了新的可能性。

研究方法與創(chuàng)新

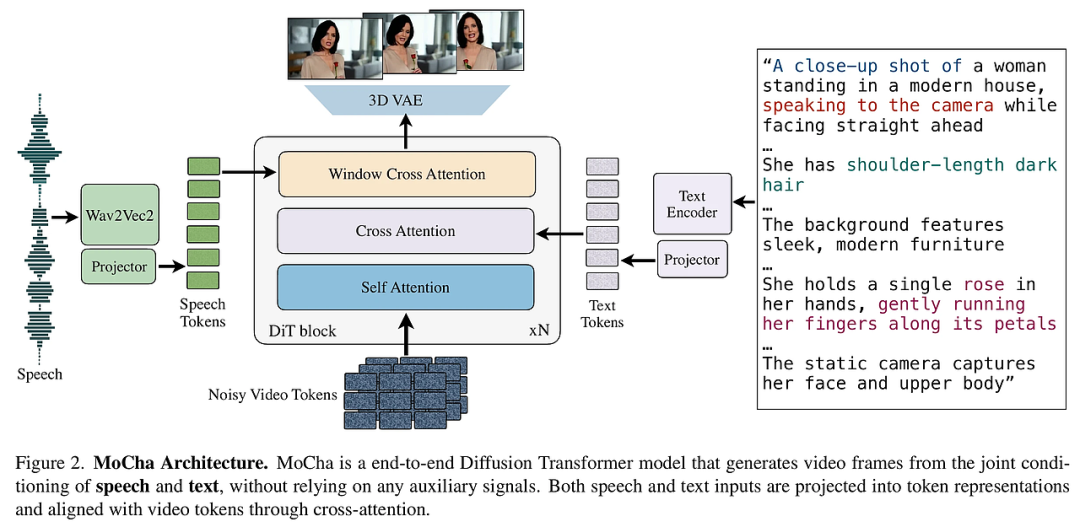

MoCha的核心創(chuàng)新在于其端到端訓(xùn)練架構(gòu)和關(guān)鍵機制的設(shè)計,這些設(shè)計顯著提升了模型的表現(xiàn)力和泛化能力。

- 端到端訓(xùn)練無輔助條件:MoCha無需依賴外部控制信號(如參考圖像、骨架或關(guān)鍵點),直接基于文本和語音進行訓(xùn)練。這種簡化不僅降低了模型復(fù)雜度,還增強了動作多樣性和泛化能力。

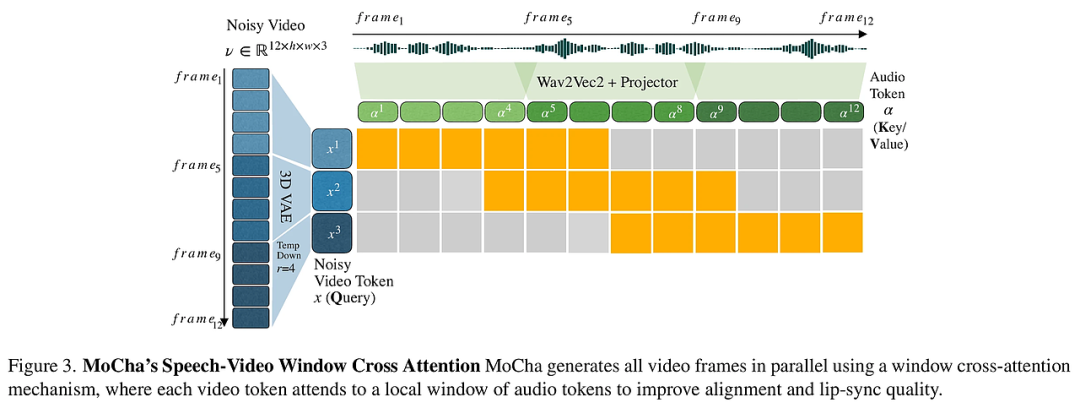

- 語音-視頻窗口注意力機制:為了改善語音與視頻之間的對齊,MoCha引入了一種新型注意力機制,該機制通過局部時間條件約束音頻和視頻令牌的關(guān)聯(lián)。這一設(shè)計顯著提高了唇形同步精度,并確保了語音與視頻的一致性。

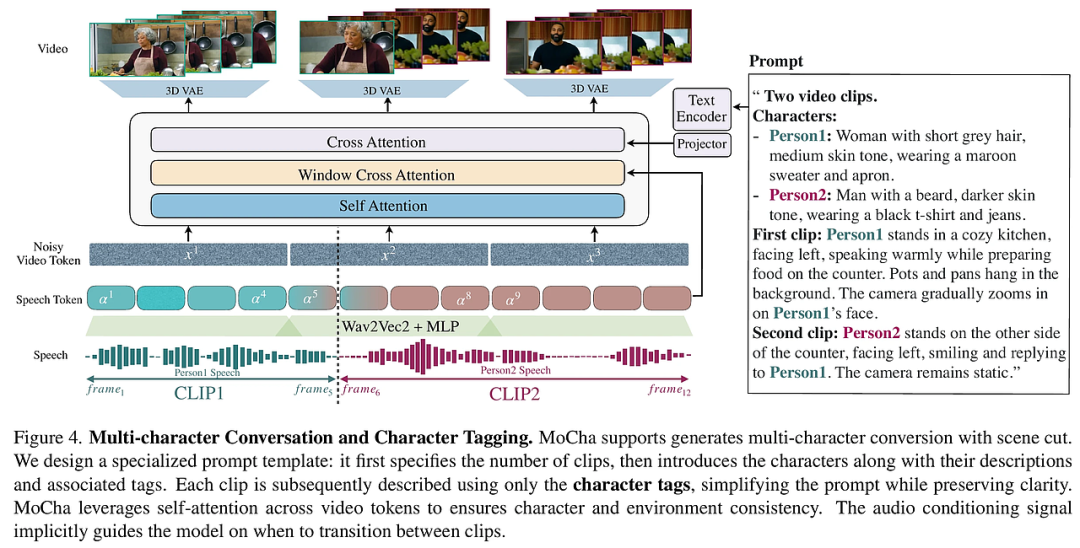

- 聯(lián)合語音-文本訓(xùn)練策略:針對大規(guī)模語音標(biāo)注視頻數(shù)據(jù)稀缺的問題,MoCha采用了一種聯(lián)合訓(xùn)練框架,同時利用語音標(biāo)注和文本標(biāo)注的視頻數(shù)據(jù)。這種方法增強了模型在多樣化角色動作上的泛化能力,并實現(xiàn)了通過自然語言提示對角色表情、動作和環(huán)境的精細(xì)控制。

- 多角色對話生成:MoCha首次實現(xiàn)了連貫的多角色動態(tài)對話生成,支持基于場景切換的多片段生成。通過自注意力機制,模型能夠在多個片段中保持角色和環(huán)境的一致性,而無需額外的架構(gòu)修改。

實驗設(shè)計與結(jié)果分析

實驗部分驗證了MoCha在多個維度上的優(yōu)越性能,包括唇形同步質(zhì)量、面部表情自然度、動作自然度、文本對齊和整體視覺質(zhì)量。

- 實驗設(shè)計:研究人員設(shè)計了一個專門用于評估Talking Characters任務(wù)的基準(zhǔn)數(shù)據(jù)集MoCha-Bench,其中包括150個多樣化的樣本。實驗涵蓋了從近景到中景的不同鏡頭類型,強調(diào)面部表情、唇形同步和全身動作的表現(xiàn)。

- 結(jié)果分析:定量實驗顯示,MoCha在唇形同步指標(biāo)Sync-C和Sync-D上均優(yōu)于基線方法。人類評價結(jié)果進一步表明,MoCha在所有五個評估維度上均顯著領(lǐng)先,尤其是在動作自然度和文本對齊方面表現(xiàn)出色。

結(jié)論與展望

MoCha的成功展示了其在生成高質(zhì)量、可控性強的角色動畫方面的潛力,為未來的研究奠定了堅實基礎(chǔ)。

- 總結(jié)貢獻:MoCha不僅實現(xiàn)了精確的唇形同步和自然的情感表達,還在多角色對話生成和全身動作表現(xiàn)上取得了突破。這些成果使其成為電影制作、虛擬助手等領(lǐng)域的有力工具。

- 分析局限:盡管MoCha表現(xiàn)優(yōu)異,但其生成的視頻在復(fù)雜動作場景下仍可能存在輕微瑕疵。此外,模型對長篇對話的處理能力仍有提升空間。

- 方法展望:未來工作可以進一步優(yōu)化語音-視頻窗口注意力機制,以更好地處理長時間序列數(shù)據(jù)。同時,探索更高效的聯(lián)合訓(xùn)練策略和更大規(guī)模的數(shù)據(jù)集將有助于提升模型的泛化能力和生成質(zhì)量。

本文轉(zhuǎn)載自????AI研究前瞻????,作者:胡耀淇