快手開源圖生視頻模型LivePortrait,等待生成時間僅需10秒,棄擴散改用隱式關鍵點框架技術,網友:強得可怕 原創

編輯 | 伊風

出品 | 51CTO技術棧(微信號:blog51cto)

快手開源了LivePortrait模型!

要知道,可靈的文生視頻和圖生視頻功能不僅備受關注,還一路火到了海外。

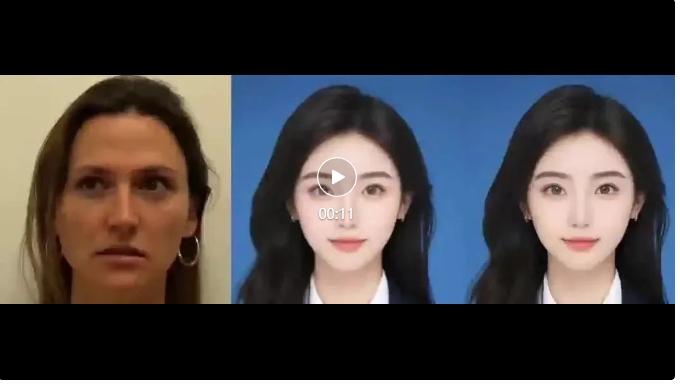

這次開源的LivePortrait效果也十足驚艷!雖然驅動肖像生成視頻的技術并不算新鮮,但還是靠效果征服了觀眾。

圖片

圖片

網友直呼,“太可靈了”。根據推測,這個技術很可能已經在快影接入的可靈模型里應用了一段時間了。

毫無疑問,此次開源大大降低了擁有自己數字人的門檻!

更妙的是,網友嘗試用開源的代碼進行部署。發現生成10秒視頻竟然也只需10秒,速度快得可怕。

超快的速度意味著LivePortrait的生成能力已經無限逼近實時。未來將可能在實時應用上大展拳腳,例如視頻會議、社交媒體直播和實時游戲動畫等場景。

可靈創作者群@guohunyo作品? 項目地址,感興趣的朋友請移步GitHub:

可靈創作者群@guohunyo作品? 項目地址,感興趣的朋友請移步GitHub:

??https://github.com/KwaiVGI/LivePortrait?tab=readme-ov-file??

論文地址:

??https://arxiv.org/pdf/2407.03168??

讀了這篇《LivePortrait:具有縫合和重定向控制的高效肖像動畫》論文后,我們發現快手在LivePortrait模型上進行了許多創新和改進。

其中最引人關注的是:LivePortrait放棄了我們所熟知的擴散模型,而是采用了隱式關鍵點框架。

被網友昵稱為:擠眉弄眼模型

被網友昵稱為:擠眉弄眼模型

1.隱式關鍵點框架:不止于快的秘訣

LivePortrait的架構包括多個關鍵組件:外觀特征提取器、規范隱式關鍵點檢測器、頭部姿勢估計網絡、表情變形估計網絡、扭曲場估計器和生成器。

這些組件協同工作,將源圖像的特征與驅動視頻的運動特征結合起來,生成最終的動畫。

不同于此前走紅的阿里的EMO,其使用了穩定擴散方案來生成視頻,通過逐步引入和去除噪聲在潛在空間中生成一幀幀圖像。

LivePortrait的隱式關鍵點框架使用一組抽象的特征來表示圖像。這些特征重點捕捉了圖像的重要信息,例如面部特征、輪廓等。

生成人物動作和表情時,LivePortrait更不容易“崩壞”。這是因為關鍵點通常對應于面部的特定部位,如眼角、嘴角、鼻子等,這些關鍵點的位置和變化可以驅動面部表情和頭部運動。

因此,隱式關鍵點框架具備良好的靈活性。通過操作關鍵點,模型可以更精確地控制面部動畫的細節,實現平滑和逼真的過渡效果。

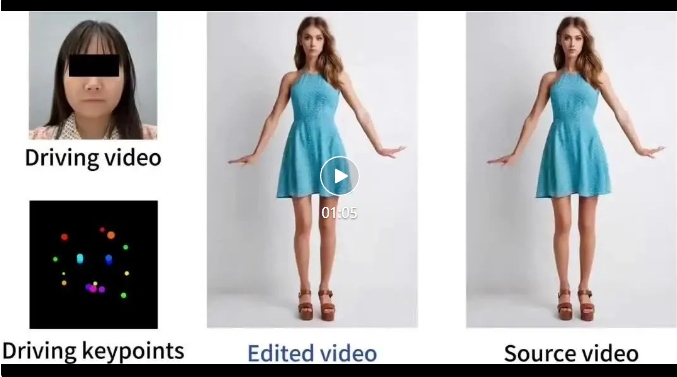

圖片

圖片

上圖:模型可以生動地對圖像進行動畫化,確保無縫拼接,并提供對眼睛和嘴唇運動的精確控制。

同時,關鍵點的方式使得模型的泛化能力也得到提升。通過學習關鍵點的運動模式,LivePortrait可以更好地泛化到新的、未見過的圖像上。

而擴散模型通常需要更長的推理時間,因為逐步去噪的方法注定增多了生成步驟,使得生成每一幀圖像的時間較長,無法達到“實時”效果。

2.訓練方法和訓練數據

在訓練方法上LivePortrait的訓練分成了兩個階段。

第一階段,模型在沒有任何預訓練的權重下,從零開始全面訓練,使用了8個NVIDIA A100 GPU,訓練時間約為10天。使用了ConvNeXt-V2-Tiny作為主干網絡,有助于減少模型的計算負擔。

第二階段,只訓練縫合和重定向模塊,而保持其他參數不變。訓練縫合模塊可以確保動畫后的肖像能夠無縫地融入原始圖像空間,特別是在處理多人肖像或全身圖像時;而訓練眼睛和嘴唇的重定向模塊,以便能夠根據驅動視頻精確控制這些面部特征的運動。第二階段的訓練時間約為2天。

在訓練數據上,LivePortrait的訓練數據規模擴展到了約6900萬高質量的幀,訓練數據包括各種姿勢和表情的4K分辨率肖像視頻,以及大量的頭部談話視頻。

現在,訓練數據的質量越來越受到重視。LivePortrait也使用了一些“巧思”確保數據的高質量。

首先,LivePortrait使用了KVQ等工具來排除低質量的視頻片段。其次,在訓練數據中,將長視頻分割為不超過30秒的片段,確保每個片段只包含一個人,讓模型更精準的學習一個人的表情活動。此外,數據十分注重身份多樣性,使用的訓練數據來自約18.9K個不同的身份,有效避免對特定身份的過擬合。

3.寫在最后

圖生視頻技術正在跑步進入下一個階段。

在此時,騰訊卻突然宣布將“數字人”驅逐出視頻號。騰訊計劃通過修訂《視頻號櫥窗達人“發布低質量內容”實施細則》來進一步限制使用數字人直播,將使用AI工具生成虛擬形象進行直播等行為明確列入低質量內容。

這無疑釋放了一個信號:AI等技術生成內容帶來的風險仍不可小覷,內容的不可控、直播“翻車”、誤導消費者等等仍然是技術尚未解決的難題。

事實正在側面印證這一觀點,每當有社會新聞誕生時,就不乏好事者用當事人的圖像生成煽動性的動態圖像。

這很可能倒逼平臺收緊生成政策,不斷疊加敏感詞,抱著“寧可錯殺一千不能放過一個”的方式來對待用戶的prompt。

圖片

圖片

技術進步并非孤立發生。本身中性的技術如果被濫用,其影響可能深遠且復雜。

在這樣的背景下,我們不得不深思:公眾的媒介素養應該如何提升,才能追得上技術的日新月異。這不僅關乎技術生態的健康發展,更關乎文明。

http://www.ekrvqnd.cn/aigc/