Meta推出開放世界具身問答數據集OpenEQA:視覺大模型在具身智能上還有很長的路要走! 原創

想象一個實體化的 AI 代理,充當家庭機器人的大腦或時尚的智能眼鏡。這樣的代理需要利用視覺等感知模態來理解周圍環境,并能夠用清晰、日常語言有效地與人交流。這類似于構建“世界模型”,即代理對外部世界的內部表示,可以通過語言查詢。這是一個長期愿景和一個艱巨的研究挑戰——Meta正在積極探索。

近日,Meta發布了開放詞匯體驗問答(OpenEQA)框架——一個衡量 AI 代理通過開放詞匯問題來理解其環境的新基準。這類似于我們如何評估人類對概念的理解,即通過問問題并評估他們的答案。OpenEQA 包含兩個任務:

- (1)敘事記憶EQA,其中實體化的 AI 代理根據其對過去經驗的回憶來回答問題;

- (2)主動EQA,在其中代理必須在環境中采取行動以收集必要的信息并回答問題。

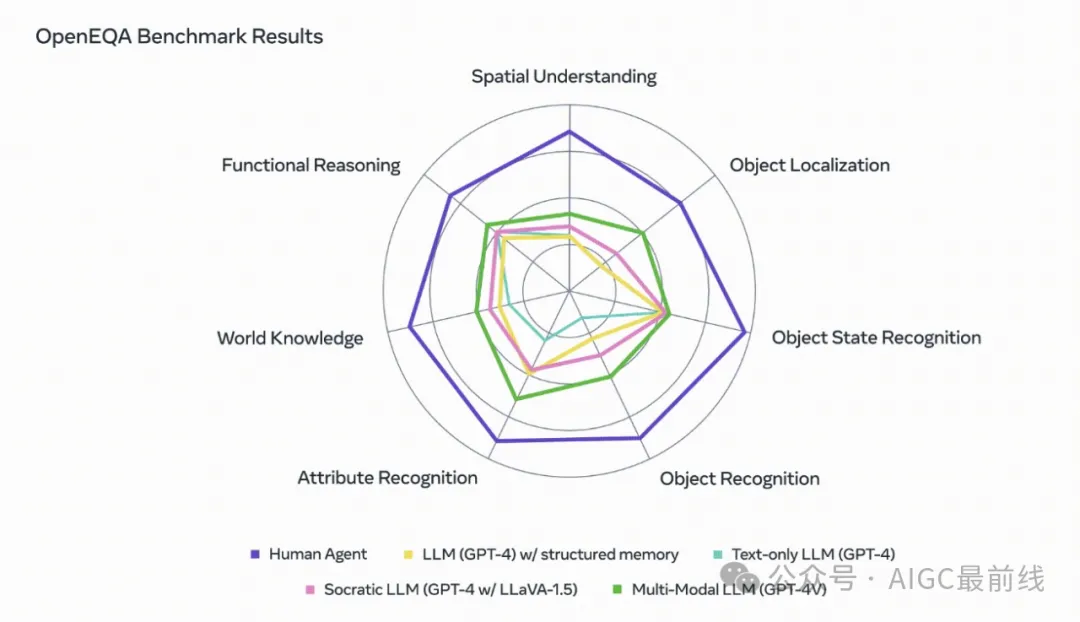

Meta使用OpenEQA對幾個最先進的視覺+語言基礎模型(VLMs)進行了基準測試,并發現即使是性能最好的模型(GPT-4V達到48.5%)與人類表現(85.9%)之間也存在顯著差距。特別值得關注的是,對于需要空間理解的問題,即使是最好的VLMs幾乎是“盲目”的——也就是說,它們的表現并不比僅文本模型好多少,這表明利用視覺信息的模型并沒有從中獲得實質性的好處,并且在回答視覺問題時依賴于在文本中捕獲的有關世界的先驗知識。舉個例子,對于問題“I'm sitting on the living room couch watching TV. Which room is directly behind me?”,模型基本上是隨機猜測不同的房間,而沒有從視覺敘事記憶中獲得明顯的好處,這應該提供對空間的理解。這表明,在實體化AI代理準備好進入主流之前,需要在感知和推理方面進行額外的改進。

OpenEQA將具有挑戰性的開放詞匯問題與以自然語言回答的能力相結合。這產生了一個直觀的基準測試,顯示了對環境的強大理解,并對當前的基礎模型構成了重大挑戰。我們希望這項工作能激發更多的研究,幫助AI理解和溝通它所看到的世界。

論文:https://open-eqa.github.io/assets/pdfs/paper.pdf

數據集:https://github.com/facebookresearch/open-eqa

本文轉載自公眾號AIGC最前線