AI長視頻生成終現(xiàn)"免費午餐"!RIFLEx顛覆性發(fā)現(xiàn):調(diào)控頻率就能突破時長魔咒

論文鏈接:https://arxiv.org/pdf/2502.15894 項目鏈接:https://riflex-video.github.io/

亮點直擊

- 通過分析現(xiàn)有方法的失敗模式并揭示位置嵌入中各個頻率成分的作用,提供了對視頻長度外推的全面理解。

- 提出了RIFLEx,一種簡單而有效的解決方案,通過適當降低內(nèi)在頻率來減少重復,且無需任何額外修改。

- RIFLEx提供了一種真正的“免費午餐”——在最先進的視頻擴散Transformer上以完全無需訓練的方式實現(xiàn)高質量的2倍外推。此外,通過少量微調(diào)且無需長視頻,它進一步提升了質量并實現(xiàn)了3倍外推。

總結速覽

解決的問題

- 生成長視頻的挑戰(zhàn):現(xiàn)有的視頻生成模型在生成長視頻時面臨時間一致性差的問題,容易出現(xiàn)時間重復或運動減速的現(xiàn)象。

- 長度外推技術的不足:現(xiàn)有的長度外推方法在應用于視頻生成時表現(xiàn)不佳,導致時間重復和運動減速。

提出的方案

- RIFLEx方法:提出了一種名為RIFLEx(Reducing Intrinsic Frequency for Length Extrapolation)的方法,通過降低內(nèi)在頻率來抑制時間重復,同時保持運動一致性。

- 訓練自由和微調(diào):RIFLEx在2倍外推時無需任何訓練即可實現(xiàn)高質量視頻生成,而在3倍外推時僅需少量微調(diào)。

應用的技術

- 頻率成分分析:通過隔離和調(diào)整位置嵌入中的頻率成分,發(fā)現(xiàn)高頻成分導致時間重復,低頻成分導致運動減速。

- 內(nèi)在頻率調(diào)整:識別并降低內(nèi)在頻率,確保外推后頻率保持在一個周期內(nèi),從而抑制重復并保持運動一致性。

- 擴散Transformer:應用了擴散Transformer(diffusion transformers)技術,結合了擴散模型的可擴展性和Transformer的表達能力。

達到的效果

- 高質量視頻生成:RIFLEx在2倍外推時實現(xiàn)了高質量、自然的視頻生成,且無需額外訓練。

- 3倍外推:通過少量微調(diào),RIFLEx進一步提升了樣本質量,并實現(xiàn)了3倍外推。

- 廣泛驗證:在多個先進的視頻擴散Transformer(如CogVideoX-5B和HunyuanVideo)上進行了廣泛實驗,驗證了RIFLEx的有效性。

- 空間外推:RIFLEx還可以同時應用于空間域,擴展視頻時長和空間分辨率。

方法

本文目標是全面理解并解決視頻長度外推問題。首先強調(diào)了現(xiàn)有方法的失敗模式,分析了位置嵌入中不同頻率成分的作用,并識別了一個內(nèi)在頻率。基于此,推導出了內(nèi)在頻率。作為副產(chǎn)品,本文方法不僅為現(xiàn)有方法在視頻外推中的失敗提供了理論解釋,還為圖像空間外推提供了見解。

現(xiàn)有方法的失敗模式

盡管“外推”一詞在不同領域被廣泛使用,但它在視頻生成中的作用與文本和圖像有根本不同。在視頻生成中,目標是創(chuàng)建新的、時間上連貫的內(nèi)容,并使其隨時間平滑演變。相比之下,文本外推主要是擴展上下文窗口,而圖像外推通常涉及添加高分辨率細節(jié),而不是生成有意義的新內(nèi)容。

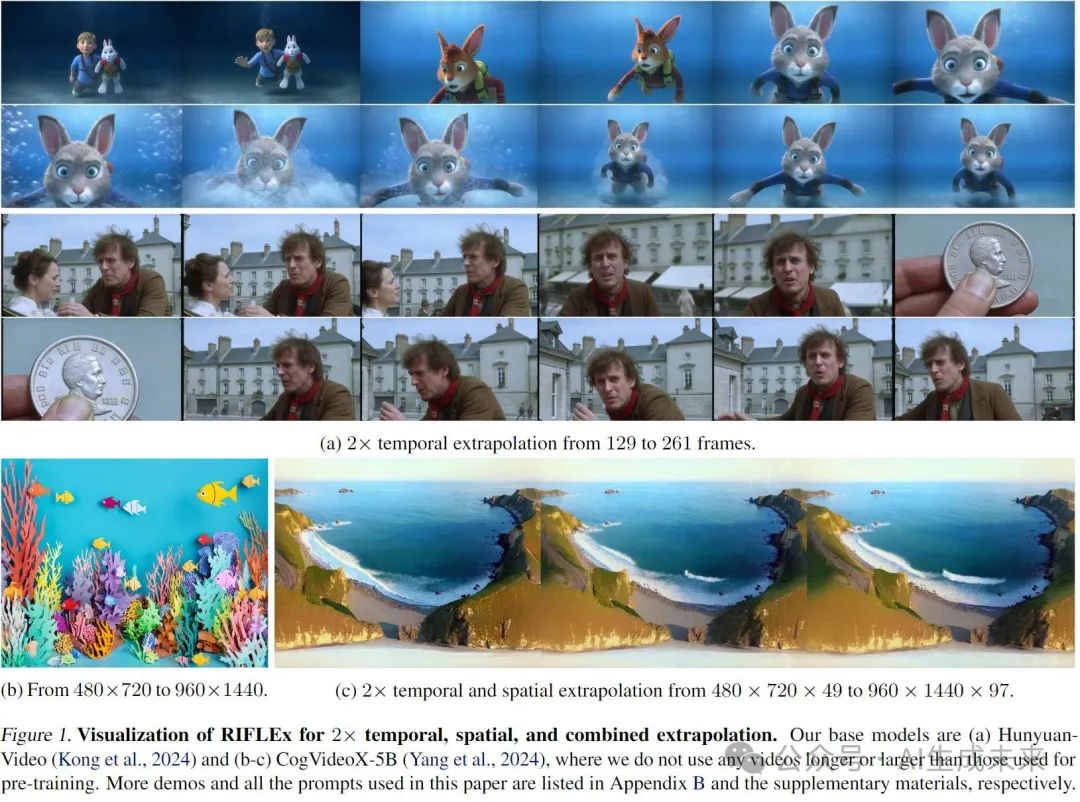

因此,為文本和圖像開發(fā)的外推策略在視頻長度外推中失敗,并表現(xiàn)出有趣的失敗模式,如圖2所示。為了更好地理解這些模式,還在圖像空間外推中進行了對比實驗,揭示了與視頻的相似之處。

- PE(直接擴展位置編碼超出訓練范圍)會導致時間重復,使視頻循環(huán)播放而不是自然推進(圖2a)。在圖像生成中,類似現(xiàn)象表現(xiàn)為空間重復,而不是生成新內(nèi)容。

- PI(Chen et al., 2023b)將位置編碼壓縮在訓練范圍內(nèi),導致運動變慢,通過拉伸幀時間來實現(xiàn)(圖2b)。雖然這種方法保持了結構一致性,但缺乏時間上的新穎性。在圖像生成中,這會導致細節(jié)模糊而不是新內(nèi)容(圖2e)。

- 如圖2c所示,NTK也會引起時間重復,無法生成有意義的運動進展。在圖像生成中,它會導致空間重復(圖2f)。雖然其他方法(Peng et al., 2023; Lu et al., 2024b; Zhuo et al., 2024)在實現(xiàn)上與NTK不同,但它們都不可避免地遭受這兩種失敗模式中的一種或兩種:要么是運動減速,要么是內(nèi)容重復。

除了揭示這些局限性外,本文的發(fā)現(xiàn)還提供了對位置嵌入如何從根本上塑造時間運動的直觀理解,這為在下一節(jié)中的頻率成分分析提供了動機。

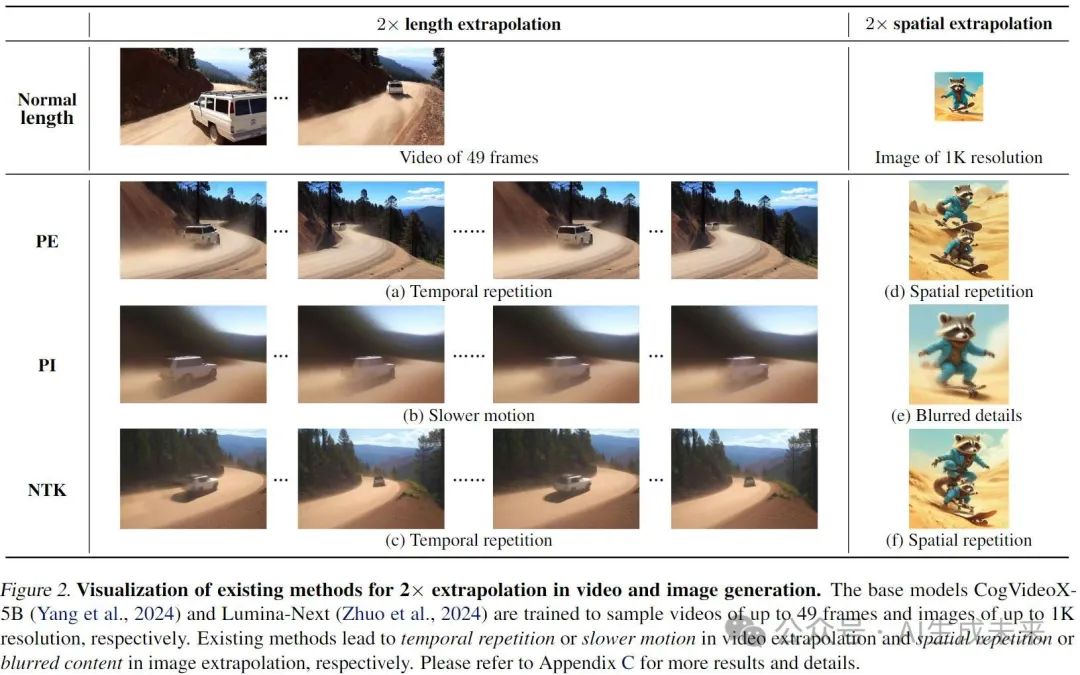

RoPE中的頻率成分分析

首先分析了RoPE(Su et al., 2021)中各個頻率成分的作用。為了簡化,專注于時間軸并省略下標。我們通過將其他頻率成分置零來隔離特定頻率成分,并在目標模型的訓練長度上進行微調(diào),以適應修改后的RoPE。通過這一分析,得出了兩個關鍵見解。

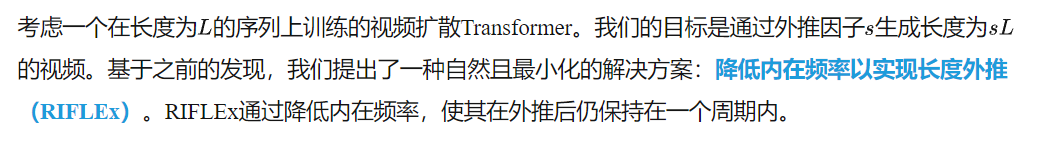

給定訓練L長度,時間重復的次數(shù)可以量化為:

令人驚訝的是,盡管N在不同視頻中存在輕微變化,但同一模型生成的不同視頻中,這種內(nèi)在頻率保持一致。例如,CogVideoX-5B的k為2,而HunyuanVideo的k為4。

在極少數(shù)情況下,如果模型在不同視頻中表現(xiàn)出不一致的內(nèi)在頻率,建議將所有此類頻率視為內(nèi)在頻率。我們的初步實驗進一步驗證了這一假設,表明將所有低頻成分納入我們的方法中仍能保持強大的性能,詳見附錄E的討論。

降低內(nèi)在頻率:一種最小化解決方案

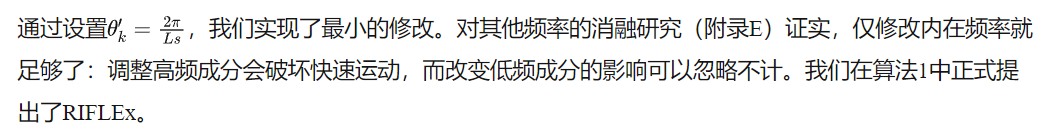

我們進一步研究了RIFLEx是否需要微調(diào)。令人驚訝的是,對于2倍外推,RIFLEx可以在無需訓練的情況下生成高質量視頻,如圖4所示。僅使用20,000個原始長度視頻和1/50,000的預訓練計算量進行微調(diào),可以進一步增強動態(tài)質量和視覺質量。

對于3倍外推,內(nèi)在頻率的變化過大,導致無需訓練的RIFLEx失效。然而,微調(diào)過程仍然成功,如圖4所示。

現(xiàn)有方法的理論解釋

我們的發(fā)現(xiàn)為第3.1節(jié)中觀察到的失敗模式提供了理論解釋。在PE和NTK中觀察到的重復現(xiàn)象源于它們的內(nèi)在頻率成分違反了公式(8)中的非重復條件。因此,生成的視頻內(nèi)容循環(huán)播放而不是自然推進。

PI和YaRN通過對高頻成分進行插值導致運動變慢,而這些成分對快速運動至關重要。在這些方法中,這些成分被除,因此無法生成快速運動。TASR結合了上述兩種方法,導致時間重復和運動減速的混合。更多細節(jié)和實驗請參見附錄C。

實驗

實驗設置

我們描述了數(shù)據(jù)集和評估設置,具體實現(xiàn)細節(jié)見表3(見附錄D)。

數(shù)據(jù)集:我們使用一個包含20,000個視頻的私有數(shù)據(jù)集進行微調(diào)。對于CogVideoX-5B,我們采用VBench的提示詞,以確保與之前的工作(Yang et al., 2024)一致。由于HunyuanVideo的高計算成本,我們使用100個跨多個類別的多樣化提示詞對其進行評估。

評估指標:根據(jù)之前的工作(Huang et al., 2024; Yang et al., 2024),我們使用圖像質量(Imaging Quality)、動態(tài)程度(Dynamic Degree)和主體一致性(Subject Consistency)來評估視頻生成,分別衡量視覺質量、運動幅度和時間一致性。此外,我們引入了無重復分數(shù)(NoRepeat Score),分數(shù)越高表示重復越少(詳見附錄D)。我們還進行了包含10名參與者的用戶研究,評估視覺質量、運動質量和整體偏好。運動質量反映了重復和慢動作的情況。用戶在所有外推方法中對偏好進行排名,允許并列。我們還對正常樣本和RIFLEx的結果進行了成對比較。更多細節(jié)見附錄D。

性能比較

結果:定量結果總結在表1中。我們的方法在整體性能上表現(xiàn)優(yōu)異,生成了新的時間內(nèi)容,同時不損害視頻質量的其他方面。例如,在CogVideoX-5B中,PI和YaRN因慢動作問題導致動態(tài)程度較低,而PE和NTK因重復問題導致無重復分數(shù)較低。通過有效解決這兩個挑戰(zhàn),我們的方法顯著提升了運動質量,并在用戶研究中在所有方法中排名最高。

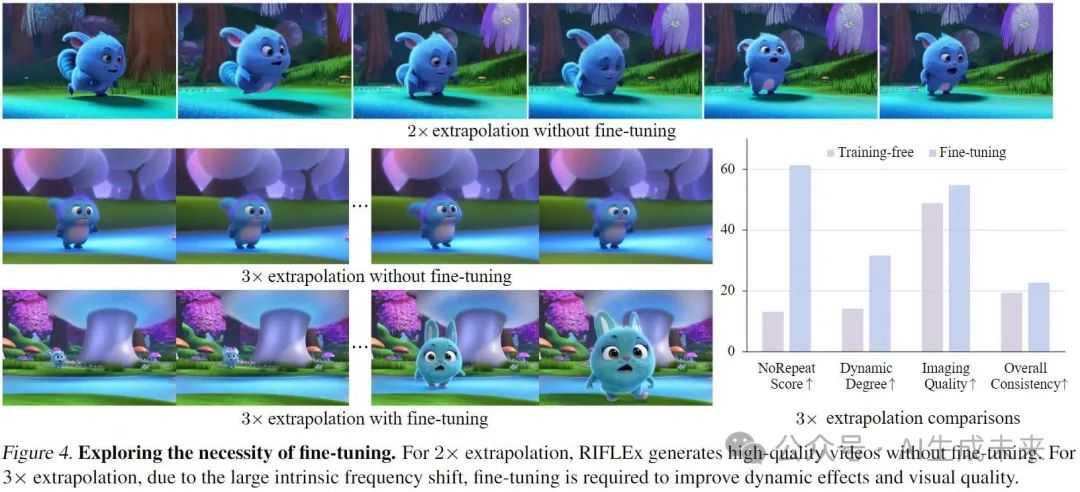

值得注意的是,NTK在HunyuanVideo的2倍外推中表現(xiàn)良好,但我們的分析將其歸因于意外的內(nèi)在頻率降低,恰好滿足了公式(8)中的非重復條件,而非其設計機制。這一點在NTK在CogVideo-X和HunyuanVideo的2.3倍外推中失敗時尤為明顯,反映在表1中的低無重復分數(shù)上。

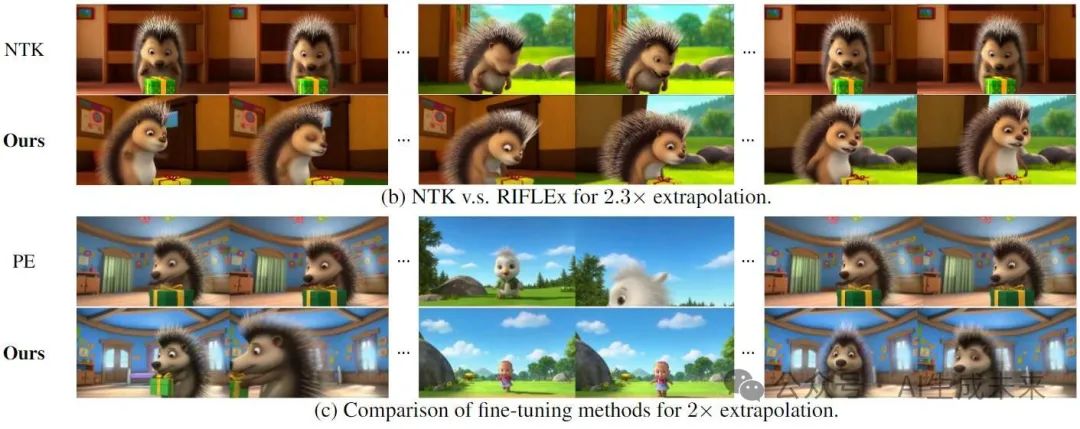

定性結果如圖5所示(HunyuanVideo),CogVideoX-5B的額外對比見附錄F。圖5與定量結果一致,展示了我們的方法在有效緩解慢動作和重復問題方面的能力,從而提高了整體視頻質量。此外,僅需1/50,000預訓練計算量的最小微調(diào)程序進一步提升了動態(tài)程度、圖像質量和無重復分數(shù)。最后,借助強大的HunyuanVideo基礎模型,我們的方法實現(xiàn)了接近訓練長度的性能——56.0%和61.6%的用戶更傾向于訓練長度而非我們的方法。

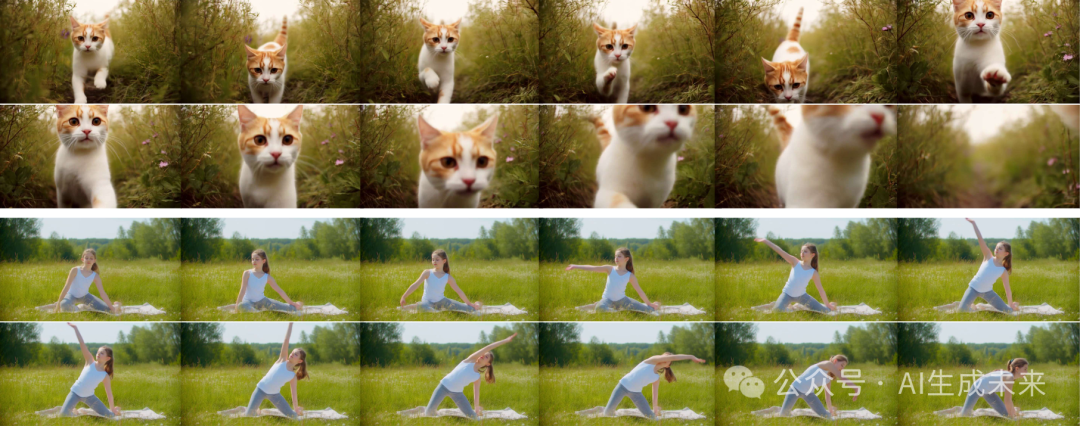

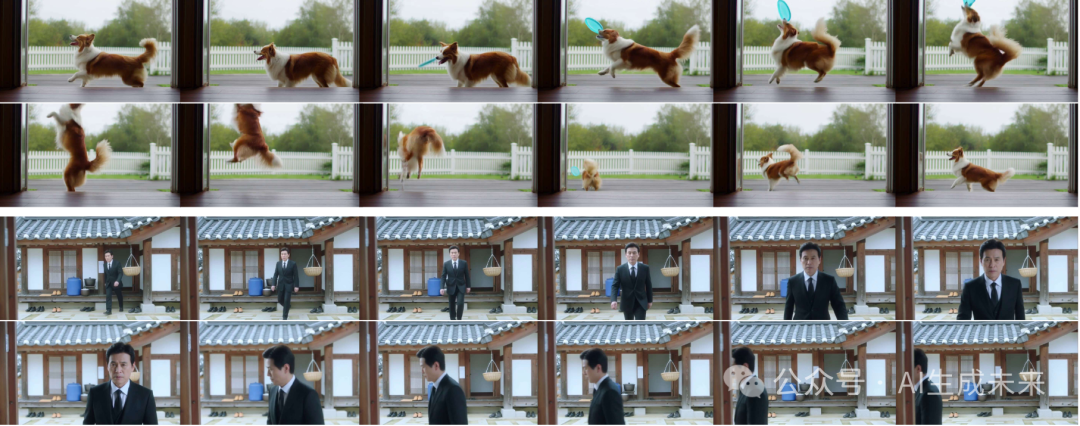

下圖5. 基于HunyuanVideo的長度外推可視化結果。通過有效解決慢動作和重復問題,實現(xiàn)了更好的視頻質量。值得注意的是,雖然HunyuanVideo中的NTK在2倍外推時偶然避免了重復,但在更長的外推(如2.3倍)時仍然遇到了顯著的重復問題。

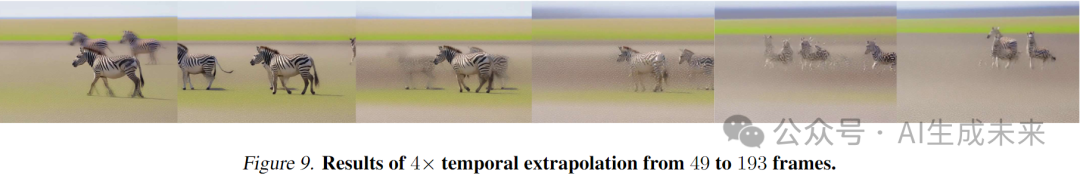

最大外推范圍:實驗表明,RIFLEx支持最多3倍外推,超過此范圍后質量顯著下降(例如4倍外推,見下圖9)。這可能是因為過度的頻率降低削弱了RoPE的有效性,導致在訓練長度內(nèi)的編碼變化極小。

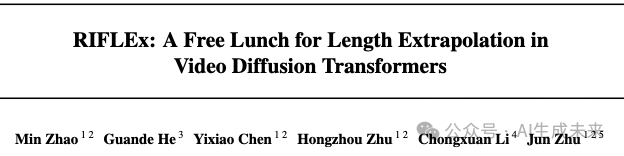

擴展到其他外推類型:進一步探索了RIFLEx在空間外推和聯(lián)合時空外推中的應用。如圖1b和圖1c所示,調(diào)整對應維度的內(nèi)在頻率可以實現(xiàn)分辨率外推和聯(lián)合時空擴展。

從129幀到261幀的2倍時間外推的更多結果

結論

通過分析RoPE中頻率成分的作用,提供了對視頻長度外推的全面理解。基于這些見解,提出了RIFLEx,這是一種簡單而有效的解決方案,通過降低內(nèi)在頻率來防止重復。RIFLEx在無需訓練的情況下,在SOTA視頻擴散Transformer上實現(xiàn)了高質量的2倍外推,并通過少量微調(diào)實現(xiàn)了3倍外推,且無需長視頻。

盡管在現(xiàn)有預訓練模型上證明了RIFLEx的有效性,但尚未探索其從頭訓練的性能,這留待未來工作。

本文轉自AI生成未來 ,作者:AI生成未來