超越Magic3D、ProlificDreamer,更靈活更可控的Text-to-3D擴散

論文鏈接:https://arxiv.org/pdf/2310.05375

代碼鏈接:https://github.com/zengbohan0217/IPDreamer

最近文本到3D生成以及單張圖片到3D生成驚艷的生成結果引來了越來越多研究者們的關注,然而這兩個方向都存在有各自小小的局限性,首先文本到3D生成的結果難以準確地控制生成結果的外觀,而單張圖片到3D生成雖然可以確定生成3D結果的外觀,但是目前主要的單張圖片到3D生成方法還是只能處理主體比較明確的圖片,難以處理復雜的圖片,并且約束比較強,無法靈活地控制生成結果。

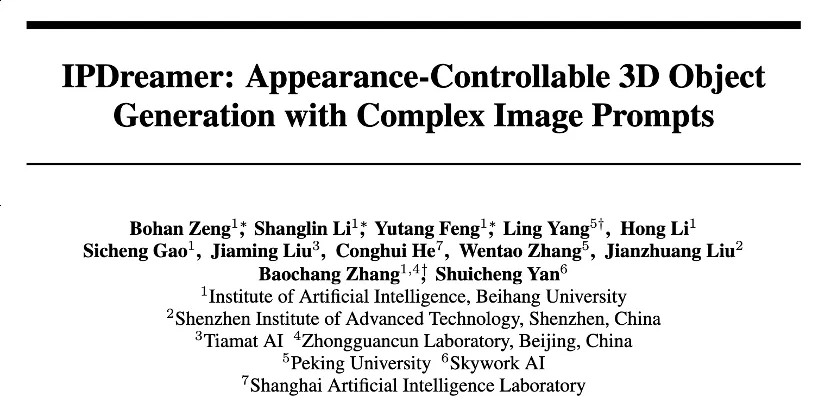

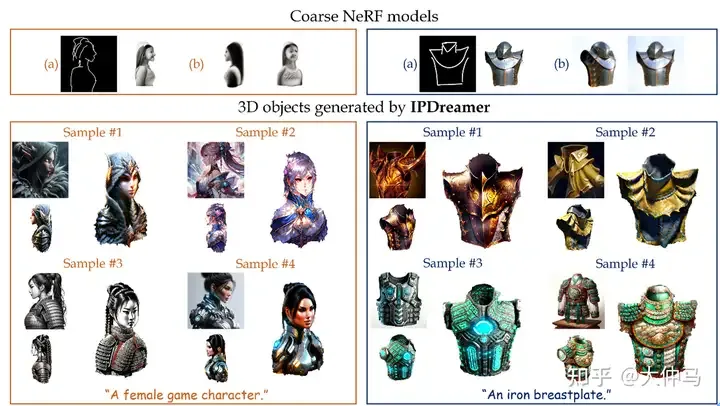

圖1

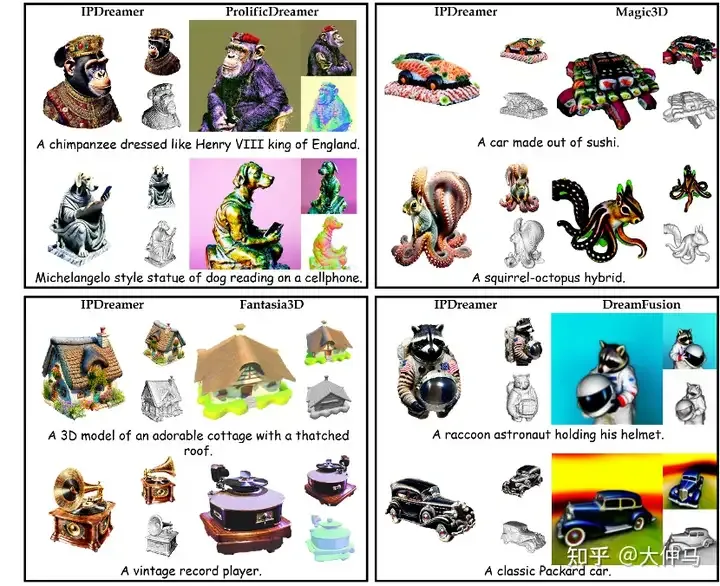

基于以上問題,本文工作向3D生成過程中引入了image prompt adaption,能夠利用圖片提示詞的特征來優化3D物體的幾何細節以及材質顏色,從而實現靈活、可控且高質量的3D生成。如圖1所示,我們可以將主體并不明確的復雜圖片風格高質量地遷移到粗糙的3D物體上。并且在文本到3D生成的效果上,我們的方法比DreamFusion、Magic3D、Fantasia3D以及ProlificDreamer等SOTA方法表現更好。

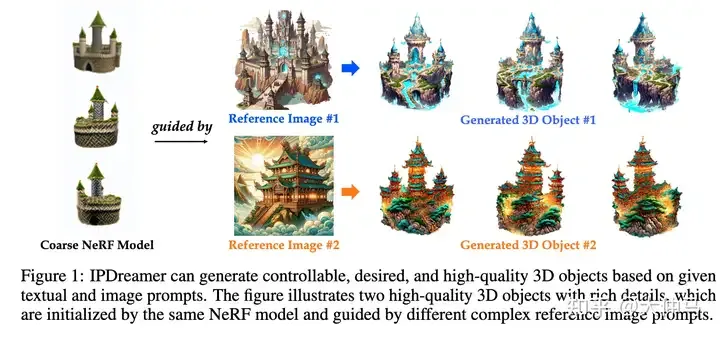

IPDreamer框架圖

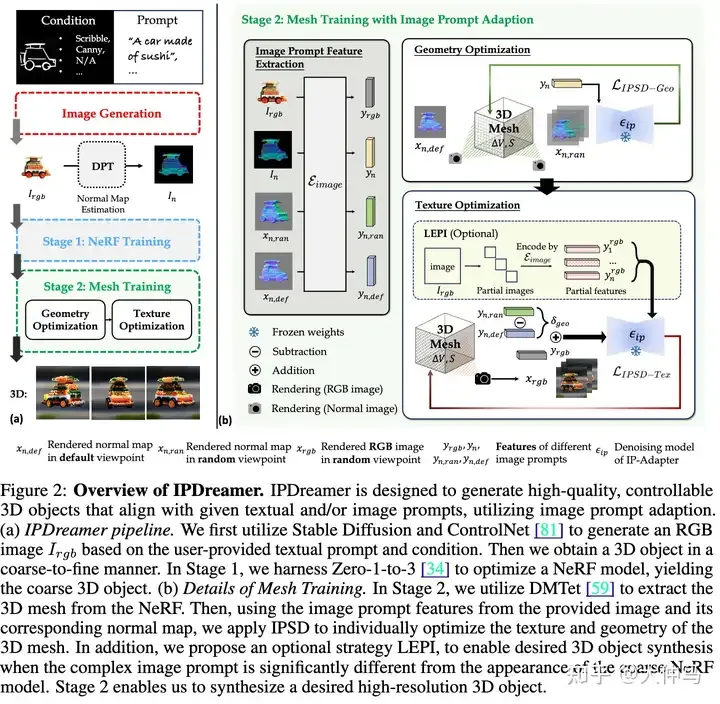

下面舉一個例子展示優化過程:

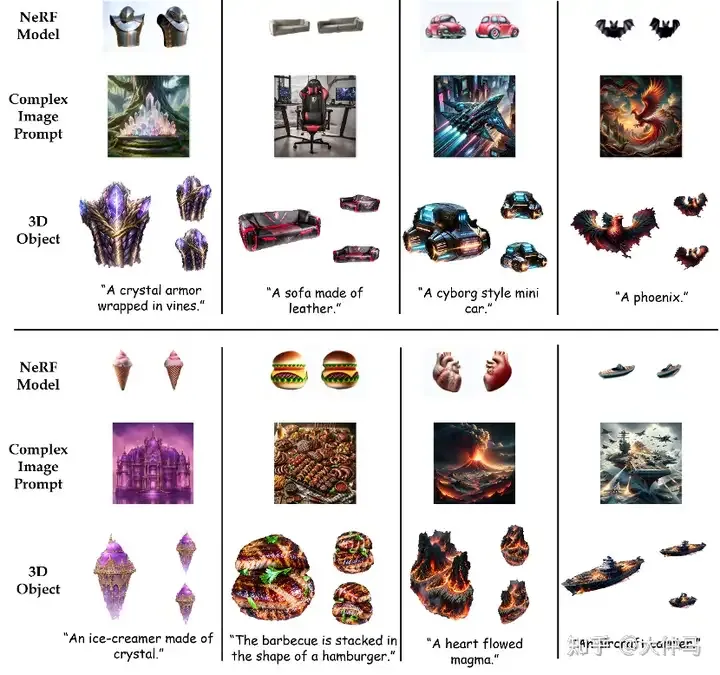

我們提出image prompt score distillation(IPSD),分別利用復雜圖片的法向圖以及圖片本身對應的圖片提示詞特征來優化3D物體的幾何細節以及顏色質地。

同時我們分析了為什么image prompt adaption可以很好地將復雜圖片提示詞的特征有效地定位到3D物體上。在優化過程中,圖片提示詞所對應的交叉注意力機制層計算得到的注意力圖會一一將復雜圖片提示詞不同部分的特征定位到3D物體2D渲染圖最合適的位置上。經過多輪的優化,復雜圖片的特征可以非常好地定位到3D物體上。

同一個3D物體使用不同的圖片提示詞進行編輯可以展現出更豐富的效果,大大擴充了3D生成的豐富性。

甚至當被編輯的3D物體與提供的圖片提示詞形象上差異比較大的時候也可以很好地實現生成

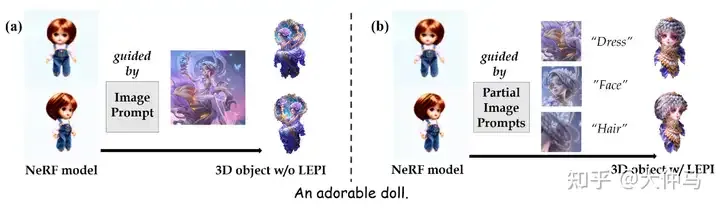

我們還發現,當被引導的粗糙的NeRF模型與復雜圖片提示詞有巨大差異時,僅僅使用交叉注意力機制曾進行特征定位難以生成理想的3D物體,為此我們提出了local editing with partial images(LEPI)策略來改進特征定位,從而更加靈活可控地生成理想的3D物體。我們借助多模態大模型以及SAM將復雜圖片提示詞分為若干個“部分圖片”,如圖5所示,同時每一個“部分圖片”被提供了一個單詞描述,我們借助這個描述在交叉注意力層中計算對應的mask,利用這個mask將對應的“部分圖片”的特征定位到3D物體上。

圖5

一些極端情況下,利用LEPI確實能產生更好的效果

更多的生成結果,證明了LEPI,即我們IPDreamer方法的穩定性與泛化性

此外我們的方法還可以完成文本到3D生成,如圖8所示,我們的方法相較于以往的文本到3D生成方法,可以生成更加高質量的復雜的3D物體。

圖8

本文轉自 AI生成未來 ,作者:大仲馬