SIGGRAPH 2025 | 快手可靈團隊提出3D感知的電影級文本到視頻生成框架CineMaster

?

Sora、可靈等視頻生成模型令人驚艷的性能表現使得創作者僅依靠文本輸入就能夠創作出高質量的視頻內容。然而,我們常見的電影片段通常是由導演在一個場景中精心布置多個目標的運動、攝像機拍攝角度后再剪輯而成的。例如,在拍攝賽車追逐的場景時,鏡頭通常跟隨賽車運動,并通過扣人心弦的超車時刻來展示賽事的白熱化。而如今的視頻生成模型無法實現 3D 場景中目標、相機聯合控制的文本到視頻創作,限制了 AI 影視制作的能力。

近期,可靈研究團隊在「3D 感知可控視頻生成」領域做出了首次嘗試,推出了電影級文本到視頻生成框架 CineMaster,允許用戶在提供全局文本描述的基礎上,通過提出的交互式工作流輔助用戶像專業導演一樣布置場景,設定目標與相機的運動,指導模型生成用戶想要的視頻內容。目前該論文已錄用于 SIGGRAPH 2025。

?

- 論文標題:CineMaster: A 3D-Aware and Controllable Framework for Cinematic Text-to-Video Generation

- 論文地址:https://arxiv.org/abs/2502.08639

- 項目主頁:https://cinemaster-dev.github.io/

?

一、支持3D感知的目標、相機運動控制

一、支持3D感知的目標、相機運動控制一、支持3D感知的目標、相機運動控制

a)目標相機聯合控制:

?

b)目標運動控制:

?

c)相機運動控制:

?

?

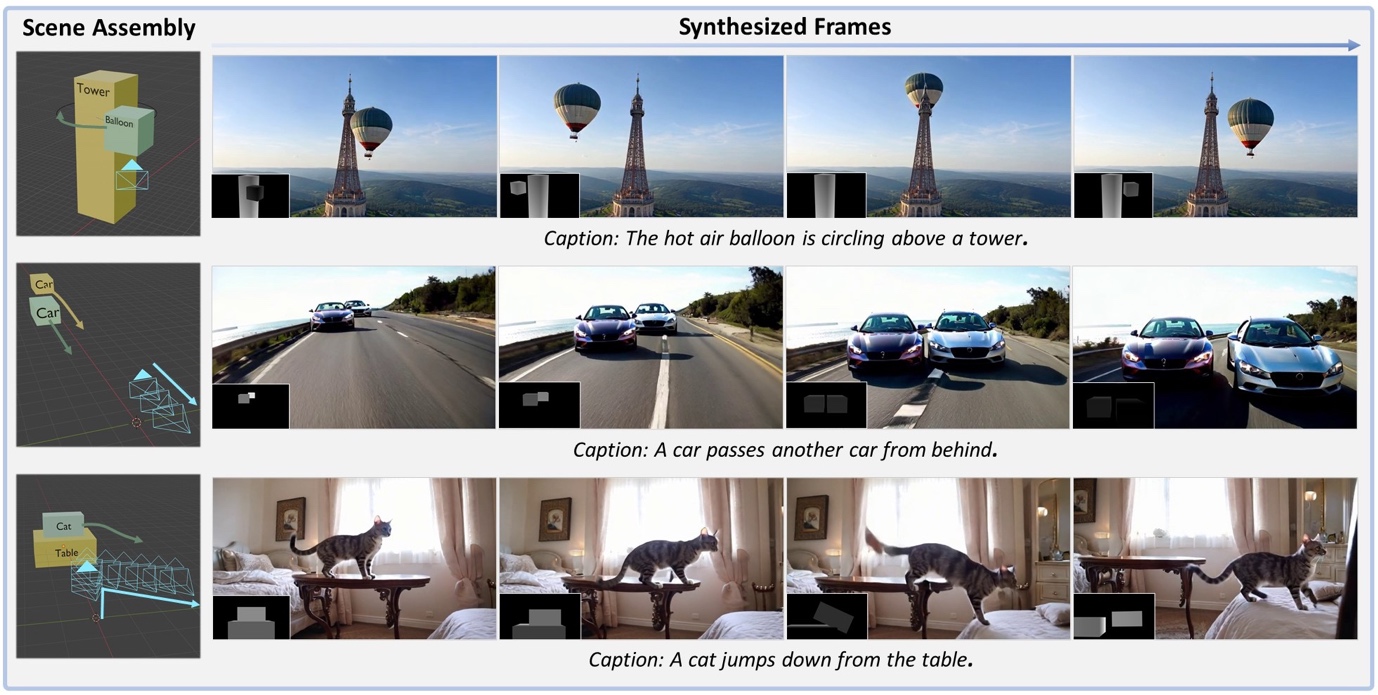

可以觀察到,CineMaster可以根據用戶提供的多模態細粒度的控制信號生成期望的視頻,支持較大幅度的目標、相機運動的可控生成。

二、CineMaster 框架

二、CineMaster 框架

CineMaster通過兩階段的工作流,實現高度可控的文本到視頻生成:

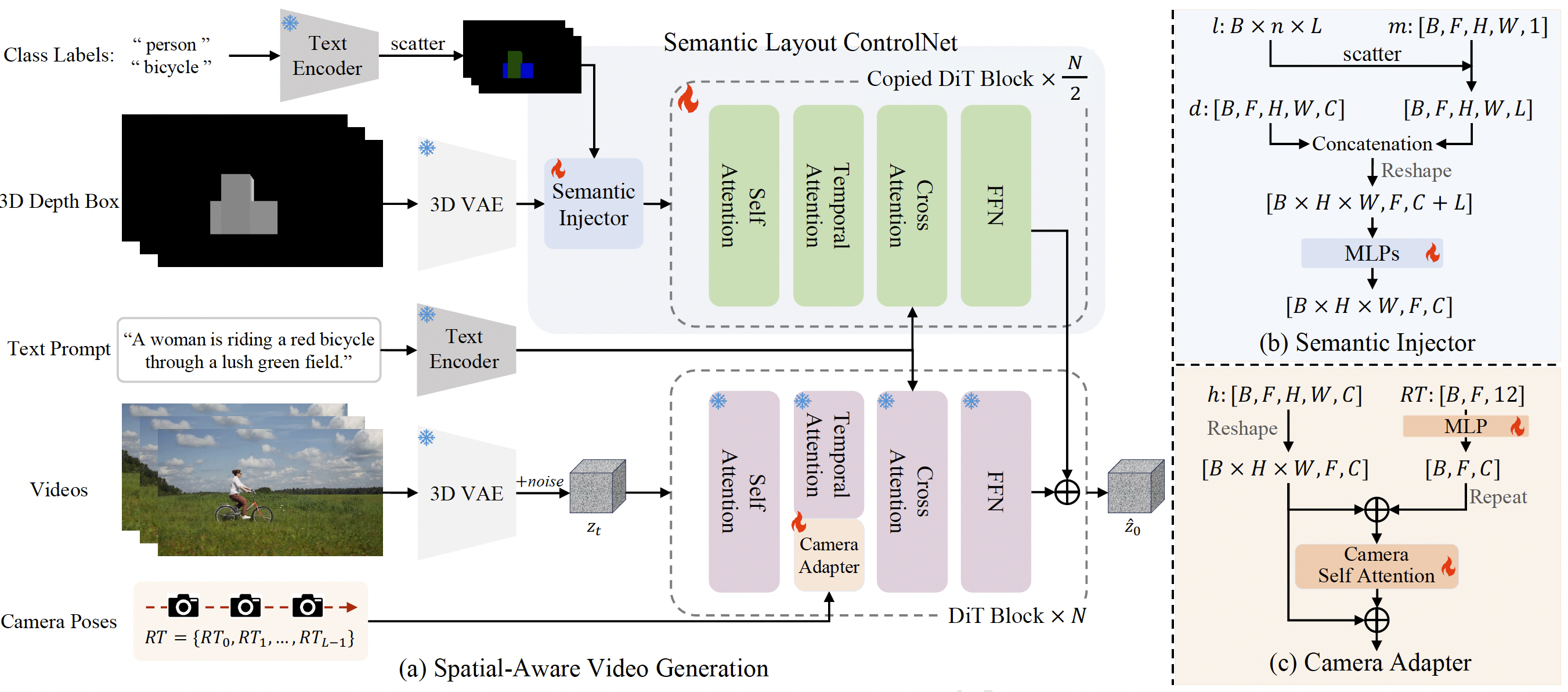

階段1:構建3D感知的控制信號:用戶可以通過交互式界面在 3D 空間中調整物體的邊界框(3D Bounding Box)和攝像機位置,這個過程類似于真實的電影拍攝過程,即導演多次調整演員在場景中的排布和相機的運動。隨后,導出相機軌跡和每幀的投影深度圖,作為后續生成的條件信號。

階段2:如圖所示,該方法框架通過語義布局ControlNet的架構集成了物體的運動控制信號和物體的類別標簽信息,從而明確地控制每個目標的運動。此外,通過Camera Adapter集成了相機運動控制信號表示視頻序列的全局運動。

?

三、CineMaster訓練數據構建流程

三、CineMaster訓練數據構建流程

?

數據構建流程旨在從任意視頻中提取 3D bounding boxes、類別標簽、視頻相機軌

跡,主要包含 4 個步驟:

- 通過 Qwen2-VL 增強的實體描述提升開放詞匯目標檢測模型 Grounding DINO 的性能,并通過 SAM v2 實現視頻實例分割;

- 利用 DepthAnything V2 估計視頻的絕對深度;

- 在每個目標的 Mask 最大幀通過深度投影分割結果到點云空間計算 3D bounding box;

- 訪問由 Spatial Tracker 實現的 3D 點跟蹤結果,計算所有目標在視頻序列中的 3D bounding box,并投影整個 3D 場景得到深度圖。

此外,該框架利用 MonST3R 計算了視頻的相機軌跡。

四、四、對比結果對比結果

四、對比結果

上圖中研究者將 CineMaster 與基線方法進行了比較。據觀察,基線方法無法顯式地關聯給定的運動條件和相應的目標,也存在目標運動和相機運動耦合的問題。而 CineMaster 可以合成符合文本提示、目標、相機控制信號的高質量視頻。請訪問項目主頁查看視頻結果。

五、總結

在本文中,研究者期望為用戶提供強大的 3D 感知的可控視頻生成能力,讓用戶能夠像專業導演一樣創作。為此,首先設計了一個 3D 感知的交互工作流,允許用戶直觀地編輯目標和相機的運動;隨后開發了一個多模態條件控制視頻生成模型,生成用戶想要的視頻。此外,該方法精心設計了一套從任意視頻中提取 3D 控制信號的數據構建流程,為 3D 可控視頻生成領域的研究提供了實踐經驗。

更多細節請參閱原論文。