簡單卻強大!端到端視覺Tokenizer調優讓多模態任務性能飆升!智源&盧湖川團隊等發布ETT

文章鏈接:https://arxiv.org/pdf/2505.10562

亮點直擊

- 提出了一種新的視覺分詞器訓練范式,以釋放視覺分詞器在下游自回歸任務中的潛力。該視覺分詞器能夠感知并針對下游訓練進行優化。

- 引入了一種簡單而有效的端到端視覺分詞器調優方法ETT。ETT利用分詞器的碼本嵌入而不僅限于離散索引,并應用詞級描述損失來優化視覺分詞器的表示。

- ETT顯著提升了基于下一詞預測范式的下游任務結果,包括多模態理解和生成任務,同時保持了分詞器的重建性能。

總結速覽

解決的問題

- 現有視覺分詞器(vision tokenizer)的訓練與下游任務解耦,僅針對低層重建(如像素級)優化,無法適應不同下游任務(如圖像生成、視覺問答)的多樣化語義需求。

- 分詞過程中的信息損失可能成為下游任務的性能瓶頸(例如圖像中文本的分詞錯誤導致生成或識別失敗)。

- 現有自回歸模型僅使用分詞器的離散索引,忽略了視覺嵌入表示的學習,導致視覺-語言對齊困難。

提出的方案

- 端到端聯合優化:將視覺分詞器與下游自回歸任務(如文本生成)共同訓練,同時優化分詞器的重建目標和下游任務目標(如描述生成)。

- 利用詞嵌入而非離散索引:引入分詞器碼本(codebook)的連續視覺嵌入表示,而非僅使用離散索引,增強視覺語義學習。

- 保持簡潔性:無需修改大語言模型(LLM)的原始文本碼本或架構,僅通過調整分詞器的訓練方式提升性能。

應用的技術

- 多任務聯合訓練:結合圖像重建損失(如VQ-VAE的量化損失)和下游任務損失(如描述生成損失)。

- 連續嵌入表示:通過分詞器的碼本嵌入(而非離散token索引)傳遞視覺信息,改善視覺-語言對齊。

- 輕量化集成:直接復用現有分詞器和LLM的架構,僅通過梯度回傳優化分詞器的碼本表示。

達到的效果

- 性能提升:在多模態理解(如視覺問答)和視覺生成任務上,相比凍結分詞器的基線模型,性能提升2%-6%。

- 保留重建能力:在優化下游任務的同時,不損害分詞器的原始圖像重建能力。

- 通用性與易用性:方法簡單易實現,可無縫集成到現有多模態基礎模型(如Emu3)中,適用于生成和理解任務。

方法論

視覺分詞器

端到端視覺分詞器調優

從離散索引到碼本嵌入。Emu3等類似方法僅在下游任務中使用視覺分詞器的離散索引,丟棄了視覺分詞器嵌入的豐富表示能力。這些方法僅依賴離散碼本索引,阻礙了梯度傳播,使得端到端訓練無法實現。為解決這一限制,本文提出ETT,直接將視覺分詞器的碼本嵌入連接到 LLM,有效利用視覺分詞器中編碼的更豐富特征表示,同時實現端到端訓練。

多模態生成與理解的訓練方案

下游多模態感知與生成的完整訓練流程包含三個連續訓練階段。采用的訓練數據由公開圖像數據集構成,并輔以如下表 1 所示的多樣化理解和生成指令數據。

階段1:對齊學習

階段2:語義學習

階段3:后訓練

通過端到端調優獲得增強版視覺分詞器后,采用標準后訓練流程實現多模態理解與生成。本階段凍結視覺分詞器,調優視覺投影層和LLM層,分別訓練兩個專用模型:

- ETT-Chat:增強多模態理解中的指令跟隨能力,使用SOL-recap、LLaVA-OneVision和Infinity-MM等多源高質量指令數據

- ETT-Gen:優化文本到圖像生成,包含1400萬Flux模型生成的AI樣本,以及從開源網絡數據篩選的1600萬圖文對(基于圖像分辨率和LAION美學評分)

實驗結果

訓練設置

數據準備。(1)視覺語言預訓練&視覺分詞器數據集。采用[8]的預處理流程優化SA-1B、OpenImages和LAION,分別得到11M、7M和14M張圖像。使用[8]的標題生成引擎產出32M條高質量描述。(2)監督微調數據集。對于理解任務,從Infinity-MM提取31.8M個多任務樣本,從LLaVA-OneVision篩選3.5M條優先復雜對話結構的指令數據;對于生成任務,通過Flux模型生成14M個AI創作樣本,并從開源網絡數據精選16M個圖文對,基于圖像分辨率和美學評分進行過濾。

多模態理解評估

在主流視覺語言感知基準上驗證ETT,包括:任務專項評估(GQA、TextVQA)、幻覺檢測(POPE)、開放域多模態理解(MME、MMBench、SEED-Bench、MM-Vet)以及科學推理(ScienceQA-IMG)。

如下表2所示,ETT在更小模型和數據規模下,持續超越Chameleon、LWM、Liquid等離散方法,凸顯端到端調優策略的高效性。相比Show-o,ETT在顯著減少訓練數據的同時實現更優性能,證明其數據利用策略的有效性。與QwenVL-Chat、EVE、Janus等基于連續編碼器的SOTA視覺語言模型相比,ETT在不依賴額外視覺編碼器的情況下仍具競爭力,既簡化架構又降低計算開銷。ETT的成功源于視覺分詞器的端到端訓練方案,其有效協調了多模態理解與生成的內在沖突。

視覺生成評估

在GenEval和T2I-CompBench基準上,全面評估文本到圖像生成能力,對比基于擴散和自回歸的SOTA方法(含專業模型與通用模型)。如下表3所示,在top-k=131,072(視覺詞表大小)和top-p=1.0的推理配置下,本文的方法以較少LLM參數和小規模訓練數據取得0.63的綜合得分,超越SDXL等擴散模型。相比LlamaGen(專業模型)和Chameleon(通用模型)等自回歸方法,ETT所需訓練數據或參數量更少。結合提示詞改寫后,其性能逼近DALL-E3和EMU3等領先模型。在T2I-CompBench上,ETT在顏色、形狀、紋理三個維度分別取得81.03、58.19和72.14分,與基于擴散的SOTA模型相當。這些結果充分驗證了端到端視覺分詞器調優方案的有效性。

下圖2展示了ETT生成的定性結果,可見其能準確遵循提示詞生成多樣化視覺內容。該模型擅長處理不同藝術風格、主體和背景的圖像生成,可適應多種構圖結構和審美偏好。

消融實驗

為驗證ETT對下游多模態生成與理解任務的有效性,本文在多個主流理解基準(如SEEDBench-Img、GQA、TextVQA和MME-Perception)及文本到圖像生成評估數據集GenEval上進行了全面消融研究。

端到端調優優勢。首先探究ETT對促進多模態下游任務的有效性。為公平驗證ETT優化視覺分詞器特征表示的潛力,所有理解與生成任務模型均采用SOL-recap訓練,理解任務額外使用LLaVA-mix-665K進行監督微調。如下表4所示,相比傳統分詞器利用方式,引入ETT在理解與生成任務上均帶來顯著性能提升。未采用端到端調優時,用碼本嵌入替換離散索引可部分緩解信息損失問題,在多模態理解基準上帶來明顯增益;盡管該替換會降低視覺生成性能,但其建立了完全可微的模型架構,為端到端優化奠定基礎。在此基礎之上,引入視覺分詞器的端到端調優相比傳統設置(即首行)進一步提升了理解與生成性能,尤其在依賴視覺特征的任務上表現突出(如通用視覺問答↑5%、光學字符識別↑6%)。

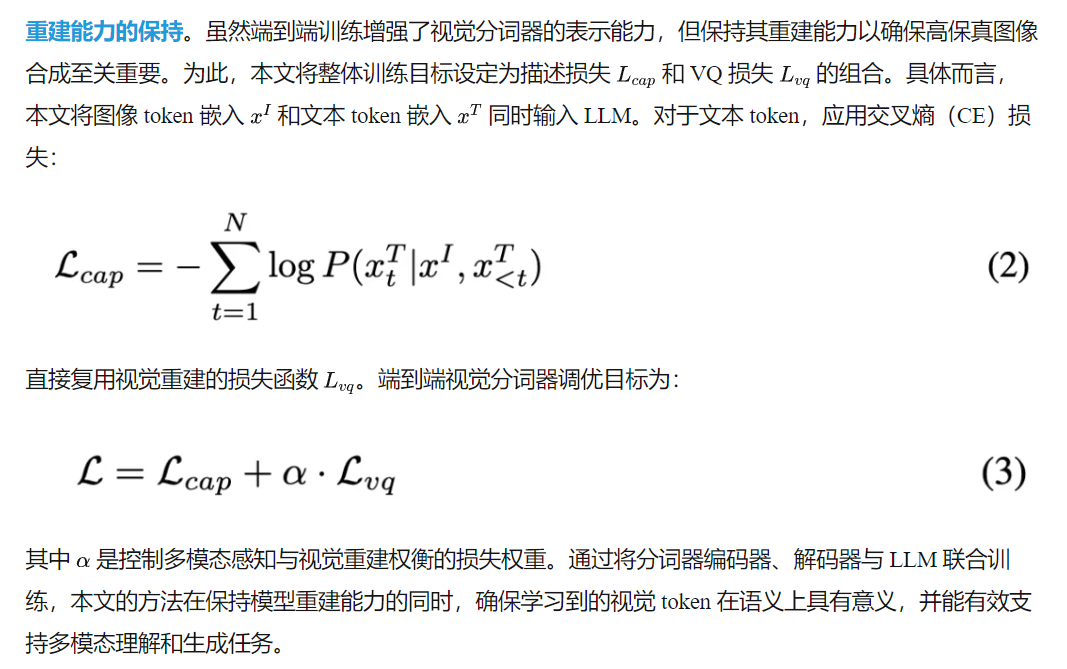

理解與重建的權衡。進一步研究ETT在視覺重建與多模態理解之間的內在任務權衡。如下表5所示,相比未調優基線(首行),調優視覺分詞器始終為理解任務帶來顯著收益,但會以不同程度犧牲重建性能。僅用圖像到文本理解任務調優分詞器(第二行)在各類理解基準上取得最佳性能,但重建質量大幅下降(ImageNet 256X256設置的rFID從1.033驟降至45.701);引入權重0.25的輔助重建目標后,理解精度略有下降而重建質量顯著改善(rFID從45.701提升至1.648),表明聯合訓練理解與重建任務的重要性;將重建權重α增至1.0可獲得最佳重建rFID 1.500,但會導致感知能力最弱。因此本文選擇α=0.25作為默認重建損失權重以平衡兩項任務。

下圖3可視化對比了引入ETT前后的重建結果。經ETT調優的視覺分詞器在保持與原模型相當的低級視覺細節同時,增強了文本渲染等特定方面,表明ETT既能保留豐富的底層細節,又能改善高層語義表征。

結論

本研究致力于解決多模態學習中視覺分詞器的表征瓶頸問題,提出了一種簡單而有效的端到端視覺分詞器調優方法ETT。該方法通過采用碼本嵌入替代純離散索引,并施加分詞級標題損失來實現分詞器與下游訓練的聯合優化。實驗表明,ETT在幾乎保持分詞器重建能力(甚至提升文本渲染等特定方面的重建性能)的同時,顯著提升了純解碼器架構下的多模態理解與生成能力。

局限性與未來方向

當前工作的主要局限在于:端到端微調的數據規模和模型容量仍有擴展空間,以進一步提升視覺表征與下游任務性能。此外,現有方法聚焦于通過優化現有視覺分詞器的視覺特征(利用LLM的語義能力)來構建簡單有效的框架,而非從頭設計兼具理解與生成能力的視覺分詞器。雖然ETT證明了LLM驅動的語義反饋對增強視覺分詞的有效性,但其仍依賴于對已有分詞器的微調而非從零開發。因此,未來本文將探索從零開始端到端訓練視覺分詞器,以構建更全面、適應性更強的多模態表征方案。另外,突破圖像與文本模態的局限(如引入視頻與音頻)也是值得探索的前沿方向。本文希望這一簡單有效的方法能為超越視覺生成與理解的多模態基礎模型發展提供啟示。

本文轉自AI生成未來 ,作者:AI生成未來