「無需配對數據」就能學習!浙大等提出連接多模態(tài)對比表征C-MCR

多模態(tài)對比表示(multi-modal contrastive representation, MCR)的目標是將不同模態(tài)的輸入編碼到一個語義對齊的共享空間中。

隨著視覺-語言領域中CLIP模型的巨大成功,更多模態(tài)上的對比表征開始涌現出來,并在諸多下游任務上得到了明顯的提升,但是這些方法嚴重依賴于大規(guī)模高質量的配對數據。

為了解決這個問題,來自浙江大學等機構的研究人員提出了連接多模態(tài)對比表示(C-MCR),一種無需配對數據且訓練極為高效的多模態(tài)對比表征學習方法。

論文地址:https://arxiv.org/abs/2305.14381

項目主頁:https://c-mcr.github.io/C-MCR/

模型和代碼地址:https://github.com/MCR-PEFT/C-MCR

該方法在不使用任何配對數據的情況下,通過樞紐模態(tài)連接不同的預訓練對比表征,我們學習到了強大的音頻-視覺和3D點云-文本表征,并在音頻-視覺檢索、聲源定位、3D物體分類等多個任務上取得了SOTA效果。

介紹

多模態(tài)對比表示(MCR)旨在將不同模態(tài)的數據映射到統(tǒng)一的語義空間中。隨著CLIP在視覺-語言領域的巨大成功,學習更多模態(tài)組合之間的對比表示已成為一個熱門研究課題,吸引了越來越多的關注。

然而,現有多模態(tài)對比表示的泛化能力主要受益于大量高質量數據對。這嚴重限制了對比表征在缺乏大規(guī)模高質量數據的模態(tài)上的發(fā)展。例如,音頻和視覺數據對之間的語義相關性往往是模糊的,3D點云和文本之間的配對數據稀缺且難以獲得。

不過,我們觀察到,這些缺乏配對數據的模態(tài)組合,往往和同一個中間模態(tài)具有大量高質量配對數據。比如,在音頻-視覺領域,盡管視聽數據質量不可靠,但音頻-文本和文本-視覺之間存在大量高質量的配對數據。

同樣,雖然3D點云-文本配對數據的可用性有限,但3D點云-圖像和圖像-文本數據卻非常豐富。這些樞紐模態(tài)可以為模式之間建立進一步關聯(lián)的紐帶。

考慮到具有大量配對數據的模態(tài)間往往已經擁有預訓練的對比表示,本文直接嘗試通過樞紐模態(tài)來將不同模態(tài)間的對比表征連接起來,從而為缺乏配對數據的模態(tài)組合構建新的對比表征空間。

連接多模態(tài)對比表示(C-MCR)可以通過重疊模態(tài)為現有大量多模態(tài)對比表示構建連接,從而學習更廣泛的模態(tài)之間的對齊關系。其中,學習過程不需要任何配對數據且極為高效。

C-MCR具有兩個關鍵優(yōu)勢:

1. 靈活性:

C-MCR能夠為缺乏直接配對配對的模態(tài)學習對比表征。從另一個視角來看,C-MCR將每個已有的多模態(tài)對比表示空間視為一個節(jié)點,并將不同表示空間的重疊模態(tài)視為樞紐模態(tài)。

通過連接各個孤立的多模態(tài)對比表征,我們可以靈活地擴展了獲得的多模態(tài)對齊知識,并挖掘出更廣泛模態(tài)間的對比表示。

2、高效性:

由于C-MCR僅需為已有的表征空間構建連接,因此只用學習兩個簡單的映射器,其訓練參數和訓練成本都是極低的。

實驗利用文本作為樞紐連接視覺-文本(CLIP)和文本-音頻(CLAP)對比表示空間,獲得了高質量的視覺-音頻表示。

類似地,通過使用圖像連接文本-視覺(CLIP)和視覺-3D點云(ULIP)對比表示空間,也可以獲得一組3D點云-文本對比表示。

方法

圖1 (a) 介紹了C-MCR的算法流程(以使用文本連接CLIP和CLAP為例)。

文本(重疊模態(tài))的數據分別被CLIP和CLAP的文本編碼器編碼為文本特征:、。

同時,大量非配對單模態(tài)數據也分別被編碼到CLIP和CLAP空間,構成image memory 和 audio memory

1. 特征語義增強

我們首先提出從語義一致性和語義完整性兩個角度來增強表征中的語義信息,從而實現更魯棒更全面的空間連接。

模態(tài)間語義一致性

CLIP和CLAP分別已經學到了可靠的對齊的圖像-文本和文本-音頻表征。

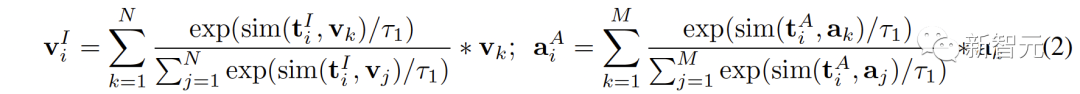

我們利用CLIP和CLAP中這種內在的模態(tài)對齊性來生成與第i個文本語義一致的圖像和音頻特征,從而更好地量化對比表征空間中的modality gap以及更直接的挖掘非重疊模態(tài)間的關聯(lián)性:

模態(tài)內語義完整性

不同表征空間對于數據的語義表達會有不同的傾向性,因此不同空間下的同一個文本也會不可避免的存在語義偏差和丟失。在連接表示空間時,這種語義偏差會被累積并且放大。

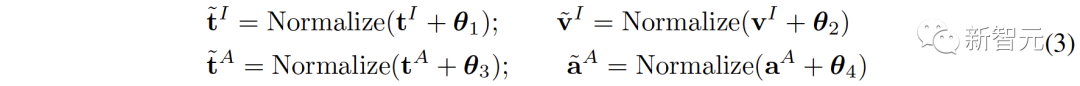

為了增強每個表征的語義完整性,我們提出將零均值高斯噪聲添加到表征中,并將它們重新歸一化為單位超球面上:

如圖1 (c) 中所示,在對比表征空間中,每個表征可以看代表是在單位超球面上的一個點。添加高斯噪聲并重新歸一化則使表征能夠代表了單位球面上的一個圓。

因為兩個特征的空間距離越接近,其語義相似度也越高。所以圓內的特征都具有相似語義,圓所能表示的語義更加完整。

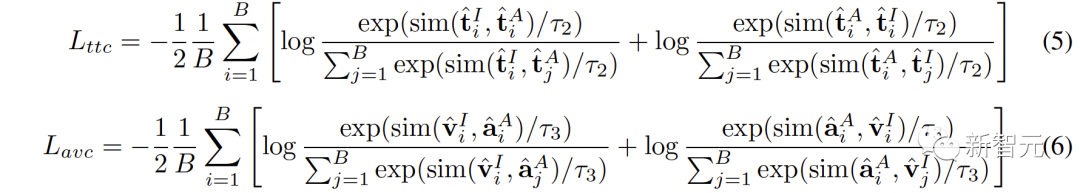

2. Inter-MCR的對齊

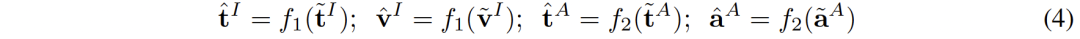

完成表征語義增強后,我們學習兩個映射器 和 來分別將CLIP和CLAP表征重新映射到一個新的共享空間:

新空間需要確保來自不同空間的語義相似的表征彼此接近。

來源于同一文本的 (,

) 是天然語義一致的,可以被看做真實標簽對,而源自于 (

,

) 的 (

,

) 可以被視為偽標簽對。

(,

) 之間的語義高度一致,但從它們中學習到的連接對于音頻-視覺來說是間接的。 而(

,

)對的語義一致性雖然不太可靠,但其更直接地有利于音頻-視覺表征。

為了更全面地連接兩個對比表征空間,我們同時對齊 (,

) 和 (

,

):

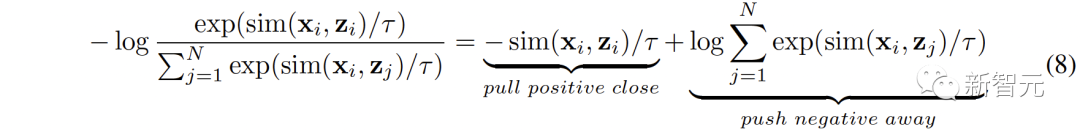

3. Intra-MCR的對齊

除了空間之間的連接,對比表征空間內部還存在著modality gap的現象。即在對比表征空間中,不同模態(tài)的表征雖然語義對齊,但它們分布在完全不同的子空間中。這意味著從 (,

) 學習到的更穩(wěn)定的連接可能不能很好的被音頻-視覺繼承。

為了解決這個問題,我們提出重新對齊各個對比表征空間的不同模態(tài)表征。具體來說,我們去除對比損失函數中的負例排斥結構,來推導出用于減小modality gap的損失函數。典型的對比損失函數可以表述為:

我們去除其中負對排斥項,最終的公式可以被簡化為:

實驗

實驗上,我們通過使用文本連接音頻-文本空間(CLAP)和文本-視覺空間(CLIP)來獲得音頻-視覺表征,使用圖像連接3D點云-圖像空間(ULIP)和圖像-文本空間(CLIP)來獲得3D點云-文本表征。

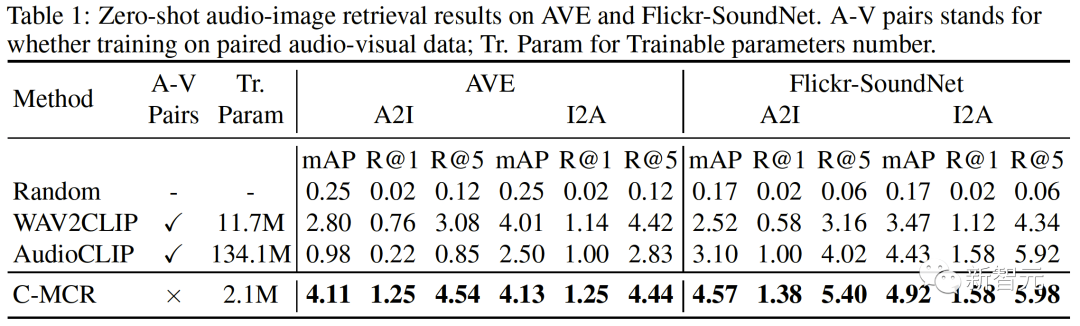

在AVE和Flickr-SoundNet上的zero-shot 音頻圖像檢索結果如下:

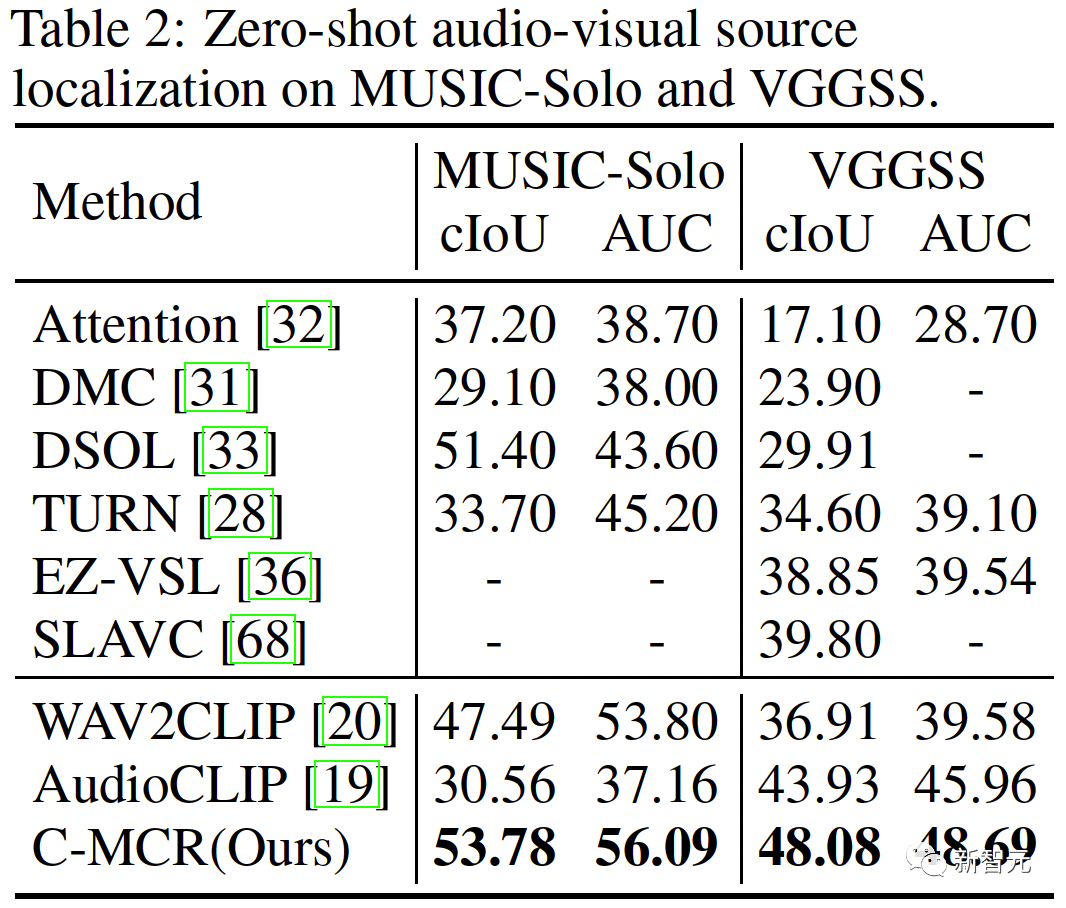

在MUSIC-Solo和VGGSS上的zero-shot 聲源定位結果如下:

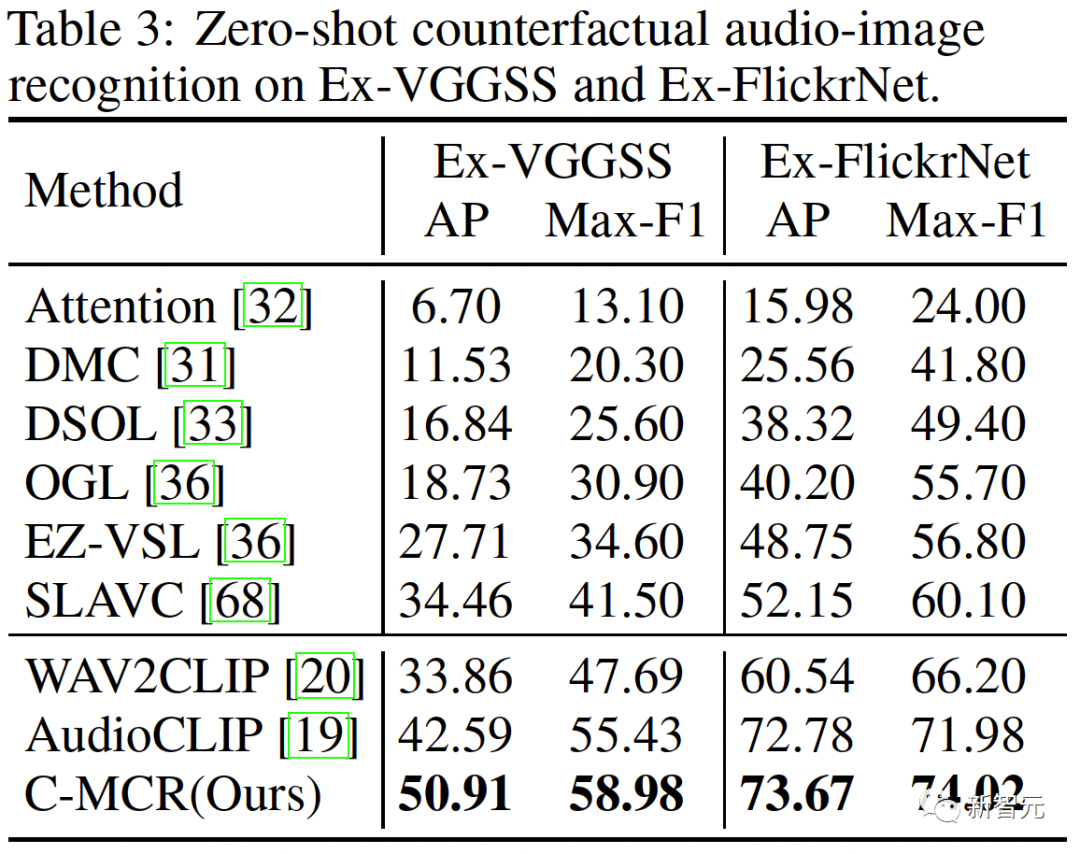

在Ex-VGGSS和Ex-FlickrNet上的zero-shot反事實音頻圖像識別結果如下:

在ModelNet40上的zero-shot 3D點云分類結果如下: