拖動圖像編輯再升級!北大、騰訊提出DragonDiffusion,在擴散模型上啟用拖動式操作

北大、騰訊提出的DragonDiffusion可以對生成或真實的圖像進行多種編輯,包括移動物體、調整物體大小、替換物體外觀、拖動內容等。值得注意的是,所有編輯和內容保存信號都來自圖像本身,模型不需要微調或額外的模塊。

論文介紹

盡管現有的大規模文本轉圖像 (T2I) 模型能夠從詳細的文本描述生成高質量的圖像,但它們往往缺乏對生成或真實圖像進行精確編輯的能力。在本文中,我們提出了一種新穎的圖像編輯方法DragonDiffusion,可在擴散模型上實現Drag式的操作。

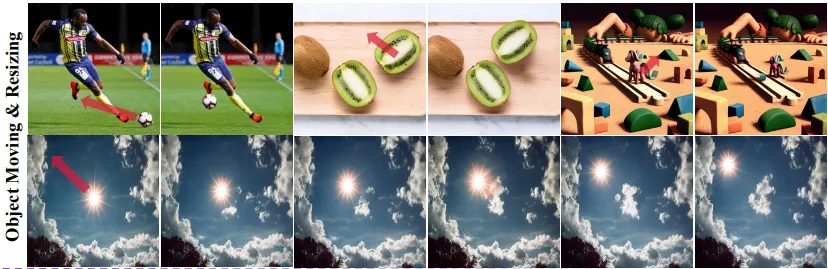

具體而言,我們根據擴散模型中中間特征的強對應性構建分類器指導。它可以通過特征對應損失將編輯信號轉換為梯度,以修改擴散模型的中間表示。基于這種指導策略,我們還構建了一個多尺度指導,以考慮語義和幾何對齊。此外,還添加了跨分支自注意力以保持原始圖像和編輯結果之間的一致性。

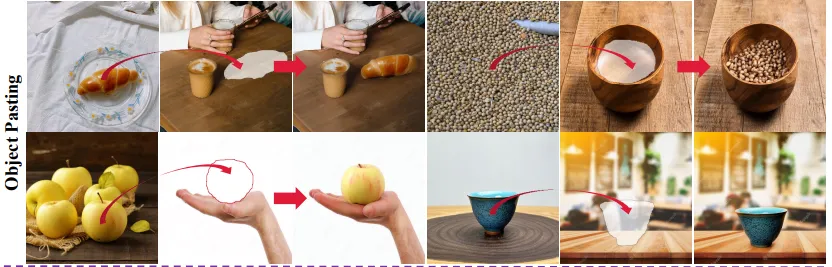

我們的方法通過高效的設計,實現了對生成或真實圖像的各種編輯模式,例如對象移動、對象調整大小、對象外觀替換和內容拖動。值得注意的是,所有編輯和內容保存信號都來自圖像本身,模型不需要微調或額外的模塊。

方法

所提出的DragonDiffusion 的流程。我們提出的方法由指導分支和生成分支組成。指導分支通過中間特征的對應關系為生成分支提供編輯和一致性指導。

所提出的DragonDiffusion 的流程。我們提出的方法由指導分支和生成分支組成。指導分支通過中間特征的對應關系為生成分支提供編輯和一致性指導。

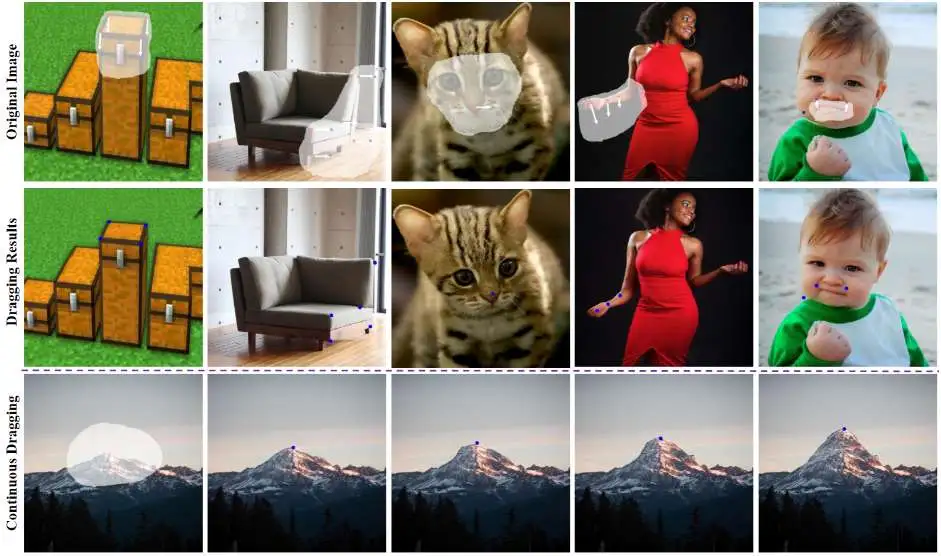

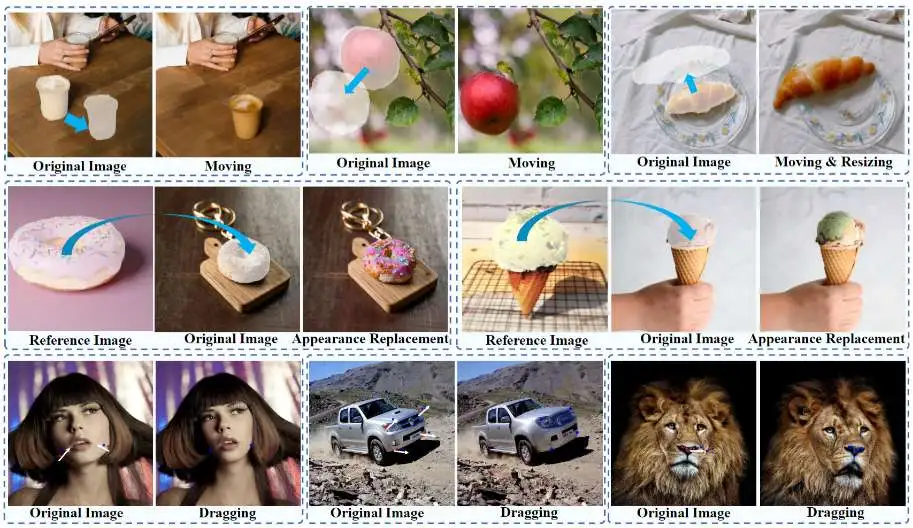

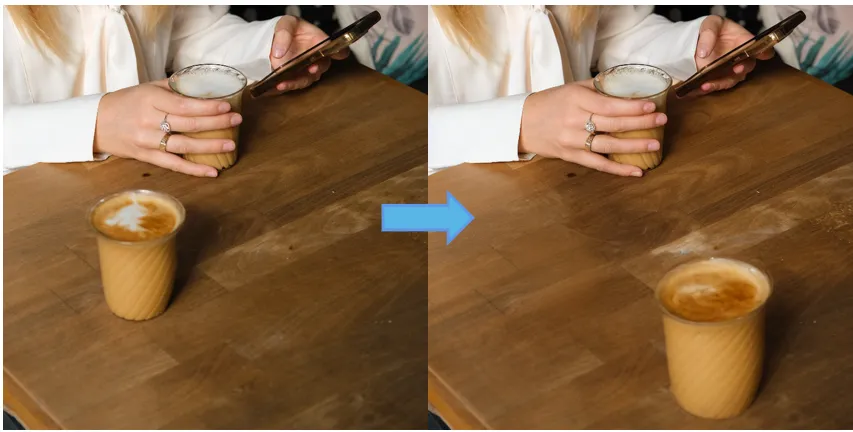

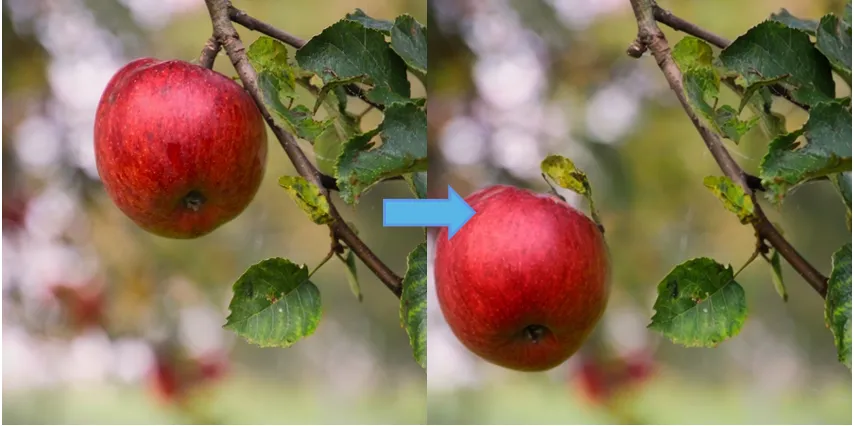

結果

物體移動結果

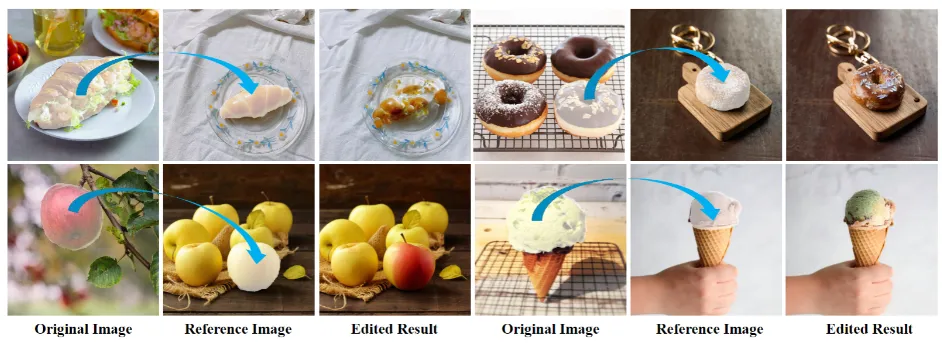

物體外觀替換結果

內容拖拽結果