華為改進Transformer架構!盤古-π解決特征缺陷問題,同規模性能超LLaMA

華為盤古系列,帶來架構層面上新!

量子位獲悉,華為諾亞方舟實驗室等聯合推出新型大語言模型架構:盤古-π。

它通過增強非線性,在傳統Transformer架構上做出改進,由此可以顯著降低特征塌陷問題。

帶來的直接效果就是模型輸出表達能力更強。

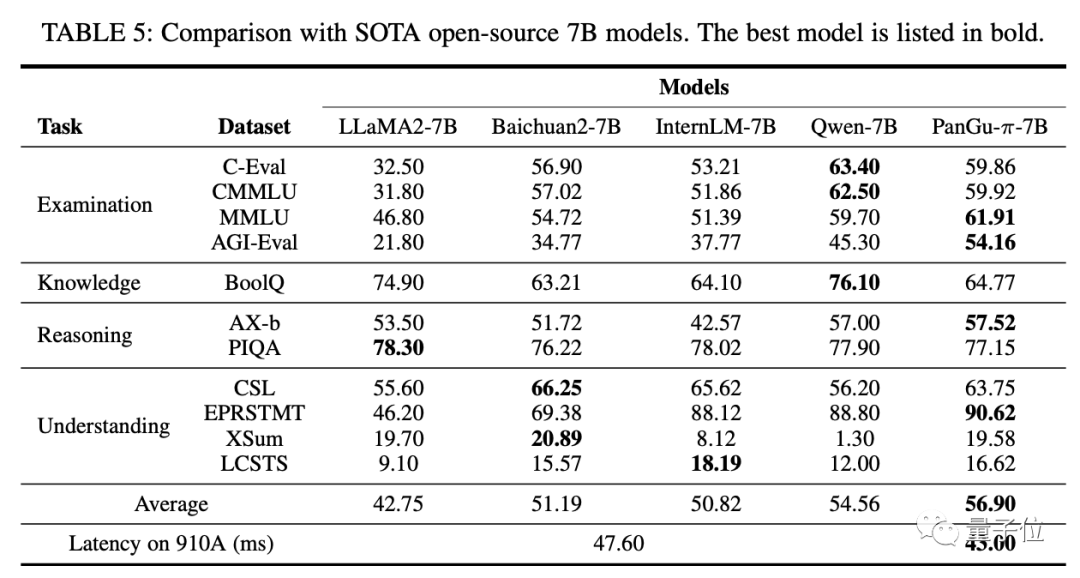

在使用相同數據訓練的情況下,盤古-π(7B)在多任務上超越LLaMA 2等同規模大模型,并能實現10%的推理加速。

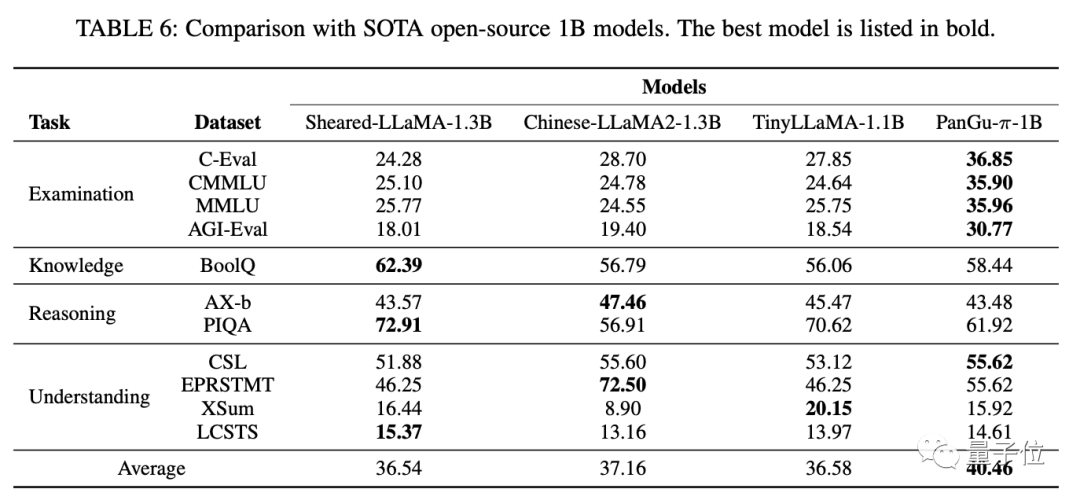

在1B規模上可達SOTA。

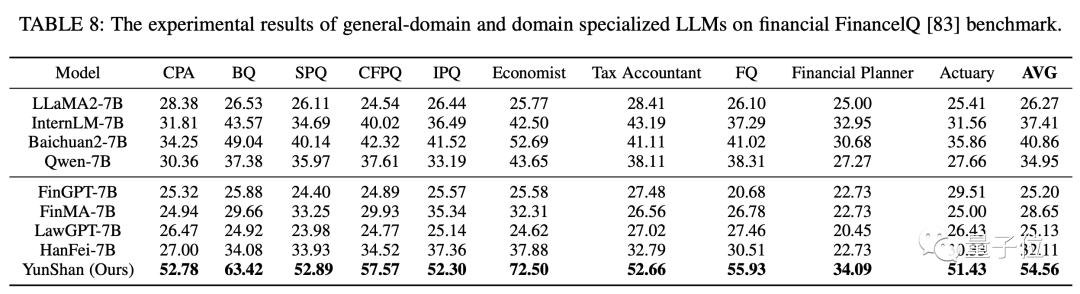

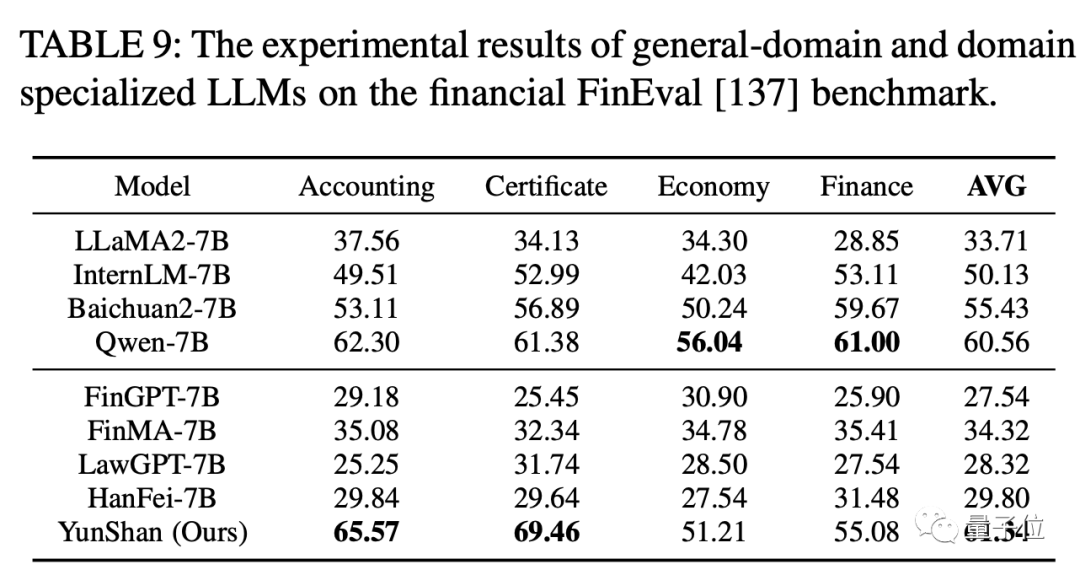

同時還基于這一架構煉出了一個金融法律大模型“云山”。

該工作由AI大牛陶大程領銜。

具體如何實現?一起來看。

利用非線性解決特征塌陷

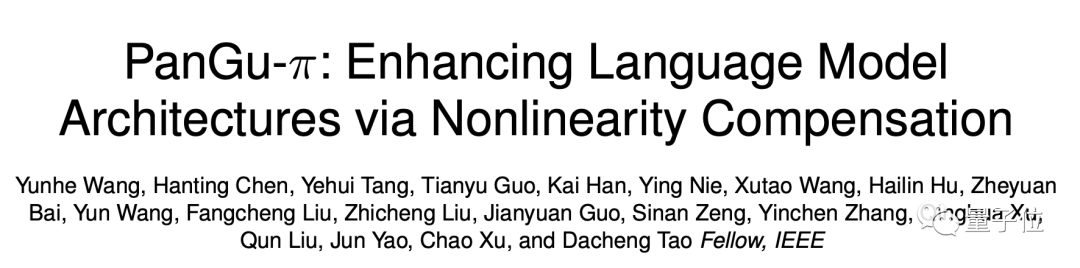

目前常見大模型基本都采用Transformer架構,比如GPT、LLaMA等。

它的核心構成包括多頭自注意力機制(MSA)和前饋網絡(FFN)。

MSA的主要功能是計算輸入序列中每個token和其他所有token之間的相關性,通過學習輸入序列中的依賴關系,可以增強對語言的理解能力。FFN主要對輸入進行非線性轉換,增強模型表達能力,使其可以逼近更復雜的函數。

不過,華為諾亞方舟實驗室發現,特征崩潰(feature collapse)會影響Transformer架構的表現,降低其表達能力,使模型難以區分不同輸入。

以LLaMA為例,在更深層的神經網絡上,特征等級顯著降低,導致了所有token之間的相似性更強。

從機制上來看,自注意力模塊可以看做在完全圖上進行信息聚合,連續堆疊多層注意力就像連續多層圖卷積一樣,會產生過度特征平滑效應。

另一方面,多層感知器(MLP)中的激活函數提供的非線性還不夠,抑制特征崩潰的作用有限。

由此,團隊想要提高模型的非線性表達能力,避免特征崩潰,進而提出了本次工作盤古-π。

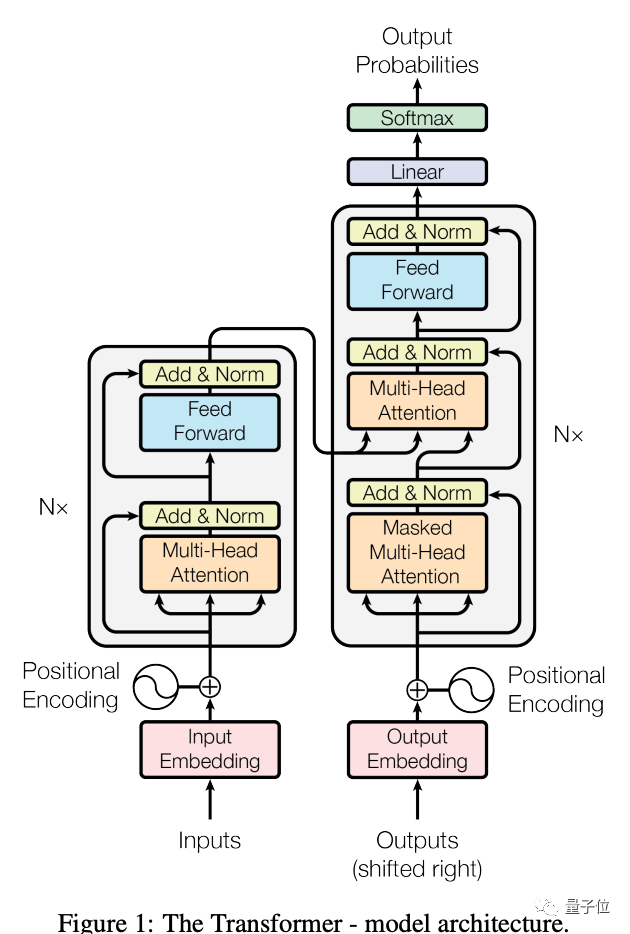

如下是盤古-π的結構示意:

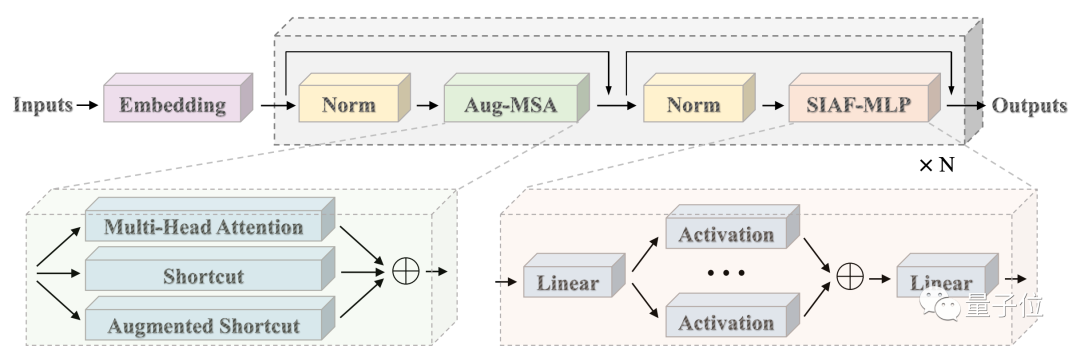

在FFN中加入串聯激活函數,在MSA中集成一種增強快捷連接(Aug-S),可以更有效地在Transformer架構中引入更多非線性。

使用了增強快捷連接(Aug-S)的MSA,能將每個token的特征轉換為不同表示形式。

基于這一新架構,通過大規模訓練和微調,研究團隊開發了一個盤古-π基礎模型。

實驗結果顯示,該模型在多任務中表現超越其他同規模模型(分別測試了7B和1B規模)。

而且盤古-π-7B可以達到約10%的推理加速。

同時團隊還以此為基礎開發了一個金融法律領域大模型“云山”,它同樣在多個benchmark中成績超越其他模型。

通訊作者為陶大程

值得關注的是,本項研究的團隊陣容也非常亮眼。

通訊作者為陶大程。

他是歐洲科學院外籍院士、澳大利亞科學院院士。本科就讀于中科大,說是畢業于港中文MMLab、師從湯曉鷗。

2007年從博士畢業后,先后在中國香港理工大學、新加坡南洋理工大學,澳大利亞悉尼科技大學、悉尼大學任教。目前是清華大學智能產業研究院AIR團隊卓越訪問教授。

與此同時,他還先后加盟過優必選、京東,曾是京東最高級別AI科學家、擔任京東探索研究院院長。

一作為王云鶴。

他是2012實驗室諾亞方舟實驗室高級研究員,現任算法應用部部長。

王云鶴在華為負責高效AI算法的創新研發以及在華為業務中的應用。他和團隊開發了高效AI算法,其衍生應用在中國天眼FAST觀測工作中,協助中科院國家天文臺專家找到了數百個新的快速射電暴樣本。

論文地址:http://arxiv.org/abs/2312.17276